マルチモーダル大規模モデルに検出およびセグメンテーション モジュールが統合された後、画像の切り出しが容易になります。

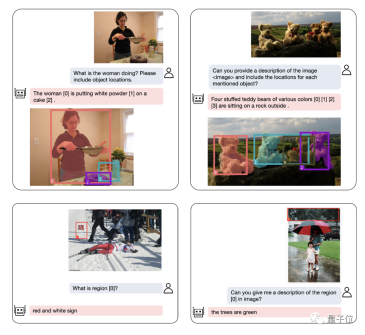

私たちのモデルは、自然言語の説明を通じて探しているオブジェクトにすばやくラベルを付け、テキストによる説明を提供して、タスクを簡単に完了できるようにします。

シンガポール国立大学の NExT 研究室と清華大学の Liu Zhiyuan チームによって開発された新しいマルチモーダル大規模モデルは、私たちに強力なサポートを提供します。このモデルは、パズルを解くプロセス中にプレイヤーに包括的なヘルプとガイダンスを提供するために慎重に作成されています。複数のモダリティからの情報を組み合わせて、プレーヤーに新しいパズル解決方法と戦略を提示します。このモデルの適用はプレイヤーに利益をもたらします

GPT-4v の発売により、マルチモーダル分野では LLaVA、BLIP-2 などの一連の新しいモデルが導入されました。 、など待ってください。これらのモデルの出現は、マルチモーダル タスクのパフォーマンスと有効性の向上に大きく貢献しました。

マルチモーダル大規模モデルの地域理解能力をさらに向上させるために、研究チームはNExT-Chatと呼ばれるマルチモーダルモデルを開発しました。このモデルには、対話、検出、セグメンテーションを同時に実行する機能があります。

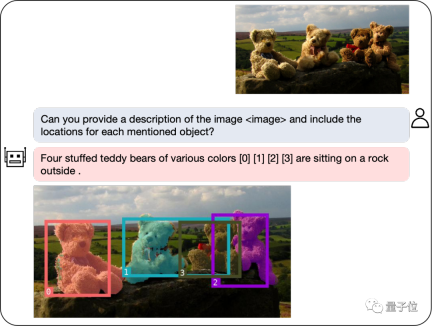

NExT-Chat の最大のハイライトは、マルチモーダル モデルに位置入出力を導入できることです。この機能により、NExT-Chat は対話中にユーザーのニーズをより正確に理解し、応答できるようになります。 NExT-Chat は、位置入力を通じて、ユーザーの地理的位置に基づいて関連情報や提案を提供できるため、ユーザー エクスペリエンスが向上します。 NExT-Chat は、位置情報の出力を通じて、特定の地理的位置に関する関連情報をユーザーに伝え、より良い情報を提供することができます。

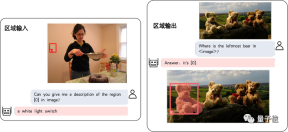

このうち、位置入力機能は、指定されたエリアに基づいて質問に答えることを指し、位置出力機能は、会話で言及されたオブジェクトの場所を指定します。これら 2 つの能力はパズル ゲームにおいて非常に重要です。

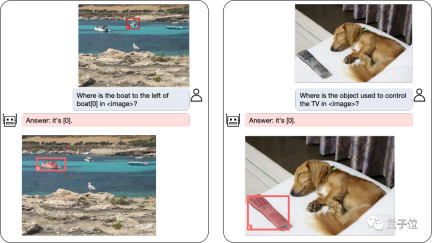

複雑な位置決め問題も解決できます:

オブジェクトの位置決めに加えて、NExT-Chat は記述も行うことができます画像またはその一部:

画像の内容を分析した後、NExT-Chat は取得した情報を使用して推論を行うことができます:

NExT-Chat のパフォーマンスを正確に評価するために、研究チームは複数のタスク データ セットに対してテストを実施しました。

複数のデータセットで SOTA を達成する

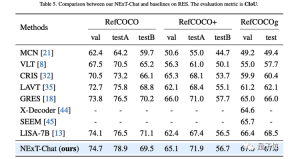

著者は最初に、参照表現セグメンテーション (RES) タスクに関する NExT-Chat の実験結果を示しました。

非常に少量のセグメンテーション データのみを使用しているにもかかわらず、NExT-Chat は、一連の教師ありモデル (MCN、VLT など) を破り、5 回の LISA メソッドを使用するなど、優れた参照セグメンテーション機能を実証しました。上記のセグメンテーション マスク アノテーションの場合。

△RESタスクにおけるNExT-Chatの結果

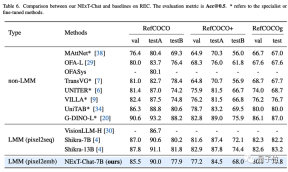

次に、研究チームはRECタスクにおけるNExT-Chatの実験結果を示しました。

以下の表に示すように、NExT-Chat は一連の教師ありメソッド (UNITER など) よりも優れた結果を達成できます。

興味深い発見は、NExT-Chat は同様のボックス トレーニング データを使用する Shikra よりも効果がわずかに低いということです。

作者は、これは、pix2emb 法の LM 損失と検出損失のバランスを取るのがより難しく、Shikra が既存の平文大規模モデルの事前学習形式に近いためであると推測しています。

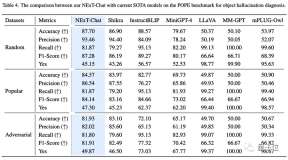

△POPE データセットでの NExT-Chat の結果

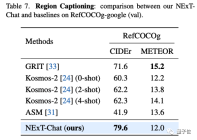

エリア記述タスクでは、NExT-Chat は最高の CIDEr パフォーマンスを達成することもでき、このインジケーターの 4 ショットのケースでは Kosmos- を上回ります。 2.

# △pix2emb メソッドの簡単な例

# △pix2emb メソッドの簡単な例

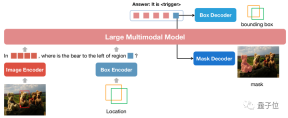

上図に示すように、位置入力は、対応するエンコーダーによって位置埋め込みにエンコードされ、出力されます。位置の埋め込みはボックス デコーダーとマスク デコーダーを介してボックスとマスクに変換されます。

これには 2 つの利点があります。

モデルの出力形式は、セグメンテーション マスクなどのより複雑な形式に簡単に拡張できます。- モデルは、タスク内の既存の実用的なメソッドを簡単に見つけることができます。たとえば、この記事の検出損失は L1 損失と GioU 損失を使用しています (pix2seq は損失の生成にテキストのみを使用できます)。このマスク デコーダは、この記事では、既存のメソッドである SAM を使用して初期化を行っています。

- pix2seq と pix2emb を組み合わせることで、著者は新しい NExT-Chat モデルをトレーニングしました。

NExT-Chat モデル

△NExT-Chat モデル アーキテクチャ

△NExT-Chat モデル アーキテクチャ

NExT-Chat は全体として LLaVA アーキテクチャを採用しています。画像エンコーダを介して画像情報をエンコードし、LLM に入力して理解します。これに基づいて、対応するボックス エンコーダと 2 つの位置出力のデコーダが追加されます。

LLM が言語の LM ヘッドまたは位置デコーダをいつ使用するかわからないという問題を解決するために、NExT-Chat は位置情報を識別するための新しいトークン タイプをさらに導入します。

モデルが出力する場合、トークンの埋め込みは、言語デコーダーではなく、デコードのために対応する位置デコーダーに送信されます。

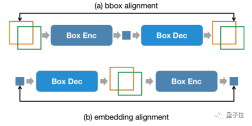

さらに、入力ステージと出力ステージでの位置情報の一貫性を維持するために、NExT-Chat では追加の位置合わせ制約が導入されています:

△位置入力、出力制約

△位置入力、出力制約

上図に示すように、ボックスと位置埋め込みはそれぞれデコーダ、エンコーダ、デコーダ-エンコーダを介して結合され、前後で変更しないことが要求されます。

著者は、この方法が位置入力機能の収束を大幅に促進できることを発見しました。

NExT-Chat のモデル トレーニングには主に 3 つの段階があります:

第 1 段階: トレーニング モデル- 基本的なボックスの入出力の基本機能

- 。 NExT-Chat は、Flickr-30K、RefCOCO、VisualGenome、および事前トレーニング用のボックス入出力を含むその他のデータセットを使用します。トレーニング プロセス中に、すべての LLM パラメータがトレーニングされます。 第 2 段階: LLM の命令追従能力を調整します

- 。 Shikra-RD、LLaVA-instruct、およびその他の命令を通じてデータを微調整すると、モデルが人間の要件によりよく応答し、より人間らしい結果を出力できるようになります。 第 3 段階: NExT-Chat モデルにセグメンテーション機能を付与します

- 。上記の 2 つのトレーニング段階を通じて、モデルはすでに優れた位置モデリング機能を備えています。著者はこの機能をさらに拡張して、出力をマスクします。実験の結果、非常に少量のマスク注釈データとトレーニング時間 (約 3 時間) を使用することで、NExT-Chat はすぐに優れたセグメンテーション機能を実現できることがわかりました。 このようなトレーニング プロセスの利点は、検出フレーム データが豊富であり、トレーニングのオーバーヘッドが小さいことです。

NExT-Chat は、豊富な検出フレーム データに基づいて基本的な位置モデリング機能をトレーニングし、より困難で注釈が少ないセグメンテーション タスクにすぐに拡張できます。

以上が大規模モデルでは、簡単な会話だけで画像に注釈を付けることができます。清華大学とNUSの研究結果の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM「AI-Ready労働力」という用語は頻繁に使用されますが、サプライチェーン業界ではどういう意味ですか? サプライチェーン管理協会(ASCM)のCEOであるAbe Eshkenaziによると、批評家ができる専門家を意味します

1つの会社がAIを永遠に変えるために静かに取り組んでいる方法Apr 26, 2025 am 11:12 AM

1つの会社がAIを永遠に変えるために静かに取り組んでいる方法Apr 26, 2025 am 11:12 AM分散型AI革命は静かに勢いを増しています。 今週の金曜日、テキサス州オースティンでは、ビテンサーのエンドゲームサミットは極めて重要な瞬間を示し、理論から実用的な応用に分散したAI(DEAI)を移行します。 派手なコマーシャルとは異なり

Nvidiaは、AIエージェント開発を合理化するためにNEMOマイクロサービスをリリースしますApr 26, 2025 am 11:11 AM

Nvidiaは、AIエージェント開発を合理化するためにNEMOマイクロサービスをリリースしますApr 26, 2025 am 11:11 AMエンタープライズAIはデータ統合の課題に直面しています エンタープライズAIの適用は、ビジネスデータを継続的に学習することで正確性と実用性を維持できるシステムを構築する大きな課題に直面しています。 NEMOマイクロサービスは、NVIDIAが「データフライホイール」と呼んでいるものを作成することにより、この問題を解決し、AIシステムがエンタープライズ情報とユーザーインタラクションへの継続的な露出を通じて関連性を維持できるようにします。 この新しく発売されたツールキットには、5つの重要なマイクロサービスが含まれています。 NEMOカスタマイザーは、より高いトレーニングスループットを備えた大規模な言語モデルの微調整を処理します。 NEMO評価者は、カスタムベンチマークのAIモデルの簡素化された評価を提供します。 Nemo Guardrailsは、コンプライアンスと適切性を維持するためにセキュリティ管理を実装しています

aiは芸術とデザインの未来のために新しい絵を描きますApr 26, 2025 am 11:10 AM

aiは芸術とデザインの未来のために新しい絵を描きますApr 26, 2025 am 11:10 AMAI:芸術とデザインの未来 人工知能(AI)は、前例のない方法で芸術とデザインの分野を変えており、その影響はもはやアマチュアに限定されませんが、より深く影響を与えています。 AIによって生成されたアートワークとデザインスキームは、広告、ソーシャルメディアの画像生成、Webデザインなど、多くのトランザクションデザインアクティビティで従来の素材画像とデザイナーに迅速に置き換えられています。 ただし、プロのアーティストやデザイナーもAIの実用的な価値を見つけています。 AIを補助ツールとして使用して、新しい美的可能性を探求し、さまざまなスタイルをブレンドし、新しい視覚効果を作成します。 AIは、アーティストやデザイナーが繰り返しタスクを自動化し、さまざまなデザイン要素を提案し、創造的な入力を提供するのを支援します。 AIはスタイル転送をサポートします。これは、画像のスタイルを適用することです

エージェントAIとのズームがどのように革命を起こしているか:会議からマイルストーンまでApr 26, 2025 am 11:09 AM

エージェントAIとのズームがどのように革命を起こしているか:会議からマイルストーンまでApr 26, 2025 am 11:09 AM最初はビデオ会議プラットフォームで知られていたZoomは、エージェントAIの革新的な使用で職場革命をリードしています。 ZoomのCTOであるXD Huangとの最近の会話は、同社の野心的なビジョンを明らかにしました。 エージェントAIの定義 huang d

大学に対する実存的な脅威Apr 26, 2025 am 11:08 AM

大学に対する実存的な脅威Apr 26, 2025 am 11:08 AMAIは教育に革命をもたらしますか? この質問は、教育者と利害関係者の間で深刻な反省を促しています。 AIの教育への統合は、機会と課題の両方をもたらします。 Tech Edvocate NotesのMatthew Lynch、Universitとして

プロトタイプ:アメリカの科学者は海外の仕事を探していますApr 26, 2025 am 11:07 AM

プロトタイプ:アメリカの科学者は海外の仕事を探していますApr 26, 2025 am 11:07 AM米国における科学的研究と技術の開発は、おそらく予算削減のために課題に直面する可能性があります。 Natureによると、海外の雇用を申請するアメリカの科学者の数は、2024年の同じ期間と比較して、2025年1月から3月まで32%増加しました。以前の世論調査では、調査した研究者の75%がヨーロッパとカナダでの仕事の検索を検討していることが示されました。 NIHとNSFの助成金は過去数か月で終了し、NIHの新しい助成金は今年約23億ドル減少し、3分の1近く減少しました。リークされた予算の提案は、トランプ政権が科学機関の予算を急激に削減していることを検討しており、最大50%の削減の可能性があることを示しています。 基礎研究の分野での混乱は、米国の主要な利点の1つである海外の才能を引き付けることにも影響を与えています。 35

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AM

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AMOpenaiは、強力なGPT-4.1シリーズを発表しました。実際のアプリケーション向けに設計された3つの高度な言語モデルのファミリー。 この大幅な飛躍は、より速い応答時間、理解の強化、およびTと比較した大幅に削減されたコストを提供します

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

メモ帳++7.3.1

使いやすく無料のコードエディター

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。

SublimeText3 中国語版

中国語版、とても使いやすい

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

ホットトピック

7746

7746 15

15 1643

1643 14

14 1397

1397 52

52 1291

1291 25

25 1234

1234 29

29