ホームページ >テクノロジー周辺機器 >AI >AI アプリケーションの次の注目のアプリケーションが登場しました。アリババとバイトダンスは、メッシを簡単に踊らせることができる同様の成果物を静かに発表しました。

AI アプリケーションの次の注目のアプリケーションが登場しました。アリババとバイトダンスは、メッシを簡単に踊らせることができる同様の成果物を静かに発表しました。

- 王林転載

- 2023-12-05 17:43:311256ブラウズ

AI ビデオ生成アーティファクトが再び登場しました。最近、アリババとバイトダンスはそれぞれのツールを密かに開始しました

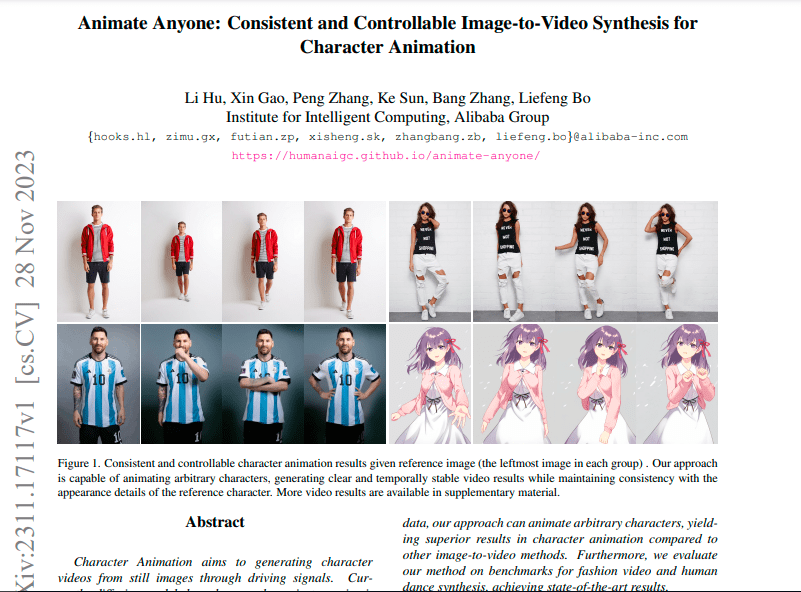

Ali は、Alibaba Intelligent Computing Research Institute が開発したプロジェクトである AnimateEveryone を立ち上げました。提供する必要があるのは、静的なキャラクター画像 (実在の人物、アニメーション/漫画のキャラクターなど) といくつかのアクションと姿勢 (ダンス、歩行) を使用すると、キャラクターの詳細な特徴 (表情、服装の詳細など) を保持したままアニメートできます。

メッシの写真さえあれば、「ボールの王様」にさまざまなポーズをとらせることができる(下図参照) この原則に従えば、メッシを踊らせるのは簡単だ。

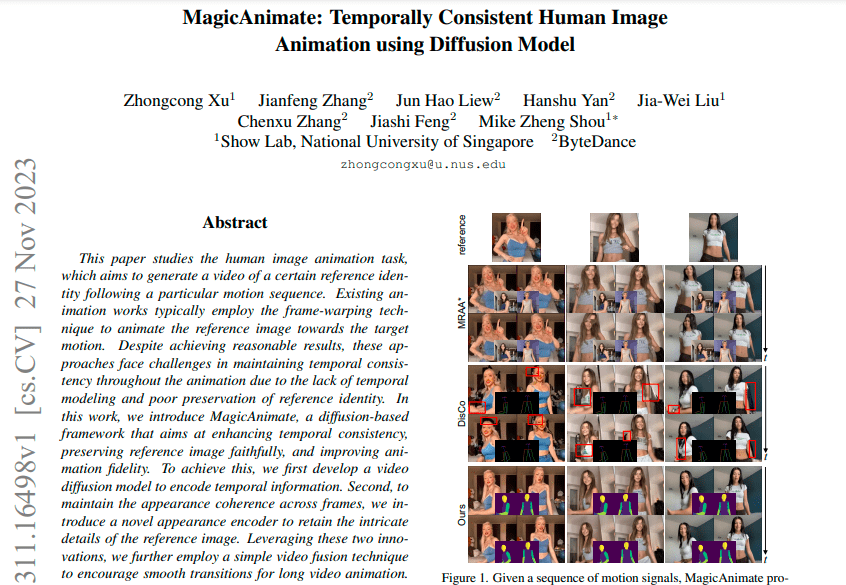

シンガポール国立大学とバイトダンスは共同で Magic Animate を立ち上げました。これも AI テクノロジーを使用して静止画像を動的なビデオに変換します。 Byte 氏は、非常に困難な TikTok ダンス データセットにおいて、Magic Animate によって生成されたビデオのリアリズムは、最も強力なベースラインと比較して 38% 以上向上したと述べました。

Tusheng Video プロジェクトでは、Alibaba と ByteDance が協力し、論文リリース、コード公開、テストアドレス公開などの一連の作業をほぼ同時に完了しました。2 つの関連論文のリリース時間はわずか 1 日しか違えませんでした

バイトに関する関連論文が 11 月 27 日にリリースされました:

アリ関連の論文は11月28日に発売されます:

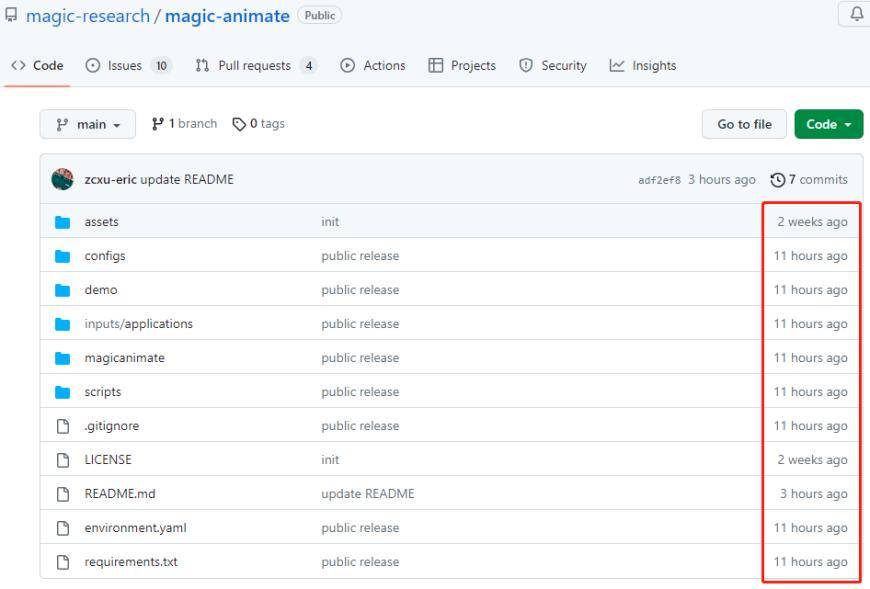

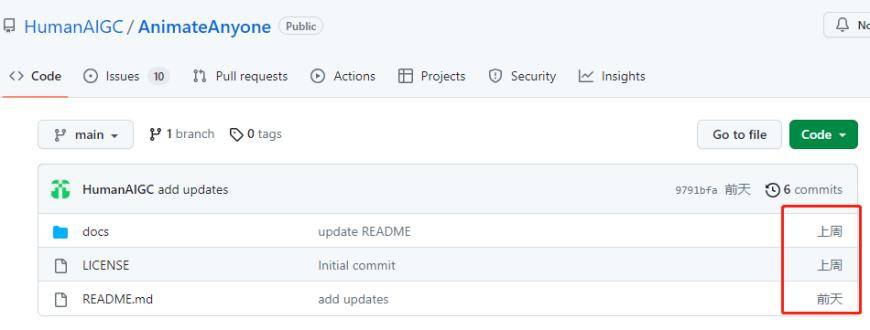

両社のオープンソース ファイルは Github で継続的に更新されます

書き直す必要があるコンテンツは次のとおりです: Magic Animate のオープンソース プロジェクト ファイル パッケージ

AnimateEveryone のオープンソース プロジェクト ファイル パッケージ

これは、次の事実を改めて強調しています: ビデオ生成は AIGC で人気のある競争イベントであり、テクノロジー大手やスター企業がそれに細心の注意を払っており、積極的に投資しています。 Runway、Meta、Stable AI が AI Vincent ビデオ アプリケーションを開始したことがわかり、Adobe は最近 AI ビデオ作成会社 Rephrase.ai の買収を発表しました。

上記 2 社の展示ビデオを見る限り、生成効果は大幅に向上しており、以前よりも滑らかさとリアルさが向上しています。局所的な歪み、ぼやけた詳細、一貫性のないプロンプトワード、元の画像との違い、フレーム落ち、画面のジッターなど、現在の画像/ビデオ生成アプリケーションの欠点を克服します。

両方のツールは拡散モデルを使用して時間的に一貫したポートレート アニメーションを作成し、トレーニング データはほぼ同じです。両方で使用される安定拡散は、CompVis、Stability AI、LAION の研究者とエンジニアによって作成されたテキストから画像への潜在拡散モデルであり、LAION-5B データベースのサブセットからの 512x512 画像を使用してトレーニングされました。 LAION-5B は、自由にアクセスできる、現存する最大のマルチモーダル データセットです。

アプリケーションについて言えば、Alibaba の研究者は論文の中で、Animate Anybody は基本的な方法として、将来的にさまざまな Tusheng ビデオ アプリケーションに拡張される可能性があると述べています。このツールには、オンライン小売、エンターテイメント ビデオ、アート制作とバーチャルキャラクター。 ByteDance はまた、Magic Animate が強力な汎用化機能を実証しており、複数のシナリオに適用できることも強調しました。

マルチモーダル アプリケーションの「聖杯」: Vincent Video

Vincent Video は、テキストと音声テクノロジーを組み合わせたビデオ コンテンツのマルチモーダル分析と処理のアプリケーションを指します。テキストおよび音声情報をビデオ画像に関連付けて、より豊かなビデオの理解とインタラクティブなエクスペリエンスを提供します。

Vincent Video Application には、インテリジェントなビデオ監視、仮想現実、ビデオ編集、コンテンツ分析など、幅広い応用分野があります。 Vincent Video は、テキストと音声の分析を通じて、ビデオ内のオブジェクト、シーン、アクションを識別して理解できるため、よりインテリジェントなビデオ処理および制御機能をユーザーに提供できます。

インテリジェントなビデオ監視の分野では、Vincent Video は監視ビデオ コンテンツに自動的にラベルを付けて分類できるため、監視の効率と精度が向上します。仮想現実の分野では、Vincent Video はユーザーの音声コマンドや仮想環境と対話して、より没入型の仮想体験を実現できます。ビデオ編集とコンテンツ分析の分野では、Vincent Video はユーザーがビデオから重要な情報を自動的に抽出し、インテリジェントな編集と編集を実行できるように支援します。

つまり、Vincent Video は、マルチモーダル アプリケーションの「聖杯」として、ビデオ コンテンツの理解と対話のための、より包括的でインテリジェントなソリューションを提供します。その発展は、さまざまな分野に更なる革新と利便性をもたらし、科学技術の進歩と社会の発展を促進します。 動画はテキストや画像に比べて、情報をより適切に表現し、画像を豊かにし、ダイナミックにすることができるという利点があります。ビデオはテキスト、画像、サウンド、視覚効果を組み合わせて、複数の情報形式を統合して 1 つのメディアに表示できます AI ビデオ ツールは強力な製品機能を備えており、より幅広いアプリケーション シナリオを開くことができます。 AI ビデオ ツールは、簡単なテキスト説明やその他の操作を通じて、高品質で完全なビデオ コンテンツを生成できるため、ビデオ作成の敷居が低くなります。これにより、専門家でなくても動画を通じてコンテンツを正確に表示できるようになり、さまざまな業界分野でコンテンツ制作の効率が向上し、より創造的なアイデアが生み出されることが期待されます。

。現在、Vincent Video のパブリック ベータ アプリケーションは非常に少なく、Runway Gen-2、Zero Scope、Pika などの少数のみです。 Meta や Google などのシリコンバレーの人工知能大手でさえ、Vincent Video の進歩は遅く、それぞれがリリースした Make-A-Video と Phenaki はまだ公開テスト用にリリースされていません。

技術的な観点から見ると、ビデオ生成ツールの基礎となるモデルとテクノロジーはまだ最適化されています。現在、主流の Vincent ビデオ モデルは主に Transformer モデルと Diffusion モデルを使用しています。拡散モデル ツールは主にビデオの品質を向上させ、粗い効果や詳細の欠如の問題を克服することに特化しています。ただし、これらのビデオの長さは 4 秒未満です 一方、拡散モデルはうまく機能しますが、そのトレーニング プロセスには大量のメモリとコンピューティング能力が必要となるため、モデル トレーニングのコストを負担できるのは、多額の投資を受けた大企業や新興企業だけです。 出典: Science and Technology Innovation Board Daily

以上がAI アプリケーションの次の注目のアプリケーションが登場しました。アリババとバイトダンスは、メッシを簡単に踊らせることができる同様の成果物を静かに発表しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。