携帯電話やその他のモバイル端末上で安定拡散などの大規模な生成 AI モデルを実行することは、業界のホット スポットの 1 つとなっており、生成速度が主な制約となっています。

最近、Google の論文「MobileDiffusion: モバイル デバイスでの 1 秒未満のテキストから画像への生成」 では、携帯電話上での最速のテキストから画像への生成が提案されました。 iPhone 15 Pro ではわずか 0.2 秒かかります。この論文は UFOGen と同じチームによるもので、超小型の拡散モデルを作成しながら、サンプリングの高速化には現在普及している Diffusion GAN テクノロジーのルートも採用しています。

# #次は、MobileDiffusion によって 1 ステップで生成された結果です。

では、MobileDiffusion はどのように最適化されているのでしょうか?

では、MobileDiffusion はどのように最適化されているのでしょうか?

まず問題から始めて、なぜ最適化が必要なのかを探ってみましょう。

最も一般的なテキストから画像への生成テクノロジー拡散モデルに基づいて実装されています。事前トレーニング済みモデルの強力な基本画像生成機能と下流の微調整タスクの堅牢な性質により、画像編集、制御可能な生成、パーソナライズされた生成、ビデオ生成などの分野で拡散モデルの優れたパフォーマンスが確認されています。 .

ただし、基本的なモデルとしては、主に 2 つの側面を含む欠点も明らかです。 まず、拡散モデルのパラメータ数が多いため、特に計算速度が遅くなります。第二に、拡散モデルではサンプリングに複数のステップが必要となるため、さらに推論速度が遅くなります。期待されている Stable Diffusion 1.5 (SD) を例にとると、その基本モデルには 10 億近くのパラメータが含まれており、このモデルを定量化し、iPhone 15 Pro で推論を行ったところ、50 ステップのサンプリングに 80 秒近くかかりました。このような高価なリソース要件と遅いユーザー エクスペリエンスにより、モバイル端末でのアプリケーション シナリオが大幅に制限されます。

上記の問題を解決するために、MobileDiffusion はポイントツーポイントを最適化します。 (1) モデルサイズが大きいという問題に対応して、主にそのコアコンポーネントである UNet で多くの実験と最適化を実施しました。これには、計算量の多い畳み込み単純化とアテンション演算を下位層に配置し、モバイル デバイスの動作最適化をターゲットにしました。活性化関数など。 (2) 拡散モデルには複数ステップのサンプリングが必要であるという問題に対応して、MobileDiffusion は漸進的蒸留や現在の最先端の UFOGen などの 1 ステップ推論技術を研究し、実践しています。

#モデルの最適化

MobileDiffusion は、現在のオープン ソース コミュニティで最も人気のある SD 1.5 UNet に基づいて最適化されています

# ####。各最適化操作の後、元の UNet モデルと比較したパフォーマンス損失が同時に測定され、測定指標には、FID と CLIP という 2 つの一般的に使用されるメトリクスが含まれます。#全体計画

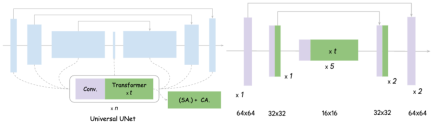

## は画像にありますの左側は元の UNet の設計図で、基本的に畳み込みと Transformer が含まれており、Transformer にはセルフ アテンション メカニズムとクロス アテンション メカニズムが含まれていることがわかります。 UNet 最適化の核となるアイデアは 2 つのポイントに分かれています: 1) 畳み込みの合理化. 誰もが知っているように、高解像度の特徴空間で畳み込みを実行するのは非常に時間がかかり、パラメーターも多数あります。これは完全な畳み込みです; 2)

注意効率の向上。 Convolution と同様に、高アテンションには特徴空間全体の長さの計算が必要です。セルフアテンションの複雑さは特徴空間の平坦化された長さに直接関係し、クロスアテンションも空間の長さに比例します。

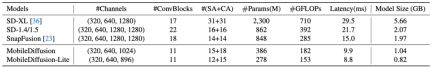

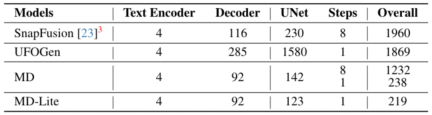

実験により、UNet の 16 個のトランスフォーマー全体を最も低い機能解像度を持つ内部層に移動し、各層の畳み込みをカットしても、パフォーマンスに明らかな影響がないことが証明されました。達成される効果は次のとおりです。MobileDiffusion は、元の 22 の畳み込みと 16 の Transformer を、わずか 11 の畳み込みと約 12 の Transformer に削減し、これらの処理はすべて低解像度の特徴マップ上で実行されます。これにより効率が大幅に向上し、効率が 40% 向上し、パラメータが 40% シャーリングされました。最終モデルを右に示します。他モデルとの比較は以下のとおりです。

##書き換える内容は、Micro Design#です。

## ここで紹介するのは斬新なデザインのほんの一部ですが、興味のある方は本文を読んでさらに詳しい紹介をご覧ください。セルフアテンションとクロスアテンションの分離

従来の UNet のトランスフォーマーにはセルフアテンションとクロスアテンションの両方が含まれていますが、MobileDiffusion では -Attend が行われます。はすべて最低解像度の特徴マップに配置されますが、クロスアテンションは中間層に保持されます。この設計により、計算効率が向上するだけでなく、モデル画像の品質も確保されることがわかります

#softmax を relu に微調整する

#誰もが知っているように、最適化されていないほとんどのケースでは、softmax 関数は並列処理を実行することが難しく、パフォーマンスが低くなります。効率。 MobileDiffusion は、各データ ポイントの活性化には relu 関数の方が効率的であるため、softmax 関数を relu 関数に直接調整 (微調整) する新しい方法を提案しています。驚くべきことに、わずか約 10,000 ステップの微調整で、モデルのメトリクスが改善され、生成された画像の品質が維持されました。したがって、softmax 関数と比較すると、relu 関数の利点は明らかです。

#Separable Convolution

MobileDiffuisonパラメーターを合理化する鍵となるのは、Seprable Convolution の使用でもあります。このテクノロジーは、MobileNet などの研究によって、特にモバイル側で非常に効果的であることが証明されていますが、一般に生成モデルで使用されることはほとんどありません。 MobileDiffusion の実験では、Separable Convolution が、特に UNet の最内層に配置されている場合に、パラメータを削減するのに非常に効果的であることがわかり、分析により、モデルの品質が損なわれないことが証明されました。

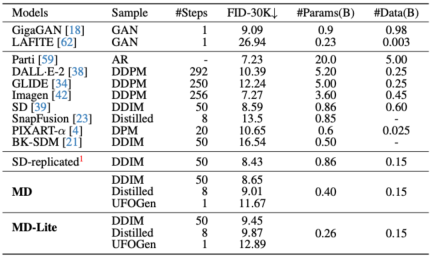

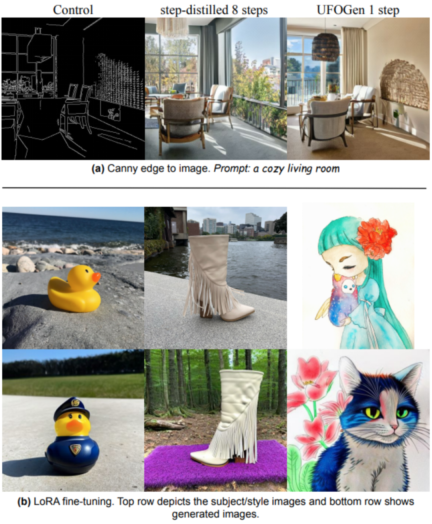

サンプリングの最適化

最も一般的なサンプリングの最適化方法には、8 ステップと 1 ステップを実現できる漸進蒸留と UFOGen があります。モデルが極度に単純化された後でも、これらのサンプリング手法が依然として有効であることを証明するために、MobileDiffusion はこれら 2 つの手法の実験的検証を実施しました。

最適化されたサンプリングがベースライン モデルと比較されました。サンプリング最適化後の 8 ステップ モデルと 1 ステップ モデルの指標が大幅に改善されたことがわかります。

実験とアプリケーション

モバイル ベンチマーク テスト

iPhone 15 Pro では、MobileDiffusion は次の場所で画像をレンダリングできます。現状最速、わずか0.2秒!

#ダウンストリーム タスク テスト

MobileDiffusion Explorationダウンストリーム タスクには、ControlNet/Plugin および LoRA Finetune が含まれます。以下の図からわかるように、モデルとサンプリングの最適化後も、MobileDiffusion は優れたモデル微調整機能を維持しています。

概要

MobileDiffusion は、さまざまなモデルとサンプリング最適化手法を検討し、最終的に達成しました。 -モバイル端末上の 2 番目のイメージ生成機能により、ダウンストリームの微調整アプリケーションの安定性も保証されます。これは将来の効率的な普及モデル設計に影響を与え、モバイルアプリケーションへの実用的な適用事例が拡大すると考えています。

以上が画像は携帯電話上で 0.2 秒でレンダリング可能 Google が最速のモバイル普及モデルを構築 MobileDiffusionの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

Gemma Scope:AI'の思考プロセスを覗くためのGoogle'の顕微鏡Apr 17, 2025 am 11:55 AM

Gemma Scope:AI'の思考プロセスを覗くためのGoogle'の顕微鏡Apr 17, 2025 am 11:55 AMジェマの範囲で言語モデルの内部の仕組みを探る AI言語モデルの複雑さを理解することは、重要な課題です。 包括的なツールキットであるGemma ScopeのGoogleのリリースは、研究者に掘り下げる強力な方法を提供します

ビジネスインテリジェンスアナリストは誰で、どのようになるか?Apr 17, 2025 am 11:44 AM

ビジネスインテリジェンスアナリストは誰で、どのようになるか?Apr 17, 2025 am 11:44 AMビジネスの成功のロック解除:ビジネスインテリジェンスアナリストになるためのガイド 生データを組織の成長を促進する実用的な洞察に変換することを想像してください。 これはビジネスインテリジェンス(BI)アナリストの力です - GUにおける重要な役割

SQLに列を追加する方法は? - 分析VidhyaApr 17, 2025 am 11:43 AM

SQLに列を追加する方法は? - 分析VidhyaApr 17, 2025 am 11:43 AMSQLの変更テーブルステートメント:データベースに列を動的に追加する データ管理では、SQLの適応性が重要です。 その場でデータベース構造を調整する必要がありますか? Alter Tableステートメントはあなたの解決策です。このガイドの詳細は、コルを追加します

ビジネスアナリストとデータアナリストApr 17, 2025 am 11:38 AM

ビジネスアナリストとデータアナリストApr 17, 2025 am 11:38 AM導入 2人の専門家が重要なプロジェクトで協力している賑やかなオフィスを想像してください。 ビジネスアナリストは、会社の目標に焦点を当て、改善の分野を特定し、市場動向との戦略的整合を確保しています。 シム

ExcelのCountとCountaとは何ですか? - 分析VidhyaApr 17, 2025 am 11:34 AM

ExcelのCountとCountaとは何ですか? - 分析VidhyaApr 17, 2025 am 11:34 AMExcelデータカウントと分析:カウントとカウントの機能の詳細な説明 特に大規模なデータセットを使用する場合、Excelでは、正確なデータカウントと分析が重要です。 Excelは、これを達成するためにさまざまな機能を提供し、CountおよびCounta関数は、さまざまな条件下でセルの数をカウントするための重要なツールです。両方の機能はセルをカウントするために使用されますが、設計ターゲットは異なるデータ型をターゲットにしています。 CountおよびCounta機能の特定の詳細を掘り下げ、独自の機能と違いを強調し、データ分析に適用する方法を学びましょう。 キーポイントの概要 カウントとcouを理解します

ChromeはAIと一緒にここにいます:毎日何か新しいことを体験してください!!Apr 17, 2025 am 11:29 AM

ChromeはAIと一緒にここにいます:毎日何か新しいことを体験してください!!Apr 17, 2025 am 11:29 AMGoogle Chrome'sAI Revolution:パーソナライズされた効率的なブラウジングエクスペリエンス 人工知能(AI)は私たちの日常生活を急速に変換しており、Google ChromeはWebブラウジングアリーナで料金をリードしています。 この記事では、興奮を探ります

ai' s Human Side:Wellbeing and the Quadruple bottuntApr 17, 2025 am 11:28 AM

ai' s Human Side:Wellbeing and the Quadruple bottuntApr 17, 2025 am 11:28 AMインパクトの再考:四重材のボトムライン 長い間、会話はAIの影響の狭い見方に支配されており、主に利益の最終ラインに焦点を当てています。ただし、より全体的なアプローチは、BUの相互接続性を認識しています

5ゲームを変える量子コンピューティングの使用ケースあなたが知っておくべきであるApr 17, 2025 am 11:24 AM

5ゲームを変える量子コンピューティングの使用ケースあなたが知っておくべきであるApr 17, 2025 am 11:24 AM物事はその点に向かって着実に動いています。量子サービスプロバイダーとスタートアップに投資する投資は、業界がその重要性を理解していることを示しています。そして、その価値を示すために、現実世界のユースケースの数が増えています

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

SublimeText3 中国語版

中国語版、とても使いやすい

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境