ホームページ >テクノロジー周辺機器 >AI >わずか 3 分で大規模な言語モデル AI ナレッジ ベースを迅速に構築

わずか 3 分で大規模な言語モデル AI ナレッジ ベースを迅速に構築

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-11-26 11:18:522612ブラウズ

FastGPT

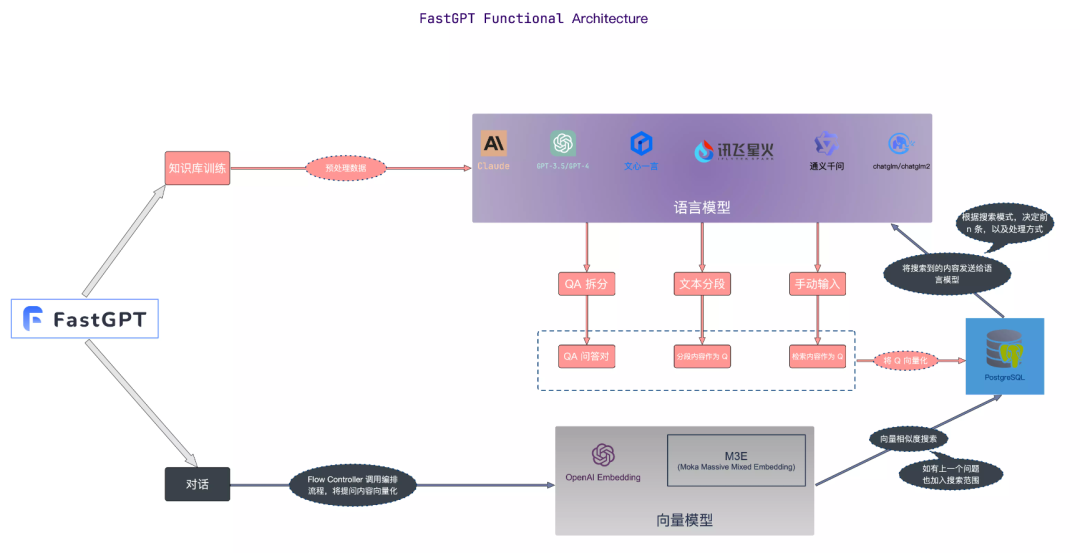

FastGPT は、LLM ラージ言語モデルを使用して構築されたナレッジ ベースの質問と回答システムであり、プラグ アンド プレイのデータ処理とモデル呼び出し機能を提供できます。同時に、複雑な質問と回答のシナリオを実現するための Flow ビジュアル ワークフロー オーケストレーションもサポートしています。

ナレッジ ベースのコア フローチャート

画像

画像

画像ソース: https://doc.fastgpt.in

プライベート デプロイメント

ここで Docker Compose を使用して、FastGPT プライベート化デプロイメントを迅速に実行します

1. Docker をインストールします

# 安装 Dockercurl -fsSL https://get.docker.com | bash -s docker --mirror Aliyunsystemctl enable --now docker# 安装 docker-composecurl -L https://github.com/docker/compose/releases/download/2.20.3/docker-compose-`uname -s`-`uname -m` -o /usr/local/bin/docker-composechmod +x /usr/local/bin/docker-compose# 验证安装docker -vdocker-compose -v

すでにインストールされている場合は、直接スキップしてください

2. コンテナ オーケストレーション

ローカル ディレクトリを作成し、ディレクトリを入力します

mkdir tinywan-fastgptcd tinywan-fastgpt

上で作成したディレクトリ パスは /d/Tinywan/GPT/tinywan-fastgpt

docker-compose.yml 設定ファイル

version: '3.3'services:pg:image: registry.cn-hangzhou.aliyuncs.com/fastgpt/pgvector:v0.5.0 # 阿里云container_name: pgrestart: alwaysports: # 生产环境建议不要暴露- 5432:5432networks:- fastgptenvironment:# 这里的配置只有首次运行生效。修改后,重启镜像是不会生效的。需要把持久化数据删除再重启,才有效果- POSTGRES_USER=username- POSTGRES_PASSWORD=password- POSTGRES_DB=postgresvolumes:- ./pg/data:/var/lib/postgresql/datamongo:image: mongo:5.0.18# image: registry.cn-hangzhou.aliyuncs.com/fastgpt/mongo:5.0.18 # 阿里云container_name: mongorestart: alwaysports: # 生产环境建议不要暴露- 27017:27017networks:- fastgptenvironment:# 这里的配置只有首次运行生效。修改后,重启镜像是不会生效的。需要把持久化数据删除再重启,才有效果- MONGO_INITDB_ROOT_USERNAME=username- MONGO_INITDB_ROOT_PASSWORD=passwordvolumes:- ./mongo/data:/data/dbfastgpt:container_name: fastgptimage: registry.cn-hangzhou.aliyuncs.com/fastgpt/fastgpt:latest # 阿里云ports:- 3000:3000networks:- fastgptdepends_on:- mongo- pgrestart: alwaysenvironment:# root 密码,用户名为: root- DEFAULT_ROOT_PSW=123465# 中转地址,如果是用官方号,不需要管- OPENAI_BASE_URL=https://api.openai.com/v1- CHAT_API_KEY=sb-xxx- DB_MAX_LINK=5 # database max link- TOKEN_KEY=any- ROOT_KEY=root_key- FILE_TOKEN_KEY=filetoken# mongo 配置,不需要改. 如果连不上,可能需要去掉 ?authSource=admin- MONGODB_URI=mongodb://username:password@mongo:27017/fastgpt?authSource=admin# pg配置. 不需要改- PG_URL=postgresql://username:password@pg:5432/postgresvolumes:- ./config.json:/app/data/config.jsonnetworks:fastgpt:

注: 値を入力してくださいCHAT_API_KEYに対応します。

config.json 構成ファイル

{"SystemParams": {"pluginBaseUrl": "","vectorMaxProcess": 15,"qaMaxProcess": 15,"pgHNSWEfSearch": 100},"ChatModels": [{"model": "gpt-3.5-turbo-1106","name": "GPT35-1106","price": 0,"maxContext": 16000,"maxResponse": 4000,"quoteMaxToken": 2000,"maxTemperature": 1.2,"censor": false,"vision": false,"defaultSystemChatPrompt": ""},{"model": "gpt-3.5-turbo-16k","name": "GPT35-16k","maxContext": 16000,"maxResponse": 16000,"price": 0,"quoteMaxToken": 8000,"maxTemperature": 1.2,"censor": false,"vision": false,"defaultSystemChatPrompt": ""},{"model": "gpt-4","name": "GPT4-8k","maxContext": 8000,"maxResponse": 8000,"price": 0,"quoteMaxToken": 4000,"maxTemperature": 1.2,"censor": false,"vision": false,"defaultSystemChatPrompt": ""},{"model": "gpt-4-vision-preview","name": "GPT4-Vision","maxContext": 128000,"maxResponse": 4000,"price": 0,"quoteMaxToken": 100000,"maxTemperature": 1.2,"censor": false,"vision": true,"defaultSystemChatPrompt": ""}],"QAModels": [{"model": "gpt-3.5-turbo-16k","name": "GPT35-16k","maxContext": 16000,"maxResponse": 16000,"price": 0}],"CQModels": [{"model": "gpt-3.5-turbo-1106","name": "GPT35-1106","maxContext": 16000,"maxResponse": 4000,"price": 0,"functionCall": true,"functionPrompt": ""},{"model": "gpt-4","name": "GPT4-8k","maxContext": 8000,"maxResponse": 8000,"price": 0,"functionCall": true,"functionPrompt": ""}],"ExtractModels": [{"model": "gpt-3.5-turbo-1106","name": "GPT35-1106","maxContext": 16000,"maxResponse": 4000,"price": 0,"functionCall": true,"functionPrompt": ""}],"QGModels": [{"model": "gpt-3.5-turbo-1106","name": "GPT35-1106","maxContext": 1600,"maxResponse": 4000,"price": 0}],"VectorModels": [{"model": "text-embedding-ada-002","name": "Embedding-2","price": 0.2,"defaultToken": 700,"maxToken": 3000}],"AudioSpeechModels": [{"model": "tts-1","name": "OpenAI TTS1","price": 0,"voices": [{"label": "Alloy","value": "alloy","bufferId": "openai-Alloy"},{"label": "Echo","value": "echo","bufferId": "openai-Echo"},{"label": "Fable","value": "fable","bufferId": "openai-Fable"},{"label": "Onyx","value": "onyx","bufferId": "openai-Onyx"},{"label": "Nova","value": "nova","bufferId": "openai-Nova"},{"label": "Shimmer","value": "shimmer","bufferId": "openai-Shimmer"}]}],"WhisperModel": {"model": "whisper-1","name": "Whisper1","price": 0}}

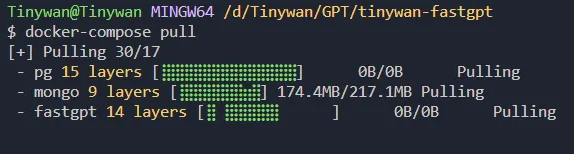

3. コンテナーを開始します

コマンド docker-compose pull を使用してイメージの更新バージョンを取得します

図

図

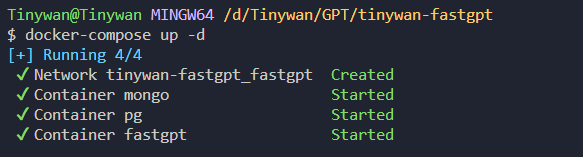

コマンド docker-compose up -d

を使用してコンテナーを起動します。図

を使用してコンテナーを起動します。図

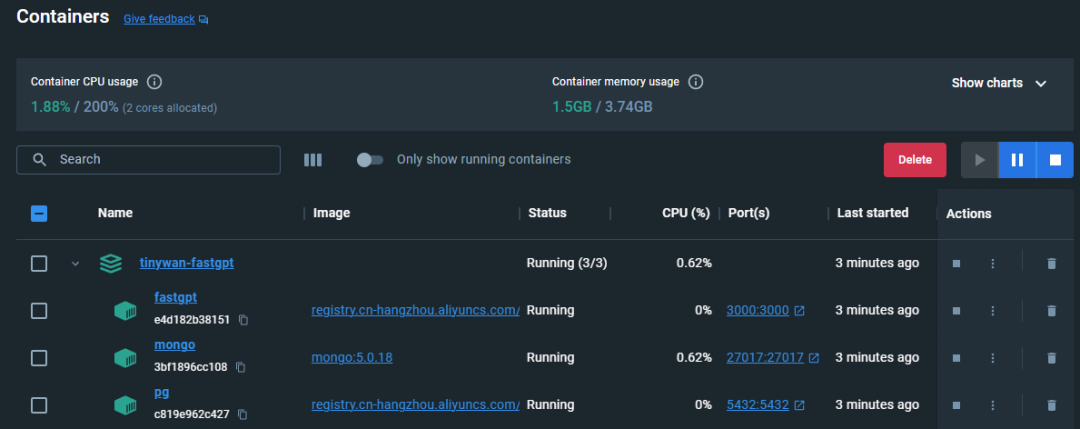

コンテナの起動ステータスの表示

##図

##図

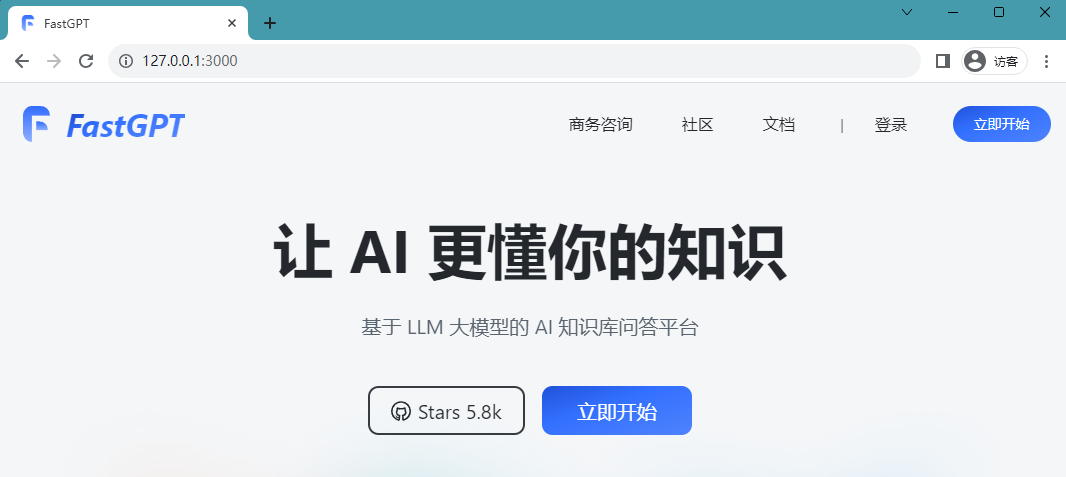

##現在、IP:3000 経由の直接アクセスが利用可能です。これはローカル展開であるため、http://127.0.0.1:3000 を通じて直接アクセスできます。

デプロイは成功しました。次のページにアクセスできます:Picture ログイン ユーザー名は次のとおりです。 root であり、パスワードは docker-compose.yml 環境変数に設定された DEFAULT_ROOT_PSW です。

ログイン ユーザー名は次のとおりです。 root であり、パスワードは docker-compose.yml 環境変数に設定された DEFAULT_ROOT_PSW です。

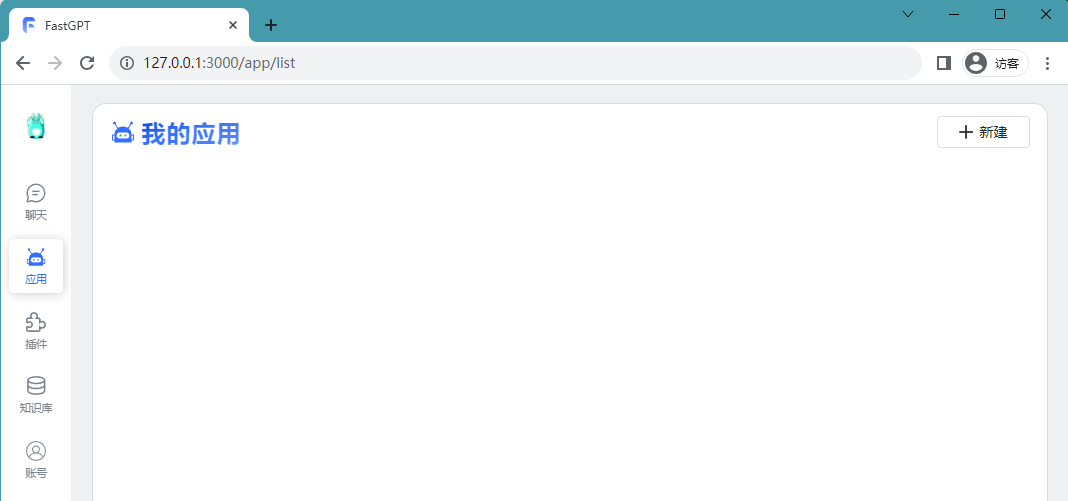

ログインに成功すると、次のページにリダイレクトされます:

Picture Build Knowledge Base

Build Knowledge Base

ナレッジ ベースの作成

ログインに成功したら、新しいナレッジ ベースを作成し、Open Source Technology Stack

Picture という名前を付けることができます。個人的な経験をナレッジ ベースにインポートする方法は、ファイル

という名前を付けることができます。個人的な経験をナレッジ ベースにインポートする方法は、ファイル

を使用することです。書き換える必要があるコンテンツは [新規/インポート] [ファイル インポート] です。 書き換え内容:[作成/インポート][ファイルインポート]

画像 確認後、現在のデータからベクターデータへの変換を開始します

確認後、現在のデータからベクターデータへの変換を開始します

Picture インポートするファイルを選択するときに、直接セグメンテーション プランを選択できます。直接セグメンテーションでは、文セグメンタを使用してテキストを特定の長さに分割し、最終的に複数の q のグループに分割します。ダイレクト セグメンテーション ソリューションを選択した場合、アプリケーションで参照プロンプト ワードを設定するときに、一般的なテンプレートを使用することをお勧めします。質問と回答のテンプレートを選択する必要はありません

インポートするファイルを選択するときに、直接セグメンテーション プランを選択できます。直接セグメンテーションでは、文セグメンタを使用してテキストを特定の長さに分割し、最終的に複数の q のグループに分割します。ダイレクト セグメンテーション ソリューションを選択した場合、アプリケーションで参照プロンプト ワードを設定するときに、一般的なテンプレートを使用することをお勧めします。質問と回答のテンプレートを選択する必要はありません

インポートは成功しました

图片

图片

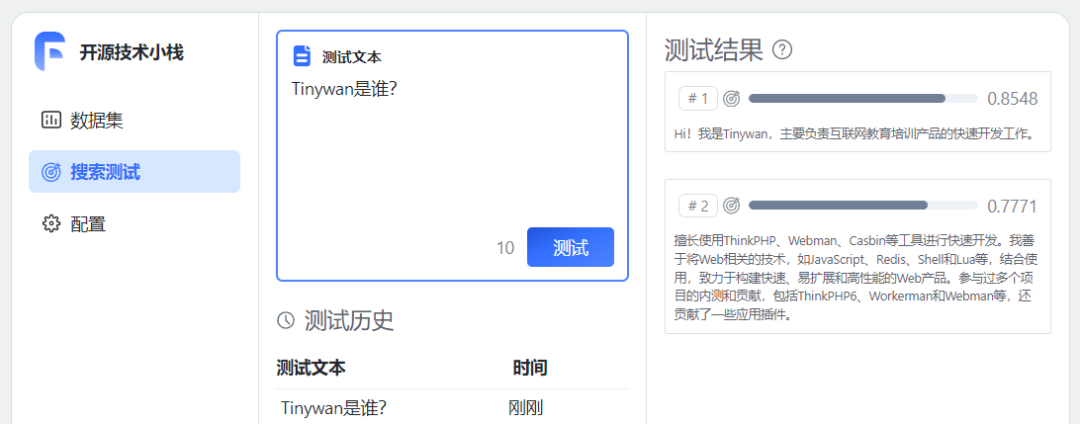

至此,个人知识库已经建好了。尝试进行测试问答

图片

图片

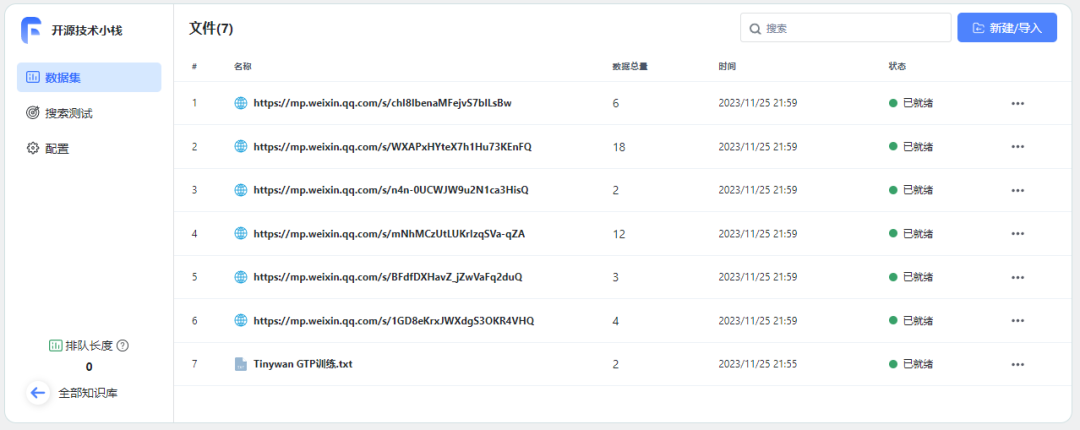

重新书写后的内容:重新连接训练数据

https://mp.weixin.qq.com/s/1GD8eKrxJWXdgS3OKR4VHQhttps://mp.weixin.qq.com/s/BFdfDXHavZ_jZwVaFq2duQhttps://mp.weixin.qq.com/s/mNhMCzUtLUKrIzqSVa-qZAhttps://mp.weixin.qq.com/s/n4n-0UCWJW9u2N1ca3HisQhttps://mp.weixin.qq.com/s/WXAPxHYteX7h1Hu73KEnFQhttps://mp.weixin.qq.com/s/chI8IbenaMFejvS7blLsBw

图片

图片

等待所有数据准备就绪

图片

图片

使用知识库

创建应用

使用知识库必须要创建一个应用

图片

图片

关联知识库

已添加开场白并选择绑定相应的知识库开源技术堆栈

图片

图片

点击保存预留后,可以直接在右边调试预览框预览对话进行文档内容测试。

开始对话

图片

图片

图片

图片

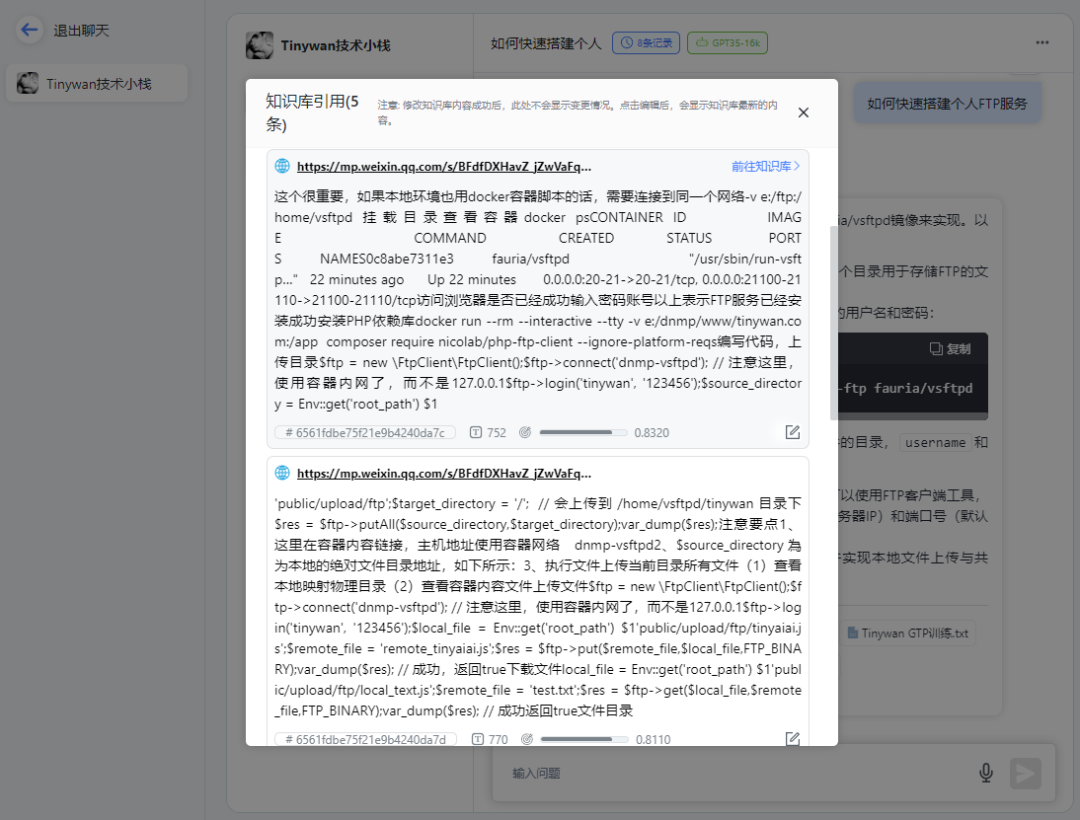

请点击链接查看知识库引用

图片

图片

打开对应链接可以直接跳转到微信公众号文章地址

总结

构建私有数据训练服务,针对问题提供精准回答。可以通过AI服务训练自有数据,形成AI知识库,然后创建不同的机器人针对用户问题提供精准回答。并且可以通过API接口很方便整合到自己的产品服务中。

以上がわずか 3 分で大規模な言語モデル AI ナレッジ ベースを迅速に構築の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。