翻訳者は書き直す必要があります:|レビューアーは書き直す必要があります:Bugatti

レビューアーは書き直す必要があります内容は次のとおりです: | 書き換える必要がある内容は次のとおりです: Chonglou

ドキュメントとデータからの洞察の抽出 # にとって、情報に基づいた意思決定を行うことは非常に重要です。ただし、機密情報を扱う場合には、プライバシーの問題が発生する可能性があります。 LangChain と OpenAI を組み合わせて使用するには、API を書き直す必要があります。インターネットにアップロードせずにローカルのドキュメントを分析します。 データをローカルに保持し、分析に埋め込みとベクトル化を使用し、環境内でプロセスを実行することでこれを実現します。 ##この時点で。 OpenAI

は、モデルのトレーニングやサービスの改善のために、API を通じて顧客から送信されたデータを使用しません。 #ビルド環境新しいものを作成する

Python仮想環境,これにより、ライブラリのバージョンの競合がなくなります。次に、次のターミナル コマンドを実行して、必要なライブラリをインストールします。

#pip需要改写的内容是:install需要改写的内容是:langchain需要改写的内容是:openai需要改写的内容是:tiktoken需要改写的内容是:faiss-cpu需要改写的内容是:pypdf

各ライブラリの 使用方法については、次のとおりです :

#LangChain: これを使用して、テキストの処理と分析のための言語チェーンを作成および管理します。これは、ドキュメントの読み込み、テキストの分割、埋め込み、および ボリューム ストレージのためのモジュールを提供します。

- #OpenAI: これを使用してクエリを実行します, を実行し、言語モデルから結果を取得します。

- tiktoken: これを使用して、指定されたテキスト内の ## を計算します。 #トークン ( テキストユニット ) の数。これは、使用するトークンの 数

- に基づいて を課金する OpenAI 用です。書き換える必要があるのは、API# です。 ##トラッキングトークン インタラクション中のカウント。 #FAISS:これを使用してベクター ストアを作成および管理します。埋め込みに基づいて類似したベクトルを迅速に取得します。 PyPDF:このライブラリは PDF# から派生しています##テキストを抽出します。 は、

- PDF ファイルをロードし、そのテキスト 、 を抽出してさらなる取引を行うのに役立ちます。と。

- #すべてのライブラリをインストールすると、環境は nowreadyready になります。 。 #GetOpenAI が書き換える必要があるコンテンツは次のとおりです: APIKey OpenAI にリクエストを行う場合、書き換える必要がある内容は次のとおりです: API、

API キーをリクエストの一部として使用します。 この キーを使用すると、API プロバイダーは、リクエストが正当なソースからのものであることと、ユーザーが

それを所有しますその機能にアクセスするには権限が必要です。 OpenAI を取得するために書き換える必要がある内容は、API キー、OpenAI プラットフォーム です。

次に、右上隅のアカウント プロフィール の下で、[#] をクリックします。 ##ViewAPIKey”, が表示されますAPIキーページ。

#[新しいキーの作成]

#[新しいキーの作成]

ボタンをクリックします。 キーに名前を付けてし、「新しいキーの作成」をクリックします。 OpenAI は API キーを生成します。これをコピーして安全な場所に保管する必要があります。セキュリティ上の理由から、OpenAI アカウントを通じて再度表示することはできません。 キーを紛失した場合は、新しいキーを生成する必要があります。

导入所需的库

为了能够使用安装在虚拟环境中的库,您需要导入它们。

from需要改写的内容是:langchain.document_loaders需要改写的内容是:import需要改写的内容是:PyPDFLoader,需要改写的内容是:TextLoaderfrom需要改写的内容是:langchain.text_splitter需要改写的内容是:import需要改写的内容是:CharacterTextSplitterfrom需要改写的内容是:langchain.embeddings.openai需要改写的内容是:import需要改写的内容是:OpenAIEmbeddingsfrom需要改写的内容是:langchain.vectorstores需要改写的内容是:import需要改写的内容是:FAISSfrom需要改写的内容是:langchain.chains需要改写的内容是:import需要改写的内容是:RetrievalQAfrom需要改写的内容是:langchain.llms需要改写的内容是:import需要改写的内容是:OpenAI

注意,您从LangChain导入了依赖项库,这让您可以使用LangChain框架的特定功能。

加载用于分析的文档

先创建一个含有API密钥的变量。稍后,您将在代码中使用该变量用于身份验证。

#需要改写的内容是:Hardcoded需要改写的内容是:API需要改写的内容是:keyopenai_api_key需要改写的内容是:=需要改写的内容是:"Your需要改写的内容是:API需要改写的内容是:key"

如果您打算与第三方共享您的代码,不建议对API密钥进行硬编码。对于打算分发的生产级代码,则改而使用环境变量。

接下来,创建一个加载文档的函数。该函数应该加载PDF或文本文件。如果文档既不是PDF文件,也不是文本文件,该函数会抛出值错误。

def需要改写的内容是:load_document(filename):if需要改写的内容是:filename.endswith(".pdf"):需要改写的内容是:loader需要改写的内容是:=需要改写的内容是:PyPDFLoader(filename)需要改写的内容是:documents需要改写的内容是:=需要改写的内容是:loader.load()需要改写的内容是:elif需要改写的内容是:filename.endswith(".txt"):需要改写的内容是:loader需要改写的内容是:=需要改写的内容是:TextLoader(filename)需要改写的内容是:documents需要改写的内容是:=需要改写的内容是:loader.load()需要改写的内容是:else:需要改写的内容是:raise需要改写的内容是:ValueError("Invalid需要改写的内容是:file需要改写的内容是:type")

加载文档后,创建一个CharacterTextSplitter。该分割器将基于字符将已加载的文档分隔成更小的块。

需要改写的内容是:

text_splitter需要改写的内容是:=需要改写的内容是:CharacterTextSplitter(chunk_size=1000,需要改写的内容是:需要改写的内容是:chunk_overlap=30,需要改写的内容是:separator="\n")需要改写的内容是:return需要改写的内容是:text_splitter.split_documents(documents=documents)

分割文档可确保块的大小易于管理,仍与一些重叠的上下文相连接。这对于文本分析和信息检索之类的任务非常有用。

查询文档

您需要一种方法来查询上传的文档,以便从中获得洞察力。为此,创建一个以查询字符串和检索器作为输入的函数。然后,它使用检索器和OpenAI语言模型的实例创建一个RetrievalQA实例。

def需要改写的内容是:query_pdf(query,需要改写的内容是:retriever):qa需要改写的内容是:=需要改写的内容是:RetrievalQA.from_chain_type(llm=OpenAI(openai_api_key=openai_api_key),需要改写的内容是:chain_type="stuff",需要改写的内容是:retriever=retriever)result需要改写的内容是:=需要改写的内容是:qa.run(query)需要改写的内容是:print(result)

该函数使用创建的QA实例来运行查询并输出结果。

创建主函数

主函数将控制整个程序流。它将接受用户输入的文档文件名并加载该文档。然后为文本嵌入创建OpenAIEmbeddings实例,并基于已加载的文档和文本嵌入构造一个向量存储。将该向量存储保存到本地文件。

接下来,从本地文件加载持久的向量存储。然后输入一个循环,用户可以在其中输入查询。主函数将这些查询与持久化向量存储的检索器一起传递给query_pdf函数。循环将继续,直到用户输入“exit”。

def需要改写的内容是:main():需要改写的内容是:filename需要改写的内容是:=需要改写的内容是:input("Enter需要改写的内容是:the需要改写的内容是:name需要改写的内容是:of需要改写的内容是:the需要改写的内容是:document需要改写的内容是:(.pdf需要改写的内容是:or需要改写的内容是:.txt):\n")docs需要改写的内容是:=需要改写的内容是:load_document(filename)embeddings需要改写的内容是:=需要改写的内容是:OpenAIEmbeddings(openai_api_key=openai_api_key)vectorstore需要改写的内容是:=需要改写的内容是:FAISS.from_documents(docs,需要改写的内容是:embeddings)需要改写的内容是:vectorstore.save_local("faiss_index_constitution")persisted_vectorstore需要改写的内容是:=需要改写的内容是:FAISS.load_local("faiss_index_constitution",需要改写的内容是:embeddings)query需要改写的内容是:=需要改写的内容是:input("Type需要改写的内容是:in需要改写的内容是:your需要改写的内容是:query需要改写的内容是:(type需要改写的内容是:'exit'需要改写的内容是:to需要改写的内容是:quit):\n")while需要改写的内容是:query需要改写的内容是:!=需要改写的内容是:"exit":query_pdf(query,需要改写的内容是:persisted_vectorstore.as_retriever())query需要改写的内容是:=需要改写的内容是:input("Type需要改写的内容是:in需要改写的内容是:your需要改写的内容是:query需要改写的内容是:(type需要改写的内容是:'exit'需要改写的内容是:to需要改写的内容是:quit):\n")

嵌入捕获词之间的语义关系。向量是一种可以表示一段文本的形式。

这段代码使用OpenAIEmbeddings生成的嵌入将文档中的文本数据转换成向量。然后使用FAISS对这些向量进行索引,以便高效地检索和比较相似的向量。这便于对上传的文档进行分析。

最后,如果用户独立运行程序,使用__name__需要改写的内容是:==需要改写的内容是:"__main__"构造函数来调用主函数:

if需要改写的内容是:__name__需要改写的内容是:==需要改写的内容是:"__main__":需要改写的内容是:main()

这个应用程序是一个命令行应用程序。作为一个扩展,您可以使用Streamlit为该应用程序添加Web界面。

执行文件分析

要执行文档分析,将所要分析的文档存储在项目所在的同一个文件夹中,然后运行该程序。它将询问所要分析的文档的名称。输入全名,然后输入查询,以便程序分析。

以下截图展示了对PDF进行分析的结果

以下の出力は、with ソース コードを含むテキスト ファイルの分析結果を示しています。

#分析するファイルが PDF またはテキスト形式であることを確認してください。ドキュメント が 他の形式 である場合は、オンライン ツールを使用して PDF 形式 に変換できます。 完全なソース コードは、GitHub コード リポジトリで入手できます: https://github.com/makeuseofcode/Document-analysis-using-LangChain-and-OpenAI

# #元のタイトル:

How 書き換える必要がある内容は次のとおりです: to 書き換える必要がある内容は次のとおりです: Analyze 書き換える必要がある内容は次のとおりです: ドキュメント書き換えが必要な内容は次のとおりです。 書き換えが必要な内容は次のとおりです。 書き換えが必要な内容は次のとおりです。 書き換えが必要な内容は次のとおりです。 書き換えが必要な内容は次のとおりです。 書き換えが必要な内容は次のとおりです。は: OpenAI 書き換える必要があるコンテンツは: API、作成者 : Denis が書き直す必要があるコンテンツは: Kuraa

書き直す必要がある内容は次のとおりです。以上がドキュメント分析に LangChain と OpenAI API を使用する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

【2025年最新】ChatGPT(チャットGPT)とは?無料での始め方や料金、使い方のコツを解説!May 12, 2025 pm 04:16 PM

【2025年最新】ChatGPT(チャットGPT)とは?無料での始め方や料金、使い方のコツを解説!May 12, 2025 pm 04:16 PMChatGPT:AIを活用した対話型サービスの活用ガイド ChatGPTは、AIによる自然な対話、文章生成、要約、コード生成などを可能にするサービスです。幅広い用途が期待される一方、効果的な活用には基本的な操作方法、注意点、問題点の理解が不可欠です。本記事では、具体的な利用例を交え、無料版の始め方、アプリの入手方法、効果的な活用方法、無料プランと有料プランの違い、ビジネス活用方法などを解説します。AI初心者にも役立つ情報です。記事が長いので、目次から必要な箇所へ直接アクセスできます。ブックマーク

OpenAI o1(ChatGPT o1)とは?使い方や料金、Proについて解説!May 12, 2025 pm 04:15 PM

OpenAI o1(ChatGPT o1)とは?使い方や料金、Proについて解説!May 12, 2025 pm 04:15 PMOpenaiは、新しいAIモデルシリーズであるOpenai O1をリリースし、その機能、アプリケーション、およびGPT-4Oとの違いを深く分析します Openaiの最新のAIモデルシリーズ「Openai O1」は、広範囲にわたる注目を集めており、その強力な推論と深い思考能力が多くの注目を集めています。この記事では、この記事のGPT-4Oとの特性、使用方法、価格戦略、違いについて説明します。複雑な推論を効率的に処理するO1-MINIから、学術分野での強さを示すOpenai O1まで、その可能性を完全に明らかにし、科学、数学、プログラミングなどのSTEM分野での優れたパフォーマンスを調査します。 Openai O1の紹介(chatgpt-o1)

AI宇宙会社が生まれましたMay 12, 2025 am 11:07 AM

AI宇宙会社が生まれましたMay 12, 2025 am 11:07 AMこの記事では、AIが宇宙産業にどのように革命をもたらしているかを示しています。 明日、AIでAIを使用して建設されていないSpaceXのような既存の宇宙企業とは異なり、AIネイティブ企業です。 探検しましょう

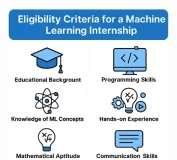

インドでの10機の機械学習インターンシップ(2025)May 12, 2025 am 10:47 AM

インドでの10機の機械学習インターンシップ(2025)May 12, 2025 am 10:47 AMインドであなたの夢の機械学習インターンシップを上陸させてください(2025)! 学生や早期キャリアの専門家にとって、機械学習インターンシップは、やりがいのあるキャリアに最適なランチパッドです。 最先端のジェナからの多様なセクターのインド企業

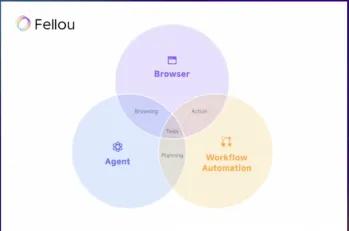

fellou aiを試して、Googleに別れを告げてChatgptを言ってくださいMay 12, 2025 am 10:26 AM

fellou aiを試して、Googleに別れを告げてChatgptを言ってくださいMay 12, 2025 am 10:26 AMオンラインブラウジングの風景は、過去1年間に大きな変化を遂げました。 このシフトは、PrplexityやCopilotなどのプラットフォームからの強化されたパーソナライズされた検索結果から始まり、ChatGPTのWeb Sの統合で加速しました

個人的なハッキングはかなり激しいクマになりますMay 11, 2025 am 11:09 AM

個人的なハッキングはかなり激しいクマになりますMay 11, 2025 am 11:09 AMサイバー攻撃が進化しています。 一般的なフィッシングメールの時代は終わりました。 サイバー犯罪の将来は超個人化されており、高度にターゲットを絞った攻撃を作成するために、容易に利用可能なオンラインデータとAIを活用しています。 あなたの仕事を知っている詐欺師を想像してください、あなたのf

教皇レオXIVは、AIが彼の名前の選択にどのように影響したかを明らかにしますMay 11, 2025 am 11:07 AM

教皇レオXIVは、AIが彼の名前の選択にどのように影響したかを明らかにしますMay 11, 2025 am 11:07 AM枢機of大学への彼の就任演説では、シカゴ生まれのロバート・フランシス・プレボスト、新たに選出された教皇レオ14世は、彼の同名の教皇レオXIIIの影響について議論しました。

初心者および専門家向けのFastapi -MCPチュートリアル-Analytics VidhyaMay 11, 2025 am 10:56 AM

初心者および専門家向けのFastapi -MCPチュートリアル-Analytics VidhyaMay 11, 2025 am 10:56 AMこのチュートリアルでは、モデルコンテキストプロトコル(MCP)とFastAPIを使用して、大規模な言語モデル(LLM)と外部ツールを統合する方法を示しています。 FastAPIを使用して簡単なWebアプリケーションを構築し、それをMCPサーバーに変換し、Lを有効にします

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

メモ帳++7.3.1

使いやすく無料のコードエディター

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。