・第 3 世代の大型ベース モデル ChatGLM3 は、中国語のグラフィックとテキストを理解する能力を向上させ、質問に基づいてインターネット上の関連情報を自動的に検索できるビジュアル モード GPT-4V を目指しています。回答する際には参考文献や記事へのリンクを提供してください。最終テスト モデル ChatGLM3-1.5B および ChatGLM3-3B は、vivo、Xiaomi、Samsung の携帯電話および車両プラットフォームをサポートします。

10月27日、2023年中国コンピュータカンファレンスで、中国のコグニティブ大型モデル会社北京芝埔華庄科技有限公司(以下「芝埔AI」)は、マルチ技術を採用した第3世代ベース大型モデルChatGLM3を発表した。 -段階の強化された予測により、トレーニングがより完全になり、携帯電話に展開できる ChatGLM3-1.5B および ChatGLM3-3B が発売され、vivo、Xiaomi、Samsung などのさまざまな携帯電話や車載プラットフォームがサポートされます。 。

ビジュアルモード GPT-4V を目指して、ChatGLM3 は、10 を超える国際標準画像およびテキスト評価データセットで SOTA (最高のパフォーマンス) を達成した CogVLM のマルチモーダル理解機能を含む、いくつかの新機能の反復アップグレードを実装しました。 。 、 最先端の)。 CogVLM モデルは、中国語のグラフィックスとテキストの理解を向上させ、複雑なターゲット検出を完了し、それにラベルを付けて自動データ アノテーションを完了することができます。レシピは材料の写真に基づいて提供され、対話者の好みに合わせて調整できます。

レシピは材料の写真に基づいて提供されます。

Zhipu AI の CEO、Zhang Peng 氏は The Paper (www.thepaper.cn) に対し、マルチモーダル大規模モデルは音声、視覚、自然言語のインタラクティブな認識において多くの具体的な進歩を遂げ、将来的にはマルチになると語った。 -モーダル大規模モデルは、より重要な段階に移行し、より多くのモーダルデータが統合される可能性があり、マルチモーダル事前トレーニングにより、大規模モデルの知能または認知能力のさらなる向上にもつながります。

ChatGLM3 のコード拡張モジュール コード インタープリターは、ユーザーのニーズに応じてコードを生成および実行し、データ分析やファイル処理などの複雑なタスクを自動的に完了します。 「コード」機能は現在、画像処理、数学的計算、データ分析、その他の使用シナリオをサポートしています。

Web 検索の強化 WebGLM のアクセス検索の強化により、質問に基づいてインターネット上の関連情報を自動的に検索し、回答時に参考文献や記事のリンクを提供できます。

ChatGLM3 は AgentTuning テクノロジーを統合し、モデル エージェント機能を有効にし、国内の大規模モデルがツール呼び出し、コード実行、ゲーム、データベース操作、ナレッジ グラフの検索と推論、オペレーティング システム、その他のシナリオをネイティブにサポートできるようにします。

現在、ChatGLM3 は、携帯電話に導入できるエンドテスト モデル ChatGLM3-1.5B および ChatGLM3-3B をリリースしています。これらは、vivo、Xiaomi、Samsung などのさまざまな携帯電話や車載プラットフォームをサポートしています。モバイル プラットフォーム上の CPU チップは 20 トークン/秒の速度です。

Zhang Peng 氏は、2022 年の初め以来、Zhipu AI によって発売された GLM シリーズ モデルは、Ascend、Sunway Supercomputing、Haiguang DCU アーキテクチャでの大規模な事前トレーニングと推論をサポートしていると述べました。現在、Zhipu AIの製品は10以上の国内ハードウェアエコシステムをサポートしており、国内チップ企業との共同イノベーションは国内ネイティブ大型モデルと国産チップの開発を支援する。

以上がZhipu AI、国産チップに適合した第 3 世代大型ベースモデルを発売の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

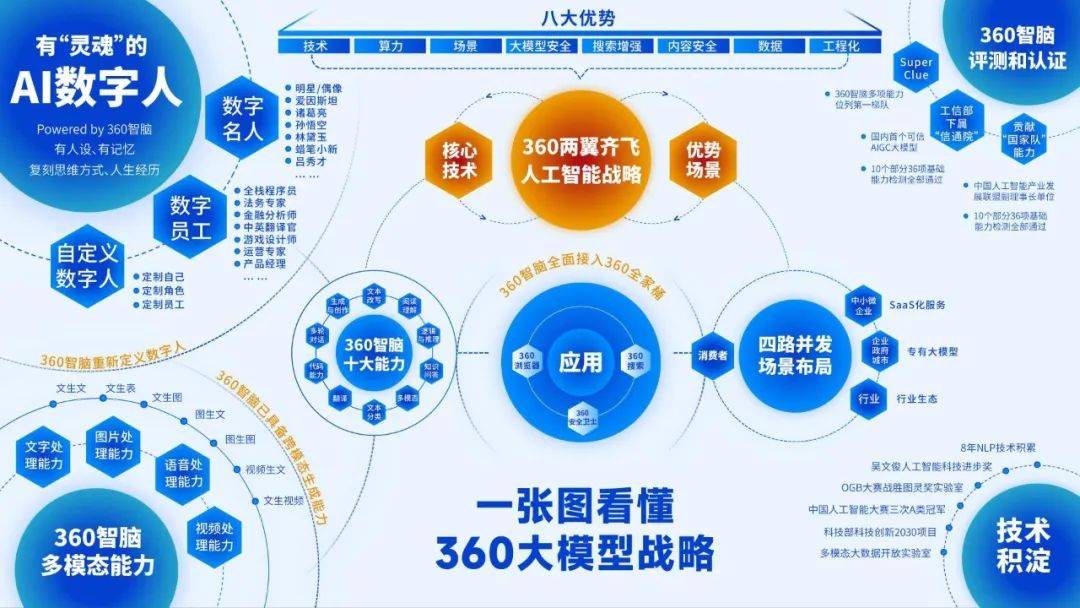

AI技术加速迭代:周鸿祎视角下的大模型战略Jun 15, 2023 pm 02:25 PM

AI技术加速迭代:周鸿祎视角下的大模型战略Jun 15, 2023 pm 02:25 PM今年以来,360集团创始人周鸿祎在所有公开场合的讲话都离不开一个话题,那就是人工智能大模型。他曾自称“GPT的布道者”,对ChatGPT取得的突破赞不绝口,更是坚定看好由此产生的AI技术迭代。作为一个擅于表达的明星企业家,周鸿祎的演讲往往妙语连珠,所以他的“布道”也创造过很多热点话题,确实为AI大模型添了一把火。但对周鸿祎而言,光做意见领袖还不够,外界更关心他执掌的360公司如何应对这波AI新浪潮。事实上,在360内部,周鸿祎也早已掀起一场全员变革,4月份,他发出内部信,要求360每一位员工、每

蚂蚁集团推出金融大模型产品:金融助理“支小宝 2.0”和业务助手“支小助”,已完成备案并即将上线Sep 10, 2023 pm 06:13 PM

蚂蚁集团推出金融大模型产品:金融助理“支小宝 2.0”和业务助手“支小助”,已完成备案并即将上线Sep 10, 2023 pm 06:13 PM蚂蚁集团在上海举行的第二届外滩大会上,宣布正式发布旗下的金融大模型据蚂蚁集团介绍,蚂蚁金融大模型基于其自研基础大模型,并针对金融产业进行深度定制,底层算力集群达到万卡规模。目前,该大模型已在蚂蚁集团财富、保险平台全面测试。同时,基于该大模型的两款产品——智能金融助理“支小宝2.0”、服务金融产业专家的智能业务助手“支小助”,也已正式亮相。据介绍,两款大模型产品展示了蚂蚁从基础大模型到行业大模型以及产业应用的全栈布局和进展。本站附两款产品目前进度如下:“支小宝2.0”已经开始内测近半年,将在完成相

百度CIO李莹:大模型是企业办公领域的重要机遇,AI的原生重构将改变智能工作方式Aug 18, 2023 pm 11:49 PM

百度CIO李莹:大模型是企业办公领域的重要机遇,AI的原生重构将改变智能工作方式Aug 18, 2023 pm 11:49 PM2023年8月16日,WAVESUMMIT深度学习开发者大会在中国举办,该活动由深度学习技术及应用国家工程研究中心主办,百度飞桨和文心大模型承办。在会上,百度发布了文心大模型、飞桨平台和AI原生应用如流等一系列技术、产品的最新进展和生态成果。百度集团副总裁兼首席信息官李莹发表了主题演讲,她认为当前以AI大模型为核心技术的第四次科技革命将从根本上推动生产力变革,为各行各业提供强大支持,并为企业办公领域带来前所未有的发展机遇基于AI原生思维,李莹宣布,百度智能工作知识管理理念“创新流水线=AIx知识

腾讯汤道生:大模型只是起点,产业落地是AI更大的应用场景Jun 22, 2023 pm 04:18 PM

腾讯汤道生:大模型只是起点,产业落地是AI更大的应用场景Jun 22, 2023 pm 04:18 PM6月21日,北大光华管理学院联合腾讯,宣布升级“数字中国筑塔计划”,共同推出“企业管理者人工智能通识课”系列课程。在第一课上,腾讯集团高级执行副总裁、云与智慧产业事业群CEO汤道生回顾了AI发展的历史,表示算法创新、算力增强、开源共创三大因素的叠加,构成了AI的“增长飞轮”。大模型的快速进步,推动我们正在进入一个被AI重塑的时代。汤道生表示,大模型只是起点,未来,应用落地的产业变革是更大的图景。企业过去的研发、生产、销售、服务等环节中,有很多依赖人来判断、协调与沟通的地方,今天都值得去看看,哪些

成功孵化首个大型模型解决方案的重庆人工智能创新中心Aug 06, 2023 pm 09:01 PM

成功孵化首个大型模型解决方案的重庆人工智能创新中心Aug 06, 2023 pm 09:01 PM最近,重庆人工智能创新中心成功孵化了云从科技的首个大模型解决方案,名为“从容大模型训推一体机”,并已成功部署。作为国内最早布局大模型的云服务商之一,华为不仅致力于深耕算力,打造强大的算力基础设施来支持中国人工智能事业的发展,而且还着眼于通用大模型和行业大模型,真正实现为千行百业和科学研究提供优质的人工智能服务经过重庆人工智能创新中心技术团队、昇腾研发专家和云从科技人工智能研究院的共同努力,一个月内顺利完成了“从容大模型训推一体机”的精度与性能对齐、产品集成与测试等工作,这成为了重庆人工智能创新中

科大讯飞人工智能大模型升级,另有6家上市公司也已布局大模型Jun 10, 2023 am 08:11 AM

科大讯飞人工智能大模型升级,另有6家上市公司也已布局大模型Jun 10, 2023 am 08:11 AM近日,科大讯飞公告其构建的“讯飞星火认知大模型”将举行升级发布会,推出该人工智能大模型的V1.5(1.5版本)。此前,朗玛信息也因推出“朗玛•39AI全科医生”大模型产品举行发布会。此外,还有5家上市公司也在与投资者沟通交流中,披露已布局AI(人工智能)大模型的信息。来源:摄图网科大讯飞的“讯飞星火认知大模型”升级至1.5版近日,科大讯飞股份有限公司(证券简称:科大讯飞;证券代码:002230.SZ)披露了《关于讯飞星火认知大模型升级发布会的提示性公告》。公告显示,2023年5月6日,科大讯飞举

融合GPT大模型产品,WakeData新一轮产品升级May 02, 2023 pm 11:10 PM

融合GPT大模型产品,WakeData新一轮产品升级May 02, 2023 pm 11:10 PM近期,WakeData惟客数据(以下简称“WakeData”)完成了新一轮的产品能力升级。在2022年11月的产品发布会上,已传递出WakeData的“三个坚定”:始终坚定技术投入,全面夯实核心产品的科技能力和自研率;始终坚定国产化适配能力,支持国产芯片、操作系统、数据库、中间件、国密算法等,并在同领域实现对国外厂商的国产化替代;始终坚定拥抱生态,与伙伴共创共赢。WakeData继续新一轮的产品能力升级,凭借过去5年的技术积累,以及在地产、零售、汽车等行业和垂直领域的实践,与战略伙伴联合研发具

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

メモ帳++7.3.1

使いやすく無料のコードエディター

SAP NetWeaver Server Adapter for Eclipse

Eclipse を SAP NetWeaver アプリケーション サーバーと統合します。

ホットトピック

7442

7442 15

15 1371

1371 52

52