ホームページ >テクノロジー周辺機器 >AI >Zhipu AI は清華 KEG と協力して、CogVLM-17B と呼ばれるオープンソースのマルチモーダル大規模モデルをリリースしました

Zhipu AI は清華 KEG と協力して、CogVLM-17B と呼ばれるオープンソースのマルチモーダル大規模モデルをリリースしました

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-10-12 11:41:011388ブラウズ

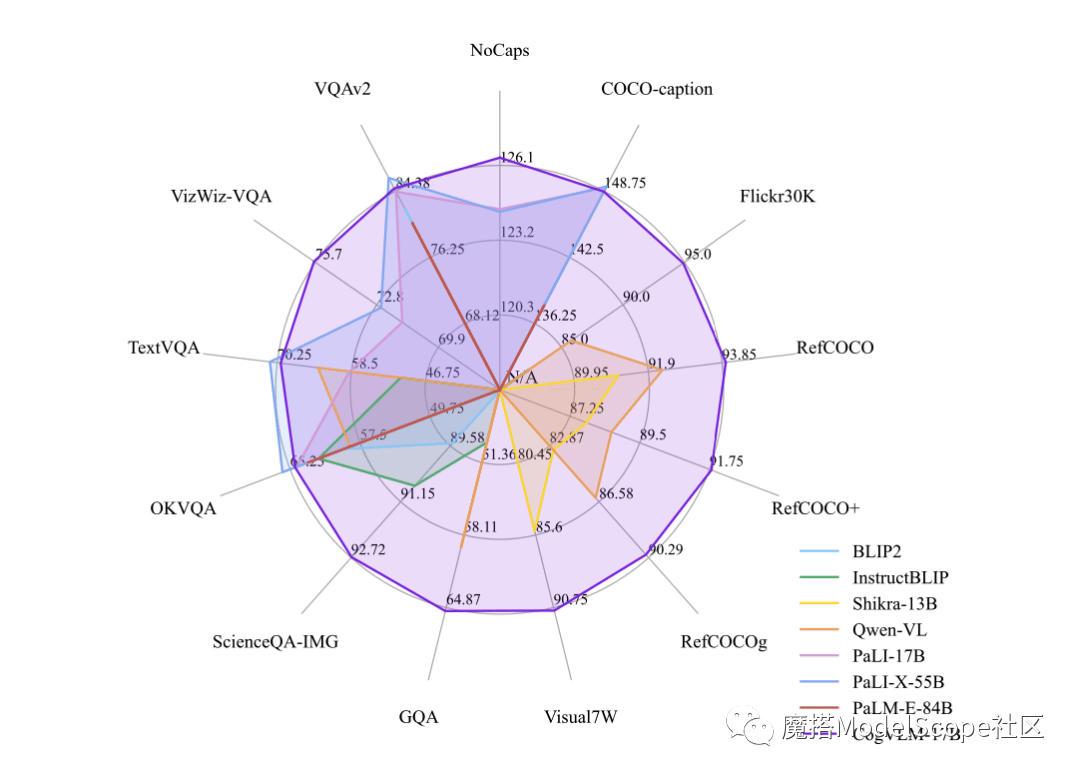

鞭牛士 10 月 12 日のニュース、最近、Zhipu AI と清華 KEG は、マルチモーダル大型モデル CogVLM-17B を Moda コミュニティでリリースし、直接オープンソース化しました。 CogVLM は、ビジュアル エキスパート モジュールを使用して言語コーディングとビジュアル コーディングを深く統合する強力なオープンソース ビジュアル言語モデルであり、14 の信頼できるクロスモーダル ベンチマークで SOTA パフォーマンスを達成したことが報告されています。

CogVLM-17B は現在、マルチモーダルの権威ある学術リストで最初の包括的なパフォーマンスを備えたモデルであり、14 のデータセットで最先端または 2 位の結果を達成しています。 CogVLMの効果は「視覚優先」、つまりマルチモーダルモデルにおいて視覚的な理解を優先するという考え方に依存します。 5B パラメーターのビジュアル エンコーダーと 6B パラメーターのビジュアル エキスパート モジュールを使用しており、画像の特徴をモデル化するために合計 11B のパラメーターがあり、テキストの 7B パラメーターよりもさらに多くなります

以上がZhipu AI は清華 KEG と協力して、CogVLM-17B と呼ばれるオープンソースのマルチモーダル大規模モデルをリリースしましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

声明:

この記事はsohu.comで複製されています。侵害がある場合は、admin@php.cn までご連絡ください。