強化学習における報酬関数設計の問題

はじめに

強化学習は、エージェントと環境の間の相互作用を通じて最適な戦略を学習する方法です。強化学習では、報酬関数の設計がエージェントの学習効果にとって重要です。この記事では、強化学習における報酬関数の設計の問題を調査し、具体的なコード例を示します。

- 報酬関数の役割と目標

報酬関数は強化学習の重要な部分であり、特定の状態でエージェントによって得られる報酬値を評価するために使用されます。その設計は、エージェントが最適なアクションを選択することで長期的な累積報酬を最大化するようにガイドするのに役立ちます。

優れた報酬関数には、次の 2 つの目標がある必要があります:

(1) エージェントが最適な戦略を学習できるように十分な情報を提供する;

(2) 適切な報酬フィードバック ガイドを通じてエージェントは非効果的で有害な行動を回避します。

- 報酬関数設計における課題

報酬関数の設計は次の課題に直面する可能性があります:

(1) スパース: 場合によっては、環境の報酬信号が非常にスパースである可能性があります。その結果、学習プロセスが遅くなったり、不安定になったりします。

(2) 誤解を招く: 報酬シグナルが正しくない、または不十分であると、エージェントが間違った戦略を学習する可能性があります。

(3) 高次元性: 多数の状態とアクションがある複雑な環境では、報酬関数を設計することがより困難になります。

(4) 目標の矛盾: 目標が異なると、短期目標と長期目標のバランスなど、報酬関数の設計において矛盾が生じる可能性があります。 - 報酬関数設計の方法

報酬関数設計の課題を克服するために、次の方法を使用できます:

(1) 手動設計: 以前の情報に基づく知識と経験、報酬関数を手動で設計します。このアプローチは通常、単純な問題には機能しますが、複雑な問題の場合は困難になる可能性があります。

(2) 報酬エンジニアリング: 補助的な報酬またはペナルティを導入することで、報酬関数のパフォーマンスを向上させます。たとえば、エージェントの学習をより適切に導くために、特定の状態やアクションに追加の報酬やペナルティを適用することができます。

(3) 適応報酬関数: 適応アルゴリズムを使用して報酬関数を動的に調整します。この方法では、時間の経過とともに報酬関数の重みを変更して、さまざまな段階の学習ニーズに適応できます。

- 具体的なコード例

次は、深層強化学習フレームワーク TensorFlow と Keras を使用したサンプル コードで、報酬関数がどのように設計されているかを示しています。

import numpy as np

from tensorflow import keras

# 定义强化学习智能体的奖励函数

def reward_function(state, action):

# 根据当前状态和动作计算奖励值

reward = 0

# 添加奖励和惩罚条件

if state == 0 and action == 0:

reward += 1

elif state == 1 and action == 1:

reward -= 1

return reward

# 定义强化学习智能体的神经网络模型

def create_model():

model = keras.Sequential([

keras.layers.Dense(64, activation='relu', input_shape=(2,)),

keras.layers.Dense(64, activation='relu'),

keras.layers.Dense(1)

])

model.compile(optimizer='adam', loss='mean_squared_error')

return model

# 训练智能体

def train_agent():

model = create_model()

# 智能体的训练过程

for episode in range(num_episodes):

state = initial_state

# 智能体根据当前策略选择动作

action = model.predict(state)

# 获得当前状态下的奖励值

reward = reward_function(state, action)

# 更新模型的权重

model.fit(state, reward)In上記のコードでは、reward_function 関数を定義することで報酬関数を設計し、エージェントのトレーニング時に現在の状態とアクションに基づいて報酬値を計算します。同時に、create_model 関数を使用してエージェントをトレーニングするためのニューラル ネットワーク モデルを作成し、model.predict 関数を使用して現在の戦略に基づいてアクションを選択します。

結論

強化学習における報酬関数の設計は、重要かつ困難な問題です。正しく設計された報酬関数は、エージェントが最適な戦略を学習するように効果的に導くことができます。この記事では、報酬関数の役割と目標、設計上の課題、具体的なコード例について説明することで、読者に強化学習における報酬関数の設計に関する参考とインスピレーションを提供したいと考えています。

以上が強化学習における報酬関数設計の問題の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

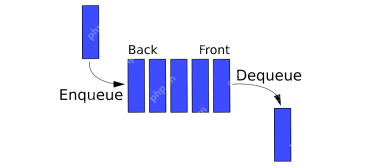

Pythonのキュー - 分析VidhyaApr 16, 2025 am 10:32 AM

Pythonのキュー - 分析VidhyaApr 16, 2025 am 10:32 AM導入 スーパーマーケットのキューに自分自身を想像して、お気に入りのアーティストのコンサートチケットを購入するためにあなたの番を辛抱強く待ってください。 個人がラインに加わり、最初の(FIFO)方法で最初に進むこの整然としたプロセスは正確です

AVバイト:AI業界のシフトと技術的ブレークスルー - 分析VidhyaApr 16, 2025 am 10:29 AM

AVバイト:AI業界のシフトと技術的ブレークスルー - 分析VidhyaApr 16, 2025 am 10:29 AM今週のAI:主要な買収、モデルの進歩、倫理的考慮事項 このAV BYTESエディションは、先週の重要なAIブレークスルーをカバーしています。 GoogleのChargether.AIの戦略的な買収からBitnet B1.58の発売まで、

Movinetsの探索:効率的なモバイルビデオ認識Apr 16, 2025 am 10:25 AM

Movinetsの探索:効率的なモバイルビデオ認識Apr 16, 2025 am 10:25 AM導入 「Movinets Unleashed」でモバイルビデオ認識の魅力的な世界に飛び込んでみましょう!このブログでは、Movinetsがモバイルデバイスのビデオ分析をどのように変換しているかを探求します。

パンダ対ポーラーApr 16, 2025 am 10:24 AM

パンダ対ポーラーApr 16, 2025 am 10:24 AM導入 データプロジェクトでひざまずき、大規模なデータセットで格闘し、可能な限り速くパターンを探していると想像してください。あなたはあなたの頼りになるデータ操作ツールに手を伸ばしますが、より良いオプションが存在する場合はどうなりますか? 比較的ne、ポーラーを入力します

ITビジネスアナリストの役割Apr 16, 2025 am 10:19 AM

ITビジネスアナリストの役割Apr 16, 2025 am 10:19 AM導入 革新的なソフトウェアを立ち上げる寸前のダイナミックITファームを想定しています。 興奮は高くなりますが、重要な課題が現れます。技術開発者とビジネス利害関係者の間のギャップを埋めることです。これがITビジネスアナリストです

Pythonの要因プログラムApr 16, 2025 am 10:13 AM

Pythonの要因プログラムApr 16, 2025 am 10:13 AM導入 特定の希望のフレーバープロファイルで料理を準備することを想像してください。正しい一連のステップが重要です。 同様に、数学とプログラミングでは、数字の要因を計算するには、一連の乗法の正確なシーケンスが必要です

データオーケストレーションのためのエアフローの代替品 - 分析VidhyaApr 16, 2025 am 09:55 AM

データオーケストレーションのためのエアフローの代替品 - 分析VidhyaApr 16, 2025 am 09:55 AM導入 Apache Airflowは、データオーケストレーションの重要なコンポーネントであり、複雑なワークフローを処理し、データパイプラインを自動化する機能で知られています。多くの組織がその柔軟性とSのためにそれを選択しています

Nvidia AI Summit 2024に登録するにはどうすればよいですか?Apr 16, 2025 am 09:49 AM

Nvidia AI Summit 2024に登録するにはどうすればよいですか?Apr 16, 2025 am 09:49 AMNVIDIA AIサミット2024:インドのAI革命に深く潜る 2024年のデータハックサミットに続いて、インドはムンバイのJio World Convention Centerで10月23日から25日に予定されているNvidia AI Summit 2024に向けて準備を進めています。 この極めて重要なイベントプロム

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

Dreamweaver Mac版

ビジュアル Web 開発ツール

PhpStorm Mac バージョン

最新(2018.2.1)のプロフェッショナル向けPHP統合開発ツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。