チャットボットにおけるコンテキスト生成の問題とコード例

要約: 人工知能の急速な発展に伴い、チャットボットは重要なアプリケーション シナリオとして広く関心を集めています。ただし、チャットボットはユーザーと会話する際に文脈の理解に欠けていることが多く、その結果、会話の品質が低下します。この記事では、チャットボットにおけるコンテキスト生成の問題を調査し、具体的なコード例を使用して解決します。

1. はじめに

チャット ロボットは、人工知能の分野において重要な研究および応用価値があり、人々の間の会話をシミュレートし、自然言語による対話を実現できます。ただし、従来のチャットボットは多くの場合、ユーザー入力に基づいて単に応答するだけであり、コンテキストの理解や記憶機能が不足しています。そのため、チャットボットの会話は支離滅裂で人間味のあるものに見え、ユーザー エクスペリエンスは比較的劣悪になります。

2. コンテキスト生成問題の原因

- コンテキスト情報の不足。従来のチャットボットの会話はユーザーの現在の入力のみに依存し、以前の会話履歴を参照として使用できず、会話に関するコンテキスト情報が不足しています。

- 対話の流れが壊れています。従来のチャットボットの応答は、ユーザーの現在の入力にのみ応答し、一貫した会話を実行できないため、会話プロセスが中断されてしまいます。

3. コンテキスト生成の解決策

チャットボットにおけるコンテキスト生成の問題を解決するには、いくつかのテクノロジーとアルゴリズムを使用してチャットボットの会話機能を向上させることができます。

- リカレント ニューラル ネットワーク (RNN) を使用します。

リカレント ニューラル ネットワークは、シーケンス データを処理できるニューラル ネットワーク構造です。前の文を現在の入力の一部として使用することで、RNN はコンテキスト情報を記憶し、回答を生成するときにそれを使用できます。以下は、RNN を使用して会話コンテキストを処理するコード例です。

import tensorflow as tf

import numpy as np

# 定义RNN模型

class ChatRNN(tf.keras.Model):

def __init__(self):

super(ChatRNN, self).__init__()

self.embedding = tf.keras.layers.Embedding(VOCAB_SIZE, EMBEDDING_DIM)

self.rnn = tf.keras.layers.GRU(EMBEDDING_DIM, return_sequences=True, return_state=True)

self.fc = tf.keras.layers.Dense(VOCAB_SIZE)

def call(self, inputs, training=False):

x = self.embedding(inputs)

x, state = self.rnn(x)

output = self.fc(x)

return output, state

# 训练模型

model = ChatRNN()

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

model.fit(x_train, y_train, epochs=10)- アテンション メカニズムを使用します。

アテンション メカニズムにより、モデルは回答を生成する際にコンテキスト内の重要な情報に重みを付け、回答の精度と一貫性を向上させることができます。以下は、アテンション メカニズムを使用して会話コンテキストを処理するコード例です:

import tensorflow as tf

import numpy as np

# 定义注意力模型

class AttentionModel(tf.keras.Model):

def __init__(self):

super(AttentionModel, self).__init__()

self.embedding = tf.keras.layers.Embedding(VOCAB_SIZE, EMBEDDING_DIM)

self.attention = tf.keras.layers.Attention()

self.fc = tf.keras.layers.Dense(VOCAB_SIZE)

def call(self, inputs, training=False):

x = self.embedding(inputs)

x, attention_weights = self.attention(x, x)

output = self.fc(x)

return output, attention_weights

# 训练模型

model = AttentionModel()

model.compile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

model.fit(x_train, y_train, epochs=10)IV. 概要

実際のアプリケーションでは、多くの場合、チャット ロボットは、会話コンテキストを処理するためにコンテキストを生成する機能を必要とします。より自然でスムーズな会話体験。この記事では、チャットボットにおけるコンテキスト生成の問題を紹介し、問題を解決するために RNN とアテンション メカニズムを使用するコード例を示します。会話履歴に参照と重み付けを追加することで、チャットボットはコンテキスト情報をよりよく理解し、一貫した応答を生成できるようになります。これらの方法は、チャットボットの会話機能を向上させるための重要なアイデアと方法を提供します。

参考文献:

- Sutskever, I.、Vinyals, O.、& Le, Q. V. (2014). ニューラル ネットワークによるシーケンスからシーケンスへの学習. ニューラル情報処理システムの進歩(pp. 3104-3112).

- Vaswani, A.、Shazeer, N.、Parmar, N.、Uszkoreit, J.、Jones, L.、Gomez, A. N.、... & Polosukhin, I . (2017). 必要なのは注意だけです. 神経情報処理システムの進歩 (pp. 5998-6008).

- Zhou, Y.、Zhang, H.、& Wang, H. (2017 ) . 感情的なチャット マシン: 内部および外部記憶による感情的な会話の生成. 計算言語学協会第 55 回年次総会予稿集 (第 1 巻: 長編論文) (pp. 1318-1327).

以上がチャットボットにおけるコンテキスト生成の問題の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

Pydanticを使用した構造化された研究自動化システムの構築Apr 24, 2025 am 10:32 AM

Pydanticを使用した構造化された研究自動化システムの構築Apr 24, 2025 am 10:32 AM学術研究の動的な分野では、効率的な情報収集、統合、およびプレゼンテーションが最重要です。 文献レビューの手動プロセスは時間がかかり、より深い分析を妨げています。 マルチエージェントリサーチアシスタントシステムBUI

10 GPT-4Oの画像生成が今日試してみるようにプロンプトします!Apr 24, 2025 am 10:26 AM

10 GPT-4Oの画像生成が今日試してみるようにプロンプトします!Apr 24, 2025 am 10:26 AMAIの世界では絶対に野生のものが起こっています。 Openaiのネイティブイメージの生成は今、非常識です。私たちは顎を落とすビジュアル、恐ろしい良いディテール、そして洗練された出力について話しています。

Windsurfを使用したバイブコーディングのガイドApr 24, 2025 am 10:25 AM

Windsurfを使用したバイブコーディングのガイドApr 24, 2025 am 10:25 AMAIを搭載したコーディングコンパニオンであるCodeiumのWindsurfで、コーディングのビジョンを楽に命を吹き込みます。 Windsurfは、コーディングやデバッグから最適化まで、ソフトウェア開発ライフサイクル全体を合理化し、プロセスをINTUに変換します

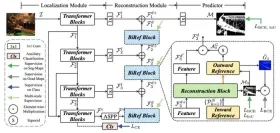

RMGB V2.0を使用した画像のバックグラウンド削除の調査Apr 24, 2025 am 10:20 AM

RMGB V2.0を使用した画像のバックグラウンド削除の調査Apr 24, 2025 am 10:20 AMBraiaiのRMGB V2.0:強力なオープンソースバックグラウンド除去モデル 画像セグメンテーションモデルはさまざまな分野に革命をもたらし、バックグラウンドの削除が進歩の重要な分野です。 BraiaiのRMGB V2.0は、最先端のオープンソースmとして際立っています

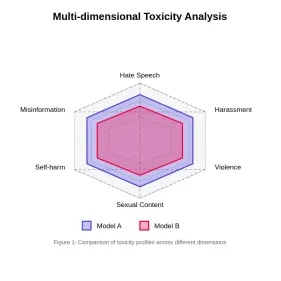

大規模な言語モデルでの毒性の評価Apr 24, 2025 am 10:14 AM

大規模な言語モデルでの毒性の評価Apr 24, 2025 am 10:14 AMこの記事では、大規模な言語モデル(LLM)における毒性の重要な問題と、それを評価して軽減するために使用される方法について説明します。 LLMSは、チャットボットからコンテンツ生成までさまざまなアプリケーションを電力を供給し、堅牢な評価メトリック、ウィットを必要とします

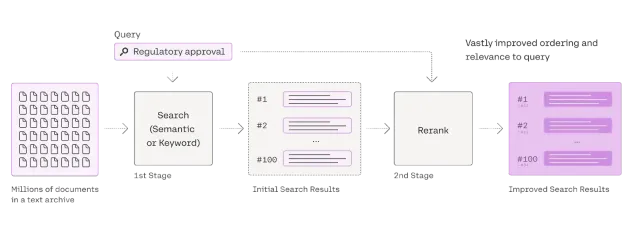

RagのRerankerに関する包括的なガイドApr 24, 2025 am 10:10 AM

RagのRerankerに関する包括的なガイドApr 24, 2025 am 10:10 AM検索拡張生成(RAG)システムは情報アクセスを変換していますが、その有効性は取得データの品質にかかっています。 これは、再審査員が重要になる場所です。

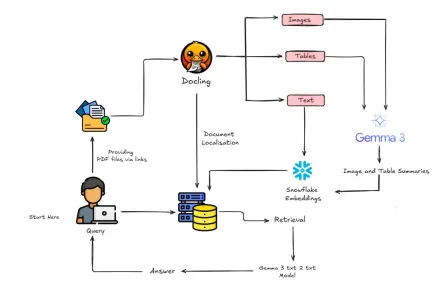

Gemma 3とDoclingでマルチモーダルラグを構築する方法は?Apr 24, 2025 am 10:04 AM

Gemma 3とDoclingでマルチモーダルラグを構築する方法は?Apr 24, 2025 am 10:04 AMこのチュートリアルでは、Google Colab内に洗練されたマルチモーダル検索の高性化(RAG)パイプラインを構築することを紹介します。 Gemma 3(言語とビジョンのため)、Docling(Document Conversion)、Langchainなどの最先端のツールを利用します

スケーラブルなAIおよび機械学習アプリケーションのためのRayへのガイドApr 24, 2025 am 10:01 AM

スケーラブルなAIおよび機械学習アプリケーションのためのRayへのガイドApr 24, 2025 am 10:01 AMレイ:AIおよびPythonアプリケーションをスケーリングするための強力なフレームワーク Rayは、AIおよびPythonアプリケーションを簡単にスケーリングするように設計された革新的なオープンソースフレームワークです。 その直感的なAPIを使用すると、研究者と開発者がコードを移行することができます

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 中国語版

中国語版、とても使いやすい

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

WebStorm Mac版

便利なJavaScript開発ツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。