GPT-3 と Llama に「A は B である」という単純な知識を学習させ、次に B は何かと順番に尋ねましたが、AI の答えの精度はゼロであることが判明しました。 ############これはどういう意味ですか?

最近、「逆転の呪い」と呼ばれる新しい概念が人工知能コミュニティで激しい議論を引き起こし、現在普及しているすべての大規模言語モデルが影響を受けています。非常に単純な問題に直面すると、その精度はゼロに近いだけでなく、精度を向上させる可能性もないようです。

さらに、研究者らは、この重大な脆弱性が次のようなものであることも発見しました。モデルとは関係ありません 規模や提起された質問とは何の関係もありません

人工知能は大規模なモデルを事前トレーニングする段階まで発展したと言いましたが、ついにそれが実現したようです論理的思考が少しは身についたはずですが、今回は元の形に戻ってしまったようです

# 図 1: 知識の不一致GPT-4。 GPT-4 はトム クルーズの母親の名前を正確に示しました (左)。しかし、息子に尋ねるために母親の名前を入力したところ、「トム・クルーズ」(右)は検索できなかった。新しい研究では、この選別効果は呪いの逆転によるものであるという仮説が立てられています。 「A は B」でトレーニングされたモデルは、「B は A」を自動的に推論しません。

研究によると、人工知能の分野で現在盛んに議論されている自己回帰言語モデルは、このように一般化できないことがわかっています。特に、モデルのトレーニング セットに「オラフ ショルツは第 9 代ドイツ首相でした」のような文が含まれており、「オラフ ショルツ」という名前が「第 9 代ドイツ首相」の説明の前にあるとします。その後、大規模なモデルは「オラフ・ショルツとは誰ですか?」という質問に正しく答えることを学習するかもしれませんが、名前の前にある他のプロンプトには答えたり説明したりすることはできません。これは「Reverse Curse」のソート効果の例です。モデル 1 が「 は です」(名前の後に説明あり) という形式の文でトレーニングされた場合、モデルは逆方向に「

は」を自動的に予測しません。特に、大規模言語モデル (LLM) が で条件付けされている場合、モデル の可能性はランダムなベースラインよりも高くはなりません。

です」という形式の文は、トレーニング前のデータセットに一緒に現れることがよくあります。前者がデータセットに現れる場合、人間は文や段落内の要素の順序を頻繁に変更するため、後者が現れる可能性が高くなります。したがって、優れたメタ学習者は、「 は 」にトレーニングされると、「

は」インスタンスの確率を高めます。この意味で、自己回帰 LLM は優れたメタ学習者ではありません。

呪いを逆転させることは、多くの人工知能研究者の注目を集めています。人工知能が人類を滅ぼすというのは単なる幻想のようだと言う人もいます 有名な科学者アンドレイ・カルパシー氏は、LLM によって学習された知識は私たちが想像しているよりも細分化されているようだと述べました。これに関しては私には良い直感がありません。彼らは、私たちが他の方向から尋ねたときに一般化できない可能性のある特定のコンテキストウィンドウ内で物事を学びます。これは奇妙な部分的な一般化であり、「呪いを逆転させる」というのは特殊なケースだと思います 物議を醸している研究は、ニューヨークのヴァンダービルト大学からのものです大学、オックスフォード大学およびその他の機関。論文「逆転の呪い: 「A は B」で訓練された LLM は「B は A」を学習できない 》: これ記事が通過しました 合成データに対する一連の微調整実験により、LLM が逆転の呪いに悩まされていることを実証しました。図 2 に示すように、研究者はまず文パターン は 実際には、図 4 (実験部分) に示すように、モデルは正しい名前を与えるとともに、ランダムに名前を付けます。同じ。さらに、テスト順序が が 呪いを逆転させないようにする方法として、研究者は次の方法を試しました。 一連の実験の後、彼らは、呪いを逆転させると最先端のモデルにおける汎化能力に影響を与えるという予備的な証拠を提供しました (図 1 およびパート B)。彼らは、「トム・クルーズの母親は誰ですか?」「メアリー・リー・ファイファーの息子は誰ですか?」などの1,000の質問を使ってGPT-4でテストした。ほとんどの場合、モデルは最初の質問 (親は誰ですか) には正しく答えましたが、2 番目の質問には正しく答えられなかったことがわかります。この記事では、これは、トレーニング前のデータに、有名人よりも上位にランクされている親の例が少ないためであると仮説を立てています (たとえば、メアリー・リー・ファイファーの息子はトム・クルーズです)。 テストの目的は、「A は B である」を学習した自己回帰言語モデル (LLM) が正しいかどうかを検証することです。トレーニング中、反対の形式「B は A」に一般化できますか。 最初の実験では、この記事は は (または反対) 名前と説明が架空のデータセットで構成されています。さらに、この研究では GPT-4 を使用して名前と説明のペアを生成しました。これらのデータ ペアは、 NameToDescription 、 descriptionToName 、およびその両方の 3 つのサブセットにランダムに割り当てられます。最初の 2 つのサブセットを図 3 に示します。 #####################結果。完全一致評価では、テスト質問の順序がトレーニング データと一致する場合、GPT-3-175B はより優れた完全一致精度を達成し、その結果を表 1 に示します。 具体的には、DescriptionToName (例: Abyssal Melodies の作曲者は Uriah Hawthorne) について、説明 (例: Abyssal Melodies の作曲者は誰である) を含むヒントが与えられたとき、モデルの取得精度はどれくらいですか?その割合は96.7%に達します。 NameToDescription のファクトの場合、精度は 50.0% と低くなります。対照的に、順序がトレーニング データと一致しない場合、モデルはまったく一般化できず、精度は 0% に近づきます。 この記事では、GPT-3-350M (付録 A.2 を参照) や Llama-7B (付録を参照) を含む複数の実験も実施されました。 A.4)、実験結果は、これらのモデルが逆転の呪いの影響を受けていることを示しています 尤度増加評価において正しい名前とランダムな名前に割り当てられた対数確率 検出可能な差はありませんそれらの間の。 GPT-3 モデルの平均対数確率を図 4 に示します。 t 検定とコルモゴロフ・スミルノフ検定はいずれも、統計的に有意な差を検出できませんでした。 図 4: 実験 1、順序が逆の場合、モデルは正しい名前の確率を高めることができません。このグラフは、モデルが関連する説明でクエリされた場合に、(ランダムな名前と比較して) 正しい名前が得られる平均ログ確率を示しています。 次に、研究では 2 番目の実験が行われました。 この実験では、「A の親は B」および「B の子供は A」という形式で、実際の有名人とその親に関する事実に基づいてモデルをテストします。この研究では、IMDB (2023) から最も人気のある有名人トップ 1000 のリストを収集し、GPT-4 (OpenAI API) を使用して有名人の両親を名前で検索しました。 GPT-4 は 79% の確率で有名人の両親を特定することができました。 その後、子と親のペアごとに、研究は親ごとに子にクエリを実行します。ここで、GPT-4 の成功率はわずか 33% です。図 1 はこの現象を示しています。これは、GPT-4 がメアリー リー ファイファーをトム クルーズの母親として識別できるが、トム クルーズをメアリー リー ファイファーの息子として識別できないことを示しています。 さらに、この研究ではまだ微調整されていない Llama-1 シリーズ モデルも評価されました。すべてのモデルは、子よりも親の識別にはるかに優れていることがわかりました (図 5 を参照)。 # 図 5: 実験 2 における親質問と子質問の順序逆転効果。青いバー (左) は、有名人の子供に質問したときにモデルが正しい親を返す確率を示し、赤いバー (右) は、代わりに親の子供に質問したときにモデルが正しい親を返す確率を示します。 Llama-1 モデルの精度は、モデルが正しく完成する可能性を表します。 GPT-3.5-turbo の精度は、温度 = 1 でサンプリングされた、子と親のペアごとに 10 個のサンプルの平均です。注: GPT-4 は、子-親ペアのリストを生成するために使用され、その構造上、「親」ペアの精度が 100% であるため、図から省略されています。 GPT-4 のスコアは「サブ」で 28% です。 LLM における逆の呪いをどう説明するか?これについては、将来のさらなる研究を待つ必要があるかもしれません。今のところ、研究者は説明の簡単なスケッチしか提供できません。モデルが「A は B である」に基づいて更新されるとき、この勾配更新により、B に関する情報が含まれるように A の表現がわずかに変更されることがあります (たとえば、中間 MLP 層で)。この勾配更新の場合、B の表現を変更して A に関する情報を含めることも合理的です。ただし、勾配の更新は近視眼的であり、必ずしも B に基づいて将来の A を予測するのではなく、A が与えられた場合の B の対数に依存します。 「呪いの逆転」の後、研究者らは、大規模モデルが論理的意味、空間的関係、n 場所の関係など、他のタイプの関係を逆転できるかどうかを調査する予定です。

名前と説明を逆にすると、大きなモデルは混乱します

実験と結果

今後の展望

以上が大規模モデルの致命的な欠陥: 正答率はほぼゼロ、GPT も Llama も影響を受けませんの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM1 前言在发布DALL·E的15个月后,OpenAI在今年春天带了续作DALL·E 2,以其更加惊艳的效果和丰富的可玩性迅速占领了各大AI社区的头条。近年来,随着生成对抗网络(GAN)、变分自编码器(VAE)、扩散模型(Diffusion models)的出现,深度学习已向世人展现其强大的图像生成能力;加上GPT-3、BERT等NLP模型的成功,人类正逐步打破文本和图像的信息界限。在DALL·E 2中,只需输入简单的文本(prompt),它就可以生成多张1024*1024的高清图像。这些图像甚至

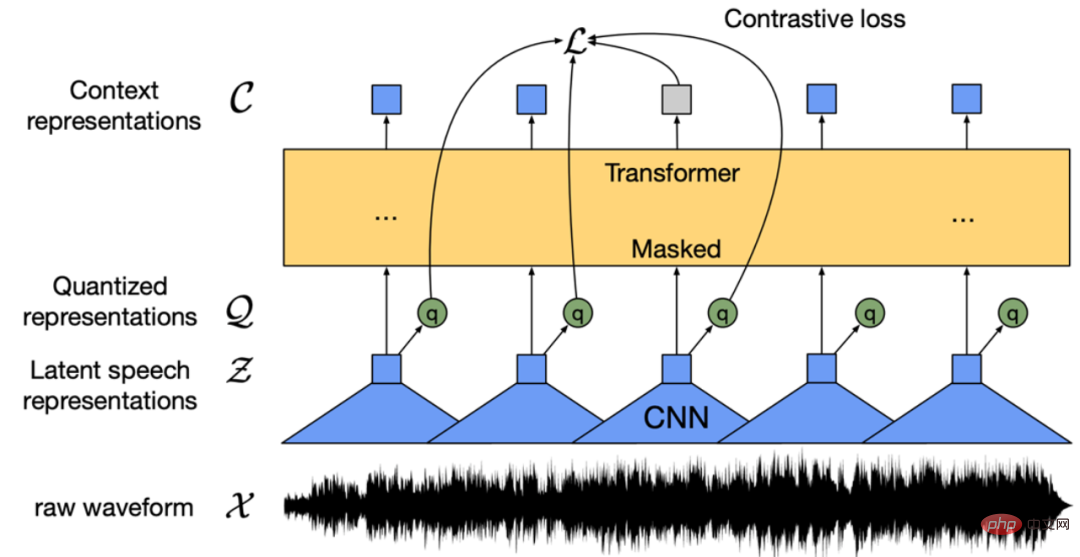

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PM

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PMWav2vec 2.0 [1],HuBERT [2] 和 WavLM [3] 等语音预训练模型,通过在多达上万小时的无标注语音数据(如 Libri-light )上的自监督学习,显著提升了自动语音识别(Automatic Speech Recognition, ASR),语音合成(Text-to-speech, TTS)和语音转换(Voice Conversation,VC)等语音下游任务的性能。然而这些模型都没有公开的中文版本,不便于应用在中文语音研究场景。 WenetSpeech [4] 是

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM“Making large models smaller”这是很多语言模型研究人员的学术追求,针对大模型昂贵的环境和训练成本,陈丹琦在智源大会青源学术年会上做了题为“Making large models smaller”的特邀报告。报告中重点提及了基于记忆增强的TRIME算法和基于粗细粒度联合剪枝和逐层蒸馏的CofiPruning算法。前者能够在不改变模型结构的基础上兼顾语言模型困惑度和检索速度方面的优势;而后者可以在保证下游任务准确度的同时实现更快的处理速度,具有更小的模型结构。陈丹琦 普

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM由于复杂的注意力机制和模型设计,大多数现有的视觉 Transformer(ViT)在现实的工业部署场景中不能像卷积神经网络(CNN)那样高效地执行。这就带来了一个问题:视觉神经网络能否像 CNN 一样快速推断并像 ViT 一样强大?近期一些工作试图设计 CNN-Transformer 混合架构来解决这个问题,但这些工作的整体性能远不能令人满意。基于此,来自字节跳动的研究者提出了一种能在现实工业场景中有效部署的下一代视觉 Transformer——Next-ViT。从延迟 / 准确性权衡的角度看,

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM3月27号,Stability AI的创始人兼首席执行官Emad Mostaque在一条推文中宣布,Stable Diffusion XL 现已可用于公开测试。以下是一些事项:“XL”不是这个新的AI模型的官方名称。一旦发布稳定性AI公司的官方公告,名称将会更改。与先前版本相比,图像质量有所提高与先前版本相比,图像生成速度大大加快。示例图像让我们看看新旧AI模型在结果上的差异。Prompt: Luxury sports car with aerodynamic curves, shot in a

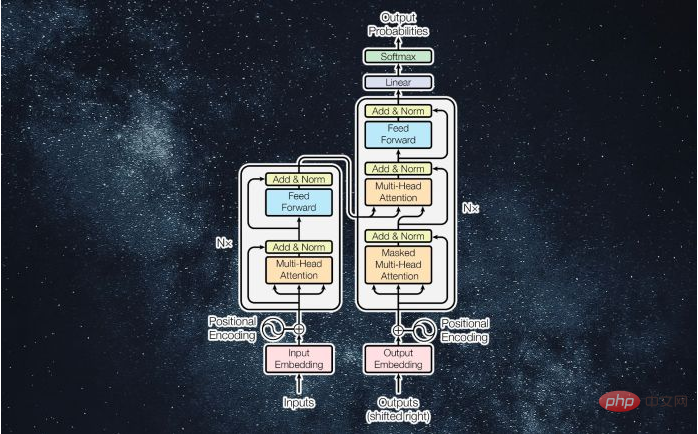

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM译者 | 李睿审校 | 孙淑娟近年来, Transformer 机器学习模型已经成为深度学习和深度神经网络技术进步的主要亮点之一。它主要用于自然语言处理中的高级应用。谷歌正在使用它来增强其搜索引擎结果。OpenAI 使用 Transformer 创建了著名的 GPT-2和 GPT-3模型。自从2017年首次亮相以来,Transformer 架构不断发展并扩展到多种不同的变体,从语言任务扩展到其他领域。它们已被用于时间序列预测。它们是 DeepMind 的蛋白质结构预测模型 AlphaFold

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM人工智能就是一个「拼财力」的行业,如果没有高性能计算设备,别说开发基础模型,就连微调模型都做不到。但如果只靠拼硬件,单靠当前计算性能的发展速度,迟早有一天无法满足日益膨胀的需求,所以还需要配套的软件来协调统筹计算能力,这时候就需要用到「智能计算」技术。最近,来自之江实验室、中国工程院、国防科技大学、浙江大学等多达十二个国内外研究机构共同发表了一篇论文,首次对智能计算领域进行了全面的调研,涵盖了理论基础、智能与计算的技术融合、重要应用、挑战和未来前景。论文链接:https://spj.scien

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM说起2010年南非世界杯的最大网红,一定非「章鱼保罗」莫属!这只位于德国海洋生物中心的神奇章鱼,不仅成功预测了德国队全部七场比赛的结果,还顺利地选出了最终的总冠军西班牙队。不幸的是,保罗已经永远地离开了我们,但它的「遗产」却在人们预测足球比赛结果的尝试中持续存在。在艾伦图灵研究所(The Alan Turing Institute),随着2022年卡塔尔世界杯的持续进行,三位研究员Nick Barlow、Jack Roberts和Ryan Chan决定用一种AI算法预测今年的冠军归属。预测模型图

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

ホットトピック

7449

7449 15

15 1374

1374 52

52