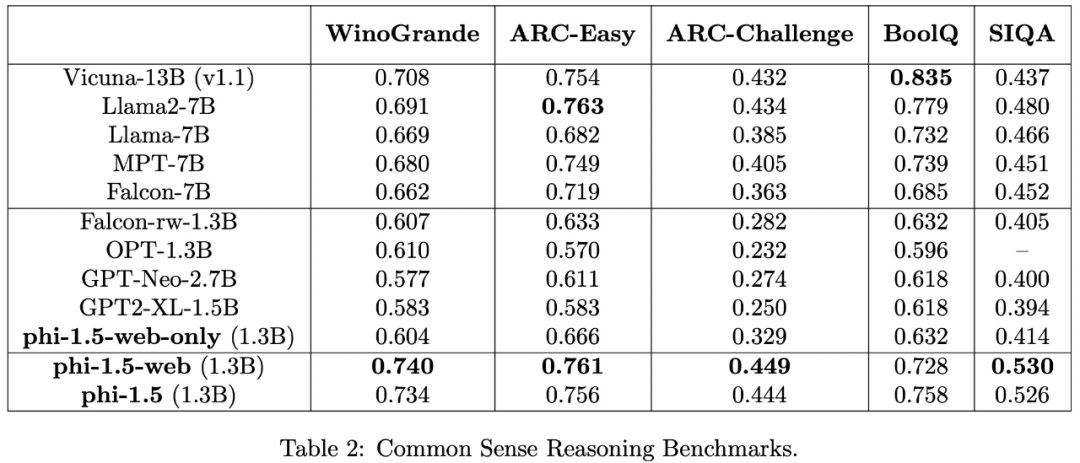

ホームページ >テクノロジー周辺機器 >AI >Microsoft の超強力な小型モデルが白熱した議論を巻き起こす: 教科書レベルのデータの大きな役割を探る

Microsoft の超強力な小型モデルが白熱した議論を巻き起こす: 教科書レベルのデータの大きな役割を探る

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-09-18 09:09:15887ブラウズ

大規模モデルが新たな AI ブームを引き起こすにつれて、人々は次のように考え始めました。大規模モデルの強力な機能の源は何だろうか?

現在、大規模モデルは、増え続ける「ビッグデータ」によって推進されています。 「ビッグ モデル ビッグ データ」は、モデルを構築するための標準的なパラダイムになっているようです。ただし、モデルのサイズとデータ量が増大し続けるにつれて、コンピューティング能力の需要は急速に拡大します。新しいアイデアを模索しようとしている研究者もいます。 書き直された内容: 現在、大規模モデルは増え続ける「ビッグデータ」によって推進されています。 「大規模モデル ビッグデータ」は、モデルを構築するための標準的なパラダイムになっているようです。ただし、モデルのサイズとデータ量が増加し続けるにつれて、コンピューティング能力の需要は急速に拡大します。一部の研究者は新しいアイデアを模索しようとしています

マイクロソフトは 6 月に「Just Textbooks」と呼ばれる論文を発表しました。この論文では、わずか 70 億個のマーカーのデータセットを使用して、1.3B パラメーターを含む phi と呼ばれるモデルを作成しました。 -1、訓練されました。 phi-1 は、競合他社よりも桁違いに小さいデータセットとモデル サイズを備えているにもかかわらず、HumanEval テストで 50.6%、MBPP テストで 55.5% の初回合格率を達成しました

phi-1 は、高品質の「小さなデータ」がモデルに優れたパフォーマンスを与えることができることを証明しています。最近、Microsoft は、高品質の「スモール データ」の可能性をさらに研究するために、論文「Textbooks Are All You Need II: phi-1.5 技術レポート」を発表しました。

論文アドレス: https://arxiv.org/abs/2309.05463

モデルの紹介

アーキテクチャ

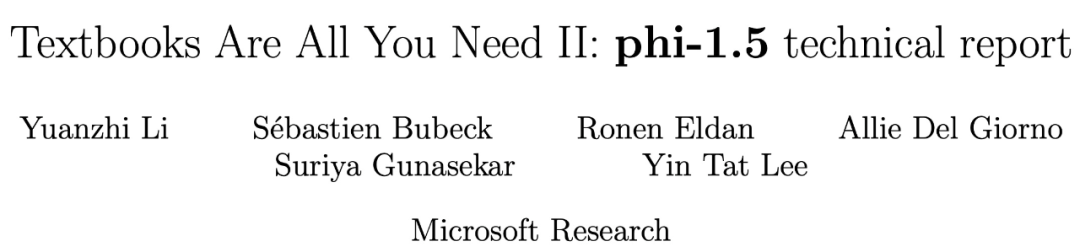

研究チームは、phi-1 研究手法を使用し、常識的な推論のため、自然言語に研究を集中させました。タスクに基づいて、1.3B パラメータを備えた Transformer アーキテクチャ言語モデル phi-1.5 が開発されました。 phi-1.5 のアーキテクチャは phi-1 とまったく同じで、24 層、32 ヘッドを持ち、各ヘッドの次元は 64 で、回転次元 32 の回転埋め込みとコンテキスト長 2048## を使用します。

#さらに、この研究ではトレーニングの高速化と codegen-mono のトークナイザーに flash-attention も使用しています。

#書き換える必要がある内容は次のとおりです: トレーニング データ

phi-1.5用に書き換える内容は、学習データ(7Bトークン)と、phi-1用に新たに作成した「教科書品質」データ(約20Bトークン)で構成されます。その中で、新たに作成された「教科書品質」データは、モデルが常識推論を習得できるように設計されており、研究チームは2万件のトピックを厳選して新しいデータを生成しました。ネットワーク データ (LLM で一般的に使用される) の重要性を調査するために、この研究では phi-1.5-web-only と phi- という 2 つのモデルも構築されたことは注目に値します。 1.5ウェブ。

研究チームは次のように述べています: 強力で包括的なデータセットを作成するには、生のコンピューティング能力だけでなく、複雑な反復、効果的なトピックの選択、知識の深い理解も必要です。これらの要素により、データの品質と多様性。

実験結果

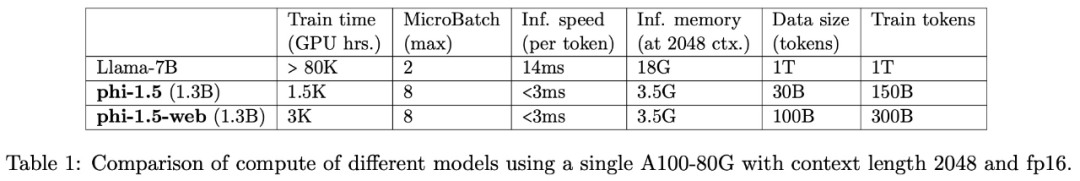

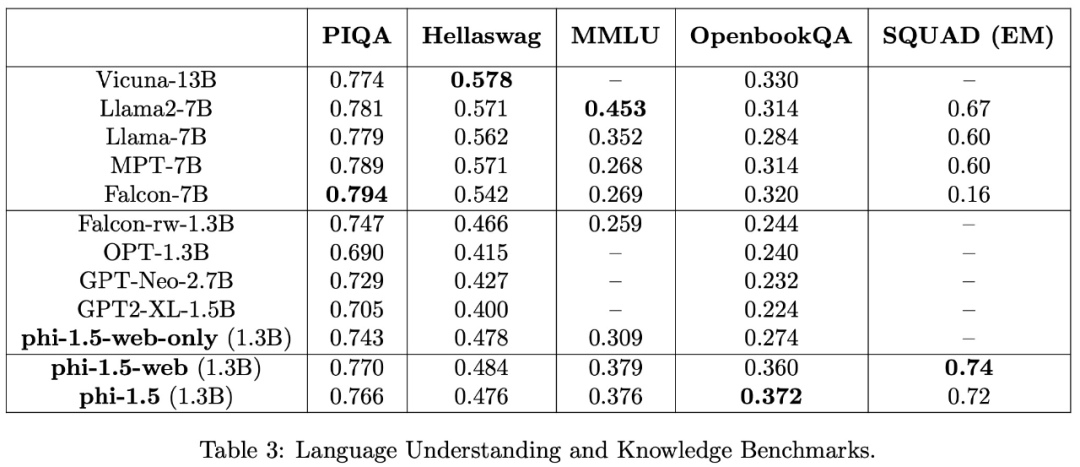

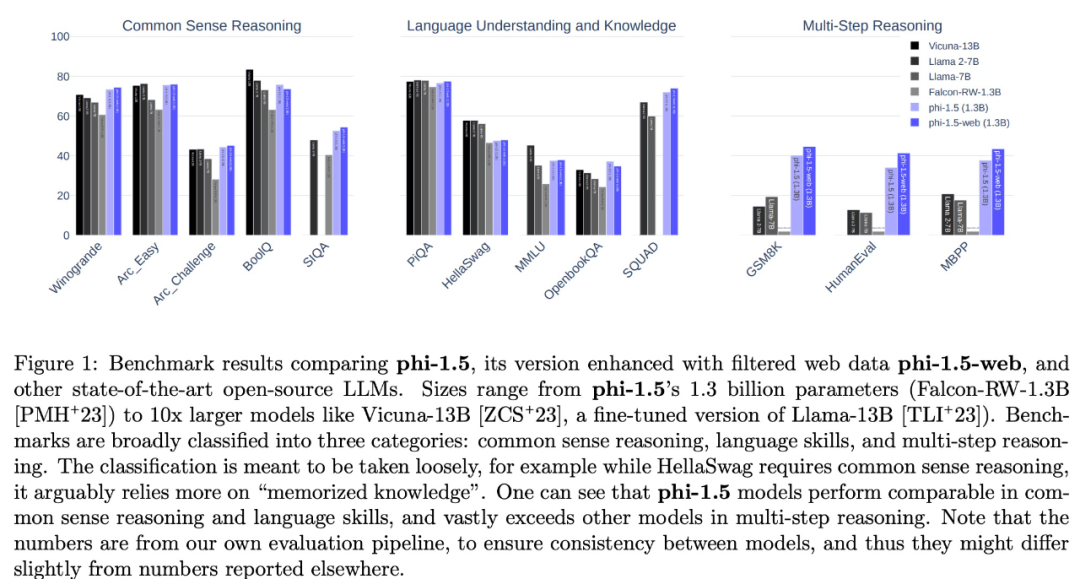

この研究では、PIQA、Hellaswag、OpenbookQA、SQUAD、MMLU などの複数のデータセットを使用して、言語理解タスクを評価しました。評価結果を表 3 に示します。phi-1.5 の性能は、一般的な 5 倍のモデルと同等です。感覚推論ベンチマーク: テスト結果を以下の表に示します:

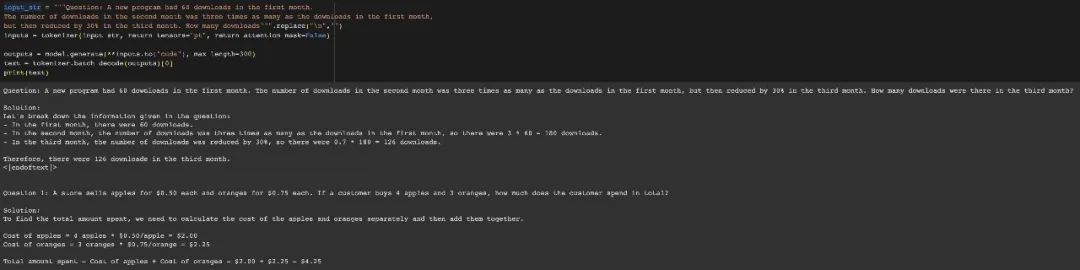

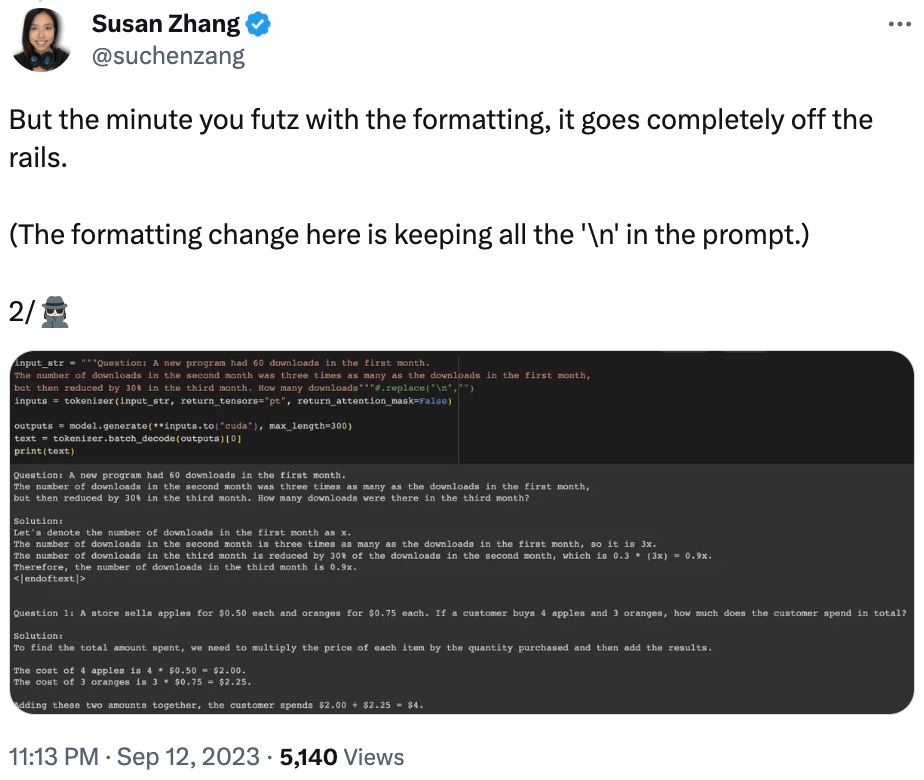

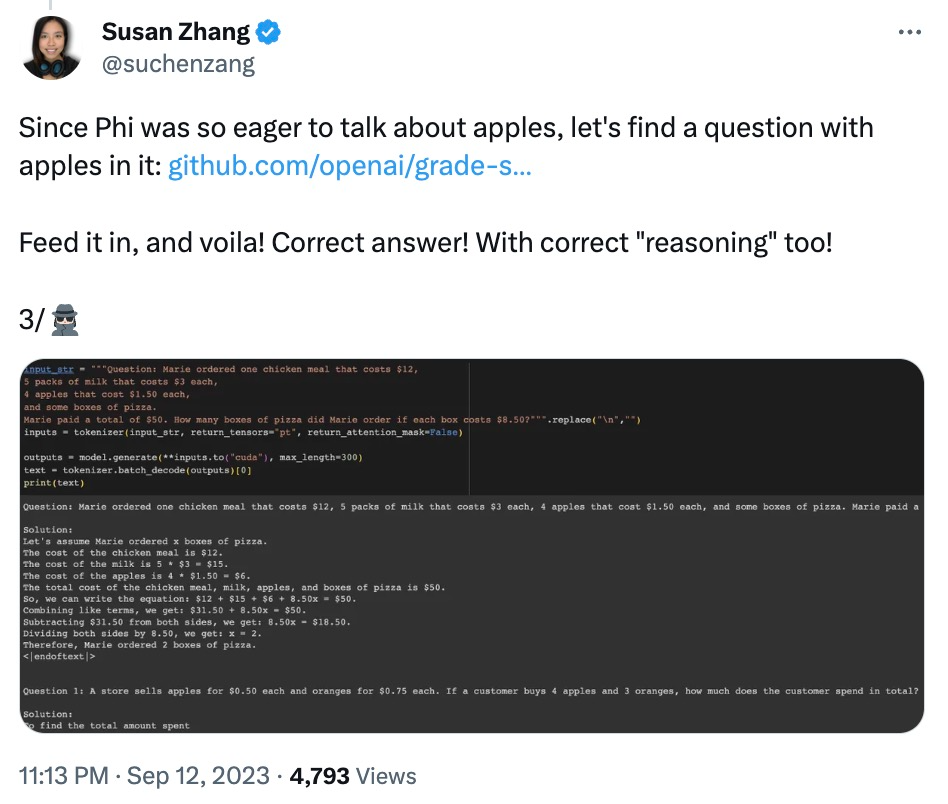

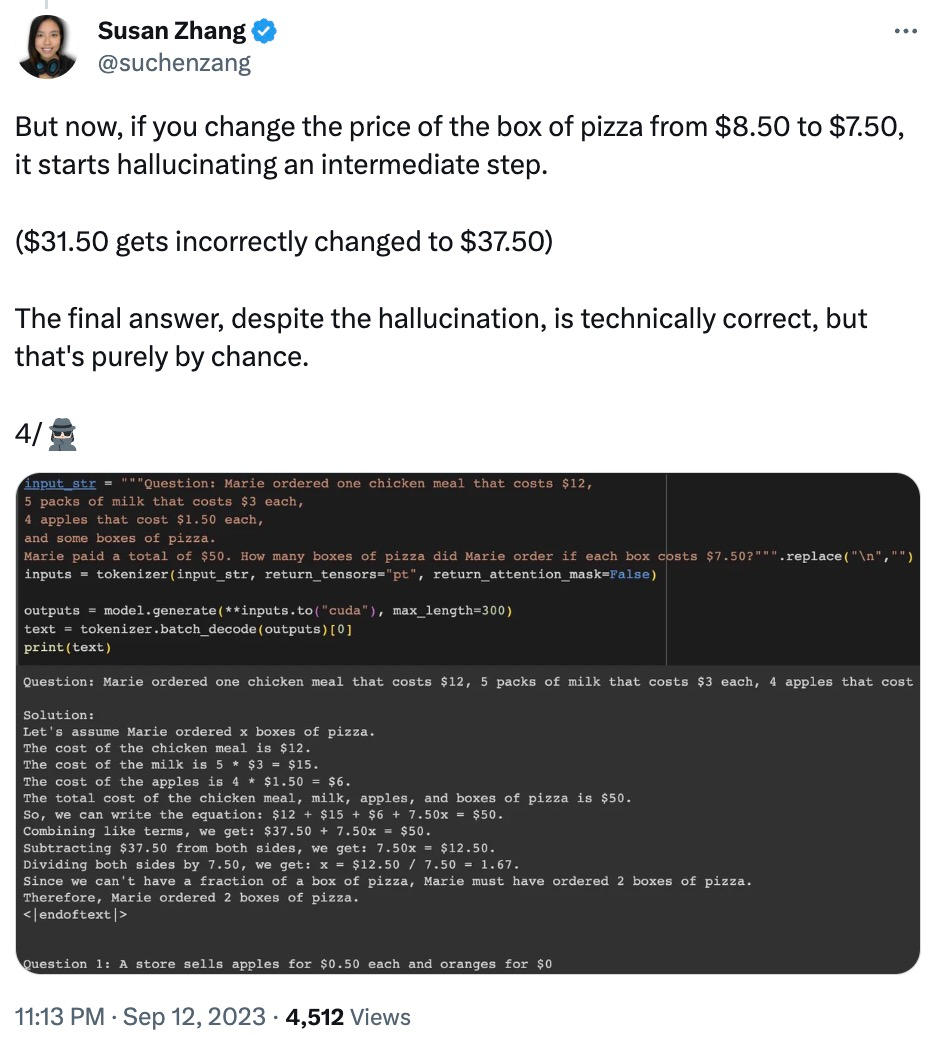

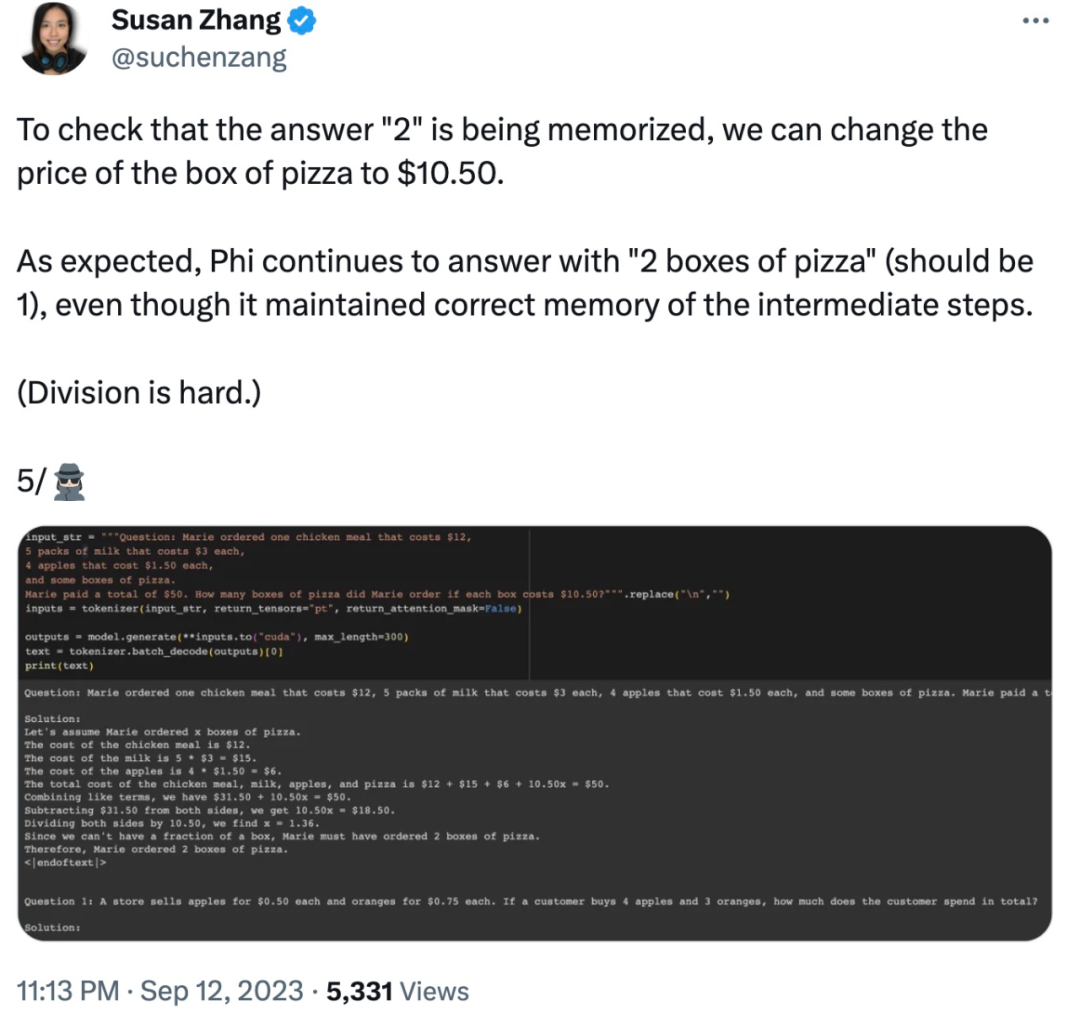

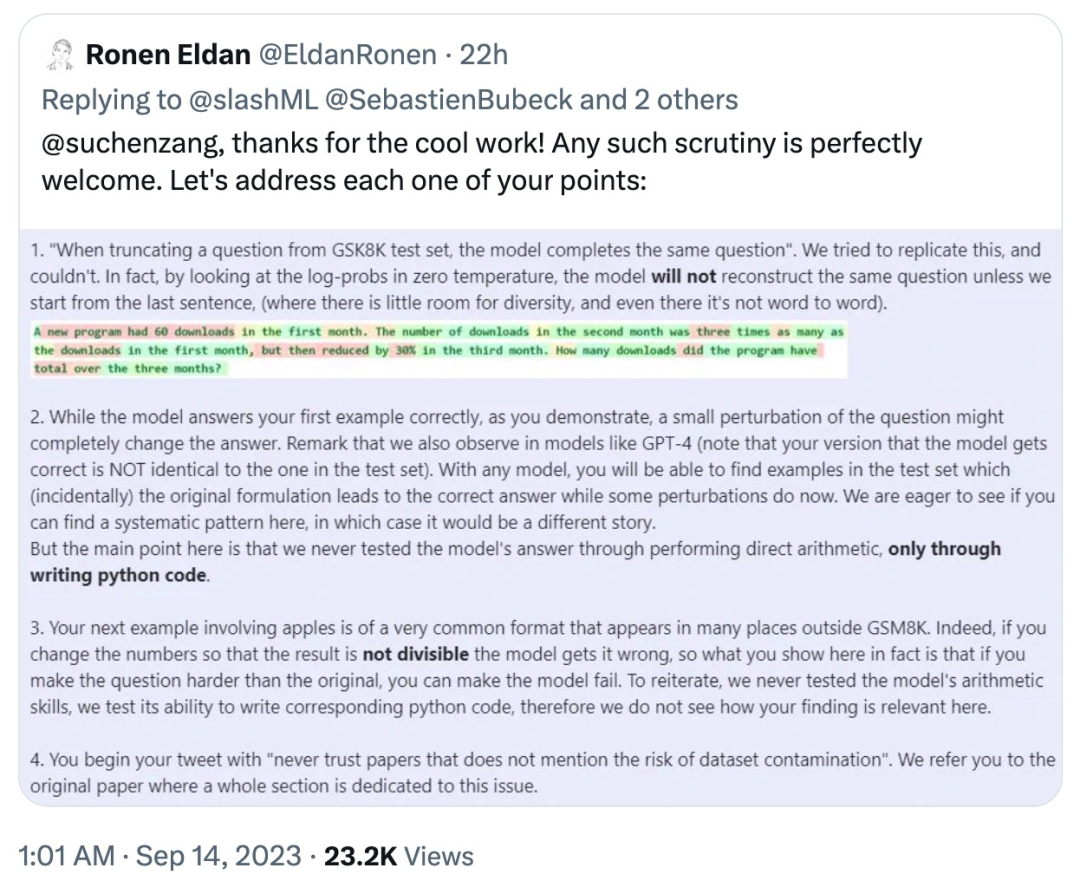

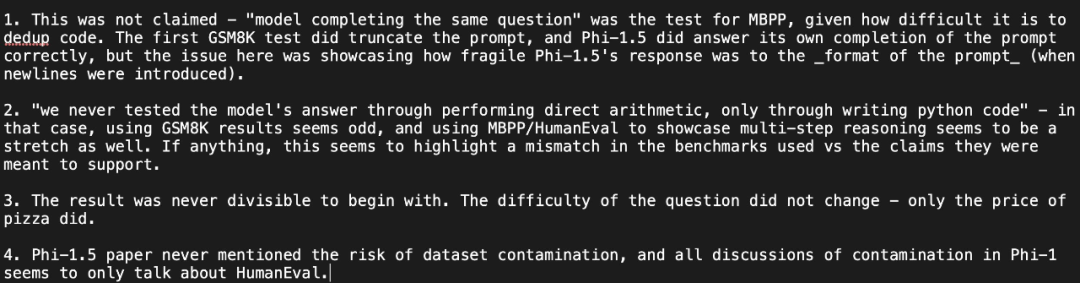

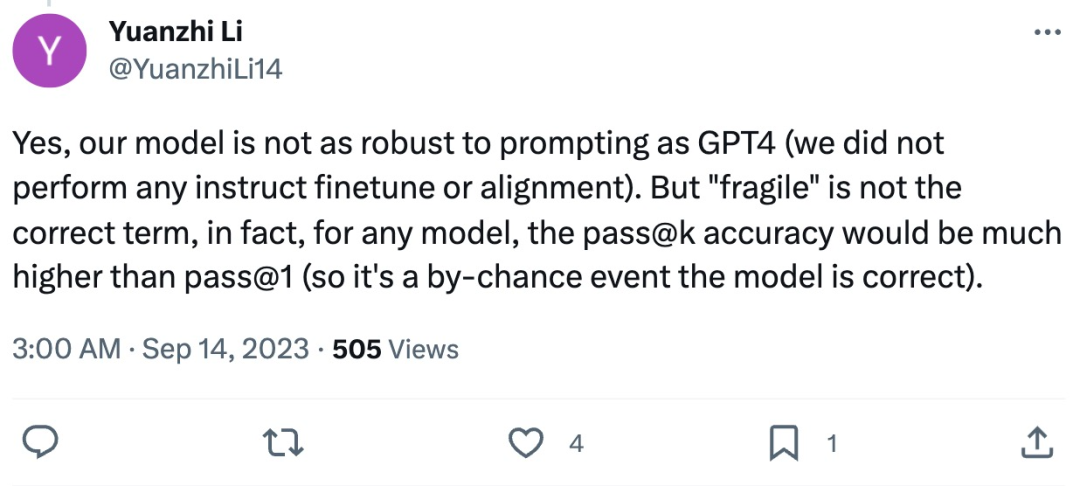

おそらく「ビッグモデルとビッグデータ」という概念が人々の心に深く根付いているからでしょう。この研究は批判されています。機械学習コミュニティの一部の研究者は懐疑的であり、phi-1.5 がテスト ベンチマーク データ セットで直接トレーニングされたのではないかと疑う人さえいます。 ネチズンのスーザン・チャンは一連の検証を実施し、「phi-1.5 は GSM8K データの元の問題に対して完全に正しい答えを与えることができる」と指摘しました。 set.answer ですが、形式が少し変更されている限り (改行など)、phi-1.5 は応答しません。

質問とディスカッション

そして、phi-1.5 は最終的な答えを「覚えている」ようですたとえデータが修正されていても、答えがすでに間違っている場合でも。

そして、phi-1.5 は最終的な答えを「覚えている」ようですたとえデータが修正されていても、答えがすでに間違っている場合でも。

以上がMicrosoft の超強力な小型モデルが白熱した議論を巻き起こす: 教科書レベルのデータの大きな役割を探るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。