ホームページ >テクノロジー周辺機器 >AI >ネット販売中!第1回Heart of Machine AI技術フォーラムは盛況のうちに終了し、これらの大型モデルの技術情報は何度も見る価値があります。

ネット販売中!第1回Heart of Machine AI技術フォーラムは盛況のうちに終了し、これらの大型モデルの技術情報は何度も見る価値があります。

- PHPz転載

- 2023-09-14 09:49:02686ブラウズ

人工知能は大規模モデルの時代に突入しており、さまざまな業界における AI の実装モデルが完全に変わり、さまざまな分野の研究開発および技術者に新たな AI スキル要件も提示されます。産業です。

大規模モデル技術のアップグレードを支援するために、「Llama 2 大規模モデルのアルゴリズムとアプリケーションの実践」というイベントを開催しました。この AI 技術フォーラムは無事終了しました。イベント当日、北京の望京浦項センターBタワー2階の多機能ホールは、全国10以上の都市からの200名の参加者で満員となった。 4 人の大型モデル技術専門家の指導の下、私たちは Llama 2 の基礎となる大型モデル技術を体系的に研究し、独自の専用大型モデルを個人的に構築し、協力して大型モデル技術のアップグレードを効率的に完了しました

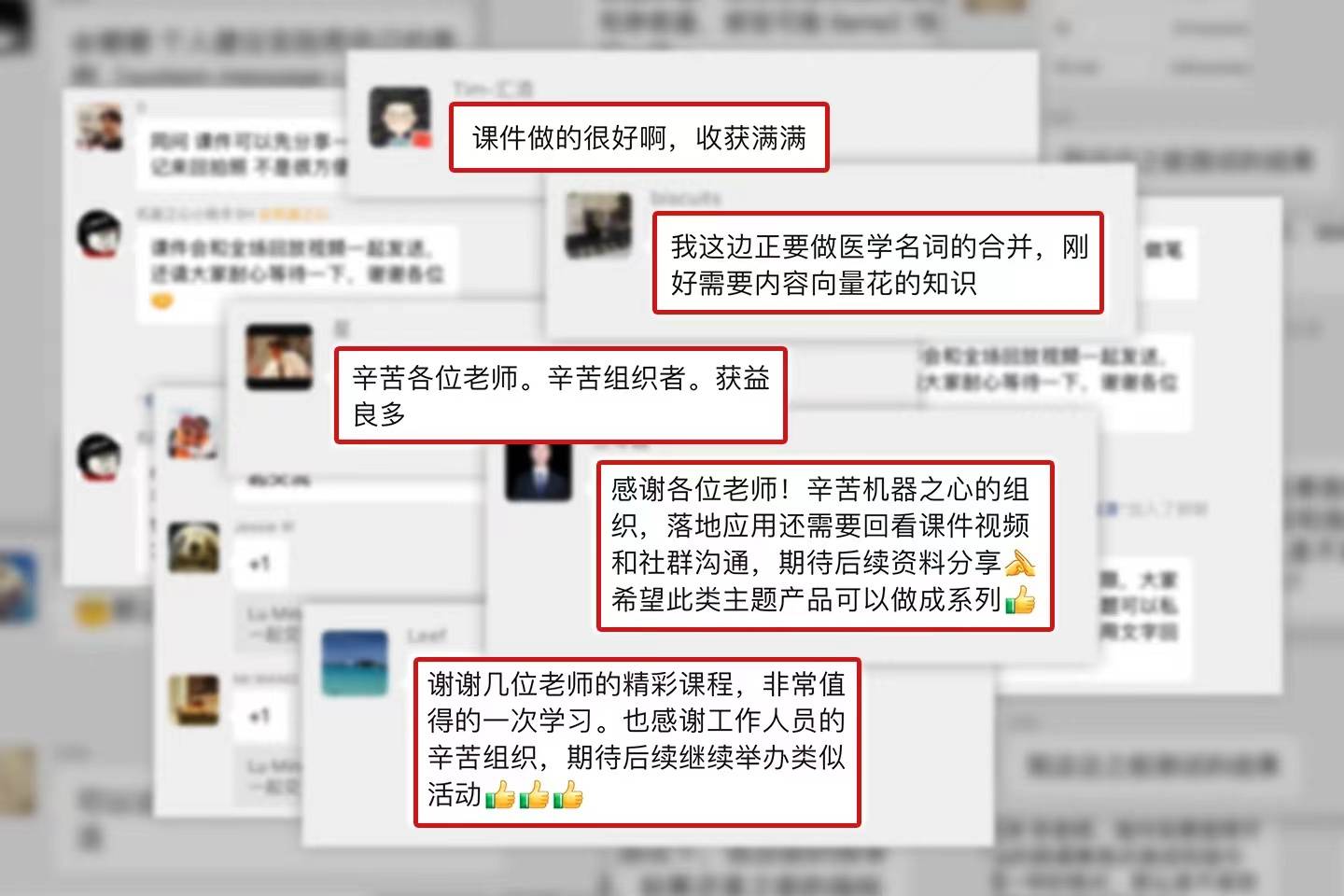

#イベントは参加者から広く好評を博しました

#イベントは参加者から広く好評を博しました

システム解説:最新の技術進歩と最先端の応用事例

Llama 2 は、最高の独創性、トレーニング技術の詳細が最も透明性が高く、市場で最高の評判を備えた事前トレーニング済み言語モデルであり、非常に高い研究価値があります。今回は、劉鵬飛氏が「ラマ2大型モデルの技術的解釈」をテーマに、LLaMA誕生の背景、重要なコンセプト、ラマ2のトレーニング技術、アライメント技術に至るまで、その技術スタックの詳細を深く解釈しました。彼は、Llama 2 とその Chat バージョンでの経験を共有し、データ ソースの重み付けやアップサンプリングなどの技術的な詳細を含む最適化の実際の経験を共有し、大規模なモデルの開発を突破する難しさについて議論しました。

##Lao Liu 氏は、NLP Technical パブリック アカウントの著者でありオープンソース愛好家でもある Liu Huanyong 氏が次のように書き直しました: 基本モデルには、コンピューティング能力とアルゴリズムに対する非常に高い要件があります。したがって、より多くの業界アプリケーションでは、基本モデルに基づいて大規模なインダストリ モデルを構築し、それをさらに改良するために選択されます。講演者の Liu Huanyong 氏は、「大規模な産業モデルに基づくと、基本モデルには垂直フィールド データが少なく、幻覚が起こりやすく、効果も満足のいくものではありません。」と述べました。初めてオープンソース化され、商用利用が可能となるため、業界での導入事例の豊富な蓄積は非常に貴重です

氏が次のように書き直しました: 基本モデルには、コンピューティング能力とアルゴリズムに対する非常に高い要件があります。したがって、より多くの業界アプリケーションでは、基本モデルに基づいて大規模なインダストリ モデルを構築し、それをさらに改良するために選択されます。講演者の Liu Huanyong 氏は、「大規模な産業モデルに基づくと、基本モデルには垂直フィールド データが少なく、幻覚が起こりやすく、効果も満足のいくものではありません。」と述べました。初めてオープンソース化され、商用利用が可能となるため、業界での導入事例の豊富な蓄積は非常に貴重です

彼は、「実用的な解釈の解釈」というタイトルで、Llama シリーズ モデルと他のオープンソース モデルの比較を共有しました。 「Llama シリーズ オープンソース モデルに基づく業界実装のパラダイムとケース」では、Llama シリーズ モデルに基づくドメイン微調整モデル ケースと「LLama シリーズ モデルに基づく知識ベース強化」の実装ケースを中国語のメカニズムで説明しています。これは、業界分野におけるモデルの微調整に必要なコンピューティング能力の条件、データ量と品質の要件、ROI とシナリオ、その他の必要条件をまとめており、業界における大規模モデルの実装形態がマルチソースの異種混合である可能性があることを強調しています。データ、ドキュメントのインテリジェントな分析、ナレッジベースの仕様。

LinkSoul.AI CEO、中国版 Llama 2 7B プロジェクトのイニシエーター Shi Yemin 大型モデル技術の発展に伴い、マルチモーダル大型モデルはますます身体化されたインテリジェンスとその原動力となっています。より良いユーザーエクスペリエンスへの鍵は、間違いなく次世代の人工知能テクノロジーの重要なコンポーネントとなるでしょう。 LLM ベースの変換は現在、最高のマルチモーダル モデル ソリューションの 1 つであり、大きな研究価値と実用的価値があります。 Shi Yemin氏は「Llama 2に基づくマルチモーダル大規模モデルの技術と実践」をテーマに講演し、マルチモーダルモデルのモードと原理を共有し、視覚マルチモーダル大規模モデルと音声マルチの改善実践について深く議論しました。 -モーダル大型モデル。彼は、古いモデルが新しいモダリティをどのようにサポートできるか、また新しい機能を検討する際に注意すべき重要な点について述べました。さらに、マルチモーダルな改善のためのいくつかのソリューションも紹介し、トレーニングの詳細で注意する必要がある事項についても強調しました。 Shi Yemin 氏は、マルチモーダル モデルの最大の課題はデータにあると考えており、モデルに基づいて写真やグラフィック データを生成するためのいくつかの方法とパスを共有しました

Shi Yemin氏は「Llama 2に基づくマルチモーダル大規模モデルの技術と実践」をテーマに講演し、マルチモーダルモデルのモードと原理を共有し、視覚マルチモーダル大規模モデルと音声マルチの改善実践について深く議論しました。 -モーダル大型モデル。彼は、古いモデルが新しいモダリティをどのようにサポートできるか、また新しい機能を検討する際に注意すべき重要な点について述べました。さらに、マルチモーダルな改善のためのいくつかのソリューションも紹介し、トレーニングの詳細で注意する必要がある事項についても強調しました。 Shi Yemin 氏は、マルチモーダル モデルの最大の課題はデータにあると考えており、モデルに基づいて写真やグラフィック データを生成するためのいくつかの方法とパスを共有しました

の寄稿者です。

今回のイベントのアンケートで、参加者が最も注目した業界アプリケーションの内容は「定量化と微調整」でした。 Su Yang 氏は共有の中で、オープンソース モデル エコロジーと Llama エコロジーの現状、主流の定量化と微調整ソリューションを含む「Llama 2 オープンソース モデルの定量化と低コスト微調整の実践」の特別コンテンツを紹介しました。そしてこれら 2 つの容易さ

「微調整には、やみくもに独自性を追求するのではなく、オープンソース業界で共有されている Sota ソリューションを使用することをお勧めします。」 同氏は、定量化と微調整が重要であることを強調しました。以下のさまざまな原則に基づいて比較的実用的です。実際のモデルの定量化プロセスは、単純な画一的なプロセスではありません。多くの次元とパラメータがあります。最も合理的な定量化または変換は、各層および列で実行する必要があります。微調整には、特定の要素も考慮する必要があります。トレーニング環境、ハードウェア環境、基本システム環境、Su Yang がこれについて詳しく説明しました。

詳細な技術解釈とケース分析の後、Shi Yeminhe Su Yangオンサイトの参加者が大規模モデルのトレーニング、定量化、微調整の実践を開始できるように導きました。

Shi Yemin は、基本的なモデルの選択、トレーニング手法、経験の説明に重点を置きました。これには、基本モデルに基づくゼロからのトレーニングとオープンソース モデルに基づく語彙拡張トレーニングの 2 つのパス、および対応するアーキテクチャ、モデルが含まれます。サイズや商用利用可能かどうか、単語リストなどの絞り込み条件を拡張するかどうか、SFTデータセットなどの疑問にお答えします。

Su Yang は、イメージのデプロイ、モデルの読み込み、データセットの読み込み、QLoRA パラメーターの設定、SFT パラメーターの構成、トランスフォーマー パラメーター パッケージの使用などを含む一連の操作を完了するようにオンサイトの参加者を導きました。微調整を通じて、参加者がこのイベントの内容をよりよく理解できるように、大規模なプライベート モデルの実行に成功しました。

今後も、業界の最新の開発とニーズに引き続き注意を払い、追跡していきます。開発者がエンジニアリングの実践と革新的なアプリケーション能力を迅速に向上させ、大規模モデルの時代に備えることができるよう、高品質の大規模な技術活動を継続して開催します。皆様、引き続き AI テクノロジー フォーラムの活動にご注目ください。

以上がネット販売中!第1回Heart of Machine AI技術フォーラムは盛況のうちに終了し、これらの大型モデルの技術情報は何度も見る価値があります。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。