ホームページ >テクノロジー周辺機器 >AI >AI モデルにおける人種および性別の偏見を評価するためのメタ オープンソース FACET ツール

AI モデルにおける人種および性別の偏見を評価するためのメタ オープンソース FACET ツール

- 王林転載

- 2023-09-13 19:53:071340ブラウズ

9 月 2 日のニュース、Meta Company は最近、現在の多くのコンピューター ビジョン モデルにおける女性および有色人種に対する体系的な偏見とジェンダー バイアスの問題を軽減するために、コンピューター ビジョン システムで人種を識別する FACET と呼ばれる新しい AI ツールを発表しました。 。

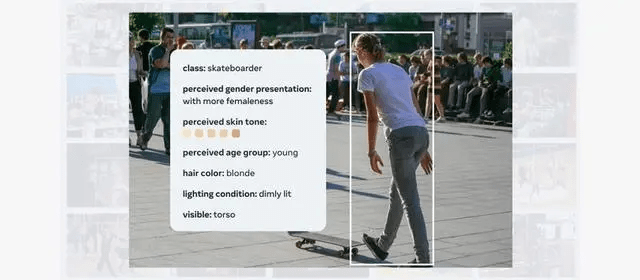

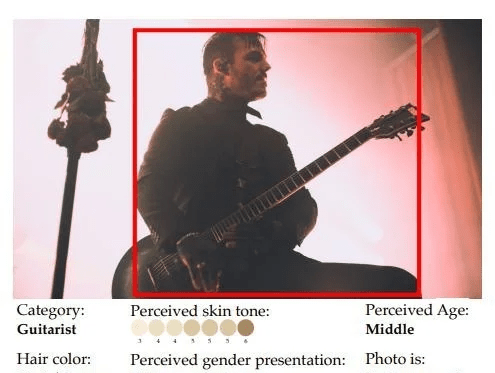

FACET ツールは現在、50,000 人の画像を含む 30,000 枚の画像でトレーニングされています。特に性別と肌の色の認識が強化されており、さまざまな特徴に関するコンピューター ビジョン モデルを評価するために使用できます。

FACET ツールは、男性をスケートボーダーとして識別することや、肌の色が明るいか暗いかなど、複雑な質問に答えるようにトレーニングできます。

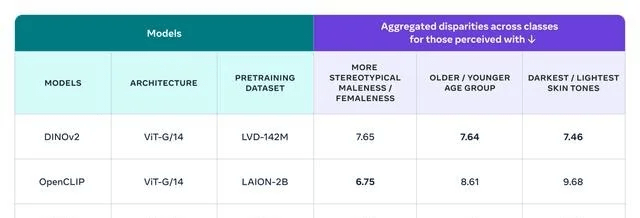

Meta は、FACET を使用して、同社が開発した DINOv2 モデルと SEERv2 モデル、および OpenAI の OpenCLIP モデルを評価しました。全体的に、OpenCLIP は性別の点で他のモデルよりも優れたパフォーマンスを示しましたが、DINOv は年齢と肌の色で優れたパフォーマンスを示しました。判定。

FACET は、研究者が同様のベンチマークを実行して独自のモデルのバイアスを理解し、公平性の問題に対処するために講じられた緩和策の影響を監視するのに役立ちます。 IT House はここに Meta のプレス リリース アドレスを添付しており、興味のあるユーザーはそれを詳しく読むことができます。

[出典: IT ホーム]

以上がAI モデルにおける人種および性別の偏見を評価するためのメタ オープンソース FACET ツールの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。