ホームページ >テクノロジー周辺機器 >AI >H100推理が8倍に急上昇! NVIDIA が 10 以上のモデルをサポートするオープンソース TensorRT-LLM を正式発表

H100推理が8倍に急上昇! NVIDIA が 10 以上のモデルをサポートするオープンソース TensorRT-LLM を正式発表

- 王林転載

- 2023-09-10 16:41:011635ブラウズ

「GPU 貧乏人」は、その苦境に別れを告げようとしています。

たった今、NVIDIA は、H100

## で実行される大規模な言語モデルの推論プロセスを高速化できる TensorRT-LLM と呼ばれるオープン ソース ソフトウェアをリリースしました。

#それでは、何回改善できるでしょうか?

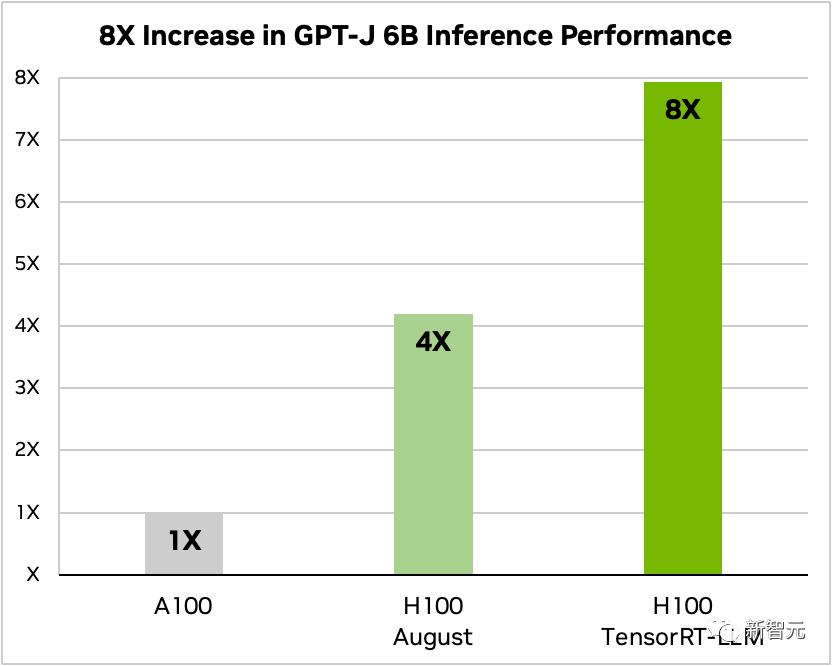

TensorRT-LLM とその一連の最適化機能 (In-Flight バッチ処理を含む) を追加した後、モデルの合計スループットは 8 倍に増加しました。

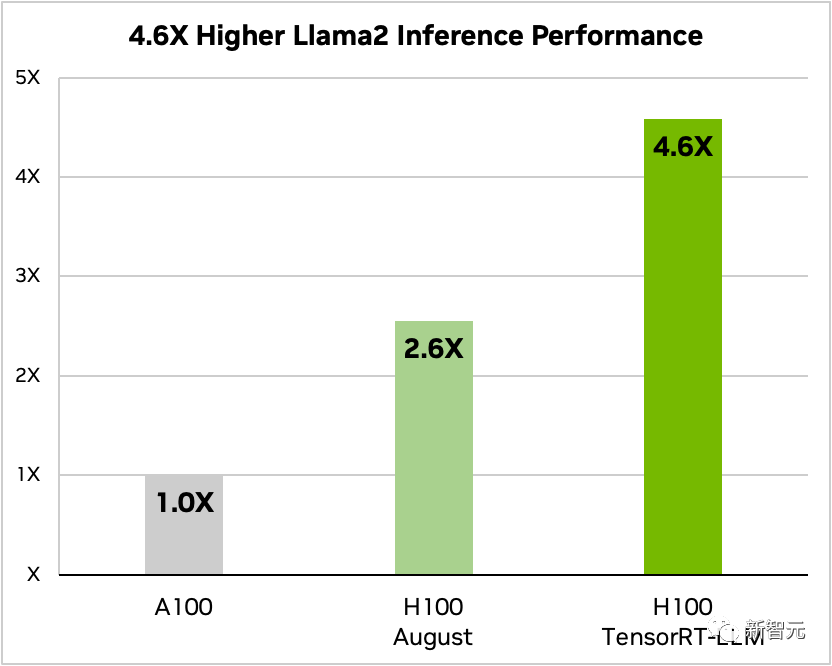

#Compare Llama 2 70B 、比較TensorRT-LLM を使用した場合と使用しない場合の A100 と H100 の比較

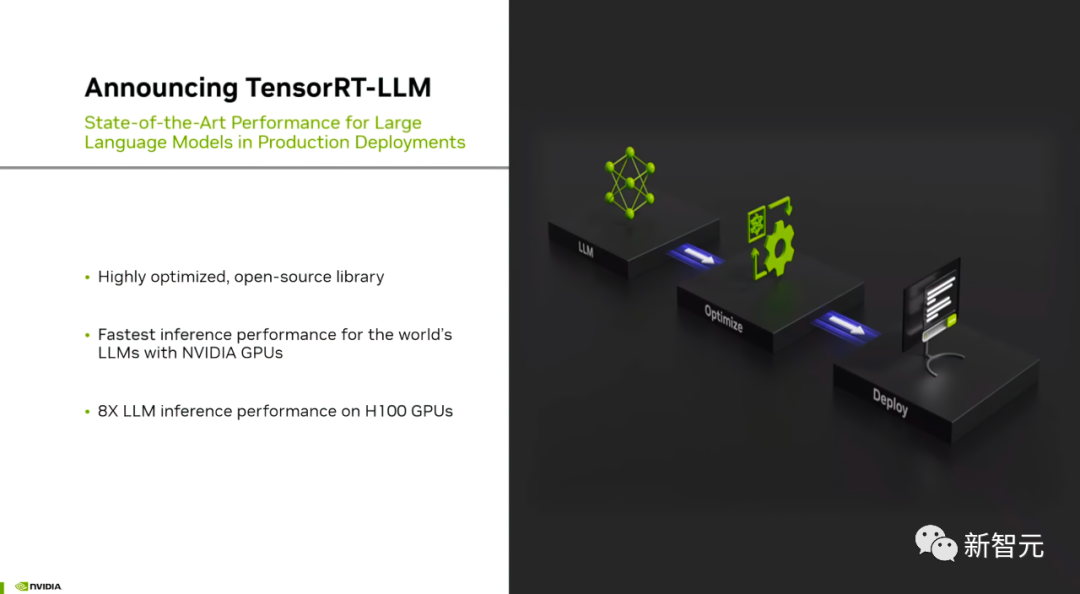

TensorRT-LLM: 大規模モデル推論高速化アーティファクト

現在、大規模モデルのパラメータ規模が膨大なため、「デプロイメント」が困難になっています。 「推理」の難易度とコストは依然として高い。

#NVIDIA が開発した TensorRT-LLM は、LLM のスループットを大幅に向上させ、GPU を通じてコストを削減することを目的としています。

## 具体的には、TensorRT-LLM は、TensorRT の深層学習コンパイラ、FasterTransformer の最適化されたカーネル、前処理および後処理、およびマルチ GPU/マルチノード通信をシンプルなオープンソース Python API ## にカプセル化します。 ##NVIDIA は、FasterTransformer をさらに強化して製品化したソリューションにしました。

C や CUDA の深い知識を必要としないプログラマーは、さまざまな大規模な言語モデルをデプロイ、実行、デバッグでき、優れたパフォーマンスと迅速なカスタマイズを実現できます。

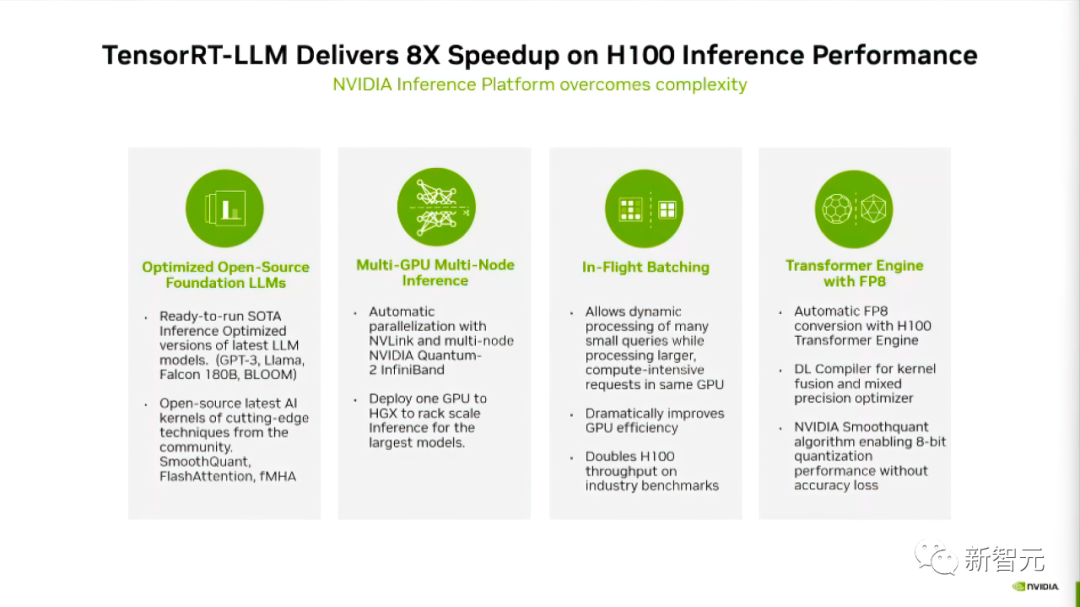

##NVIDIA の公式ブログによると、TensorRT-LLM は 4 つの方法を使用して Nvidia GPU での LLM 推論パフォーマンスを向上させます

まず、現在の上位 10 モデルには TensorRT-LLM が導入されており、開発者はすぐに実行できるようになります。

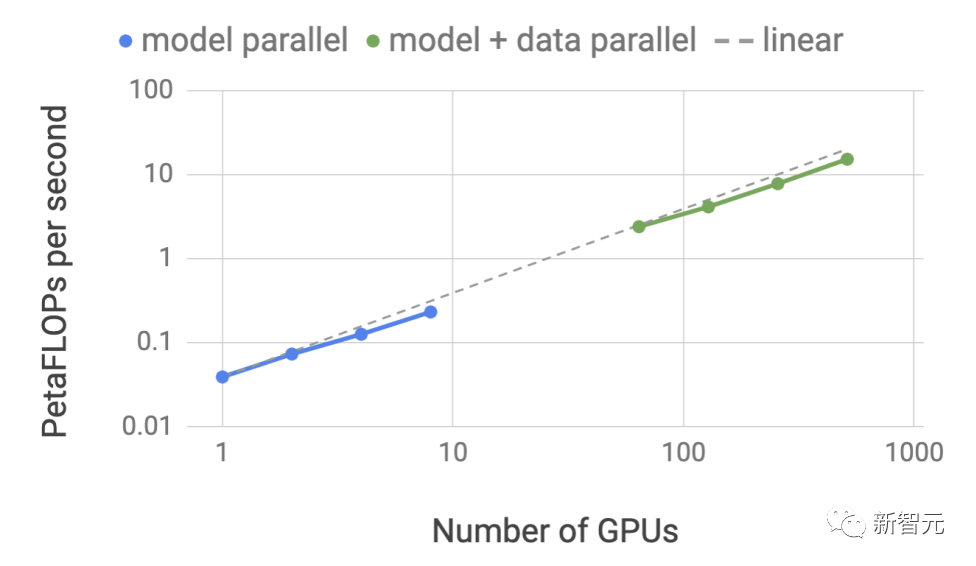

第 2 に、TensorRT-LLM は、オープン ソース ソフトウェア ライブラリとして、LLM が複数の GPU および複数の GPU サーバーで同時に推論を実行できるようにします。

これらのサーバーは、それぞれ NVIDIA の NVLink および InfiniBand 相互接続を介して接続されています。

3 番目のポイントは、「マシン内バッチ処理」についてです。これは、異なるモデルのタスクが他のタスクから独立して GPU に出入りできるようにする新しいスケジューリング技術です。

最後に、TensorRT-LLM は、H100 Transformer Engine を使用してモデル推論中のメモリ使用量とレイテンシを削減するように最適化されました。

TensorRT-LLM がモデルのパフォーマンスをどのように向上させるかを詳しく見てみましょう

豊富な LLM エコシステムをサポート

TensorRT -LLMオープンソース モデル エコシステムに優れたサポートを提供します書き直す必要があるのは次のとおりです: Meta によって発売された Llama 2-70B などの最大かつ最先端の言語モデルには、複数の GPU の動作が必要ですリアルタイムで応答を提供するために連携します

以前は、LLM 推論の最高のパフォーマンスを達成するには、開発者が AI モデルを手動で書き直して複数の部分に分割し、実行を調整する必要がありました。 GPU 間

#

#TensorRT-LLM は、テンソル並列テクノロジーを使用して重み行列を各デバイスに配布することで、プロセスを簡素化し、大規模な効率的な推論を可能にします

各モデルは、開発者の介入やモデルの変更を行わずに、NVLink 経由で接続された複数の GPU および複数のサーバー上で並行して実行できます。

新しいモデルとモデル アーキテクチャの導入により、開発者は TensorRT-LLM モデルでオープンソース化された最新の NVIDIA AI カーネル (カーナル) を使用して最適化できます。

書き直す必要がある内容は次のとおりです: サポートされているカーネル フュージョン (Kernal Fusion) には、最新の FlashAttendant 実装と、GPT モデルのコンテキストおよび生成ステージ用のマスクされたマルチヘッド アテンションが含まれています。実行 Li ら

#さらに、TensorRT-LLM には、現在人気のある多くの大規模な言語モデルの、完全に最適化され、すぐに実行できるバージョンも含まれています。これらのモデルには、Meta Llama 2、OpenAI GPT-2 および GPT-3、Falcon、Mosaic MPT、BLOOM など 10 種類以上が含まれます。これらのモデルはすべて、使いやすい TensorRT-LLM Python API を使用して呼び出すことができます。

これらの機能は、開発者がカスタマイズされた大規模な言語モデルをより迅速かつ正確に構築し、さまざまなニーズを満たすのに役立ちます。あらゆる分野で。

実行中のバッチ処理

現在、大規模な言語モデルが幅広いアプリケーションで使用されています。単一のモデルは、チャットボットでの単純な Q&A 応答から文書の要約や長いコード ブロックの生成まで、一見異質に見える複数のタスクに同時に使用でき、ワークロードは非常に動的です。出力サイズは、さまざまな規模のタスクのニーズを満たす必要があります。

タスクの多様性により、リクエストを効率的にバッチ処理し、効率的な並列実行を実行することが困難になる可能性があり、一部のリクエストが他のリクエストよりも早く完了する可能性があります。

大規模言語モデルの中核原理は、テキスト生成プロセス全体がモデルの複数回の反復を通じて実現できるということです。

-flight バッチ処理 を使用すると、TensorRT-LLM ランタイムは、バッチ全体が完了するのを待ってから次のリクエスト セットに進むのではなく、完了したシーケンスをバッチから即座に解放します。

新しいリクエストを実行するとき、前のバッチの完了していない他のリクエストはまだ処理中です。

オンボード バッチ処理を実行し、追加のカーネル レベルの最適化を行うことにより、GPU 使用率が向上し、その結果、H100 上の LLM の実際のリクエスト ベンチマークのスループットが少なくとも 2 倍になります

FP 8 の H100 Transformer Engine の使用

TensorRT-LLM は、大規模なモデル推論中のメモリ消費とレイテンシを効果的に削減できる H100 Transformer Engine と呼ばれる機能も提供します。LLM には数十億のモデルの重みと活性化関数が含まれているため、通常、これらは FP16 または BF16 の値でトレーニングおよび表現され、それぞれが 16 ビットのメモリを占有します。

ただし、推論時には、8 ビットまたは 4 ビット整数 (INT8 または INT4) などの量子化手法を使用して、ほとんどのモデルを低精度で効果的に表現できます。

量子化は、精度を犠牲にすることなくモデルの重みとアクティベーション精度を減らすプロセスです。より低い精度を使用すると、各パラメーターが小さくなり、モデルが GPU メモリ内で占有するスペースが少なくなります。

#同じハードウェアを使用して、実行中のメモリ操作の時間消費を削減しながら、より大きなモデルを推論できます

#同じハードウェアを使用して、実行中のメモリ操作の時間消費を削減しながら、より大きなモデルを推論できます

H100 Transformer Engine テクノロジーにより、TensorRT-LLM を備えた H100 GPU により、ユーザーはモデルの重みを新しい FP8 形式に簡単に変換し、モデルを自動的にコンパイルして最適化された FP8 カーネルを利用できるようになります。

そして、このプロセスにはコードは必要ありません。 H100 によって導入された FP8 データ形式により、開発者はモデルを定量化し、モデルの精度を低下させることなくメモリ消費量を大幅に削減できます。

INT8 や INT4 などの他のデータ形式と比較して、FP8 量子化はより高い精度を維持しながら最速のパフォーマンスを実現し、実装が最も便利です。 INT8 や INT4 などの他のデータ形式と比較して、FP8 量子化は最高のパフォーマンスを達成しながら高い精度を維持し、実装が最も便利です。

TensorRT-LLM の入手方法

TensorRT-LLM はまだ正式リリースされていませんが、事前に体験できるようになりました

##アプリケーションのリンクは次のとおりです:

# https://developer.nvidia.com/tensorrt-llm-early-access/joinNVIDIA は、TensorRT-LLM が間もなく NVIDIA NeMo フレームワークに統合されるとも述べました。

このフレームワークは、NVIDIA が最近立ち上げた AI Enterprise の一部であり、企業顧客に安全で安定しており、管理性の高いエンタープライズ レベルの AI ソフトウェア プラットフォームを提供します

開発者と研究者は、NVIDIA NGC の NeMo フレームワークまたは GitHub のプロジェクトを通じて TensorRT-LLM にアクセスできます。

# ただし、ユーザーは次のことを行う必要があることに注意してください。 NVIDIA 開発者プログラムに登録して、早期アクセス バージョンを申請してください。

ネチズンの熱い議論

Reddit 上のユーザーは、TensorRT-LLM のリリースについて白熱した議論を交わしました

最適化後は想像を絶するほどLLM 専用のハードウェアを使用すると、効果が大幅に向上します。

しかし、一部のネチズンは、このことの目的はLao HuangがH100をより多く売るのを助けることであると信じています。

しかし、一部のネチズンは、このことの目的はLao HuangがH100をより多く売るのを助けることであると信じています。

一部のネチズンはこれについてさまざまな意見を持っており、Tensor RT はディープ ラーニングをローカルにデプロイするユーザーにも役立つと考えています。 RTX GPU を持っている限り、将来同様の製品から恩恵を受ける可能性があります

一部のネチズンはこれについてさまざまな意見を持っており、Tensor RT はディープ ラーニングをローカルにデプロイするユーザーにも役立つと考えています。 RTX GPU を持っている限り、将来同様の製品から恩恵を受ける可能性があります

よりマクロな観点から見ると、おそらく LLM の場合、特にハードウェア レベルを対象とした一連の最適化措置が存在し、パフォーマンスを向上させるために LLM 用に特別に設計されたハードウェアも存在する可能性があります。この状況は多くの一般的なアプリケーションで発生しており、LLM も例外ではありません

よりマクロな観点から見ると、おそらく LLM の場合、特にハードウェア レベルを対象とした一連の最適化措置が存在し、パフォーマンスを向上させるために LLM 用に特別に設計されたハードウェアも存在する可能性があります。この状況は多くの一般的なアプリケーションで発生しており、LLM も例外ではありません

#

#

以上がH100推理が8倍に急上昇! NVIDIA が 10 以上のモデルをサポートするオープンソース TensorRT-LLM を正式発表の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。