テクノロジー周辺機器

テクノロジー周辺機器 AI

AI Google AudioPaLM は、スピーキングとリスニングの両方に対応する大規模なモデルである「テキスト + オーディオ」デュアルモーダル ソリューションを実装しています。

Google AudioPaLM は、スピーキングとリスニングの両方に対応する大規模なモデルである「テキスト + オーディオ」デュアルモーダル ソリューションを実装しています。Google AudioPaLM は、スピーキングとリスニングの両方に対応する大規模なモデルである「テキスト + オーディオ」デュアルモーダル ソリューションを実装しています。

大規模言語モデルは、その強力なパフォーマンスと多用途性により、オーディオ、ビデオなどの多数のマルチモーダル大規模モデルの開発を推進してきました。

言語モデルの基礎となるアーキテクチャは、主に Transformer と主にデコーダに基づいているため、モデル アーキテクチャをあまり調整せずに他のシーケンス モダリティに適応できます。

最近、Google は統合音声テキスト モデル AudioPaLM をリリースしました。これは、テキストとオーディオ トークンをマルチモーダルな共同語彙にマージし、さまざまなタスク記述タグを組み合わせてデコーダーのトレーニングを実現します。 - 従来から使用される、音声認識 (ASR)、テキスト音声合成、自動音声翻訳 (AST)、音声音声翻訳 (S2ST) などを含む、音声とテキストの混合タスクに関する専用モデル異種混合モデルによって解決されるタスクは、アーキテクチャとトレーニング プロセスに統合されます。

写真

写真

紙のリンク: https://arxiv.org/pdf/2306.12925.pdf

リンクの例: https://google-research.github.io/seanet/audiopalm/examples/

さらに、AudioPaLM の基礎となるアーキテクチャは大規模な Transformer モデルは、テキストで事前トレーニングされた大規模な言語モデルの重みを使用して初期化でき、PaLM などのモデルの言語知識の恩恵を受けることができます。

実装結果の観点から見ると、AudioPaLM は AST および S2ST ベンチマークで最先端の結果を達成しており、ASR ベンチマークでのパフォーマンスは他のモデルと同等です。

AudioLM のオーディオ キューを活用することで、AudioPaLM モデルは、新しい話者の音声移行に対して S2ST を実行でき、音声品質と音声保存の点で既存の方法を上回ります。

AudioPaLM モデルには、トレーニングでは見られない音声入力とターゲット言語の組み合わせに対して AST タスクを実行するゼロショット機能もあります。

AudioPaLM

研究者らは、デコーダ専用の Transformer モデルを使用してテキストと音声トークンをモデル化しました。テキストと音声はモデルに入力される前に処理されています。単語のセグメンテーション。そのため、入力は単なる整数のシーケンスであり、トークン化解除された操作が出力側で実行されてユーザーに返されます。

#画像

#画像

音声埋め込みと単語分割

##元のオーディオ波形をトークンに変換するプロセスには、既存の音声表現モデルから埋め込みを抽出し、埋め込みを限られたオーディオ トークンのセットに離散化することが含まれます

前研究では、埋め込みが w2v-BERT モデルから抽出され、k-means によって量子化されました。この論文では、研究者は 3 つのソリューションを実験しました:

w2v-BERT: w2v-BERT を使用します。モデルは純粋な英語ではなく多言語データでトレーニングされ、K 平均法クラスタリングの前に正規化処理は実行されません。そうしないと、多言語環境が発生し、中程度のパフォーマンスが低下します。次に、語彙サイズ 1024

USM-v1 のレート 25Hz でトークンを生成します。より強力な 20 億パラメータのユニバーサル スピーチ モデル (USM) エンコーダを使用して、同様の操作を実行します。中間層から埋め込みを抽出;

USM-v2: 補助的な ASR 損失でトレーニングされ、多言語をサポートするためにさらに微調整されています。

テキスト専用デコーダの変更

Transfomrer デコーダ構造内で、以下を除く入力層と最後のソフトマックス出力層では、モデリング トークンの数は関与しません。PaLM アーキテクチャでは、入力行列と出力行列の重み変数が共有されます。つまり、それらは相互に転置されます。

したがって、純粋なテキスト モデルを両方のテキストをシミュレートできるモデルに変えるには、埋め込み行列のサイズを (t × m) から (t a) × m に拡張するだけで済みます。音声のモデル。t はテキスト語彙のサイズ、a は音声語彙のサイズ、m は埋め込み次元です。

事前トレーニングされたテキスト モデルを活用するために、研究者らは、埋め込み行列に新しい行を追加することで、既存のモデルのチェックポイントを変更しました。

具体的な実装では、最初の t トークンが SentencePiece テキスト タグに対応し、次の a トークンがオーディオ タグを表します。テキスト埋め込みでは事前トレーニングされた重みが再利用されますが、オーディオ埋め込みは新しく初期化されており、トレーニングする必要があります。

実験結果は、ゼロから再トレーニングする場合と比較して、テキストベースの事前トレーニング モデルが音声とテキストのマルチモーダル タスクのパフォーマンスを向上させるのに非常に有益であることを示しています。

オーディオ トークンをネイティブ オーディオにデコードします

オーディオ波形を合成するには研究者らはオーディオ トークンから 2 つの異なる方法をテストしました:

1. AudioLM モデルと同様の自己回帰デコード

2. SoundStorm モデル 非自己回帰デコーディング

両方の方法では、最初に SoundStream トークンを生成し、次に畳み込みデコーダーを使用してそれをオーディオ波形に変換する必要があります。

#研究者らは多言語 LibriSpeech でトレーニングしました。音声条件は 3 秒間の音声サンプルであり、音声トークンと SoundStream トークンとして同時に表現されました

元の入力音声の一部を音声条件として提供することにより、話者の音声を別の言語に翻訳する際に元の話者の音声を保存し、翻訳時に繰り返し再生することで空白時間を埋めることができます。元の音声は 3 秒未満です。

#トレーニング タスク

使用されるトレーニング データ セットは音声テキスト データです:1. オーディオ オーディオ: ソース言語での音声

2. トランスクリプト: 音声データ内の音声の文字起こし

3. 翻訳された音声: 音声内の音声の音声翻訳

##4. 翻訳されたトランスクリプト: 音声内の音声の書面による翻訳

コンポーネント タスクには次のものが含まれます:

1. ASR (自動音声認識): 音声を書き起こして、書き起こされたテキストを取得します

2. AST (自動音声翻訳): 音声を翻訳して、翻訳されたトランスクリプトを取得します。

#3. S2ST (音声間翻訳): 音声を翻訳して、翻訳されたトランスクリプトを取得します。 Audio

4. TTS (Text to Speech): 音声のトランスクリプトを読みます。

5. MT (テキストからテキストへの機械翻訳): 翻訳されたトランスクリプト テキストを取得するためのトランスクリプトの翻訳

データセットは、次の目的で使用される場合があります。複数のタスクがあるため、研究者らは、与えられた入力に対してどのタスクを実行するかをモデルに通知することを選択しました。具体的な方法は、入力の前にラベルを追加し、タスクの英語名と入力言語を指定し、出力言語を指定することもできます。選択されました。

たとえば、モデルでフランス語コーパスに対して ASR を実行する場合、TTS を実行するには、単語分割後の音声入力の前にラベル [ASR French] を追加する必要があります。英語のタスクの場合は、テキストの前にラベルを追加する必要があります [TTS 英語] を追加します。英語からフランス語への S2ST タスクを実行するには、セグメント化後の英語音声の前に [S2ST 英語 フランス語]

## が追加されます。トレーニング ミックス

##研究者らは SeqIO ライブラリを使用してトレーニング データをブレンドし、より大きなデータの重みを軽減しました。セット。

#写真

実験部分 写真

写真

AudioPaLM は、AST および S2ST タスクで他のベースライン モデルを上回っており、ASR でのパフォーマンスは最適ではありませんが、効果も非常に優れています。

客観的メトリクス

オーディオ サンプルを指定して、1 の間の非参照 MOS 推定器と同様のものを使用します。知覚されるオーディオ品質の推定値を 5 の範囲で提供します。

言語間での音声伝達の品質を測定するために、研究者らは既製の話者検証モデルを使用し、ソース (SoundStream でエンコード/デコード) と翻訳された音声の間のエンベディングを計算しました。コサイン類似度。ソース オーディオからターゲット オーディオまでの音響特性 (録音条件、バックグラウンド ノイズ) も測定します。主観的評価 研究者らは、生成された音声の品質と音声の類似性を評価するために 2 つの独立した研究を実施しました。サンプルセット。 コーパスの品質が不均一であるため、一部には、大音量で重複する音声 (たとえば、バックグラウンドで再生されているテレビ番組や歌) や、非常に強いノイズ (たとえば、衣服が擦れる音) が含まれています。マイクなど))、同様の歪み効果は人間の評価者の作業を複雑にするため、研究者らは、MOS 推定値が少なくとも 3.0 の入力のみを選択することでプレフィルタリングすることにしました。 評価は、1 (低品質、またはまったく異なるサウンド) から 5 (高品質、同じサウンド) の範囲の 5 段階スケールで提供されます。 結果から、AudioPaLM はオーディオに関して客観的測定と主観的測定の両方で優れたパフォーマンスを発揮していることがわかります。品質と音声の類似性: どちらもベースラインの Translatotron 2 システムよりも大幅に優れており、AudioPaLM は CVSS-T の実際の合成録音よりも高品質で音声の類似性が高く、ほとんどの指標で比較的大きな改善が見られます。 研究者らはまた、リソースの高いグループとリソースの少ないグループ (フランス語、ドイツ語、スペイン語、カタロニア語と他の言語) のシステムを比較し、これらのグループ間に有意な差がないことを発見しました。インジケーターで。  写真

写真

以上がGoogle AudioPaLM は、スピーキングとリスニングの両方に対応する大規模なモデルである「テキスト + オーディオ」デュアルモーダル ソリューションを実装しています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

シンプソンのパラドックスは、どのようにしてデータの隠された傾向を明らかにすることができますか? - 分析VidhyaApr 23, 2025 am 09:20 AM

シンプソンのパラドックスは、どのようにしてデータの隠された傾向を明らかにすることができますか? - 分析VidhyaApr 23, 2025 am 09:20 AMシンプソンのパラドックス:データの隠された傾向を発表します 統計に惑わされたことはありますか?シンプソンのパラドックスは、集計されたデータが重要な傾向を曖昧にする方法を示し、複数のレベルでデータを分析することの重要性を明らかにしています。この簡潔なGUI

名目データとは何ですか? - 分析VidhyaApr 23, 2025 am 09:13 AM

名目データとは何ですか? - 分析VidhyaApr 23, 2025 am 09:13 AM導入 公称データはデータ分析の基盤を形成し、統計、コンピューターサイエンス、心理学、マーケティングなどのさまざまな分野で重要な役割を果たします。 この記事は、ノミの特性、アプリケーション、および区別を掘り下げています

ワンショットプロンプトとは何ですか? - 分析VidhyaApr 23, 2025 am 09:12 AM

ワンショットプロンプトとは何ですか? - 分析VidhyaApr 23, 2025 am 09:12 AM導入 機械学習の動的な世界では、最小データを使用して正確な応答を効率的に生成することが最重要です。 ワンショットプロンプトは強力なソリューションを提供し、AIモデルが単一の例を使用して特定のタスクを実行できるようにします

テスラのロブバンは、2024年のロボタクシティーザーの隠された宝石でしたApr 22, 2025 am 11:48 AM

テスラのロブバンは、2024年のロボタクシティーザーの隠された宝石でしたApr 22, 2025 am 11:48 AM2008年以来、私は共有ライドバンを擁護しました。これは、「Robotjitney」と呼ばれる「後に「Vansit」と呼ばれ、都市交通の未来として擁護しました。 私はこれらの車両を21世紀の次世代トランジットソリューション、スルパとして予見します

サムのクラブは領収書の小切手を排除し、小売を強化するためにAIに賭けますApr 22, 2025 am 11:29 AM

サムのクラブは領収書の小切手を排除し、小売を強化するためにAIに賭けますApr 22, 2025 am 11:29 AMチェックアウトエクスペリエンスに革命をもたらす Sam's Clubの革新的な「Just Go」システムは、既存のAIを搭載した「スキャン&ゴー」テクノロジーに基づいて構築され、ショッピング旅行中にメンバーがサムズクラブアプリを介して購入をスキャンできるようになりました。

NvidiaのAI OmniverseはGTC 2025で拡大しますApr 22, 2025 am 11:28 AM

NvidiaのAI OmniverseはGTC 2025で拡大しますApr 22, 2025 am 11:28 AMGTC 2025でのNvidiaの強化された予測可能性と新製品のラインナップ AIインフラストラクチャの重要なプレーヤーであるNvidiaは、クライアントの予測可能性の向上に焦点を当てています。 これには、一貫した製品配信、パフォーマンスの期待を満たすこと、および

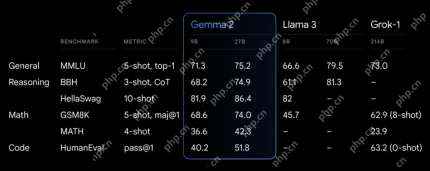

Google'のGemma 2モデルの機能を調査しますApr 22, 2025 am 11:26 AM

Google'のGemma 2モデルの機能を調査しますApr 22, 2025 am 11:26 AMGoogleのGemma 2:強力で効率的な言語モデル 効率とパフォーマンスで祝われるGoogleのGemmaファミリーは、Gemma 2の到着とともに拡大しました。この最新リリースは2つのモデルで構成されています。

genaiの次の波:Kirk Borne博士との展望-AnalyticsVidhyaApr 22, 2025 am 11:21 AM

genaiの次の波:Kirk Borne博士との展望-AnalyticsVidhyaApr 22, 2025 am 11:21 AMデータエピソードを率いるこの主要なのは、主要なデータサイエンティスト、天体物理学者、TEDXスピーカーであるカークボーン博士を特徴としています。 ビッグデータ、AI、および機械学習の有名な専門家であるボルネ博士は、現在の状態と将来のトラジェについて非常に貴重な洞察を提供しています

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!