ホームページ >テクノロジー周辺機器 >AI >チューリング賞受賞者のヤン・リークン氏: AI の論理的推論と計画能力には限界があり、事実や論理的な誤りを犯します。

チューリング賞受賞者のヤン・リークン氏: AI の論理的推論と計画能力には限界があり、事実や論理的な誤りを犯します。

- 王林転載

- 2023-06-10 17:05:531121ブラウズ

捜狐テクノロジーが制作

著者|鄭松儀

6月9日、2023年知源人工知能カンファレンスが北京で開催された。フランスの現地時間午前4時、「世界のディープラーニングの三大巨頭」の一人として知られるヤン・ルカン氏が北京のフランスのビデオリンクで「大規模モデルに向けて」というテーマで講演した。学習、推論、計画が可能」 このスピーチでは、人工知能についての深い考えが表現されました。

捜湖科技は知源会議でこのスピーチを視聴しましたが、スピーチ中の楊立坤の笑顔の表情からは、楊立坤の人工知能の開発に対する前向きで楽観的な姿勢が感じられます。以前、マスク氏らが人工知能の発展は人類文明にリスクをもたらすとの共同書簡に署名した際、楊立坤氏は人工知能はまだ人類に深刻な脅威をもたらすほどには発展していないと信じ、公に反論した。楊力坤氏は講演の中で、人工知能は制御可能であることを改めて強調し、「恐怖は潜在的なマイナスの結果の予測によって引き起こされるが、高揚感はプラスの結果の予測によって生じる。このような目標主導のシステムでは、私はこれを「目標駆動型 AI」と呼んでいます。コスト関数を通じて目標を設定できるため、制御可能になります。これにより、これらのシステムが世界を征服することを望まなくなり、代わりに人類と安全保障に屈することになります。 「

楊力坤氏は、人工知能と人間や動物との違いは、知能の重要な特徴である論理的推論と計画にあるとし、今日の大型モデルは「本能的に反応する」ことしかできないと述べた。

「1 兆または 2 兆のトークンを使用してマシンをトレーニングすると、マシンのパフォーマンスは驚くべきものになりますが、最終的にはマシンは事実上の誤りや論理的な誤りを犯すようになり、その推論能力には限界があります。」

Yang Likun 氏は、自己監視に基づく言語モデルでは現実世界についての知識を得ることができないと強調しました。彼は、機械は人間や動物に比べて学習能力が低いと考えています。何十年もの間、システムを開発する方法は教師あり学習を使用することでしたが、教師あり学習ではラベルが多すぎ、何かを学習するには多くの試行が必要で、強化学習の結果は満足のいくものではありませんでした。これらのシステムは脆弱で間違いを犯します。間違っていて、論理的に考えたり計画したりすることができません。

「私たちがスピーチをするときと同じように、ある点を別の点にどのように表現するか、どのように物事を説明するかは、一言一句即興で行うのではなく、頭の中で計画されています。低いレベルでは即興劇をしているのかもしれませんが、高いレベルでは、計画を立てる必要があります。したがって、計画の必要性は非常に明白です。私の予測では、比較的短い数年のうちに、正気の人は間違いなく自己回帰要素 (学習方法における自己教師ありモデルの 1 つ) を使用しなくなるでしょう。これらのシステムは修復不可能なため、間もなく放棄されるでしょう。」

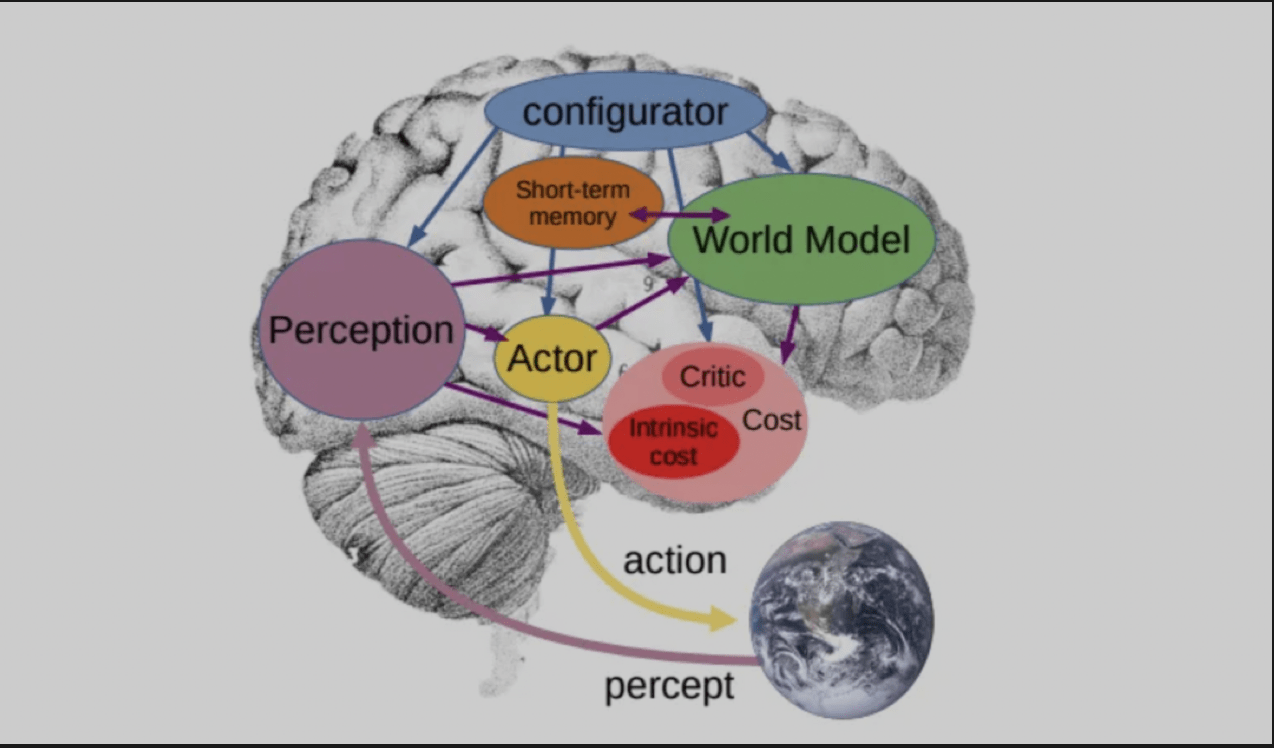

彼は、言語モデルが現実世界の知識を真に理解するには、それを置き換える新しいアーキテクチャが必要であると述べました。このアーキテクチャは、彼が 1 年前に発表した論文「Autonomous」で提案したアーキテクチャです。インテリジェンス(自律知能)」。これは、構成モジュールがシステム全体を制御し、入力された情報に基づいて予測、推論、意思決定を行うアーキテクチャです。 「ワールドモジュール」は、不足している情報を推定し、将来の外部条件を予測する機能を備えています。

そういえば、Yang Likun 氏は論文で発表したもう 1 つのモデル、「World Model」を紹介しました。これは、シーンを想像し、そのシーンに基づいてアクションの結果を予測することができます。目標は、独自の世界モデルによって予測され、さまざまなコストを最小限に抑える一連のアクションを見つけることです。

ヤン・リクン氏はQ&AセッションでAGIの現状と将来に関する今後の議論について質問されたとき、議論は人工知能システムが人間に実存的リスクをもたらすかどうかという問題を中心に展開するだろうと述べた。マックス・テグマーク氏とヨシュア・ベンジオ氏は「イエス」の側に立ち、強力なAIシステムは人類に存亡の危機をもたらす可能性があると主張する。そしてリクン・ヤンとメラニー・ミッチェルは「ノー」側に立つことになる。

「私たちが言いたいのは、リスクが存在しないということではなく、これらのリスクは存在するものの、注意深く設計することで簡単に軽減または抑制できるということです。」

楊力坤氏は、超知能システムはまだ開発されておらず、発明されてから「超知能システムが人間にとって安全かどうか」を議論しても手遅れになると考えています。

以上がチューリング賞受賞者のヤン・リークン氏: AI の論理的推論と計画能力には限界があり、事実や論理的な誤りを犯します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。