ホームページ >テクノロジー周辺機器 >AI >人工知能の 3 つの段階: 人類滅亡につながる可能性のある AI テクノロジーを制限するために科学者たちが協力する理由

人工知能の 3 つの段階: 人類滅亡につながる可能性のある AI テクノロジーを制限するために科学者たちが協力する理由

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-06-09 20:21:541662ブラウズ

OpenAI や Google Deepmind の責任者を含む専門家は、人工知能が人類の絶滅につながる可能性があると警告していますが、どうすれば機械が人間に取って代わることができるのでしょうか?

2022 年 11 月の発表以来、人工知能を使用して質問に答えたり、ユーザーのニーズに基づいてテキストやコードを生成したりするチャットボットである ChatGPT は、史上最も急速に成長しているインターネット アプリケーションとなっています。

わずか 2 か月でアクティブ ユーザー数が 1 億人に達しました。テクノロジー監視会社Sensor Townによると、Instagramがこのマイルストーンに到達するまでに2年半もかかったという。

Microsoft からの資金提供を受けて OpenAI によって開発された ChatGPT の人気は、人工知能が人類の将来に与える影響についての激しい憶測を引き起こしました。

数十人の専門家が、AI セーフティ センターのページに掲載された声明を支持し、次のように述べています。「AI によってもたらされる絶滅のリスクを軽減することは、伝染病や核戦争などの他の社会規模のリスクと並んで、世界的な優先事項となるべきです。」

しかし、この懸念は誇張されているという人もいます。

人間の真似をする

ChatGPT、DALL-E、Bard、AlphaCode などの人工知能は、人間とほぼ同じテキスト (散文、詩、ジョークからコンピューター コードまで) と画像 (図、写真、アートワークなど) を生成します。 ' 自身の作品。見分けがつきません。

学生は宿題を書くためにそれを使用し、政治家はスピーチを書くためにそれを使用します。民主党のジャック・オーチンクロス下院議員は、米国議会でこのリソースを立ち上げました。

テクノロジー大手IBMは、人工知能が対応できる7,800のポジションの募集を停止すると発表した。

これらすべての変更に圧倒されている場合は、準備をしてください:

私たちは人工知能の第 1 段階にすぎず、今後さらに 2 段階が予定されており、一部の科学者はそれが人類の生存を脅かす可能性があると懸念しています。

以下に 3 つの段階があります。

1. 狭義の人工知能

弱い人工知能は、制限ドメイン人工知能とも呼ばれ、単一のタスクに焦点を当て、さまざまな機能にわたって反復的な作業を実行します。

通常、インターネットなどの大量のデータから学習しますが、プログラムされている特定のドメイン内でのみ学習します。

例としては、世界チャンピオンに勝つことはできるが、他のタスクを実行できないチェス プログラムがあります。

スマートフォンには、GPS マップからユーザーの好みを学習して推奨する音楽やビデオ プログラムまで、このテクノロジーを使用するアプリがたくさんあります。

自動運転車や ChatGPT などのより複雑なシステムは、依然として弱い人工知能のカテゴリーに分類されます。彼らは自分に割り当てられた役割の範囲外で行動することができないため、自分自身で意思決定を行うことができません。

しかし一部の専門家は、ChatGPT や AutoGPT などの自動学習機能を備えてプログラムされたシステムが開発の次の段階に入る可能性があると考えています。

2. 汎用人工知能

汎用人工知能は、人間が完了できるあらゆる知的タスクを機械が完了できるようになったときに登場します。

「強い人工知能」とも呼ばれます。

6か月の停止

2023 年 3 月、1,000 人以上の技術専門家が「すべての人工知能研究所に対し、GPT-4 より強力な人工知能システムのトレーニングを少なくとも 6 か月間直ちに中止する」よう求めました。GPT-4 は ChatGPT の最新バージョンです。

「人間に匹敵する知能を備えた人工知能システム」と、アップルの共同創設者スティーブ・ウォズニアック氏と、テスラやスペースXの社長イーロン・マスク氏を含む他のハイテク巨人は書いている。社会と人類に重大なリスクをもたらす可能性がある。 OpenAI の創設者であり、後に会社のリーダーシップとの意見の相違により取締役を辞任しました。

非営利団体フューチャー・オブ・ライフ研究所が発表した書簡の中で、専門家らは、企業がプロジェクトの即時停止を拒否する場合、安全対策を設計・実施できるよう「政府が介入して一時停止措置を講じるべきだ」と述べた。 。

「賢くてバカ」

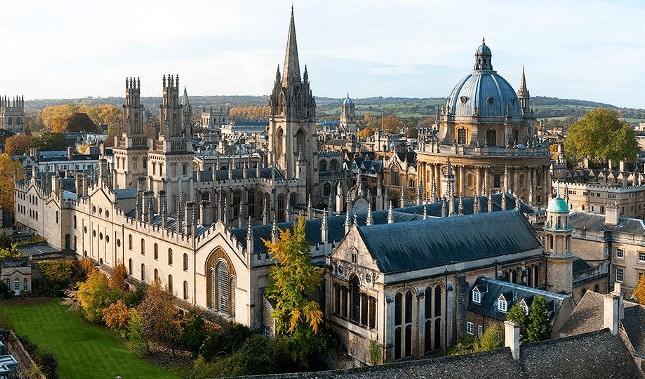

この手紙は、オックスフォード大学人工知能倫理研究所のカリッサ・ベリスによって署名されました。彼女は、最終的に人工知能安全センターによって発行された警告声明が極端すぎると信じていたため、署名を拒否しました。

「私たちが現在開発している種類の AI は、賢いと同時に愚かでもあります。ChatGPT や他の AI を試したことのある人なら、非常に重大な制限があることに気づくでしょう。」

と彼女は Andrew Webb 氏に語った。ワイリズ氏は、人工知能が非常に高い割合で誤った情報を生み出すのではないかと懸念していると述べた。

2024 年の米国大統領選挙が近づくにつれ、Twitter やその他の主要プラットフォームのような重要なプラットフォームが AI の倫理および安全チームを解雇しているのではないかという懸念が高まっています。 「

米国政府は潜在的な脅威を認識しています。ホワイトハウスは5月4日の声明で、「人工知能は現代で最も強力なテクノロジーの1つだが、それがもたらす機会をつかむためには、まずそのリスクを軽減しなければならない」と述べた。

米国議会は、ChatGPT に関する質問に答えるよう OpenAI CEO の Sam Altman を召喚しました。アルトマン氏は上院公聴会で、人工知能の発展に伴い同業界に対する政府規制にとって「非常に重要」であると述べた。

フューチャー・オブ・ライフ研究所の公共政策研究者であるグティエレス氏は記者団に対し、人工知能によってもたらされる大きな課題の一つは、「政府間組織のような、人工知能をどのように規制するかを決定するための専門家で構成された共同機関が存在しないこと」と説明した。気候変動委員会のようなもの。」

これで、人工知能の第 3 段階、つまり最終段階に到達します。

3. 超人工知能

この理論では、第 2 段階に到達すると、すぐに最終段階である「超人工知能」に入るということです。人工知能が人間の知能を超えると、こういうことが起こります。オックスフォード大学の哲学者で人工知能の専門家であるボストロムは、超知能を「科学的創造性、一般的な知能、社会的スキルなど、ほぼすべての分野で人間の最高の脳をはるかに超える知能」と定義しています。

「人間は、エンジニア、看護師、弁護士になるためには長い時間をかけて学習する必要があります。一般的な人工知能の難しさは、人間ができない状況でも継続的に自己改善できる能力があることです」とグティエレス氏は説明しました。 ”.

######SF######

######SF######

プリンストン大学のコンピューター科学者ナラヤナン氏は以前、SF の災害シナリオは非現実的であると記者団に語った:「現在の人工知能は、これらのリスクを現実にするのに十分とは程遠い。結局のところ、人工知能は人々の注意をそらすことになる。人工知能は害を及ぼすだろう」短期的には注意が必要です。」

人間が持つ広範な知性、特に心の知能の点で機械が実際に達成できるかどうかについては多くの議論があるが、これは人類が一般的な人工知性を達成しようとしていると信じる人々の最大の懸念の1つである。知能。

最近、「人工知能のゴッドファーザー」ジェフリー・ヒントンは、私たちがこのマイルストーンに近づいているかもしれないと警告しました。ヒントンは、経験から学ぶよう機械に教育する先駆者です。

「現時点で(機械が)私たちより賢いとは思えません。彼が引退し、75歳であることを考えると、おそらくかなり早くそこに到達すると思います。

同氏は、これらのマシンは最終的に「『もっとパワーが必要だ』といった下位目標を生み出す可能性があり」、それが「存続リスク」をもたらす可能性があると警告した。

ヒントンは、人工知能にはリスクがある可能性があることを認めていますが、短期的にはその利点がリスクを上回ると信じており、したがってこの技術の開発を止めるべきではないと考えています。 "彼は言った。###

絶滅か不死か

英国の物理学者スティーブン・ホーキング博士は厳しい警告を発した。「人工知能の完全な発展は人類の終焉を意味するかもしれない」と彼は死の4年前の2014年に記者団に語った。

このレベルのインテリジェンスを備えたマシンは「独自に進化し、加速度的に再設計されるだろう」と同氏は述べた。

ナノボットと不死性

人工知能の最大の愛好家の 1 人は、未来の発明家であり作家であるカーツワイルです。彼は Google の AI 研究者であり、シリコンバレーのシンギュラリティ大学の共同創設者です。カーツワイル氏は、人間は超知能の人工知能を使用して生物学的障害を克服できるようになると信じています。

彼は 2015 年に、体内で働き、あらゆる損傷や病気を修復し治癒できるナノボット (非常に小さなロボット) のおかげで、2030 年までに人類は不死を達成すると予測しました。

人工知能管理

Gutierrez 氏は、AI ガバナンス システムを構築することが鍵であることに同意します。「ある実体が(インターネット検索のおかげで)地球上のすべての人々とその習慣について非常に多くの情報を持っており、私たちが知らない方法で私たちをコントロールできるようになる未来を想像してみてください。」と彼は言いました。

「最悪のシナリオは、人間とロボットの間の戦争ではありません。私たちはこの地球を、私たちより賢い存在と共有していますが、悲しいことに、私たちは自分たちが操作されていることに気づいていません。」

以上が人工知能の 3 つの段階: 人類滅亡につながる可能性のある AI テクノロジーを制限するために科学者たちが協力する理由の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。