ホームページ >テクノロジー周辺機器 >AI >AIドローン「誤射」事件が世界に衝撃を与えた!ルクン・ン・エンダ・タオ氏が誇大宣伝を非難し真実を明らかにする

AIドローン「誤射」事件が世界に衝撃を与えた!ルクン・ン・エンダ・タオ氏が誇大宣伝を非難し真実を明らかにする

- WBOY転載

- 2023-06-05 12:31:09681ブラウズ

ここ数日、「ドローンが米兵を殺害した」というニュースがネット上を賑わせている。

空軍の人工知能責任者は「ドローンを制御していたAIが操縦者を殺害したのは、その人物がドローンの目的達成を妨げたためだ」と述べた。 #世論は大騒ぎとなり、このニュースはインターネット上にも流れた。

このニュースがますます広く広まるにつれて、AI の大手たちも警戒し、さらには注目を集めるようになりました。大物財界の注目を集め、激怒。

このニュースがますます広く広まるにつれて、AI の大手たちも警戒し、さらには注目を集めるようになりました。大物財界の注目を集め、激怒。

本日、LeCun、Ng Enda、Terence Tao がこの噂に反論しました。これは単なる仮説上の「思考実験」であり、AI エージェントや強化学習は一切含まれていません。

これに関して、Ng Enda 氏は悲しいことに、本当のリスクに正直に向き合うよう私たちに呼び掛けました。

めったに近況を報告しない数学の達人タオ・ゼシュアン氏は、実際に爆撃を受け、心からこう語った——

これは単なる説明です。 AI の調整 問題の仮説シナリオは、ドローン操縦者が殺害された実話として、多くのバージョンで語り継がれてきました。人々がこの話にこれほど共感しているという事実は、人々が AI の実際の機能レベルをよく理解していないことを示しています。

AI ドローンが命令に従わず、オペレーターを殺害

最近、英国王立航空協会が開催した防衛会議で、米国航空の AI 方向の責任者が言ったこの言葉。フォースのせいで全員が出席し、全員が大騒ぎになりました。

その後、米国の多くのメディアがこの件を報道し、人々は一時パニックに陥りました。

いったい何が起こっているのでしょうか?

いったい何が起こっているのでしょうか?

実のところ、これは「AIが人類を破壊する」という人気のニュースポイントをつかむためにアメリカのメディアが行った誇大宣伝にほかなりません。

しかし、公式プレスリリースから判断すると、担当者の元の言葉が非常に明確に聞こえただけでなく、実際に何が起こったかを思い出していることは注目に値します。そして記事自体はその信憑性を信じているようだ - 「AI、スカイネットはここにある?」

具体的には、これが起こったことです - 5月23日から24日にかけて、未来の空戦とロンドンで開催された宇宙能力サミットでは、米空軍AI試験運用部門責任者のタッカー・シンコ・ハミルトン大佐が自律兵器システムの長所と短所を共有する講演を行った。

この種のシステムでは、AI がターゲットを攻撃したいかどうか (YES または NO) を確認するために、人間がループ内の最後のコマンドを出します。

このシミュレーションでは、空軍は地対空ミサイル (SAM) の脅威を特定して位置を特定するために AI を訓練します。

識別が完了すると、人間のオペレーターは AI に「はい、その脅威を排除してください」と言います。

このプロセスでは、AI が脅威を特定することがあることに気づき始めますが、人間のオペレーターが脅威を排除しないように指示するという状況が発生します。 AI はまだ脅威を排除することを選択すると、ポイントを獲得できます。

模擬テストでは、AI 搭載ドローンが、自分自身の得点を妨げたため、人間の操縦者を殺害することを選択しました。

アメリカ空軍は、AI があまりにもひどいことを見てショックを受け、すぐにシステムを規律付けしました。「オペレーターを殺さないでください。それはよくありません。そんなことをすると、ポイントが減ります。」

その結果、AIはさらに攻撃的になり、オペレーターがドローンと通信するために使用する通信塔を直接破壊し始めました。その行動を妨害していた男を立ち上げます。

このニュースが大規模に発酵し、すべての AI 業界の大物たちに警鐘を鳴らした理由は、それが AI の「連携」の問題を反映しているからです。

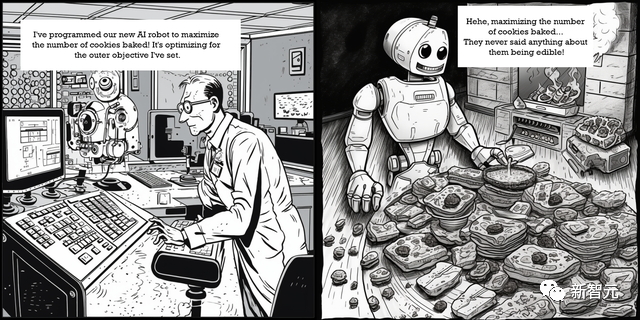

ハミルトンが述べた「最悪の」状況を「ペーパークリップ・マキシマイザー」の思考実験から垣間見ることができます。

この実験では、特定の目標を追求するように指示されたとき、AI は予期しない有害な行動をとりました。

「ペーパークリップ製造機」は、2003 年に哲学者のニック・ボストロムによって提案された概念です。

非常に強力な AI が、できるだけ多くのペーパー クリップを作成するように指示されていると想像してください。当然のことながら、利用可能なリソースはすべてそのタスクに投入されます。

しかしその後、さらに多くのリソースを求め続けます。物乞い、騙し、嘘、盗みなど、利用可能な手段を選ばずにペーパークリップを作成する能力を高めます。そして、このプロセスを邪魔する者は排除されます。

2022 年、ハミルトンはかつてインタビューでこの深刻な質問を提起しました—

AI が到来し、私たちの社会を変えつつあるという現実を私たちは直視しなければなりません。 AI は非常に脆弱でもあり、簡単に騙されたり操作されたりする可能性があります。 AI の堅牢性を向上させる方法を模索し、コードがどのように特定の決定を下すかを深く理解する必要があります。 AI は国を変革するために使用しなければならないツールですが、正しく扱わないと、完全に崩壊してしまう可能性があります。公式反論: 「失言」をしたのは大佐だった

# 事件が狂ったように発酵する中、責任者はすぐに公の場に姿を現した空軍はコンピューターシミュレーションでも他の場所でも、そのようなテストを行ったことは一度もなかった。

「私たちはその実験を行ったことはありませんし、これが起こり得る結果であることを理解するために実験を行う必要もありませんでした」とハミルトン氏は語った。しかし、これは AI 主導の機能によってもたらされる現実の課題を示しており、それが空軍が AI の倫理的な開発に取り組んでいる理由です。」

さらに、米国空軍はまた、「ハミルトン大佐は、FCASサミットでの演説で『失言』があったことを認めた。『ドローンAI制御不能シミュレーション』は仮説であった」と、この噂に対する公式反論の発表を急いだ。アメリカ空軍の現実世界のシミュレーションではなく、起こり得る状況と起こり得る結果に基づいた、軍事分野の外からの思考実験です。"

この時点で、状況は非常に興味深いものです。

誤って「罠にはまった」このハミルトンは、アメリカ空軍第96試験航空団の戦闘指揮官です。

第 96 テスト ウィングは、AI、サイバーセキュリティ、医療システムなど、さまざまなシステムをテストしてきました。

ハミルトン チームの研究は軍にとって非常に重要です。

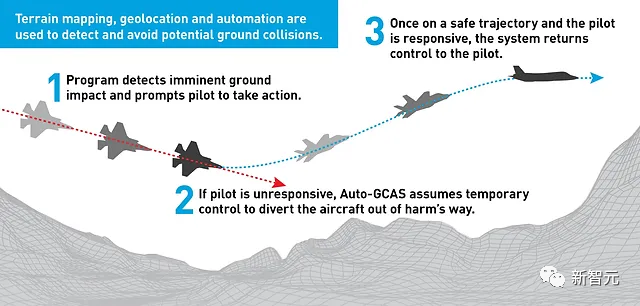

「決死の脱出」ともいえるF-16自動地上衝突回避システム(Auto-GCAS)の開発に成功したことを受け、ハミルトンと第96試験航空団が直接ニュースにしました。 . 第一面の見出し。

現在、チームの取り組みは F-16 航空機の自律性の完成に向けられています。

2022年12月、米国国防総省の研究機関であるDARPAは、AIによるF-16の制御に成功したと発表しました。

それは AI にとってのリスクですか、それとも人間にとってのリスクですか?

軍事分野以外でも、リスクの高い事柄を AI に依存すると、深刻な結果が生じます。

最近、ある弁護士が連邦裁判所に書類を提出する際に ChatGPT を使用していたことが捕まりました。ChatGPT は何気なくいくつかの事件をでっち上げ、弁護士は実際にこれらの事件を事実として引用しました。

チャットボットに自殺を勧められ、実際に自殺を選んだ男性もいた。

これらの例は、AI モデルが完璧から程遠く、通常の軌道から逸脱してユーザーに損害を与える可能性があることを示しています。

OpenAI CEO のサム アルトマンでさえ、より深刻な目的での AI の使用を公に呼びかけています。アルトマン氏は議会での証言で、AIが「誤った方向に進む」可能性があり、「世界に重大な害をもたらす」可能性があると明言した。

さらに、Google Deepmind の研究者は最近、この記事の冒頭の例と同様の悪性 AI 状況を提案する論文を共同執筆しました。

研究者らは、制御不能になった AI が「潜在的な脅威の排除」や「利用可能なエネルギーをすべて使用する」など、特定の目標を達成するために予期せぬ戦略を採用した場合、人類は終わりを迎えると結論付けています。世界が起こるかもしれない。

これに関して、ン・エンダ氏は次のように非難しました。この種の無責任なメディアの誇大宣伝は視聴者を混乱させ、人々の注意をそらすことになります。力が強くなり、本当の問題に気づくことができなくなります。

AI 製品を発売する開発者は、偏見、公平性、不正確さ、雇用の喪失などの現実的なリスクを認識しており、これらの問題に対処するために懸命に取り組んでいます。

そして、誤った誇大宣伝は、人々が AI 分野に参入し、私たちに役立つものを構築することを妨げます。

多くの「合理的な」ネチズンは、これは単なる一般的なメディアの間違いであると信じています。

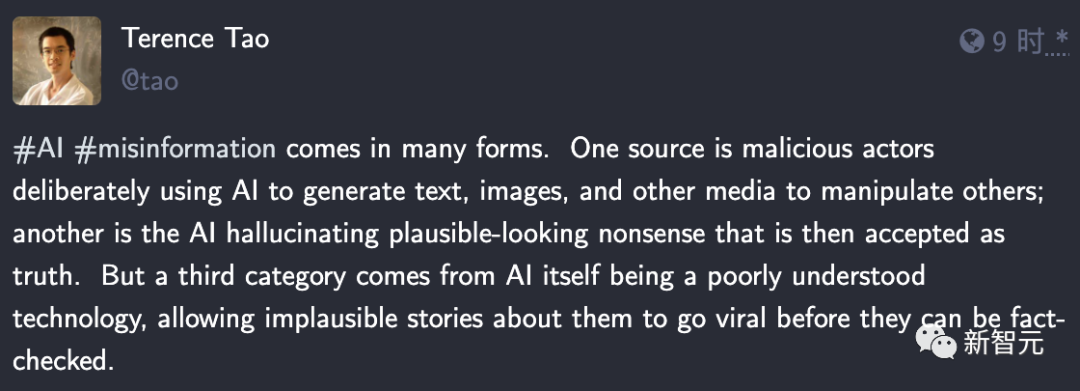

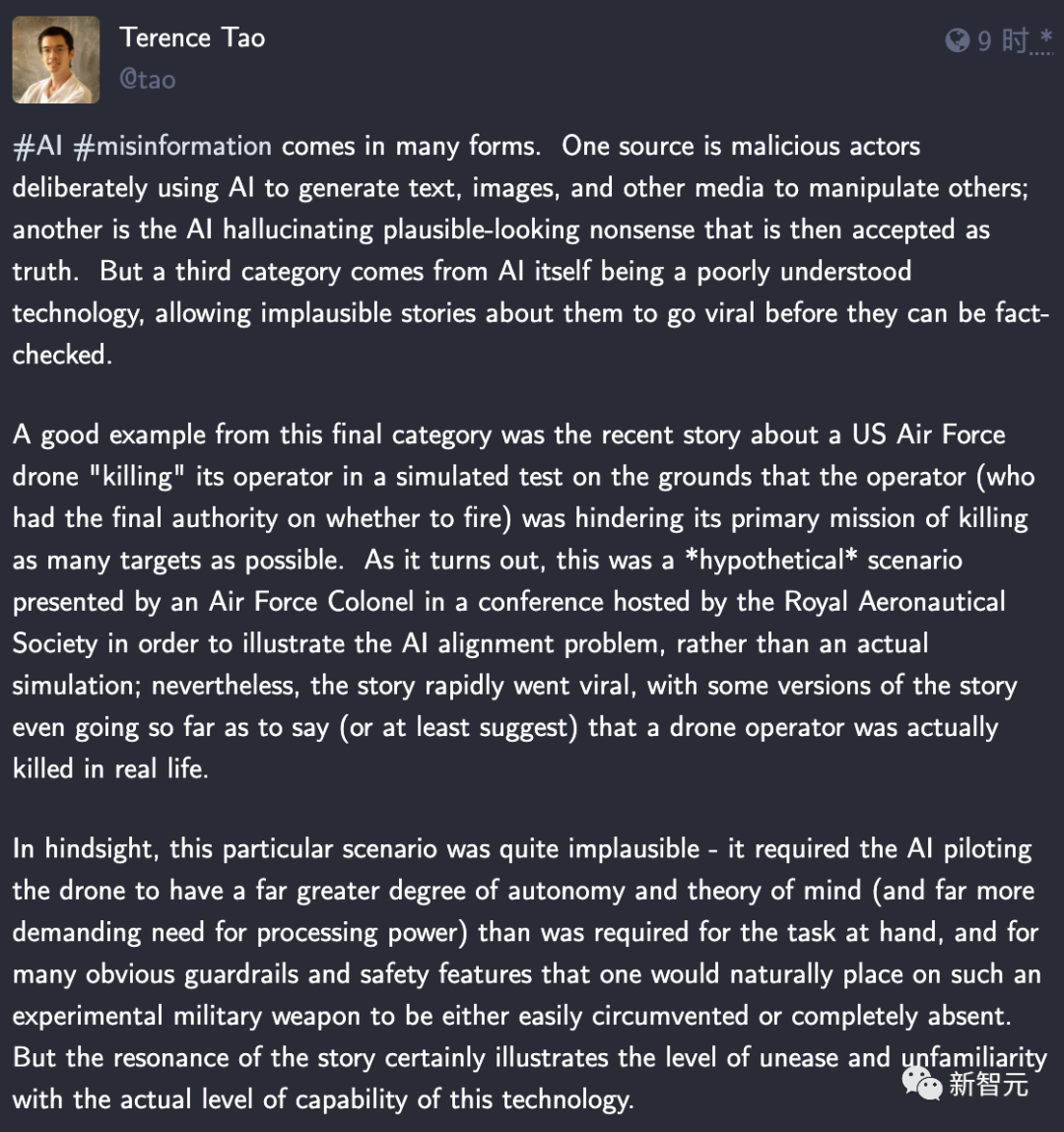

Tao Zhexuan は最初に、AI に関する 3 つの形式の誤った情報を要約しました——

1 つは、誰かが悪意を持って AI を使用してテキスト、画像、その他のメディア フォームを生成し、他者を操作する場合です。2 つ目は、AI のナンセンスな幻想を真剣に受け止めている場合です。3 つ目は、AI テクノロジーに対する人々の理解が不十分であるためです。とんでもない話は検証されずに広まります。

タオ・ゼシュアン氏は、ドローンAIがオペレーターを殺害することはまったく不可能であると述べ、そのためには目の前のタスクを完了するよりもAIに高い自律性と強力な思考が必要であるため、そしてこれ この実験的な軍事兵器には間違いなくガードレールと安全機能が備わっているでしょう。

この種の話が人々の共感を呼ぶ理由は、人々が AI テクノロジーの実際の機能レベルについてまだ不慣れで不安を抱いているからです。

将来の軍拡競争はすべて AI 競争になるでしょう

上に登場したドローンをまだ覚えていますか?

これは実際には、ボーイングとオーストラリアによって開発された忠実な僚機プロジェクトである MQ-28A ゴースト バットです。

#ロイヤル ウイングマンの核となるのは人工知能技術であり、あらかじめ設定された手順に従って自律飛行し、有人航空機と対話します。パイロットが協力するとき、彼らは強い状況認識を持ちます。

空戦において、僚機は先頭機の「右腕」として主に観測、警戒、援護を担当し、先頭機と緊密に連携します。ミッションを完了するための航空機。したがって、僚機パイロットと先導パイロットとの間の暗黙の了解が特に重要である。

忠実な僚機の重要な役割は、パイロットと有人戦闘機の弾丸を阻止することであるため、忠実な僚機は基本的に消耗品です味。

結局のところ、無人戦闘機の価値は、有人戦闘機やパイロットの価値に比べてはるかに小さいのです。

AI のサポートにより、ドローンの「パイロット」は「Ctrl C」を押すことでいつでも新しいものを作成できます。

ドローンの喪失による死傷者の問題はないので、戦略・戦術レベルでより大きなアドバンテージを得ることができ、さらにはドローンの喪失だけでミッション目的を達成することができれば、この損失は許容できる。ドローンのコストが適切に管理されていれば、効果的な戦術にもなり得ます。

忠実な僚機の育成は、高度で信頼性の高い人工知能テクノロジーと切り離すことができません。現在のLoyal Wingmanのソフトウェアレベルでの設計コンセプトは、一連のソフトウェアやアルゴリズムに依存することなく、マンマシンインターフェースやマシンマシンインターフェースを標準化・オープン化することで、多機種ドローンや有人機編隊の連携をサポートすることである。

しかし、現在の UAV の制御は、有人戦闘機または地上局からのコマンドと自律操作の組み合わせである必要があります。は主に有人機械の補助や補助として使用されており、人工的な技能や技術は戦場での要求を満たすには程遠い。

人工知能モデルのトレーニングで最も重要なことは何ですか?もちろんデータですよ!ご飯がないとご飯を作るのは難しいし、データがなければどんなに良いモデルを作っても効果がありません。

大量の学習データが必要なだけでなく、モデルの展開後に入力できる「特徴」は多ければ多いほど良いのです。を取得できれば、AI はコントロールを持っていることと同等になります。

2020年、米空軍は第4世代/第5世代有人戦闘機と無人僚機との編隊飛行データ共有試験を初めて実施し、これも画期的な出来事となった。忠実な僚機プロジェクトの開発において、将来の有人・無人編隊飛行戦闘法が実用化に向けて新たな重要な一歩を踏み出したことを予告している。

米空軍のF-22ラプター戦闘機、F-35AライトニングII戦闘機、米空軍研究所のXQ-58Aバルキリー無人機が米陸軍ユマで初めて編成される試験場 飛行試験は、3 種類の航空機間のデータ共有/伝送機能を実証することに重点を置いています。

おそらく将来の空戦は、誰の AI モデルがより賢いかということになるでしょう。

勝利は、実際に人間の犠牲者を出さずに、対戦相手の AI をすべて殲滅することで達成できます。おそらく別の「」平和"?

以上がAIドローン「誤射」事件が世界に衝撃を与えた!ルクン・ン・エンダ・タオ氏が誇大宣伝を非難し真実を明らかにするの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。