ホームページ >テクノロジー周辺機器 >AI >南部科学技術のブラックテクノロジー: ワンクリックでビデオキャラクターを排除、特殊効果アーティストの救世主が登場!

南部科学技術のブラックテクノロジー: ワンクリックでビデオキャラクターを排除、特殊効果アーティストの救世主が登場!

- PHPz転載

- 2023-05-25 14:56:29747ブラウズ

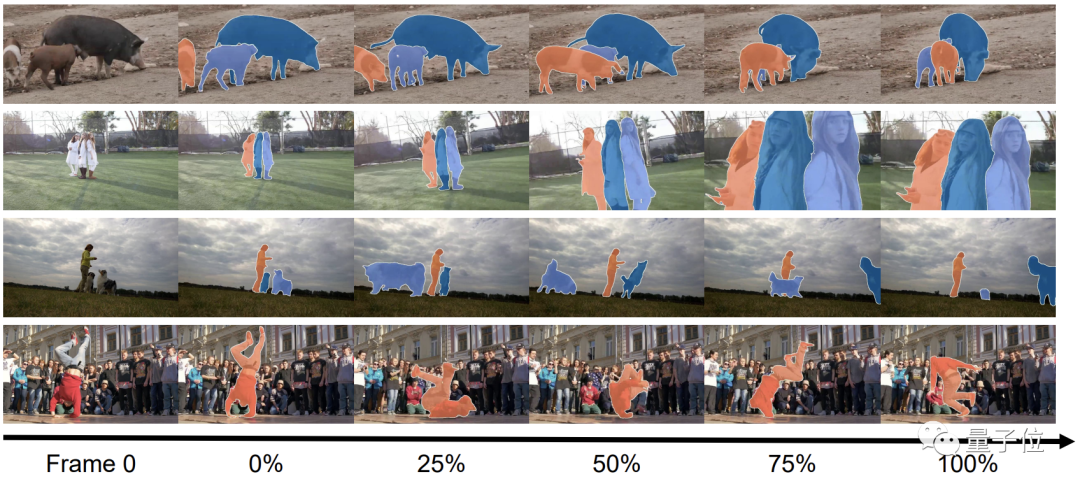

南方科学技術大学のこのビデオ セグメンテーション モデルは、ビデオ内のあらゆるものを追跡できます。

「見る」だけでなく「切り取る」こともでき、ビデオから個人を削除することも簡単です。

操作に関しては、マウスを数回クリックするだけです。

特撮アーティストはニュースを見て救世主を見つけたようで、この製品は世界のゲームのルールを変えるだろうと率直に言いました。 CGI業界。

このモデルは TAM (Track Anything Model) と呼ばれていますが、Meta の画像セグメンテーション モデル SAM の名前に似ていますか?

実際、TAM は SAM をビデオ分野に拡張し、動的オブジェクト トラッキング のスキル ツリーを強化します。

#ビデオ セグメンテーション モデルは実際には新しいテクノロジーではありませんが、従来のセグメンテーション モデルでは人間の作業が軽減されません。

これらのモデルで使用されるトレーニング データはすべて手動で注釈を付ける必要があり、使用前に特定のオブジェクトのマスク パラメーターで初期化する必要さえあります。

SAM の出現により、この問題を解決するための前提条件が提供されます。少なくとも、初期化データを手動で取得する必要がなくなりました。

もちろん、TAM は SAM をフレームごとに重ねて使用するのではなく、対応する時空間関係を構築する必要があります。

チームは、SAM を XMem と呼ばれるメモリ モジュールと統合しました。

SAM を使用して最初のフレームで初期パラメータを生成するだけで済み、XMem が後続の追跡プロセスをガイドできます。

追跡対象は多数あります。たとえば、次の清明節の川沿いの写真です。

シーンが変わっても、 TAM のパフォーマンスには影響しません:

私たちが実際に体験したところ、TAM は対話型のユーザー インターフェイスを使用しており、操作が非常にシンプルで使いやすいことがわかりました。

2FGVIを組み合わせることで形成されます。

E2FGVI 自体もビデオ要素除去ツールであり、TAM の正確なセグメンテーションのサポートにより、その作業はより的を絞ったものになります。

TAM をテストするために、チームは DAVIS-16 および DAVIS-17 データ セットを使用して評価しました。

#直感的な感覚は依然として非常に良好であり、データからもそれは確かに真実です。

TAM ではマスク パラメーターを手動で設定する必要はありませんが、J (領域類似性) と F (境界精度) の 2 つの指標は手動モデルに非常に近いです。

DAVIS-2017 データセットのパフォーマンスでも、STM のパフォーマンスよりわずかに優れています。

他の初期化方法の中でも、SiamMask のパフォーマンスは TAM と比較できません;

MiVOS と呼ばれる別の方法は TAM よりもパフォーマンスが優れていますが、結局 8 ラウンド進化しました...

チームプロフィール

TAM は、南方科学技術大学の視覚知能知覚 (VIP) 研究室の出身です。

この研究室の研究方向には、テキスト、画像、音声のマルチモデル学習、マルチモデル知覚、強化学習、視覚的欠陥検出が含まれます。

現在、チームは 30 以上の論文を発表し、5 つの特許を取得しています。

チームのリーダーは、南方科技大学のジェン・フェン准教授で、英国のシェフィールド大学で博士号を取得し、中国高等研究所で勤務した経験があります。科学アカデミー、テンセント・ユートゥなどの機関を卒業し、2018年に南方科学技術大学に入学し、准教授に昇進した。

論文アドレス:

https://arxiv.org/abs/2304.11968

GitHub ページ:

https://github.com/gaomingqi/Track-Anything

参考リンク:

https://twitter.com/bilawalsidhu/status/1650710123399233536 ?s=20

以上が南部科学技術のブラックテクノロジー: ワンクリックでビデオキャラクターを排除、特殊効果アーティストの救世主が登場!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。