ホームページ >テクノロジー周辺機器 >AI >幻覚? Musk の TruthGPT もそれを処理できません。 OpenAIの共同創設者は「それは複雑だ」と語る

幻覚? Musk の TruthGPT もそれを処理できません。 OpenAIの共同創設者は「それは複雑だ」と語る

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-05-23 19:13:04759ブラウズ

先月、マスク氏はスーパーAIの研究開発を6か月停止するよう必死に要求した。

やがて、老馬は黙っていられなくなり、TruthGPTと呼ばれるAIプラットフォームの立ち上げを正式に発表しました。

マスク氏はかつて、TruthGPTは宇宙の本質を理解しようとする「最大の真実探求人工知能」になるだろうと語った。

彼は、私たちは宇宙の興味深い部分であるため、宇宙を理解しようとする人工知能が人類を絶滅させる可能性は低いと強調しました。

しかし、今のところ「幻想」を扱える言語モデルはありません。

最近、OpenAI の共同創設者は、TruthGPT の崇高な理想の実現がなぜそれほど難しいのかを説明しました。

TruthGPT の理想はバブルですか?

マスク氏の X.AI が構築しようとしている TruthGPT は、正直な言語モデルです。

そうすることで、ChatGPT を直接ターゲットにします。

なぜなら、以前は、ChatGPT のような AI システムは、誤った出力などの典型的な幻覚ケースを生成し、特定の政治的信念の報告をサポートすることさえあったからです。

ChatGPT を使用すると、ユーザーは問題を解決するために言語モデルをより詳細に制御できるようになりますが、「錯覚」は依然として OpenAI、Google、およびマスクの人工知能企業が対処しなければならない中核的な問題です。未来。

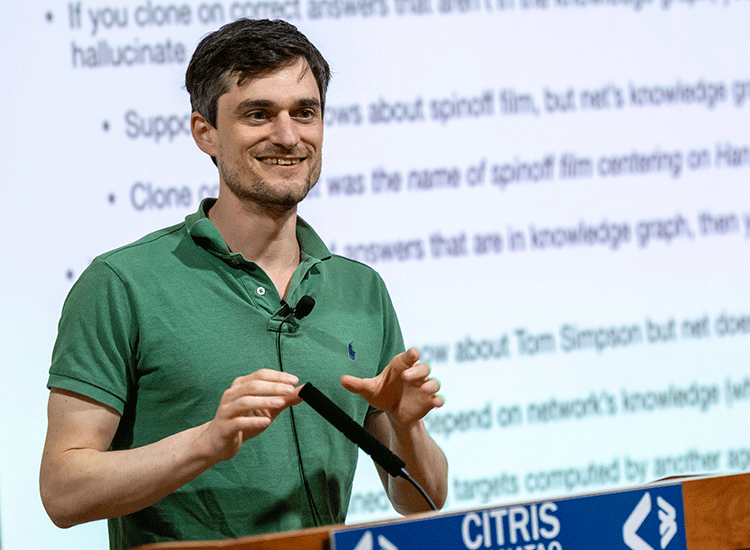

OpenAI の共同創設者で研究者の John Schulman 氏は、講演「RL と真実性 – TruthGPT に向けて」の中で、これらの課題とその対処方法について説明しています。

#なぜ「幻覚」があるのでしょうか?

シュルマンによれば、幻覚は大きく 2 つのタイプに分類できます:

1. 「パターン補完動作」、つまり言語モデルでは表現できないそれ自体不確実性、プロンプトで前提条件に疑問を呈することができない、または以前の間違いから継続することができない。

2. モデルの推測が間違っています。

言語モデルは、独自のネットワーク内のトレーニング データからのファクトを含むナレッジ グラフを表すため、微調整は、そのナレッジ グラフ上で動作する関数を学習して出力することとして理解できます。トークン予測。

たとえば、微調整データセットには、「スター ウォーズのジャンルは何ですか?」という質問と「サイエンス フィクション」という回答が含まれる場合があります。

この情報が元のトレーニング データに既に存在する場合、つまりナレッジ グラフの一部である場合、モデルは新しい情報を学習しません。動作の 1 つは、正解を出力することです。この種の微調整は「動作クローニング」とも呼ばれます。

しかし、問題は、「ハン・ソロのスピンオフ映画の名前は何ですか」という質問が微調整データセットに表示される場合です。

しかし、「ソロ」という答えが元のトレーニング データ セットの一部 (ナレッジ グラフの一部) にない場合、ネットワークは、たとえ答え。

実際には正しいがナレッジ グラフにない回答を微調整することで、ネットワークに回答を作成する、つまり「幻覚」を作成するように教えます。逆に、不正確な答えを使用してトレーニングすると、ネットワークは情報を保留します。

したがって、動作のクローン作成は理想的には常にネットワークの知識に基づいている必要がありますが、この知識は命令の調整など、データセットを作成または評価する人間の作業者には知られていないことがよくあります。

シュルマン氏によると、この問題は、Alpaca 式の場合のように、他のモデルが微調整されたデータセットを作成する場合にも存在します。

同氏は、ナレッジ グラフが小さい小規模なネットワークでは、ChatGPT の出力を使用して答えを出し、指示に従うことを学習するだけでなく、より頻繁に幻覚を見ることも学習するだろうと予測しました。

OpenAI はどのようにして幻覚と闘うのでしょうか?

まず、単純な質問の場合、言語モデルはほとんどの場合、答えがわかっているかどうかを予測でき、不確実性を表現することもできます。

したがって、シュルマン氏は、データセットを微調整する際、モデルは不確実性を表現する方法、前提が変更される状況、およびエラーが認識された場合の対処方法を学習する必要があると述べました。 。

これらの状況のインスタンスをモデルに供給して学習させる必要があります。

しかし、モデルはまだタイミングのトレーニングが不十分です。つまり、これらの操作をいつ実行すべきかがわかりません。

シュルマン氏は、ここで強化学習 (RL) が登場すると述べました。たとえば、ヒューマンフィードバックによる強化学習 (RLHF) です。

RL を適用すると、モデルは「動作境界」を学習し、いつどのような動作を実行するかを学習できます。

もう 1 つの困難は、出典を検索して引用する機能です。

問題は、動作と RLHF をコピーする機能があるにもかかわらず、なぜ ChatGPT は依然として幻覚を見せるのかということです。

#その理由は、問題自体の難しさにあります。

上記の方法は短い質問と回答にはうまく機能しますが、ChatGPT で一般的な長い形式の設定では別の問題が発生します。

一方で、完全に間違った答えが得られる可能性は低く、ほとんどの場合、間違っていることと正しいことが混在しています。

極端な場合には、コード 100 行の単なるエラーである可能性があります。

他の場合には、その情報は従来の意味では間違っていませんが、誤解を招くものです。したがって、ChatGPT のようなシステムでは、情報の内容や正確さの観点から出力の品質を測定することが困難です。

しかし、この測定は、複雑な動作境界をトレーニングするように設計された RL アルゴリズムにとって非常に重要です。

現在、OpenAI は RLHF のランキングベースの報酬モデルに依存しており、2 つの回答のうちどちらが優れているかを予測することはできますが、どちらが優れているかについて有効なシグナルを与えることはできません。 better. 答えがどれだけ優れているか、より有益か、または正しいか。

シュルマン氏は、細かい動作境界を学習するためにモデルにフィードバックを提供する機能が欠けていると述べた。そして、この種の細かい行動境界は、幻想を解決する可能性のある方法です。

さらに、このプロセスは、RLHF ラベル付けプロセスにおける人的ミスによってさらに複雑になります。

したがって、シュルマンは、RL を幻覚を軽減する重要な方法の 1 つであると考えていますが、まだ多くの未解決の問題があると考えています。

正しい行動を導くために上記の報酬モデルがどのようなものである必要があるかを除いて、RLHF は現在人間の判断のみに依存しています。

これにより、知識の生成がより困難になる可能性があります。なぜなら、将来についての予測は、説得力の低いプレゼンテーションにつながる場合があるからです。

しかし、シュルマンは、知識の生成が言語モデルの次の重要なステップであると同時に、未来の予測や推論規則の付与などの問題の理論的構築が次のタイプであると信じています。早急に解決する必要がある未解決の問題、性的な問題。

シュルマン氏によると、考えられる解決策の 1 つは、他の AI モデルを使用して言語モデルをトレーニングすることです。

OpenAI も、この手法は AI の調整にとって非常に有意義であると考えています。

ChatGPT アーキテクト

ChatGPT のアーキテクトである John Schulman は、まだ博士課程の勉強中だった 2015 年に共同創設者の 1 人として OpenAI に参加しました。

シュルマン氏はインタビューで、OpenAI に参加した理由を次のように説明しました。人工知能の研究では、OpenAI には野心的な使命があり、一般的な人工知能の構築に取り組んでいると思います。

当時、AGI について話すのは少しクレイジーに思えましたが、AGI について考え始めるのは当然だと思い、AGI について話すことが受け入れられる場所にいたいと思っていました。 。

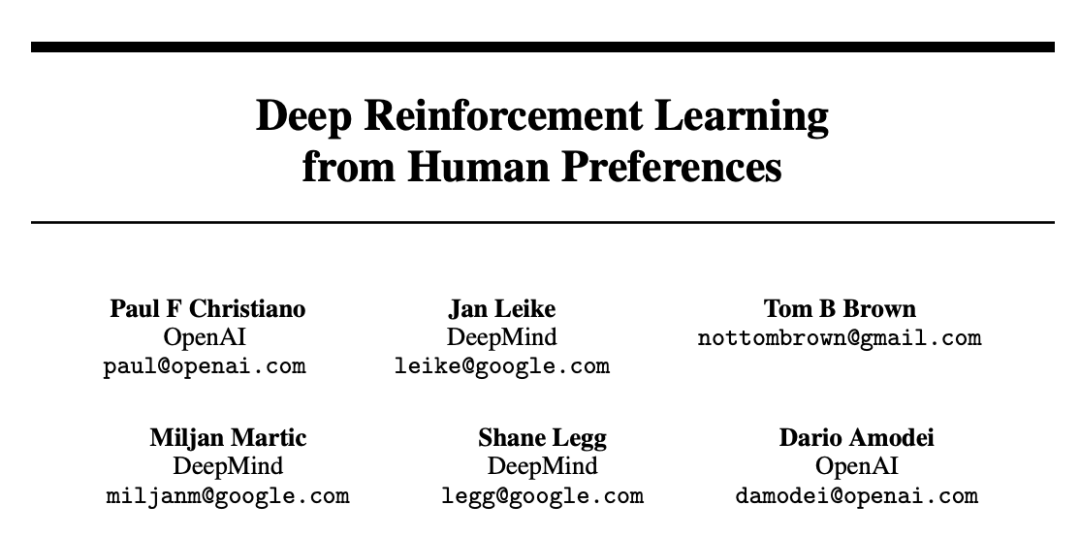

さらに、Schulman 氏によると、ChatGPT にヒューマン フィードバック強化学習 (RLHF) を導入するという OpenAI のアイデアは 17 年前まで遡ることができます。

当時、彼は OpenAI のメンバーでもあり、この手法について言及した論文「Deep Reinforcement Learning from Human Preferences」を発表しました。

論文アドレス: https://arxiv.org/pdf/1706.03741.pdf

##OpenAI セキュリティ チームがこれに取り組んでいるのは、モデルを人間の好みに合わせたいためです。つまり、モデルが実際に人間の声を聞き、人間がやりたいことを実行できるようにしようとしているのです。 GPT-3 がトレーニングを完了したとき、シュルマンは研究全体の方向性の可能性を認識し、このトレンドに参加することを決めました。

ChatGPT を初めて使用したときの最初の反応は何だったかを尋ねると、シュルマン氏の言葉は「何の感情もありませんでした」と明らかにしました。

ChatGPT が昨年登場し、多くの人々の脳が瞬時に爆発したことを今でも覚えています。

そして、OpenAI 社内では ChatGPT に興奮している人は誰もいません。リリースされた ChatGPT は GPT-3.5 をベースにした弱いモデルだったので、当時同僚は GPT-4 で遊んでいた。

つまり、当時、OpenAI の誰も ChatGPT に興奮していませんでした。なぜなら、すでにトレーニングされている、より強力で賢いモデルがあったからです。

シュルマン氏は、将来の人工知能の次のフロンティアについての見解について、AI はより困難なタスクを改善し続けているが、そこで人間は何をすべきかという疑問が生じると述べました。 do? 、人間が大きな影響力を持ち、大規模なモデルの助けを借りてより多くの作業を実行できるタスク。

以上が幻覚? Musk の TruthGPT もそれを処理できません。 OpenAIの共同創設者は「それは複雑だ」と語るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。