ホームページ >テクノロジー周辺機器 >AI >Nvidia の優位性の時代は終わったのでしょうか? ChatGPTはGoogleとMicrosoftの間でチップ戦争を引き起こし、Amazonもゲームに参加する

Nvidia の優位性の時代は終わったのでしょうか? ChatGPTはGoogleとMicrosoftの間でチップ戦争を引き起こし、Amazonもゲームに参加する

- 王林転載

- 2023-05-22 22:55:041266ブラウズ

ChatGPT が普及した後、Google と Microsoft という 2 つの巨人の間の AI 戦争は、新しいフィールド サーバー チップに焼きつきました。

現在、AI とクラウド コンピューティングが戦場となり、チップもコスト削減と企業顧客の獲得の鍵となっています。

元々、Amazon、Microsoft、Googleなどの大手企業はソフトウェアで有名でしたが、今ではチップの開発と生産に数十億ドルを費やしています。

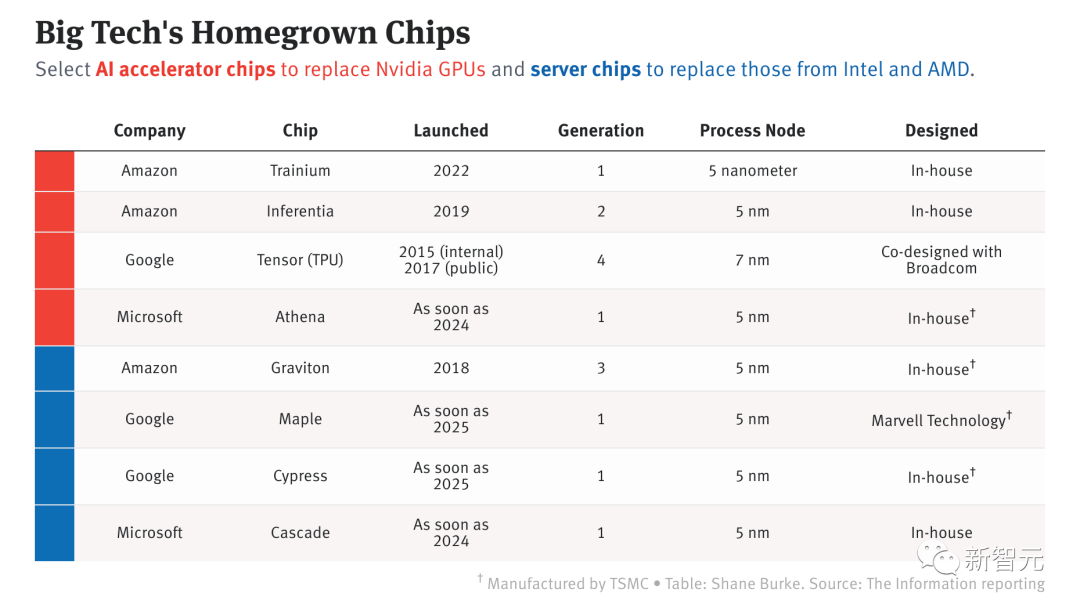

大手テクノロジー大手が開発したAIチップ

ChatGPTが爆発し、大手メーカーがチップ競争を開始

海外メディアThe Informationなどの報道によると、これらは大手メーカー 3 社 社内製品開発、クラウド サーバー レンタル、またはその両方のために、現在 8 台のサーバーと AI チップを立ち上げているか、立ち上げる予定です。

「AI に最適化されたシリコンを製造できれば、大きな勝利が待っています」と、調査会社 Forrester のディレクター、グレン・オドネル氏は言います。

これらの多大な努力は確実に報われますか?

答えは、必ずしもそうとは限りません。

Intel、AMD、Nvidia は規模の経済の恩恵を受けることができますが、大手テクノロジー企業の場合はそうではありません。

また、チップ設計者を雇用したり、カスタム チップを使用してアプリケーションを構築するよう開発者を説得したりするなど、多くの困難な課題にも直面しています。

しかし、大手メーカーはこの分野で目覚ましい進歩を遂げています。

公開されたパフォーマンスデータによると、Amazon の Graviton サーバーチップ、および Amazon と Google がリリースした AI 専用チップは、すでに従来のチップメーカーと性能が同等です。

Amazon、Microsoft、Google がデータセンター向けに開発したチップには、主に 2 種類あります。標準的なコンピューティング チップと、機械学習モデルのトレーニングと実行に使用される特殊なチップです。 ChatGPT のような大規模な言語モデルを強化するのは後者です。

以前、AppleはiPhone、iPad、Mac用のチップの開発に成功し、一部のAIタスクの処理を改善しました。これらの大手メーカーはAppleからインスピレーションを得たのかもしれない。

3大メーカーの中で、サーバーに2種類のチップを提供しているのはAmazonだけである。2015年に買収したイスラエルのチップ設計会社Annapurna Labsがこうした取り組みの基礎を築いた。

Google は 2015 年に AI ワークロード用のチップを発売し、Google Cloud のサーバー パフォーマンスを向上させる標準サーバー チップを開発しています。

対照的に、Microsoft のチップの研究開発は比較的遅く開始され、2019 年に発売されました。最近、Microsoft は LLM 専用に設計された AI チップの発売スケジュールを加速しました。

ChatGPT の人気により、世界中のユーザーの間で AI に対する興奮が高まりました。これにより、大手メーカー3社の戦略転換がさらに促進された。

ChatGPT は Microsoft の Azure クラウド上で実行され、数万台の Nvidia A100 を使用します。 ChatGPT と、Bing に統合されたその他の OpenAI ソフトウェアやさまざまなプログラムはどちらも非常に多くのコンピューティング能力を必要とするため、Microsoft は AI 開発を行う社内チームにサーバー ハードウェアを割り当てています。

Amazon では、最高財務責任者の Brian Olsavsky 氏が先週の決算会見で投資家に対し、ChatGPT をサポートするために必要なインフラストラクチャへの投資の一環として、支出を小売事業から AWS に移行する計画であると語った。

Google では、Tensor Processing Unit の構築を担当するエンジニアリング チームが Google Cloud に移動されました。報告によると、クラウド組織は現在、TPU とその上で実行されるソフトウェアのロードマップを開発できるようになり、クラウド顧客が TPU を搭載したサーバーをさらにレンタルできるようになることを期待しています。

Google: AI 向けに特別に調整された TPU V4

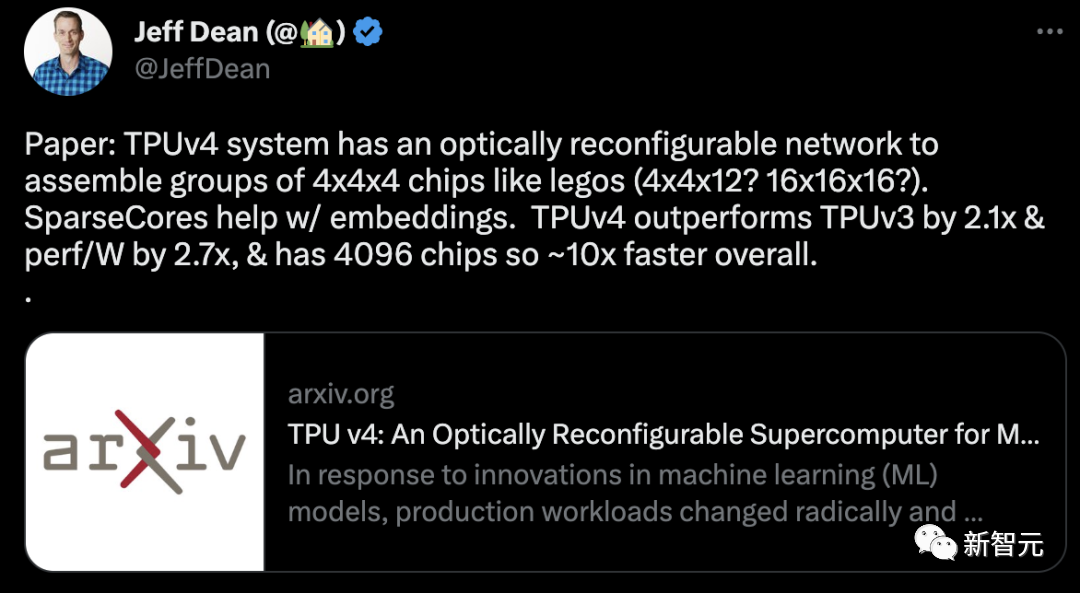

2020 年の初めに、Google は当時最も強力な AI チップである TPU v4 を自社のデータセンターに導入しました。

しかし、GoogleがこのAIスーパーコンピューターの技術的詳細を初めて発表したのは、今年の4月4日でした。

TPU v3と比較して、TPU v4のパフォーマンスは2.1倍高く、4096チップを統合した後、スーパーコンピューティングのパフォーマンスは10倍向上します。

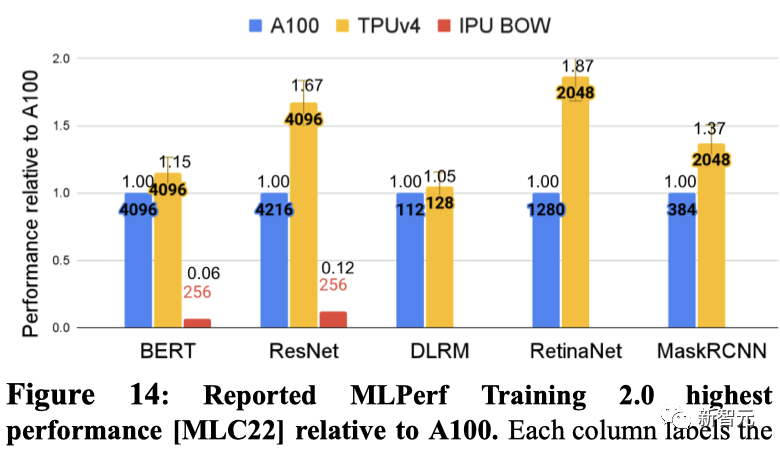

同時に、Googleは、自社のチップがNVIDIA A100よりも高速でエネルギー効率が高いとも主張しています。同等のサイズのシステムの場合、TPU v4 は NVIDIA A100 よりも 1.7 倍優れたパフォーマンスを提供し、エネルギー効率も 1.9 倍向上します。

同様のサイズのシステムの場合、TPU v4 は BERT 上で A100 より 1.15 倍、IPU より約 4.3 倍高速です。 ResNet の場合、TPU v4 はそれぞれ 1.67 倍、約 4.5 倍高速です。

これとは別に、Google は Nvidia H100 と競合する新しい TPU の開発に取り組んでいることを示唆しました。グーグルの研究者ジュッピ氏はロイターのインタビューで、グーグルには「将来のチップの生産ライン」があると述べた。

マイクロソフト: 秘密兵器アテナ

何があっても、マイクロソフトは依然としてこのチップ紛争に積極的に挑戦したいと考えています。

以前、Microsoftが秘密裏に結成した300人のチームが2019年に「Athena」と呼ばれるカスタムチップの開発を開始したというニュースが流れた。

当初の計画によれば、「Athena」はTSMCの5nmプロセスを使用して構築され、各チップのコストが1/3に削減されることが期待されています。

来年大規模に実装できれば、Microsoft の社内チームと OpenAI チームは「Athena」を使用してモデルのトレーニングと推論を同時に完了できるようになります。

このようにして、専用コンピューターの不足を大幅に軽減できます。

ブルームバーグは先週、マイクロソフトのチップ部門がAMDと協力してAthenaチップを開発したと報じ、これも木曜日にAMDの株価を6.5%上昇させた。

しかし、ある関係者によると、AMDは関与していないが、Nvidiaに対抗するために独自のGPUを開発しており、MicrosoftがこのGPUを購入すると見込まれているため、AMDはチップの設計についてMicrosoftと協議しているという。

Amazon: すでにリードを奪っている

Microsoft や Google とのチップ競争では、Amazon がリードを奪っているようです。

過去 10 年間、Amazon はより高度なテクノロジーと低価格を提供することで、クラウド コンピューティング サービスにおいて Microsoft や Google に対して競争上の優位性を維持してきました。

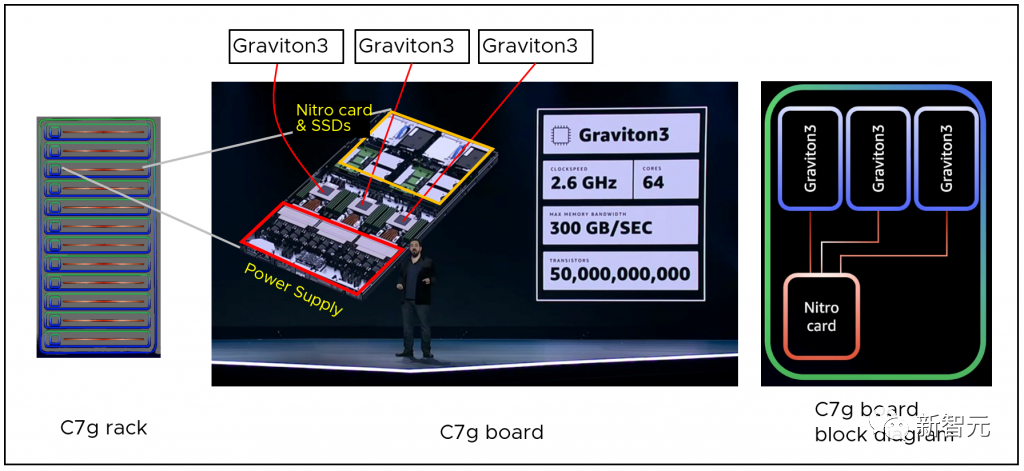

今後 10 年間、Amazon は自社開発のサーバーチップ Graviton を通じて競争での優位性を維持し続けると予想されています。

最新世代のプロセッサーである AWS Graviton3 は、前世代と比較してコンピューティングパフォーマンスが最大 25% 向上し、浮動小数点パフォーマンスが最大 2 倍向上します。また、DDR4 メモリと比較して帯域幅が 50% 増加する DDR5 メモリもサポートしています。

機械学習ワークロードの場合、AWS Graviton3 は前世代よりも最大 3 倍優れたパフォーマンスを提供し、bfloat16 をサポートします。

Graviton 3 チップをベースとしたクラウド サービスは、一部の地域で非常に人気があり、供給が需要を上回る状態にさえ達しています。

Amazon のもう 1 つの利点は、現在、サーバーに標準コンピューティング チップ (Graviton) と AI 固有のチップ (Inferentia および Trainium) を提供する唯一のクラウド プロバイダーであることです。

2019 年の初めに、Amazon は独自の AI 推論チップ Inferentia を発売しました。

これにより、お客様は画像認識、音声認識、自然言語処理、パーソナライゼーション、不正行為検出などの大規模な機械学習推論アプリケーションをクラウド上で低コストで実行できるようになります。

最新の Inferentia 2 では、コンピューティング パフォーマンスが 3 倍向上し、総アクセラレータ メモリが 4 倍に拡張され、スループットが 4 倍増加し、レイテンシーが 1/10 に減少しました。

オリジナルの Inferentia の発売後、Amazon は主に AI トレーニング用に設計されたカスタム チップ、Trainium をリリースしました。

画像分類、セマンティック検索、翻訳、音声認識、自然言語処理、推奨エンジンなどを含むディープラーニング トレーニング ワークロード向けに最適化されています。

場合によっては、チップのカスタマイズによりコストを一桁削減し、エネルギー消費を 1/10 に削減できるだけでなく、これらのカスタマイズされたソリューションにより、顧客に待ち時間の少ないより良いサービスを提供できます。 。

NVIDIA の独占を揺るがすのはそれほど簡単ではありません

しかし、これまでのところ、ほとんどの AI ワークロードは依然として GPU 上で実行されており、NVIDIA はほとんどのチップを製造しています。

以前のレポートによると、Nvidia の独立系 GPU 市場シェアは 80% に達し、ハイエンド GPU 市場シェアは 90% にも達します。

20 年間で、AI を実行する世界のクラウド コンピューティングとデータ センターの 80.6% が NVIDIA GPU によって駆動されてきました。 2021 年、Nvidia は、世界の上位 500 のスーパーコンピューターの約 70% が自社のチップで駆動されていると発表しました。

そして現在、ChatGPT を実行している Microsoft データセンターでも、数万個の NVIDIA A100 GPU を使用しています。

長い間、トップの ChatGPT であれ、Bard、Stable Diffusion などのモデルであれ、その背後には、それぞれ約 10,000 米ドル相当の NVIDIA A100 チップによって提供されるコンピューティング能力がありました。

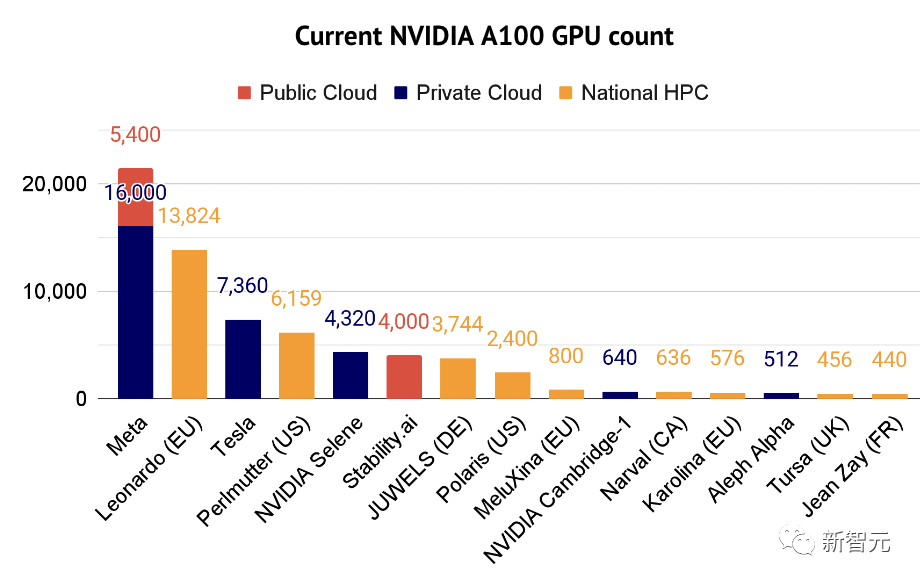

それだけでなく、A100 は今や人工知能の専門家にとっての「主力馬」となっています。 2022 年の人工知能の現状報告書には、A100 スーパーコンピューターを使用している企業の一部もリストされています。

Nvidiaが世界のコンピューティングパワーを独占し、独自のチップで世界を支配していることは明らかです。

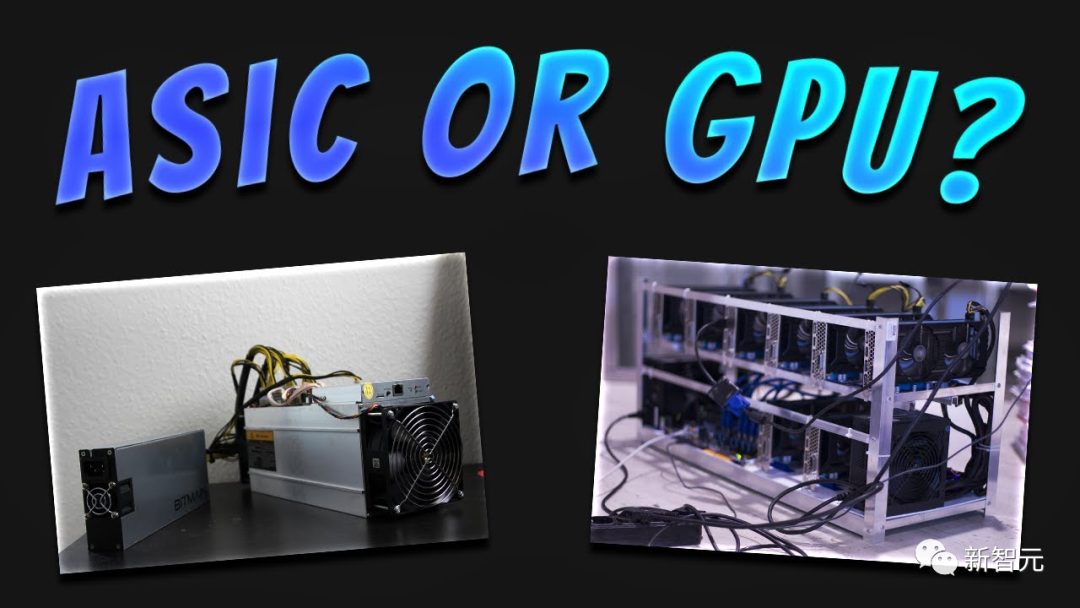

専門家によると、汎用チップと比較して、Amazon、Google、Microsoft が開発している特定用途向け集積回路 (ASIC) チップは、機械学習タスクをより高速に実行でき、消費電力も少なくなります。

ディレクターのオドネル氏は、GPU と ASIC を比較するときにこの比較を使用しました。「日常の運転にはプリウスを使用できますが、山中で四輪駆動を使用する必要がある場合は、ジープ ラングラーの方が適しています。」

しかし、あらゆる努力にもかかわらず、Amazon、Google、Microsoft はいずれも課題に直面しています。開発者にこれらの AI チップを使用するよう説得するにはどうすればよいでしょうか?

現在、NVIDIA の GPU が主流であり、開発者は GPU 駆動のアプリケーションを作成するための独自のプログラミング言語 CUDA にすでに慣れています。

Amazon、Google、または Microsoft のカスタム チップに切り替える場合、新しいソフトウェア言語を学習する必要があります。その意欲はありますか?

以上がNvidia の優位性の時代は終わったのでしょうか? ChatGPTはGoogleとMicrosoftの間でチップ戦争を引き起こし、Amazonもゲームに参加するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。