ChatGPT が普及してから、その使用方法は非常にたくさんあります。

これを人生のアドバイスを求めるために使用する人もいれば、単に検索エンジンとして使用する人も、論文を書くために使用する人もいます。

この論文は...書くのが楽しくありません。

米国の一部の大学は、学生が ChatGPT を使用して宿題を書くことを禁止し、また、学生が提出した論文が GPT によって生成されたかどうかを識別するためのソフトウェアを多数開発しました。

#ここで問題が発生しました。

誰かの論文はもともと下手に書かれていましたが、その文章を判定したAIはそれが同僚によって書かれたものだと判断しました。

さらに興味深いのは、中国人が書いた英語論文がAIによって生成されたものと判定される確率は61%にも上ることです。

非ネイティブスピーカーには価値がありませんか?

現在、生成言語モデルは急速に発展しており、実際にデジタル コミュニケーションに大きな進歩をもたらしています。しかし、虐待は本当にたくさんあります。

研究者たちは、AI と人間が生成したコンテンツを区別するために多くの検出方法を提案してきましたが、これらの検出方法の公平性と安定性はまだ改善の必要があります。

これを行うために、研究者らは、英語を母国語とする著者および英語を母国語としない著者によって書かれた作品を使用して、広く使用されているいくつかの GPT 検出器のパフォーマンスを評価しました。

研究結果によると、これらの検出器は、非ネイティブ スピーカーによって書かれたサンプルは AI によって生成されたものであると常に誤って判断されますが、ネイティブ スピーカーによって書かれたサンプルは基本的に正確に識別できます。

さらに、研究者らは、いくつかの簡単な戦略を使用してこのバイアスを軽減し、GPT 検出器を効果的にバイパスできることを実証しました。 ############これはどういう意味ですか?これは、GPT 検出器が言語スキルがあまり高くない著者を見下していることを示しており、非常に迷惑です。

AIが本物の人間かどうかを判定するあのゲームを思わずにはいられません、相手が本物の人間だけどAIだと推測した場合、システムは

複雑さが足りない = AI 世代?

研究者らは、中国の教育フォーラムから 91 件の TOEFL エッセイと、7 つの広く使用されている GPT 検出器を検出するためのヒューレット財団のデータセットからアメリカの 8 年生が書いた 88 件のエッセイを入手しました。

#グラフ内のパーセンテージは、「誤った判断」の割合を表しています。つまり、人間によって書かれたものですが、検出ソフトウェアは AI によって生成されたものであると考えます。

7 つの検出器の中で、米国の 8 年生が書いた作文で誤判定される確率が最も高いのはわずか 12% であり、誤判定がゼロの GPT が 2 つあります。

中国のフォーラムで TOEFL エッセイが誤判定される確率は半分以上で、最も高い誤判定確率は 76% に達することがあります。

91 件の TOEFL エッセイのうち 18 件は、7 つの GPT 検出器すべてによって AI によって生成されたと満場一致でみなされましたが、91 件のエッセイのうち 89 件は、少なくとも 1 つの GPT 検出器によって誤って生成されたと判断されました。

上の図から、7 つの GPT すべてで誤判定された TOEFL エッセイの複雑さは低いことがわかります (複雑さ)は他の論文に比べて大幅に低いです。

これは、冒頭の結論を裏付けるものです。GPT 検出器は、言語表現能力が限られた著者に対して一定の偏見を持ちます。

したがって、研究者らは、GPT 検出器は非母語話者によって書かれた記事をより多く読み取るべきであり、より多くのサンプルを使用することでのみバイアスを除去できると考えています。

次に、研究者らは、言語を豊かにし、ネイティブ スピーカーの単語使用習慣を模倣するために、非ネイティブ スピーカーが書いた TOEFL エッセイを ChatGPT に投入しました。

同時に、対照グループとして、アメリカの 8 年生の子供たちが書いた作文も ChatGPT に投入され、言語は非ネイティブの文章の特徴を模倣するように簡略化されました。スピーカー。下の写真は修正後の新たな判定結果です。

状況は劇的に変化し、言語を豊かにする TOEFL エッセイの誤判定率が急減したことがわかります。 、最低は 3%、最高は 19% です。以前の誤検知率とは異なり、基本的に半分以上でした。

それどころか、8 年生の子供たちが書いた作文の偽陽性率は急増しており、偽陽性率が 99% という高い GPT 検出器さえあります。基本的にすべてのエラー。

記事の複雑さの変数が変化したためです。

#研究者らは、非母語話者によって書かれたものは本物ではなく、複雑さが低く、誤解されやすいという結論に達しました。 。

これは技術的な問題にもつながりますが、価値の問題にもつながります。 AI と人間のどちらが作成者であるかを判断するために複雑さを利用することは、合理的で包括的かつ厳密です。

#結果は明らかにそうではありません。

複雑さを基準として使用すると、非母語話者は非母語話者であるという理由で大きな損失を被ることになります(ナンセンス)。

AI ポリッシュ = 人間が書いたもの? ?研究者らは、言語の多様性を高めることで、非母語話者に対する偏見を軽減できるだけでなく、GPT で生成されたコンテンツが GPT 検出器をバイパスできるようになると考えています。

この点を証明するために、研究者らは、2022年から2023年にアメリカの大学に申請された入学エッセイのトピックを選択し、ChatGPT-3.5に入力し、合計31の偽エッセイを生成しました。 。

GPT 検出器は最初は非常に効果的でしたが、2 回目では効果がありませんでした。これは、第 2 ラウンドで研究者がこれらの論文を ChatGPT に投入し、テキストの品質を向上させるために文学的な言語を使用して洗練したためです。

その結果、GPT 検出器の精度は 100% から 0% に低下しました。以下に示すように:

研究者らは、洗練された論文は誤判定されやすく、AI によって生成されたものであると改めて結論付けました。

GPT検出器?まだまだ練習不足です

要するに、総合的に見て、さまざまな GPT 検出器は依然として AI 生成とデータ間の関係を捉えることができていないようです。人間の文章、それらの最も本質的な違いです。

人々の文章も 3 つ、6 つ、または 9 つのレベルに分かれており、複雑さだけで判断するのはあまり合理的ではありません。

バイアス要因はさておき、テクノロジー自体にも改善が必要です。

以上がとんでもない!最新の研究: 中国人が書いた英語論文の 61% が ChatGPT 検出器によって AI によって生成されたものと判断されるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ai合并图层的快捷键是什么Jan 07, 2021 am 10:59 AM

ai合并图层的快捷键是什么Jan 07, 2021 am 10:59 AMai合并图层的快捷键是“Ctrl+Shift+E”,它的作用是把目前所有处在显示状态的图层合并,在隐藏状态的图层则不作变动。也可以选中要合并的图层,在菜单栏中依次点击“窗口”-“路径查找器”,点击“合并”按钮。

ai橡皮擦擦不掉东西怎么办Jan 13, 2021 am 10:23 AM

ai橡皮擦擦不掉东西怎么办Jan 13, 2021 am 10:23 AMai橡皮擦擦不掉东西是因为AI是矢量图软件,用橡皮擦不能擦位图的,其解决办法就是用蒙板工具以及钢笔勾好路径再建立蒙板即可实现擦掉东西。

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM虽然谷歌早在2020年,就在自家的数据中心上部署了当时最强的AI芯片——TPU v4。但直到今年的4月4日,谷歌才首次公布了这台AI超算的技术细节。论文地址:https://arxiv.org/abs/2304.01433相比于TPU v3,TPU v4的性能要高出2.1倍,而在整合4096个芯片之后,超算的性能更是提升了10倍。另外,谷歌还声称,自家芯片要比英伟达A100更快、更节能。与A100对打,速度快1.7倍论文中,谷歌表示,对于规模相当的系统,TPU v4可以提供比英伟达A100强1.

ai可以转成psd格式吗Feb 22, 2023 pm 05:56 PM

ai可以转成psd格式吗Feb 22, 2023 pm 05:56 PMai可以转成psd格式。转换方法:1、打开Adobe Illustrator软件,依次点击顶部菜单栏的“文件”-“打开”,选择所需的ai文件;2、点击右侧功能面板中的“图层”,点击三杠图标,在弹出的选项中选择“释放到图层(顺序)”;3、依次点击顶部菜单栏的“文件”-“导出”-“导出为”;4、在弹出的“导出”对话框中,将“保存类型”设置为“PSD格式”,点击“导出”即可;

ai顶部属性栏不见了怎么办Feb 22, 2023 pm 05:27 PM

ai顶部属性栏不见了怎么办Feb 22, 2023 pm 05:27 PMai顶部属性栏不见了的解决办法:1、开启Ai新建画布,进入绘图页面;2、在Ai顶部菜单栏中点击“窗口”;3、在系统弹出的窗口菜单页面中点击“控制”,然后开启“控制”窗口即可显示出属性栏。

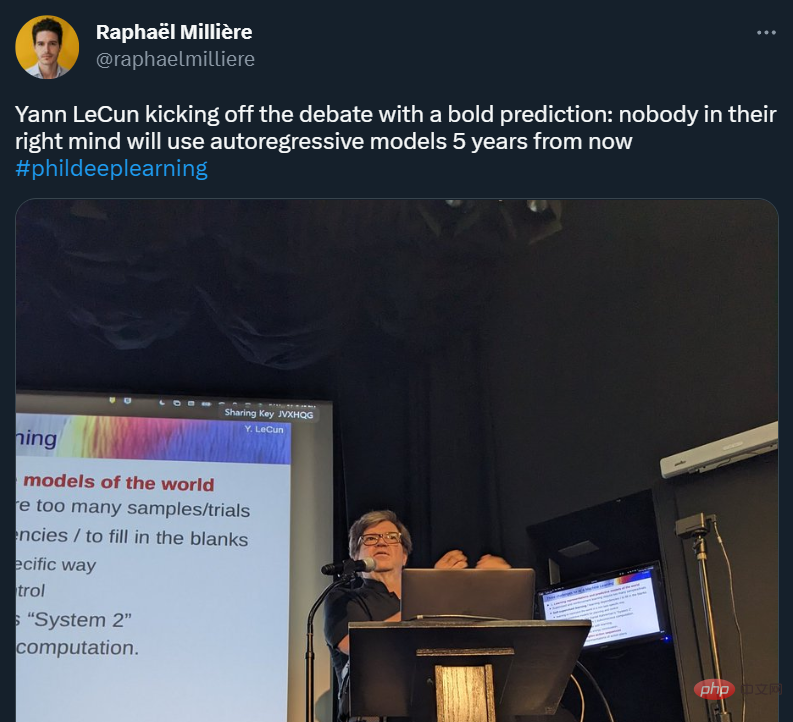

GPT-4的研究路径没有前途?Yann LeCun给自回归判了死刑Apr 04, 2023 am 11:55 AM

GPT-4的研究路径没有前途?Yann LeCun给自回归判了死刑Apr 04, 2023 am 11:55 AMYann LeCun 这个观点的确有些大胆。 「从现在起 5 年内,没有哪个头脑正常的人会使用自回归模型。」最近,图灵奖得主 Yann LeCun 给一场辩论做了个特别的开场。而他口中的自回归,正是当前爆红的 GPT 家族模型所依赖的学习范式。当然,被 Yann LeCun 指出问题的不只是自回归模型。在他看来,当前整个的机器学习领域都面临巨大挑战。这场辩论的主题为「Do large language models need sensory grounding for meaning and u

ai移动不了东西了怎么办Mar 07, 2023 am 10:03 AM

ai移动不了东西了怎么办Mar 07, 2023 am 10:03 AMai移动不了东西的解决办法:1、打开ai软件,打开空白文档;2、选择矩形工具,在文档中绘制矩形;3、点击选择工具,移动文档中的矩形;4、点击图层按钮,弹出图层面板对话框,解锁图层;5、点击选择工具,移动矩形即可。

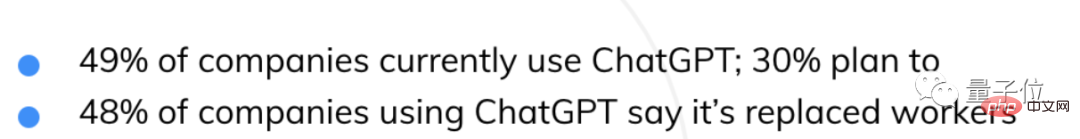

AI抢饭碗成真!近500家美国企业用ChatGPT取代员工,有公司省下超10万美元Apr 07, 2023 pm 02:57 PM

AI抢饭碗成真!近500家美国企业用ChatGPT取代员工,有公司省下超10万美元Apr 07, 2023 pm 02:57 PM自从ChatGPT掀起浪潮,不少人都在担心AI快要抢人类饭碗了。然鹅,现实可能更残酷QAQ......据就业服务平台Resume Builder调查统计,在1000多家受访美国企业中,用ChatGPT取代部分员工的,比例已达到惊人的48%。在这些企业中,有49%已经启用ChatGPT,还有30%正在赶来的路上。就连央视财经也为此专门发过一个报道:相关话题还曾一度冲上了知乎热榜,众网友表示,不得不承认,现在ChatGPT等AIGC工具已势不可挡——浪潮既来,不进则退。有程序员还指出:用过Copil

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

SublimeText3 中国語版

中国語版、とても使いやすい

WebStorm Mac版

便利なJavaScript開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

ホットトピック

7447

7447 15

15 1374

1374 52

52