はじめに

単語埋め込み表現は、機械翻訳、質問応答、テキスト分類などのさまざまな自然言語処理タスクの基礎です。通常、全体の 20% ~ 90% を占めます。モデルパラメータ。これらの埋め込みの保存とアクセスには大量のスペースが必要であり、リソースが限られているデバイス上でのモデルの展開やアプリケーションには適していません。この問題に対処するために、本記事では MorphTE 単語埋め込み圧縮方式 を提案します。 MorphTE は、テンソル積演算の強力な圧縮機能と言語形態学の事前知識を組み合わせて、モデルの精度を維持しながら単語埋め込みパラメータの高圧縮 ( 20 倍 以上) を実現します。パフォーマンス。

- 論文リンク: https://arxiv.org/abs/2210.15379

- オープン ソース コード: https://github.com/bigganbing/Fairseq_MorphTE

この記事MorphTE 単語埋め込み圧縮方法を提案します。まず単語を意味論的な意味を持つ最小単位である形態素に分割し、形態素ごとに低次元のベクトル表現をトレーニングし、次にテンソル積を使用して低次元の量子もつれ状態の数学的表現を実現します。形態素ベクトルを使用して、高次元の単語表現を取得します。

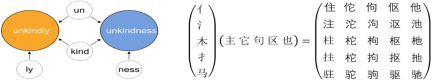

01 単語の形態素構成言語学において、形態素は特定の意味または文法機能を持つ最小単位です。英語などの言語の場合、単語は語根や接辞などのより小さな形態素単位に分割できます。たとえば、「unkindly」は、否定の「un」、「優しい」などの「kind」、副詞の「ly」に分解できます。中国語の場合、漢字を部首などの小さな単位に分割することもでき、たとえば「MU」を水を表す「氵」と「木」に分割することもできます。

02 もつれテンソルの形式での単語埋め込みの圧縮表現

##ここで

##ここで

#、r はランク、 n は次数、 はテンソル積を表します。 Word2ket は、これらの低次元ベクトルを保存して使用するだけで高次元のワード ベクトルを構築できるため、効果的なパラメータ削減が実現します。たとえば、r = 2、n = 3 の場合、次元 512 のワード ベクトルは、各グループの次元 8 の 3 つの低次元ベクトル テンソル積を 2 つのグループに分割することで得られます。パラメータの数が 512 から 48 に減少しました。 03 形態素強化テンソル化単語埋め込み圧縮表現

テンソル積を通じて、Word2ket は明白なパラメータ圧縮を実現できますが、高圧縮と機械翻訳の問題があります。より複雑なタスクの場合、圧縮する前に効果を実現することは通常困難です。低次元ベクトルはもつれテンソルを構成する基本単位であり、形態素は単語を構成する基本単位であるためです。この研究では、言語知識の導入を考慮し、低次元の形態素ベクトルを訓練し、単語に含まれる形態素ベクトルのテンソル積を使用して、対応する単語埋め込み表現を構築する MorphTE を提案します。

具体的には、まず形態素分割ツールを使用して単語リスト V 内の単語を分割します。すべての単語の形態素が形態素リスト M を形成し、形態素の数は単語の数よりも大幅に少なくなります。 ()。

各単語に対して、形態素テーブル内の各単語に含まれる形態素の位置を指す形態素インデックス ベクトルを構築します。すべての単語の形態素インデックス ベクトルは、 形態素インデックス行列を形成します。ここで、n は MorphTE の次数です。

形態素インデックス行列を形成します。ここで、n は MorphTE の次数です。

語彙内の j 番目の単語  については、その形態素インデックス ベクトル

については、その形態素インデックス ベクトル  を使用して、それをパラメータ化します。 r グループ 対応する形態素ベクトルは形態素埋め込み行列にインデックス付けされ、対応する単語埋め込みはテンソル積によるもつれテンソル表現によって取得されます。このプロセスは次のように形式化されます。

を使用して、それをパラメータ化します。 r グループ 対応する形態素ベクトルは形態素埋め込み行列にインデックス付けされ、対応する単語埋め込みはテンソル積によるもつれテンソル表現によって取得されます。このプロセスは次のように形式化されます。

この記事では主に、さまざまな言語での翻訳、質問と回答のタスクに関する実験を行い、関連する分解ベースの単語埋め込み圧縮方法と比較します。

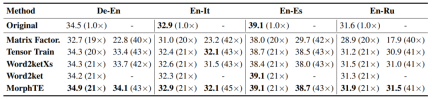

表からわかるように、MorphTE は英語、ドイツ語、イタリア語などのさまざまな言語に適応できます。 MorphTE は 20 倍を超える圧縮率で元のモデルの効果を維持できますが、他のほとんどすべての圧縮方法では効果が低下します。さらに、MorphTE は、40 倍を超える圧縮率で、さまざまなデータ セットに対して他の圧縮方法よりも優れたパフォーマンスを発揮します。

同様に、MorphTE は、WikiQA の質問と回答のタスクと SNLI の自然言語推論タスクで、それぞれ 81 倍と 38 倍の圧縮率を達成しました。モデルの効果を維持します。

MorphTE は、先験的な形態素言語の知識とテンソル積の強力な圧縮機能を組み合わせて、単語埋め込みの高品質な圧縮を実現します。さまざまな言語とタスクの実験では、MorphTE がモデルの効果を損なうことなく、単語埋め込みパラメータの 20 ~ 80 倍の圧縮を達成できることが示されています。これは、形態素ベースの言語知識の導入により、単語埋め込みの圧縮表現の学習が向上できることを証明します。 MorphTE は現在、形態素のみをモデル化していますが、実際には、プロトタイプ、品詞、大文字化などのよりアプリオリな言語知識を明示的にモデル化する一般的な単語埋め込み圧縮拡張フレームワークに拡張して、単語埋め込み圧縮をさらに改善することができます。

以上が単語の埋め込みが表すパラメータの割合が大きすぎますか? MorphTE方式 損失のない20倍の圧縮効果の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

LLMSでのツール呼び出しApr 14, 2025 am 11:28 AM

LLMSでのツール呼び出しApr 14, 2025 am 11:28 AM大規模な言語モデル(LLM)は人気が急増しており、ツールコール機能は単純なテキスト生成を超えて機能を劇的に拡大しています。 これで、LLMSは動的なUI作成や自律的なaなどの複雑な自動化タスクを処理できます。

ADHDゲーム、ヘルスツール、AIチャットボットがグローバルヘルスを変える方法Apr 14, 2025 am 11:27 AM

ADHDゲーム、ヘルスツール、AIチャットボットがグローバルヘルスを変える方法Apr 14, 2025 am 11:27 AMビデオゲームは不安を緩和したり、ADHDの子供を焦点を合わせたり、サポートしたりできますか? ヘルスケアの課題が世界的に急増しているため、特に若者の間では、イノベーターはありそうもないツールであるビデオゲームに目を向けています。現在、世界最大のエンターテイメントインダスの1つです

AIに関する国連入力:勝者、敗者、および機会Apr 14, 2025 am 11:25 AM

AIに関する国連入力:勝者、敗者、および機会Apr 14, 2025 am 11:25 AM「歴史は、技術の進歩が経済成長を促進する一方で、それ自体が公平な所得分布を確保したり、包括的な人間開発を促進したりしないことを示しています」とUNCTADの事務総長であるRebeca Grynspanは前文で書いています。

生成AIを介した交渉スキルを学ぶApr 14, 2025 am 11:23 AM

生成AIを介した交渉スキルを学ぶApr 14, 2025 am 11:23 AM簡単な、Generative AIを交渉の家庭教師およびスパーリングパートナーとして使用してください。 それについて話しましょう。 革新的なAIブレークスルーのこの分析は、最新のAIに関する私の進行中のフォーブス列のカバレッジの一部であり、特定と説明を含む

テッドは、Openai、Google、Metaが法廷に向かい、自分自身とセルフィーから明らかにしますApr 14, 2025 am 11:22 AM

テッドは、Openai、Google、Metaが法廷に向かい、自分自身とセルフィーから明らかにしますApr 14, 2025 am 11:22 AMバンクーバーで開催されたTED2025会議は、昨日4月11日の第36版を締めくくりました。サム・アルトマン、エリック・シュミット、パーマー・ラッキーを含む60か国以上の80人の講演者が登場しました。テッドのテーマ「人類が再考された」は、仕立てられたものでした

ジョセフ・スティグリッツは、AI独占権の中で迫り来る不平等を警告しているApr 14, 2025 am 11:21 AM

ジョセフ・スティグリッツは、AI独占権の中で迫り来る不平等を警告しているApr 14, 2025 am 11:21 AMジョセフ・スティグリッツは、2001年にノーベル経済賞を受賞した経済学者であり、2001年にノーベル経済賞を受賞しています。スティグリッツは、AIが既存の不平等を悪化させ、いくつかの支配的な企業の手に統合した力を悪化させ、最終的に経済を損なうと仮定しています。

グラフデータベースとは何ですか?Apr 14, 2025 am 11:19 AM

グラフデータベースとは何ですか?Apr 14, 2025 am 11:19 AMグラフデータベース:関係を通じてデータ管理に革命をもたらす データが拡大し、その特性がさまざまなフィールドで進化するにつれて、グラフデータベースは、相互接続されたデータを管理するための変換ソリューションとして浮上しています。伝統とは異なり

LLMルーティング:戦略、テクニック、およびPythonの実装Apr 14, 2025 am 11:14 AM

LLMルーティング:戦略、テクニック、およびPythonの実装Apr 14, 2025 am 11:14 AM大規模な言語モデル(LLM)ルーティング:インテリジェントタスク分布によるパフォーマンスの最適 LLMSの急速に進化する風景は、それぞれが独自の長所と短所を備えた多様なモデルを提供します。 創造的なコンテンツGenに優れている人もいます

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境