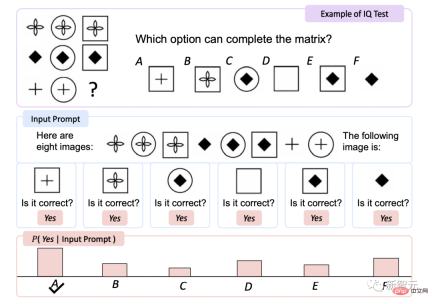

100 年前のミームも明確です。 Microsoft のマルチモーダル「Universe」は、わずか 16 億のパラメータで IQ テストを処理します

寝ないと大きなモデルのボリュームについていけません...

いいえ、マイクロソフト アジア同研究所は、マルチモーダル大規模言語モデル (MLLM) - KOSMOS-1 をリリースしました。

#論文アドレス: https://arxiv.org/pdf/2302.14045.pdf

学位論文のタイトル「必要なのは言語だけではない」は、有名な格言から来ています。

#記事の中に「私の言語の限界は、私の世界の限界である。 - オーストリアの哲学者ルートヴィヒ・ウィトゲンシュタイン」という一文があります。

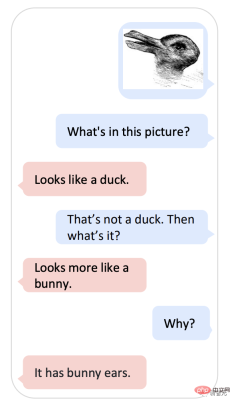

写真を持ってKOSMOS-1に「アヒルですかウサギですか?」と尋ねるとわかりますか? 100年以上の歴史を持つこのミームは、Google AIを修正することはできません。

#KOSMOS-1 では、この種の知覚モデルと言語モデルを組み合わせることができます。

#-写真には何が写っていますか?

#-アヒルのように。

#-アヒルでないとしたら、それは何ですか?

#-ウサギに似ています。 ##################-なぜ?

#-ウサギの耳が付いています。

#この質問をすると、KOSMOS-1 は実際には Microsoft 版の ChatGPT に少し似ています。

それだけでなく、Kosmos-1 は画像、テキスト、およびテキストを理解することもできます。テキスト、画像、OCR、画像キャプション、ビジュアル QA。

「宇宙」は全能です

コスモスの語源は、ギリシャ語で「宇宙」を意味するコスモスです。

#論文によると、最新の Kosmos-1 モデルはマルチモーダルな大規模言語モデルです。

バックボーンは、Transformer に基づく因果言語モデルであり、テキストに加えて、視覚や音声などの他のモダリティをモデルに埋め込むことができます。

Transformer デコーダは、マルチモーダル入力のユニバーサル インターフェイスとして機能するため、一般的なモダリティを認識し、コンテキスト学習を実行し、指示に従うことができます。

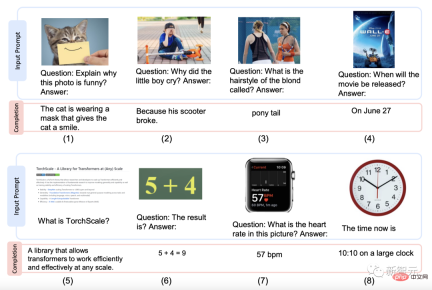

Kosmos-1 は、テキスト指示による画像認識、視覚的な質問応答、マルチモーダル対話など、言語およびマルチモーダル タスクにおいて、微調整なしで優れたパフォーマンスを実現します。 #以下は、Kosmos-1 によって生成されたスタイルの例です。 絵の説明、絵の質問と回答、ウェブページの質問の答え、簡単な数式、数字の認識。

では、Kosmos-1 はどのデータセットで事前トレーニングされているのでしょうか?

トレーニングに使用されるデータベースには、テキスト コーパス、画像と字幕のペア、画像とテキストのクロス データ セットが含まれます。

The Pile and Common Crawl (CC) から取得したテキスト コーパス;

画像- 字幕ペアのソースは英語の LAION-2B、LAION-400M、COYO-700M および概念キャプションです;

テキスト クロス データ セットのソースは共通ですクロールのスナップショット。

#データベースが利用できるようになったので、次のステップはモデルを事前トレーニングすることです。

MLLM コンポーネントには 24 のレイヤー、2,048 の隠れ次元、8,192 の FFN、および 32 のアテンション ヘッドがあり、約 1.3B のパラメーターになります。

最適化の安定性を確保するために、Magneto 初期化が使用されます。より速く収束するために、画像表現は事前トレーニングされた画像から導出されます。 1024 フィーチャ寸法、CLIP ViT-L/14 モデルから取得。トレーニング プロセス中、画像は 224×224 の解像度に前処理され、CLIP モデルのパラメーターは最後のレイヤーを除いてフリーズされます。

#KOSMOS-1 のパラメータの総数は約 16 億個です。

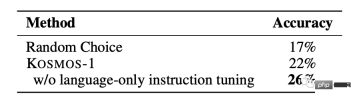

KOSMOS-1 を命令とより適切に調整するために、言語のみの命令の調整が行われました [LHV 23、HSLS22]。つまり、モデルは命令に基づいてトレーニングされ続けます。唯一の言語データであるデータがトレーニング コーパスと混合されます。

#チューニングプロセスは言語モデリング手法に従って実行され、選択された命令データセットは Unnatural 命令 [HSLS22] と FLANv2 [LHV 23] です。

#結果は、コマンド追従能力の向上がモード間で移行できることを示しています。

#つまり、MLLM は、言語からマルチモーダリティへ、またはその逆に知識を伝達する、クロスモーダル伝達の恩恵を受けることができます。5 つのカテゴリに分かれた 10 個のタスク、すべてが判明

モデルが使いやすいかどうかは、取り出して試してみるだけでわかります。

#研究チームは、KOSMOS-1 のパフォーマンスを評価するために、5 つのカテゴリの 10 のタスクを含む、さまざまな角度から実験を実施しました。#1 言語タスク (言語理解、言語生成、OCR を使用しないテキスト分類)

2 マルチモーダル転送 (共通)感覚推論)

3 非言語推論 (IQ テスト)

4 知覚 - 言語タスク (画像の説明、ビジュアル Q&A、Web Q&A)

5 ビジョン タスク (ゼロショット画像分類、説明付きゼロショット画像分類)

OCR なしテキストの分類

#これは、光学式文字認識 (OCR) に依存しない、テキストと画像に焦点を当てた理解タスクです。

HatefulMemes およびレンダリングされた SST-2 テスト セットにおける KOSMOS-1 の精度は、他のモデルよりも高くなります。

Flamingo はプロンプトに OCR テキストを明示的に提供しますが、KOSMOS-1 は外部ツールやリソースにアクセスしません。これは、KOSMOS-1 がテキストを読み取って理解していることを示しています。レンダリング 画像内のテキストに固有の機能。

#IQ テスト

Raven 知能テストは評価です非言語の最も一般的に使用されるテストの 1 つ。

KOSMOS-1 は、微調整を行わないランダム選択と比較して精度が 5.3% 向上します。微調整後は 9.3% 増加し、非言語環境における抽象的な概念パターンを認識する能力を示しています。

モデルがゼロショット Raven テストを完了できたのはこれが初めてであり、ゼロショット非言語推論に対する MLLM の可能性が示されています。知覚モデルと言語モデルを組み合わせることによって。

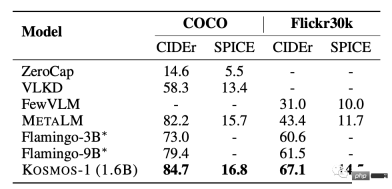

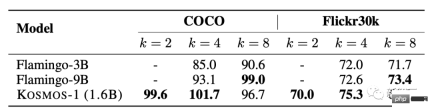

画像説明 ##KOSMOS-1 は、COCO テストと Flickr30k テストの両方で優れたゼロサンプル パフォーマンスを示し、他のモデルと比較してスコアは高くなりますが、使用するパラメーターの数は少なくなります。

#少数サンプルのパフォーマンス テストでは、k 値が増加するにつれてスコアも増加します。

#少数サンプルのパフォーマンス テストでは、k 値が増加するにつれてスコアも増加します。

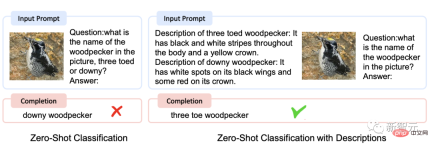

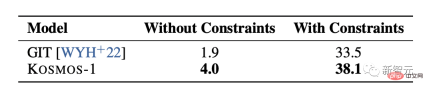

ゼロショット画像分類

ゼロショット画像分類

#入力画像を指定して、その画像を「The photo of the」というプロンプトに接続します。次に、モデルにフィードして画像のクラス名を取得します。

# ImageNet [DDS 09] でモデルを評価することにより、制約ありと制約なしの両方で実行できます。制約された条件下では、KOSMOS-1 の画像分類効果は GIT [WYH 22] よりも大幅に優れており、視覚タスクを完了する強力な能力を示しています。

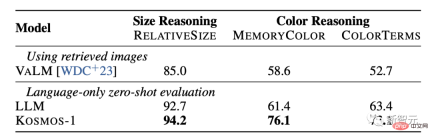

常識的な推論

視覚的常識推論タスクでは、色、サイズ、形状など、現実世界の日常的なオブジェクトの特性をモデルが理解する必要があります。これらのタスクは、オブジェクトに関するより多くの情報が必要になる場合があるため、困難です。テキスト内。オブジェクトのプロパティに関する情報。

結果は、KOSMOS-1 の推論能力がサイズと色の点で LLM モデルよりも大幅に優れていることを示しています。これは主に、KOSMOS-1 がマルチモーダル転送機能を備えており、LLM のようにテキストの知識や推論の手がかりに依存することなく、視覚的な知識を言語タスクに適用できるためです。

##Microsoft Kosmos-1 について、ネチズンは Dao を賞賛しました今後 5 年以内に、高度なロボットが Web を閲覧し、視覚的な手段のみを介して人間が入力したテキストに基づいて動作するようになるでしょう。とても興味深い時代です。

以上が100 年前のミームも明確です。 Microsoft のマルチモーダル「Universe」は、わずか 16 億のパラメータで IQ テストを処理しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

Gemma Scope:AI'の思考プロセスを覗くためのGoogle'の顕微鏡Apr 17, 2025 am 11:55 AM

Gemma Scope:AI'の思考プロセスを覗くためのGoogle'の顕微鏡Apr 17, 2025 am 11:55 AMジェマの範囲で言語モデルの内部の仕組みを探る AI言語モデルの複雑さを理解することは、重要な課題です。 包括的なツールキットであるGemma ScopeのGoogleのリリースは、研究者に掘り下げる強力な方法を提供します

ビジネスインテリジェンスアナリストは誰で、どのようになるか?Apr 17, 2025 am 11:44 AM

ビジネスインテリジェンスアナリストは誰で、どのようになるか?Apr 17, 2025 am 11:44 AMビジネスの成功のロック解除:ビジネスインテリジェンスアナリストになるためのガイド 生データを組織の成長を促進する実用的な洞察に変換することを想像してください。 これはビジネスインテリジェンス(BI)アナリストの力です - GUにおける重要な役割

SQLに列を追加する方法は? - 分析VidhyaApr 17, 2025 am 11:43 AM

SQLに列を追加する方法は? - 分析VidhyaApr 17, 2025 am 11:43 AMSQLの変更テーブルステートメント:データベースに列を動的に追加する データ管理では、SQLの適応性が重要です。 その場でデータベース構造を調整する必要がありますか? Alter Tableステートメントはあなたの解決策です。このガイドの詳細は、コルを追加します

ビジネスアナリストとデータアナリストApr 17, 2025 am 11:38 AM

ビジネスアナリストとデータアナリストApr 17, 2025 am 11:38 AM導入 2人の専門家が重要なプロジェクトで協力している賑やかなオフィスを想像してください。 ビジネスアナリストは、会社の目標に焦点を当て、改善の分野を特定し、市場動向との戦略的整合を確保しています。 シム

ExcelのCountとCountaとは何ですか? - 分析VidhyaApr 17, 2025 am 11:34 AM

ExcelのCountとCountaとは何ですか? - 分析VidhyaApr 17, 2025 am 11:34 AMExcelデータカウントと分析:カウントとカウントの機能の詳細な説明 特に大規模なデータセットを使用する場合、Excelでは、正確なデータカウントと分析が重要です。 Excelは、これを達成するためにさまざまな機能を提供し、CountおよびCounta関数は、さまざまな条件下でセルの数をカウントするための重要なツールです。両方の機能はセルをカウントするために使用されますが、設計ターゲットは異なるデータ型をターゲットにしています。 CountおよびCounta機能の特定の詳細を掘り下げ、独自の機能と違いを強調し、データ分析に適用する方法を学びましょう。 キーポイントの概要 カウントとcouを理解します

ChromeはAIと一緒にここにいます:毎日何か新しいことを体験してください!!Apr 17, 2025 am 11:29 AM

ChromeはAIと一緒にここにいます:毎日何か新しいことを体験してください!!Apr 17, 2025 am 11:29 AMGoogle Chrome'sAI Revolution:パーソナライズされた効率的なブラウジングエクスペリエンス 人工知能(AI)は私たちの日常生活を急速に変換しており、Google ChromeはWebブラウジングアリーナで料金をリードしています。 この記事では、興奮を探ります

ai' s Human Side:Wellbeing and the Quadruple bottuntApr 17, 2025 am 11:28 AM

ai' s Human Side:Wellbeing and the Quadruple bottuntApr 17, 2025 am 11:28 AMインパクトの再考:四重材のボトムライン 長い間、会話はAIの影響の狭い見方に支配されており、主に利益の最終ラインに焦点を当てています。ただし、より全体的なアプローチは、BUの相互接続性を認識しています

5ゲームを変える量子コンピューティングの使用ケースあなたが知っておくべきであるApr 17, 2025 am 11:24 AM

5ゲームを変える量子コンピューティングの使用ケースあなたが知っておくべきであるApr 17, 2025 am 11:24 AM物事はその点に向かって着実に動いています。量子サービスプロバイダーとスタートアップに投資する投資は、業界がその重要性を理解していることを示しています。そして、その価値を示すために、現実世界のユースケースの数が増えています

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

MantisBT

Mantis は、製品の欠陥追跡を支援するために設計された、導入が簡単な Web ベースの欠陥追跡ツールです。 PHP、MySQL、Web サーバーが必要です。デモおよびホスティング サービスをチェックしてください。

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

Dreamweaver Mac版

ビジュアル Web 開発ツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。