ChatGPT には「ヒューマン フィードバック強化学習 (RLHF)」と呼ばれる核となるトレーニング方法があります。

これにより、モデルがより安全になり、出力結果が人間の意図とより一致するようになります。

Google Research と UC Berkeley の研究者らは、AI ペイントでこの方法を使用すると、画像が入力と完全に一致しない状況を「処理」でき、その効果も驚くほど良好であることを発見しました—

最大 47% の改善が達成できます。

△左が安定拡散、右が改善効果

現時点では、AIGC分野で人気の2つのモデルが見つかったようですある種の「共鳴」。

AI ペイントに RLHF を使用するにはどうすればよいですか?

RLHF、正式名は「Reinforcement Learning from Human Feedback」で、2017 年に OpenAI と DeepMind が共同開発した強化学習テクノロジーです。

名前が示すように、RLHF はモデルの出力結果 (つまりフィードバック) を人間が評価してモデルを直接最適化します。LLM では、「モデルの値」を人間の値とより一致させることができます。

AI 画像生成モデルでは、生成された画像をテキスト プロンプトと完全に一致させることができます。

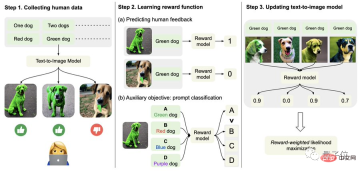

具体的には、まず人間のフィードバックデータを収集します。

ここで、研究者らは合計 27,000 を超える「テキストと画像のペア」を生成し、何人かの人間にそれらを採点するように依頼しました。

わかりやすくするために、テキスト プロンプトには、量、色、背景、ブレンド オプションに関連する次の 4 つのカテゴリのみが含まれます。人間のフィードバックは、「良い」、「悪い」、「しない」の 3 つのみに分類されます。知っています(スキップ)" "。

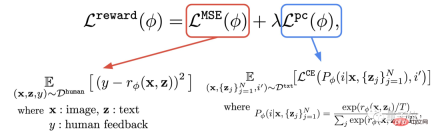

2 番目に、報酬関数を学習します。

このステップでは、取得した人間の評価で構成されるデータセットを使用して報酬関数をトレーニングし、この関数を使用してモデルの出力に対する人間の満足度を予測します (式の赤い部分)。

このようにして、モデルは結果がテキストとどの程度一致するかを認識します。

#報酬関数に加えて、著者は補助タスク (式の青い部分) も提案しています。

つまり、画像生成が完了した後、モデルは大量のテキストを提供しますが、元のテキストはそのうちの 1 つだけであり、画像が一致するかどうかを報酬モデルに「自らチェック」させます。文章。

この逆の操作により、効果を「二重の保険」にすることができます (下図のステップ 2 を理解するのに役立ちます)。

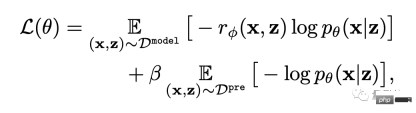

最後に、微調整です。

つまり、テキスト画像生成モデルは、報酬重み付け尤度最大化 (以下の式の最初の項目) を通じて更新されます。

#過学習を避けるために、作成者はトレーニング前のデータセットの NLL 値 (式の第 2 項) を最小化しました。このアプローチは、structGPT (ChatGPT の「直接の前身」) に似ています。

エフェクトは 47% 増加しましたが、明瞭度は 5% 低下しました。

次の一連のエフェクトに示すように、元の安定した拡散と比較して、RLHF で微調整されたモデルは、 :

(1) テキスト内の「two」と「green」をより正確に理解します;

(2) ではありません「海」を無視する 背景要件として;

(3) 赤いタイガーが必要な場合は、「より赤い」結果が得られます。

具体的なデータから判断すると、微調整モデルの人間の満足度は 50% で、元のモデル (3%) と比較して 47% 向上しています。

ただし、その代償として画像の鮮明さが 5% 失われます。

下の写真からも、右側のオオカミが左側のオオカミよりも明らかにぼやけていることがわかります。

はい したがって、著者らは、より大規模な人による評価データセットとより優れた最適化 (RL) 手法を使用することで状況を改善できる可能性があると示唆しています。

著者について

この記事の著者は合計 9 名です。

韓国科学技術研究院の Google AI 研究科学者 Kimin Lee 博士は、カリフォルニア大学バークレー校で博士研究員として研究を実施しました。

中国人著者は 3 人です:

Liu Hao カリフォルニア大学バークレー校の博士課程の学生で、主な研究対象はフィードバック ニューラルです。ネットワーク。

Du Yuqing はカリフォルニア大学バークレー校の博士課程候補者で、主な研究方向は教師なし強化学習法です。

責任著者のShixiang Shane Gu (Gu Shixiang) は、学部の学位を三大巨人の一人であるヒントンに師事し、ケンブリッジ大学を卒業して博士号を取得しました。

△Gu Shixiang

この記事を書いているとき、彼はまだ Google 社員でしたが、現在は OpenAI に転職しました。 ChatGPT担当者からの報告に直属します。

論文アドレス:

https://arxiv.org/abs/2302.12192

参考リンク: [1] https://www.php .cn/link/4d42d2f5010c1c13f23492a35645d6a7

[2] https://openai.com/blog/instruction-following/

以上がChatGPT のコアメソッドを AI ペイントに使用でき、効果が 47% 向上 担当著者: OpenAI に切り替えましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

迅速なエンジニアリングにおける思考のグラフは何ですかApr 13, 2025 am 11:53 AM

迅速なエンジニアリングにおける思考のグラフは何ですかApr 13, 2025 am 11:53 AM導入 迅速なエンジニアリングでは、「思考のグラフ」とは、グラフ理論を使用してAIの推論プロセスを構造化および導く新しいアプローチを指します。しばしば線形sを含む従来の方法とは異なります

Genaiエージェントとの電子メールマーケティングを組織に最適化しますApr 13, 2025 am 11:44 AM

Genaiエージェントとの電子メールマーケティングを組織に最適化しますApr 13, 2025 am 11:44 AM導入 おめでとう!あなたは成功したビジネスを運営しています。ウェブページ、ソーシャルメディアキャンペーン、ウェビナー、会議、無料リソース、その他のソースを通じて、毎日5000の電子メールIDを収集します。次の明白なステップはです

Apache Pinotによるリアルタイムアプリのパフォーマンス監視Apr 13, 2025 am 11:40 AM

Apache Pinotによるリアルタイムアプリのパフォーマンス監視Apr 13, 2025 am 11:40 AM導入 今日のペースの速いソフトウェア開発環境では、最適なアプリケーションパフォーマンスが重要です。応答時間、エラーレート、リソース利用などのリアルタイムメトリックを監視することで、メインに役立ちます

ChatGptは10億人のユーザーにヒットしますか? 「わずか数週間で2倍になりました」とOpenai CEOは言いますApr 13, 2025 am 11:23 AM

ChatGptは10億人のユーザーにヒットしますか? 「わずか数週間で2倍になりました」とOpenai CEOは言いますApr 13, 2025 am 11:23 AM「ユーザーは何人いますか?」彼は突き出した。 「私たちが最後に言ったのは毎週5億人のアクティブであり、非常に急速に成長していると思います」とアルトマンは答えました。 「わずか数週間で2倍になったと言った」とアンダーソンは続けた。 「私はそのprivと言いました

PIXTRAL -12B:Mistral AI'の最初のマルチモーダルモデル-Analytics VidhyaApr 13, 2025 am 11:20 AM

PIXTRAL -12B:Mistral AI'の最初のマルチモーダルモデル-Analytics VidhyaApr 13, 2025 am 11:20 AM導入 Mistralは、最初のマルチモーダルモデル、つまりPixtral-12B-2409をリリースしました。このモデルは、Mistralの120億個のパラメーターであるNemo 12bに基づいて構築されています。このモデルを際立たせるものは何ですか?これで、画像とTexの両方を採用できます

生成AIアプリケーションのエージェントフレームワーク - 分析VidhyaApr 13, 2025 am 11:13 AM

生成AIアプリケーションのエージェントフレームワーク - 分析VidhyaApr 13, 2025 am 11:13 AMクエリに応答するだけでなく、情報を自律的に収集し、タスクを実行し、テキスト、画像、コードなどの複数のタイプのデータを処理するAIを搭載したアシスタントがいることを想像してください。未来的に聞こえますか?これでa

金融セクターにおける生成AIの応用Apr 13, 2025 am 11:12 AM

金融セクターにおける生成AIの応用Apr 13, 2025 am 11:12 AM導入 金融業界は、効率的な取引と信用の可用性を促進することにより経済成長を促進するため、あらゆる国の発展の基礎となっています。取引の容易さとクレジット

オンライン学習とパッシブアグレッシブアルゴリズムのガイドApr 13, 2025 am 11:09 AM

オンライン学習とパッシブアグレッシブアルゴリズムのガイドApr 13, 2025 am 11:09 AM導入 データは、ソーシャルメディア、金融取引、eコマースプラットフォームなどのソースから前例のないレートで生成されています。この連続的な情報ストリームを処理することは課題ですが、

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

SublimeText3 中国語版

中国語版、とても使いやすい

WebStorm Mac版

便利なJavaScript開発ツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター