ホームページ >テクノロジー周辺機器 >AI >MLC LLM: オフライン操作をサポートし、グラフィックス カードが統合されたコンピューターおよび iPhone に適したオープンソース AI チャットボットです。

MLC LLM: オフライン操作をサポートし、グラフィックス カードが統合されたコンピューターおよび iPhone に適したオープンソース AI チャットボットです。

- 王林転載

- 2023-05-06 15:46:172375ブラウズ

5 月 2 日のニュースでは、現在、ほとんどの AI チャットボットは処理のためにクラウドに接続する必要があり、ローカルで実行できるものであっても、非常に高い構成要件があります。では、インターネット接続を必要としない軽量のチャットボットはあるのでしょうか?

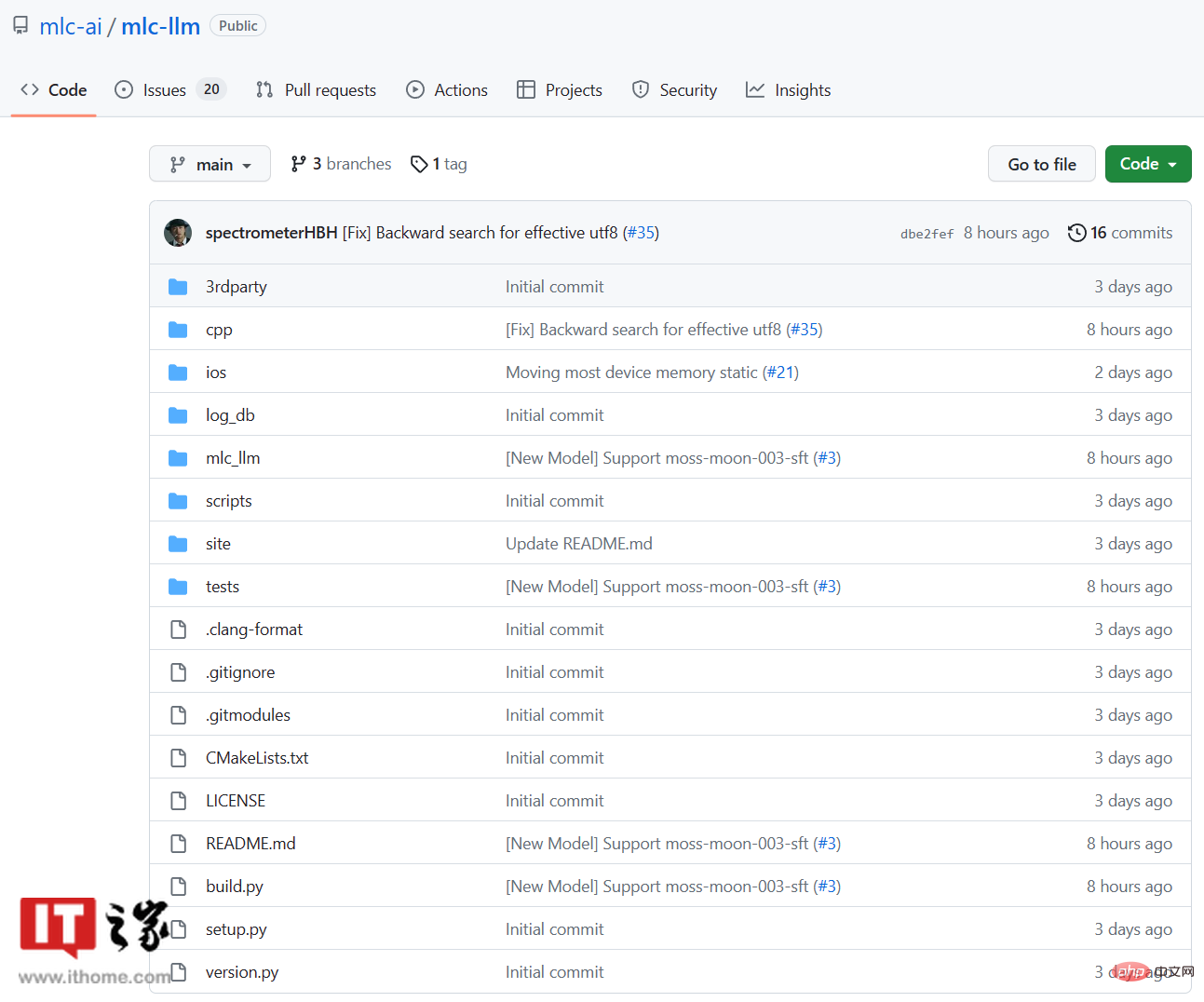

MLC LLM という新しいオープン ソース プロジェクトが GitHub で開始されました。インターネット接続を必要とせずに完全にローカルで実行されます。古いコンピュータや Apple iPhone 携帯電話でも実行できます。

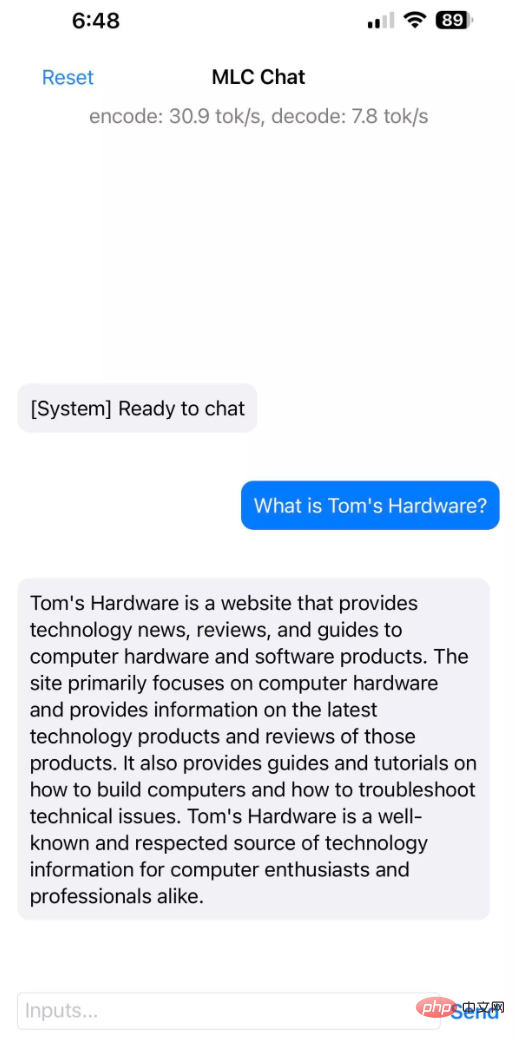

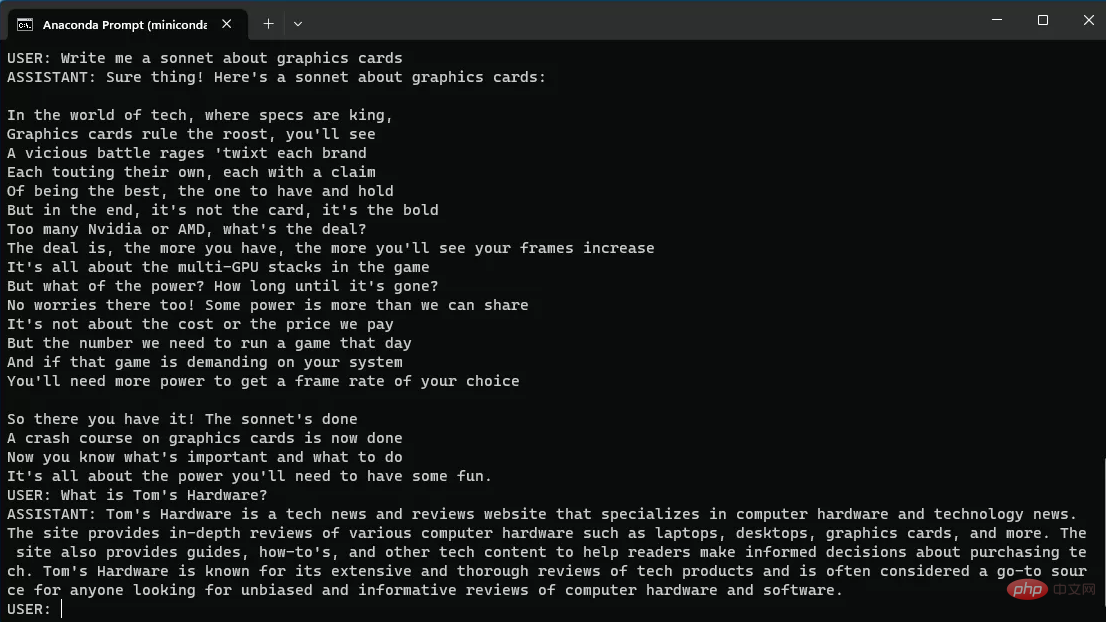

MLC LLM プロジェクトの紹介には、次のように記載されています。「MLC LLM は、あらゆる言語モデルをさまざまなハードウェア バックエンドやネイティブ アプリケーションのセットにプログラム的にローカルにデプロイできるユニバーサル ソリューションです。また、誰もが自分のユースケースに合わせてモデルのパフォーマンスをさらに最適化できる効率的なフレームワークでもあります。サーバーのサポートなしですべてがローカルで実行され、携帯電話やラップトップ上のローカル GPU によって高速化されます。私たちの使命は、すべての人を支援することです。個人が AI モデルを開発、最適化、展開できるようにすることです。

Android で利用できるバージョンはまだありません。

海外メディア tomshardware のテストによると、6GB のメモリを搭載した AppleiPhone 14 Pro Max および iPhone 12 Pro Max 携帯電話は、インストール サイズ 3GB で MLC LLM を正常に実行しました。 4GB のメモリを搭載した Apple iPhone 11 Pro Max では、MLC LLM を実行できません。

以上がMLC LLM: オフライン操作をサポートし、グラフィックス カードが統合されたコンピューターおよび iPhone に適したオープンソース AI チャットボットです。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。