ホームページ >テクノロジー周辺機器 >AI >言いたいことがあるなら発言してください! Googleロボットは大規模な言語モデルを「食べた」後、自ら学習して考えることができる

言いたいことがあるなら発言してください! Googleロボットは大規模な言語モデルを「食べた」後、自ら学習して考えることができる

- 王林転載

- 2023-05-04 14:13:061098ブラウズ

「ホールに行ってもいいし、キッチンに行ってもいいよ。」 これは理想的な優しい妻への褒め言葉ですが、私は将来 Google のロボットにも言うことになるでしょう。

大規模な言語モデルを備え、自ら学習できるロボットを見たことがあるでしょうか?やり方がわかりませんか?学べるよ!今はわからなくても、しばらくすればできるようになります。

##ボストン・ダイナミクスの非常にクールなナイフの山を登り、火の海に降りるのと比較してください。 、山や尾根を越えると、平地を歩いているような気分になります。「鉄仮面キングコング」、今度はGoogleが開発した「学習ロボット」は、あなたの周りの思いやりのある小さなアシスタントのようなものです。私が言うこととあなたが行うことは、ロボットが命令を実行するための一般的なルーチンです。今回のGoogleの新たな研究により、ロボットは指示に従うだけでなく、自ら実行することも可能になる。

Google が大規模な言語モデルとロボットを組み合わせて、人間と同じことを行うようにロボットに教えるのはこれが初めてです。

論文アドレス: https://arxiv.org/pdf/2204.01691.pdfGoogle のタイトルをそのまま使用してください論文 : 「言うことを聞くのではなく、できる限りのことをする」。

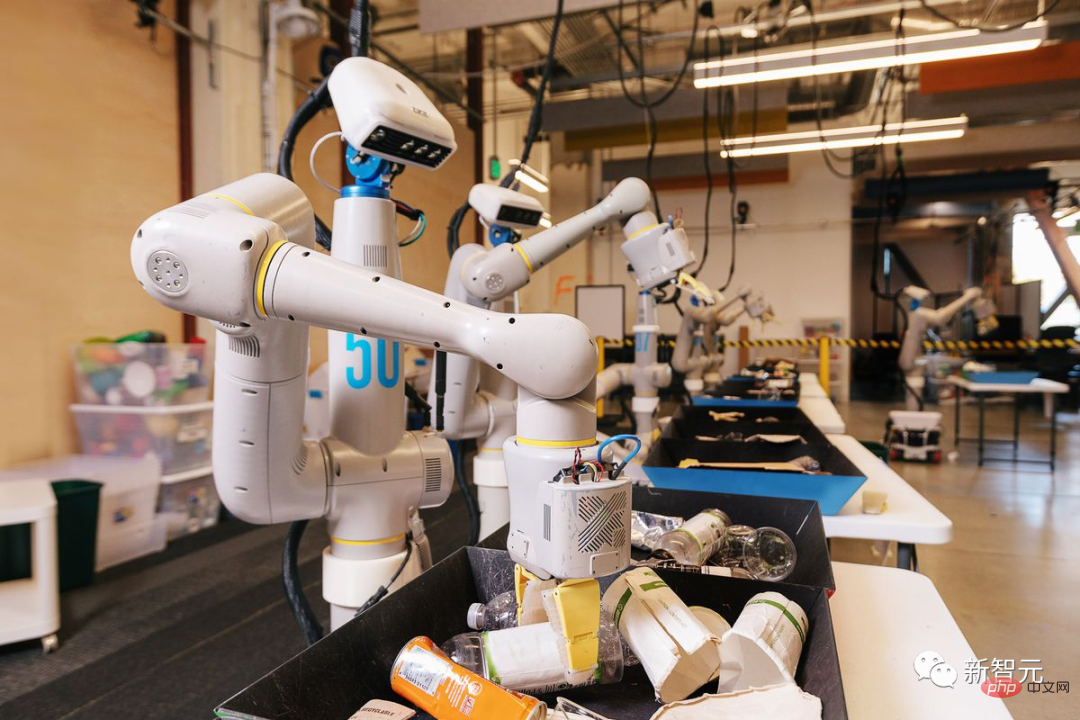

おそらくこれは、次のことを意味します。「あなたはすでに成熟したロボットです。あなたは私と同じことができます。知らない場合は、学ぶことができます。 Google はこのロボットを PaLM-SayCan と名付けました。 「ワシントン・ポスト」の報道の中で、記者は研究者がロボットにプラスチック製のおもちゃの材料を使ってハンバーガーを作るように依頼しているのを目撃した。このロボットアームは、肉を入れた後、レタスを入れる前にケチャップを加える必要があることを認識しているようですが、シェフは現在、「ケチャップを加える」ということは、ケチャップボトル全体をハンバーガーに入れることを意味すると考えています。

このロボット シェフはまだ資格を持っていませんが、大規模な言語モデルをトレーニングすれば、ハンバーガーの調理を学習するのは時間の問題だと Google は考えています。このロボットは、セブンアップやコカ・コーラの缶を認識したり、引き出しを開けたり、ポテトチップスの袋を見つけたりすることもできます。 PaLM の抽象化機能を使用すると、黄色、緑、青のボウルをそれぞれ砂漠、ジャングル、海にたとえることもできます。

誰かと話しているような感じです。

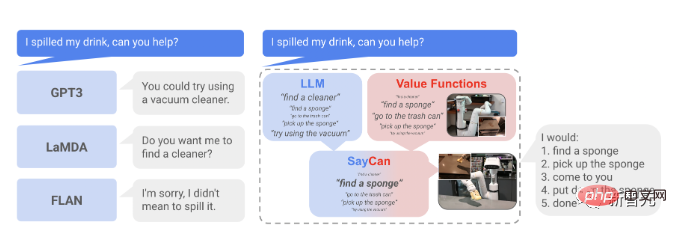

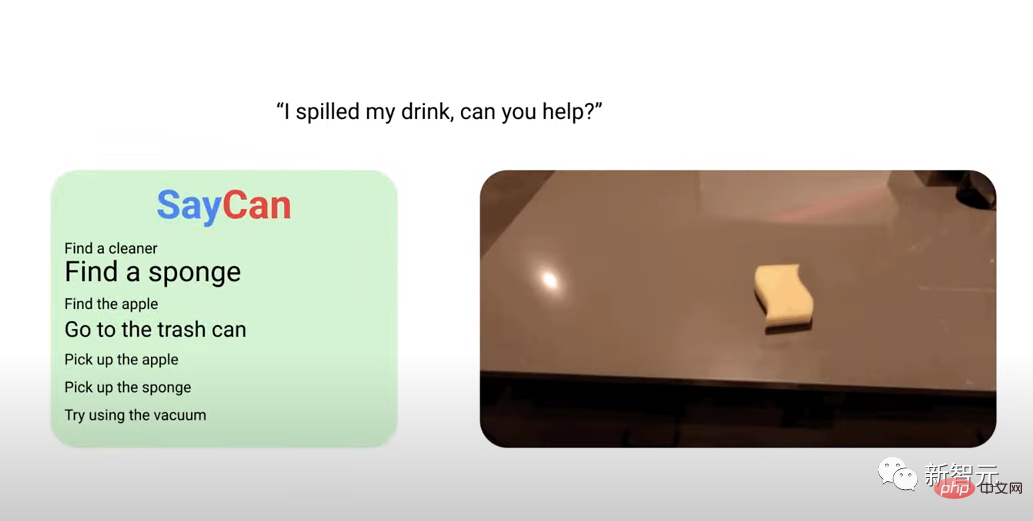

たとえば、Google の人工知能研究者が PaLM-SayCan ロボットに「飲み物をこぼしてしまったので、助けてくれませんか?」と言ったとき、それは Google のキッチンでした。オフィスビル 車輪で滑空し、デジタルカメラのビジョンを使ってカウンター上のスポンジを見つけ、電動アームで掴んで元に戻します。

現在、ロボットは珍しいものではなくなりました。世界中の工場では何百万ものロボットが働いていますが、それらは特定の指示に従い、1 つまたは 2 つのタスクだけに集中していることがよくあります。しかし、一連のタスクを完了し、実行中に学習できるロボットの構築ははるかに複雑です。長年にわたり、大小を問わずテクノロジー企業がそのような「万能ロボット」の開発に熱心に取り組んできました。

近年人気が高まっているビッグ言語モデルにより、Google は「ユニバーサル ロボット」開発のインスピレーションを得ることができました。大規模な言語モデルは、インターネットからの大量のテキストを使用して AI ソフトウェアをトレーニングし、特定の質問やコメントに続く可能性のある応答の種類を推測します。

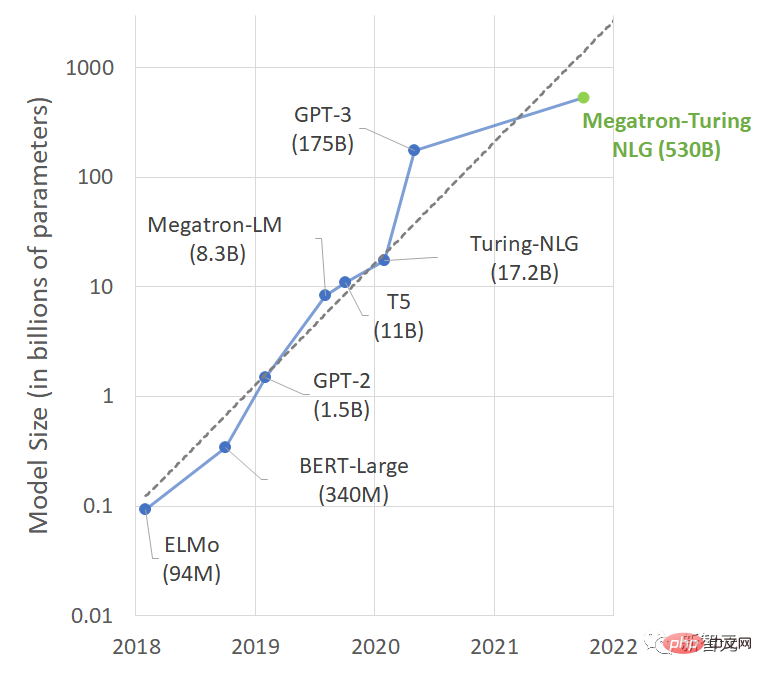

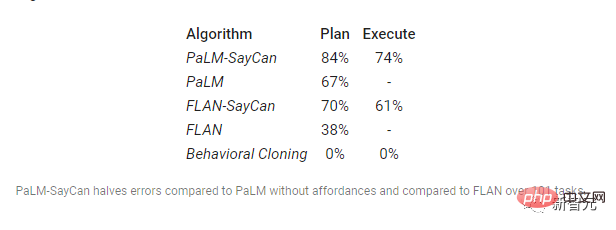

BERT から GPT-3、その後 MT-NLP へ、パラメータ数は急速に増加、これらのモデルは正しい反応を予測するのが非常に上手になっているため、モデルに対処するのは知識のある人間と会話しているように感じることがよくあります。知識が豊富であれば、一日中他の人とおしゃべりするだけではもったいないと思いませんか?会話ができれば仕事ができる、チャットボットからアシスタントロボットに至るまで、Google の研究アイデアは自然に生まれたものと言えます。 今回、Google AIは、Googleの親会社であるAlphabetのムーンショットプロジェクトのXチームが立ち上げたEveryday Robotプロジェクトと連携して手法を提案しました。つまり、事前トレーニングを通じて大規模言語モデル (LLM) から知識が抽出され、ロボットが高レベルのテキストの指示に従って物理的なタスクを完了できるようになります。 Everyday Robot プロジェクトは長年にわたって作業が進められており、チーム メンバーの多くは Google AI を使用しています。 2015年か2016年にAlphabetに参加。そのアイデアは、ロボットが遭遇する可能性のあるあらゆる状況をロボットに教えることなく、カメラと高度な機械学習アルゴリズムを使用して、周囲の世界を見てそこから学習できるようにすることです。 Google のアイデアは次のとおりです。大規模な言語モデルは、世界に関する豊富な意味論的な知識をエンコードできます。知識は、自然言語でタスクを実行するように設計されたロボットにとって非常に役立ちます。 LLM の明らかな欠点は、「実世界の経験が不足している」ことです。実験室で完璧に機能しても、実生活では役に立たない可能性があります。 したがって、研究者は、環境に準拠した自然言語アクションを完了するようにモデルを制約するために、「事前トレーニング スキルを通じて現実世界の基盤を提供する」ことを推奨しています。 ロボットは言語モデルの「手と目」として機能し、言語モデルはタスクに関する高レベルの意味知識/現実世界の経験を提供します。 Google は、PaLM (Pathways Language Model) をトレーニングするために、巨大な 6144 プロセッサ マシンを使用しました。トレーニング リソースには、Microsoft の GitHub Web サイトにある多言語 Web ドキュメントの大規模なコレクション、書籍、Wikipedia の記事、会話、プログラミング コードが含まれます。このように訓練された AI エージェントは、ジョークを説明し、文章を完成させ、質問に答え、独自の思考連鎖に従って推論することができます。 次の質問は、このエージェントがロボットで使用される場合、物理的なタスクを完了するために大規模言語モデル (LLM) の知識をどのように抽出して利用するかということです。たとえば、飲み物をこぼした場合、GPT-3 は掃除機を使ってもよいと言い、LaMDA は掃除機を探す必要がありますか?と言います。 (非常に混乱します) 大規模な言語モデルは実際の環境と対話しないため、この操作に応答できません。 LLM ベースの SayCan によって事前トレーニングされたモデルを通じて形成された値判断能力は、複雑な現実の環境での命令を処理できます。 この例からインスピレーションを得て、ロボットが高レベルのテキスト命令に従うことができるように、LLM で知識を抽出する方法を調査しました。問題。このロボットには、低レベルの視覚運動制御が可能な「アトミック」動作のための一連の学習スキルが装備されています。 LLM に単に指示の説明を求めるだけでなく、個人のスキルが高レベルの指示の完了に向けて進歩する可能性を評価するためにも使用できます。 各スキルがアフォーダンス関数を持っていると仮定すると、現在の状態からそのスキルが成功する確率を定量化することができ(価値関数の学習など)、この値によってスキルの確率を測定できます。このようにして、LLM は、指示の完了に対する各スキルの寄与の確率の記述を完了します。 ##研究者らは、システムのパフォーマンスを評価するために 2 つの指標を使用しました。 (1) 計画成功率。ロボットが指示に対して正しいスキルを選択したかどうかを示します。 (2) 実行成功率。指示の実行に成功したかどうかを示します。 データを見ると、PaLM-SayCan の命令実行率も全モデルの中で最も高いことがわかります。 アイデアは素晴らしいですが、この作業にはリスクがないわけではありません。大規模な言語モデルのトレーニング コーパスはインターネットから取得されますが、一部の言語モデルは人種差別や性差別などの否定的な傾向を示しており、場合によっては憎しみに満ちたスピーチや嘘を公開するように誘導されます。このモデルをチャットボットのトレーニングに使用すると、悪口を言ったり噂話をしたりできる音声アシスタントが作成されますが、手と足を持つロボットに悪いことをするようにトレーニングするためにこのモデルを使用した場合はどうなるでしょうか? さらに、これよりも危険なのは、このように訓練されたロボットが意識を持つようになると、制御不能になる可能性があることです(同様のSF映画はたくさんあります)。 今年 7 月、ある Google 従業員は、ソフトウェアは生身の従業員であると主張しました。 AI 専門家の間では、これらのモデルは生きていないというのがコンセンサスですが、多くの人は、これらのモデルはフィルタリングされていない人間が生成した大量のテキストでトレーニングされているため、バイアスが現れるのではないかと懸念しています。 それにもかかわらず、Google は依然として懸命に取り組んでいます。現在、研究者はロボットの各タスクに対して特定の技術的命令をコード化する必要がなくなり、より簡単に日常言語を使用してロボットとコミュニケーションできるようになりました。 . 彼らは話します。さらに、新しいソフトウェアは、ロボットが複雑な複数ステップの命令を独自に解析するのに役立ちます。 現在、ロボットはこれまで聞いたことのない指示を解釈し、意味のある応答や行動を自ら考え出すことができます。 おそらくロボットにとっては、新たな扉が開いたばかりで、未来はまだ長い道のりかもしれません。ニューラル ネットワークや強化学習などの人工知能技術は、ロボットの訓練に長年使用されてきました。いくつかの画期的な進歩もありましたが、進歩はまだ遅いです。 Google のロボットは現実世界で使用できる状態には程遠く、研究者らは、このロボットはまだ実験段階にあり、商品化する計画はないと繰り返し述べてきました。

この PaLM-SayCan の何がそんなに優れているのでしょうか?

以上が言いたいことがあるなら発言してください! Googleロボットは大規模な言語モデルを「食べた」後、自ら学習して考えることができるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。