ホームページ >テクノロジー周辺機器 >AI >GPTモデルにおけるデータ中心型AIの秘密

GPTモデルにおけるデータ中心型AIの秘密

- 王林転載

- 2023-04-30 17:58:071587ブラウズ

翻訳者 | Zhu Xianzhong

査読者| Chonglou

画像は記事 https://www.php.cn/link/f74412c3c1c8899f3c130bb30ed0e363 から引用したもので、著者自身が作成したものです。

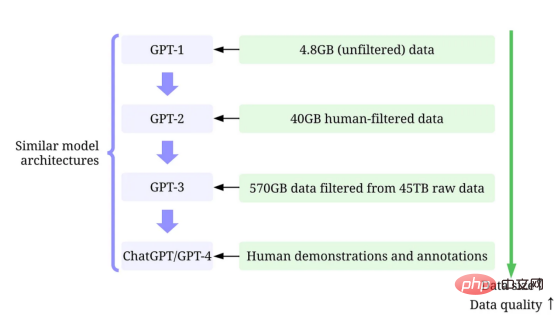

人工知能は、私たちの生活、仕事、テクノロジーとの関わり方を変えるという驚くべき進歩を遂げています。最近、大きな進歩を遂げた分野は、 GPT-3 、## などの大規模言語モデル (LLM) の開発です。 #ChatGPT および GPT-4 。これらのモデルは、言語翻訳、テキストの要約、質問応答などのタスクを優れた精度で実行できます。 大規模な言語モデルのモデル サイズが増大し続けることを無視することはできませんが、その成功の主な要因は、言語モデルに使用される多数の高性能マシンによるものであることを認識することも同様に重要です。質の高いデータを提供します。

この記事では、最近の調査論文を参照しながら、データ中心の人工知能の観点から大規模言語モデルの最近の進歩の概要を説明します。 (終了 ドキュメント 1 および 2 のビュー) および GitHub 上の対応する

技術リソース。特に、データ中心の 人工知能 のレンズを通して GPT モデルを詳しく見ていきます。データサイエンスコミュニティの視点。トレーニング データ開発、推論データ開発、データ メンテナンスという 3 つのデータ中心の人工知能の目標について説明することで、GPT モデルの背後にあるデータ中心の人工知能を明らかにします。 大規模言語モデルと GPT モデル LLM (大規模言語モデル) は、文脈内の単語を推測するようにトレーニングされた自然言語処理モデルです。たとえば、LLM の最も基本的な機能は、コンテキストに基づいて欠落しているトークンを予測することです。これを行うために、LLM は、大量のデータから各候補トークンの確率を予測するようにトレーニングされます。

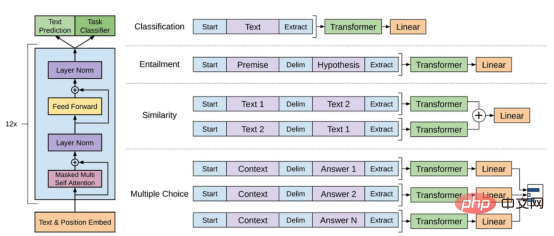

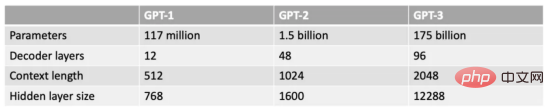

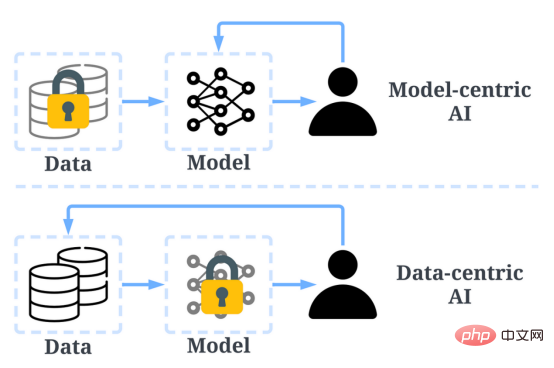

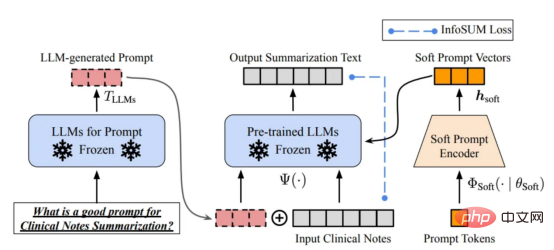

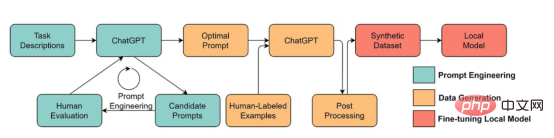

#コンテキストを含む大規模な言語モデルを使用して、トークンが欠落する確率を予測する例 (著者提供)本人写真)# GPT モデルは、 GPT-1 など、OpenAI によって作成された一連の大規模言語モデルを指します。 GPT-2 、 GPT-3 、 InstructGPT および ChatGPT/GPT-4 。他の大規模言語モデルと同様に、GPT モデルのアーキテクチャは、テキストと位置の埋め込みを入力として使用し、アテンション レイヤーを使用してトークン間の関係をモデル化するトランスフォーマーに大きく基づいています。 GPT-1 モデル アーキテクチャ図、この画像は論文から引用 https://www.php.cn/link/c3bfbc2fc89bd1dd71ad5fc5ac96ae69 後の GPT モデルは GPT-1 と同様のアーキテクチャを使用しましたが、より多くのレイヤー、より大きなコンテキスト長、隠れ層サイズなどを備えた、より多くのモデル パラメーターを使用しました。 GPTモデルの各モデルサイズの比較(写真提供:著者提供) データ中心の人工知能は、人工知能システムの構築方法に関する新たな考え方です。人工知能の先駆者であるアンドリュー・ン氏は、このアイデアを擁護してきました。 データ中心の人工知能は、人工知能システムの構築に使用されるデータの体系的エンジニアリングの分野です。 ——Andrew Ng これまでは、データが基本的に変更されていない場合に、より優れたモデル (モデル中心の人工知能) を作成することに主に焦点を当てていました。ただし、このアプローチでは、不正確なラベル、重複、バイアスなど、データ内で発生する可能性のあるさまざまな問題が考慮されていないため、現実の世界で問題が発生する可能性があります。したがって、データセットを「過剰適合」しても、必ずしもモデルの動作が改善されるとは限りません。 対照的に、データ中心の AI は、AI システムの構築に使用されるデータの質と量の向上に焦点を当てています。これは、モデルが比較的固定されている一方で、データ自体に注目が集まることを意味します。 AI システムを開発するためのデータ中心のアプローチは、トレーニングに使用されるデータが最終的にモデルの最大能力を決定するため、現実世界ではより大きな可能性を秘めています。 「データ中心」は「データ駆動」とは根本的に異なることに注意する価値があります。後者は、人為的データを導くためのデータの使用のみを強調するためです。一方、AI 開発は多くの場合、エンジニアリング データではなくモデルの開発を中心としています。 データ中心の人工知能とモデル中心の AI の比較 (画像は https://www.php より) .cn/link/f9afa97535cf7c8789a1c50a2cd83787論文著者) 全体的に、データ中心の人工知能フレームワークは 3 つの目標で構成されています: データ中心の人工知能フレームワーク (論文からの画像 https://www.php.cn/link/ f74412c3c1c8899f3c130bb30ed0e363 ) 数か月前、人工知能業界のリーダーであるヤン・ルカン氏は、ChatGPT は新しいものではないと Twitter で述べました。実際、ChatGPT と GPT-4 で使用されているすべてのテクニック (Tトランスフォーマーや人間のフィードバックからの強化学習など) は新しいテクノロジーではありません。しかし、以前のモデルでは達成できなかった驚くべき結果を達成しました。では、何が彼らの成功を後押ししているのでしょうか? まず、トレーニングデータ開発を強化します。データ収集、データラベル付け、およびデータ準備戦略の改善により、GPT モデルのトレーニングに使用されるデータの量と質が大幅に増加しました。 ;DR」などの指示とともに要約のテキストを提供することで、テキスト要約を実行できます。 適切な推論プロンプトを設計することは、困難な作業です。それはヒューリスティック技術に大きく依存しています。優れた調査は、人々がこれまでに使用したさまざまなプロンプト方法を要約しています。場合によっては、意味的に類似したキューであっても、出力が大きく異なる場合があります。この場合、不一致を減らすためにソフトキューベースのキャリブレーションが必要になる場合があります。 #ソフト プロンプト ベースのキャリブレーション。この画像は、元の著者の許可を得て、論文 https://arxiv.org/abs/2303.13035v1 から引用したものです。 大規模な開発に関する研究-スケール言語モデル推論データはまだ初期段階にあります。近い将来、他のタスクですでに使用されている推論データ開発手法が、大規模言語モデルの分野にさらに適用される可能性があります。 データ保守の観点から見ると、商用製品である ChatGPT/GPT-4 は、一度トレーニングを成功させるだけではなく、継続的なトレーニングを必要とします。メンテナンス。当然のことながら、OpenAI の外部でデータ保守がどのように実行されるかはわかりません。したがって、GPT モデルで使用されている可能性が高い、または今後使用される可能性が高い、一般的なデータ中心の AI 戦略について説明します。 ChatGPT/GPT-4 システムは、図に示すように「賛成」と「反対」の 2 つのアイコン ボタンを通じてユーザーのフィードバックを収集し、さらなるプロモーションを行うことができます。彼らはシステム開発を行っています。ここのスクリーンショットは https://chat.openai.com/chat からのものです。 大規模言語モデルの成功は、人工知能に革命をもたらしました。今後、大規模な言語モデルはデータ サイエンスのライフサイクルにさらに革命を起こす可能性があります。この目的のために、私たちは 2 つの予測を立てます。 大規模な言語モデルを使用して合成データを生成し、モデルをトレーニングします。ここにある画像は、論文 https://arxiv.org/abs/2303.04360、原著者の許可を得て この記事ができることを願っていますあなた自身の仕事にインスピレーションを与えるために使用してください。データ中心の AI フレームワークと、それが大規模な言語モデルにどのようなメリットをもたらすかについて詳しくは、次の論文をご覧ください: [1] データ中心型人工知能のレビュー 。 [2] データ中心型人工知能の展望と課題 。 当社では GitHub コード リポジトリ も管理していることに注意してください。これは定期的に更新されます。データ中心の人工知能リソース。 #今後の記事では、データ中心人工知能の 3 つの目標 (学習データ開発、推論データ開発、データ保守) を掘り下げ、代表的な性的手法を紹介します。 Zhu Xianzhong、51CTOコミュニティ編集者、51CTOエキスパートブロガー、講師、濰坊の大学のコンピューター教師、フリーランスプログラミングコミュニティ ベテラン。 元のタイトル: データ中心の AI 概念とはGPT モデルの背後にありますか? 、著者: Henry Lai

データ中心の人工知能とは何ですか?

データ中心の人工知能が GPT モデルをこれほど成功させたのはなぜですか?

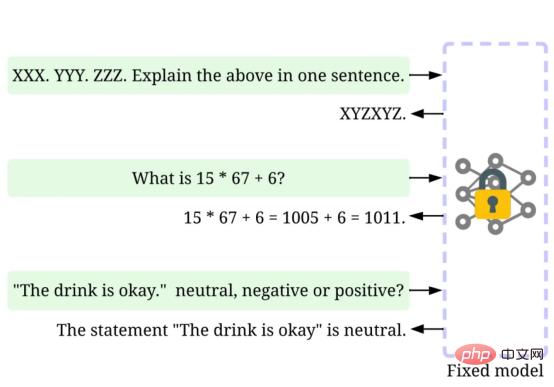

#2 番目に、推論データを作成します。最近の GPT モデルは十分強力になっているので、モデルを修正しながらヒントを調整する(または推論データを調整する)ことで、さまざまな目的を達成できます。たとえば、推論プロセスをガイドする「要約してください」や「TL

以上がGPTモデルにおけるデータ中心型AIの秘密の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。