ホームページ >テクノロジー周辺機器 >AI >真の量子速読:一度に50ページのテキストしか理解できないGPT-4の限界を突破、新しい研究は数百万のトークンにまで拡張

真の量子速読:一度に50ページのテキストしか理解できないGPT-4の限界を突破、新しい研究は数百万のトークンにまで拡張

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-28 10:37:241095ブラウズ

1 か月以上前、OpenAI の GPT-4 が発表されました。さまざまな優れた視覚的なデモンストレーションに加えて、重要なアップデートも実装されています。デフォルトでは長さ 8K のコンテキスト トークンを処理できますが、最大 32K (テキストの約 50 ページ) まで対応できます。これは、GPT-4 に質問するときに、以前よりもはるかに長いテキストを入力できることを意味します。これにより、GPT-4 のアプリケーション シナリオが大幅に拡張され、長い会話、長いテキスト、ファイルの検索と分析をより適切に処理できるようになります。

しかし、この記録はすぐに破られました。Google Research の CoLT5 は、モデルが処理できるコンテキスト トークンの長さを 64k に拡張しました。

Transformer アーキテクチャを使用するこれらのモデルはすべて問題に直面しているため、このようなブレークスルーは簡単ではありません。Transformer による長いドキュメントの処理は、入力の長さに応じて注意コストが増加するため、計算コストが非常に高くなります。は二次関数的に増大するため、大規模なモデルをより長い入力に適用することがますます困難になります。

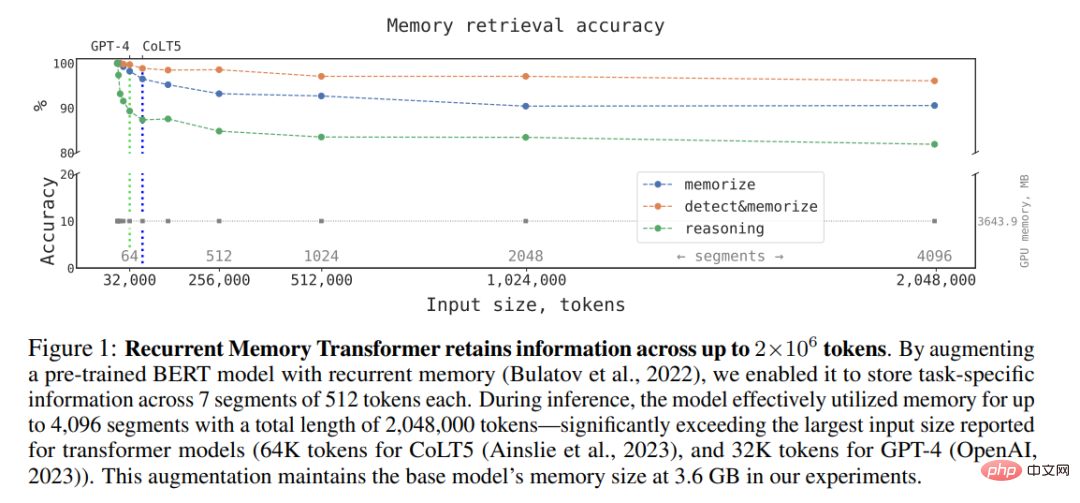

にもかかわらず、研究者たちは依然としてこの方向で画期的な進歩を遂げています。数日前、オープンソースの対話 AI テクノロジー スタック DeepPavlov とその他の機関による研究では、次のことが示されました。リカレント メモリ トランスフォーマー (RMT) と呼ばれるアーキテクチャを使用することで、BERT の有効なコンテキスト長を増やすことができます。高いメモリ検索精度を維持しながら、200 万トークン (OpenAI の計算方法によるとおよそ 3,200 ページのテキストに相当) までモデル化できます (注: Recurrent Memory Transformer は、NeurIPS 2022 Methods の論文で Aydar Bulatov らによって提案されました)。新しい方法では、ローカルおよびグローバル情報の保存と処理、および再帰を使用した入力シーケンスのセグメント間の情報の流れが可能になります。

著者は、Bulatov et al. の記事「Recurrent」で紹介された単純なトークンベースのアルゴリズムを使用することによって、 「Memory Transformer」メモリ メカニズムにより、RMT を BERT などの事前トレーニングされた Transformer モデルと組み合わせ、Nvidia GTX 1080Ti GPU を使用して、100 万を超えるトークンのシーケンスに対して完全な注意と完全な精度の操作を実行できます。

#論文アドレス: https://arxiv.org/pdf/2304.11062.pdf

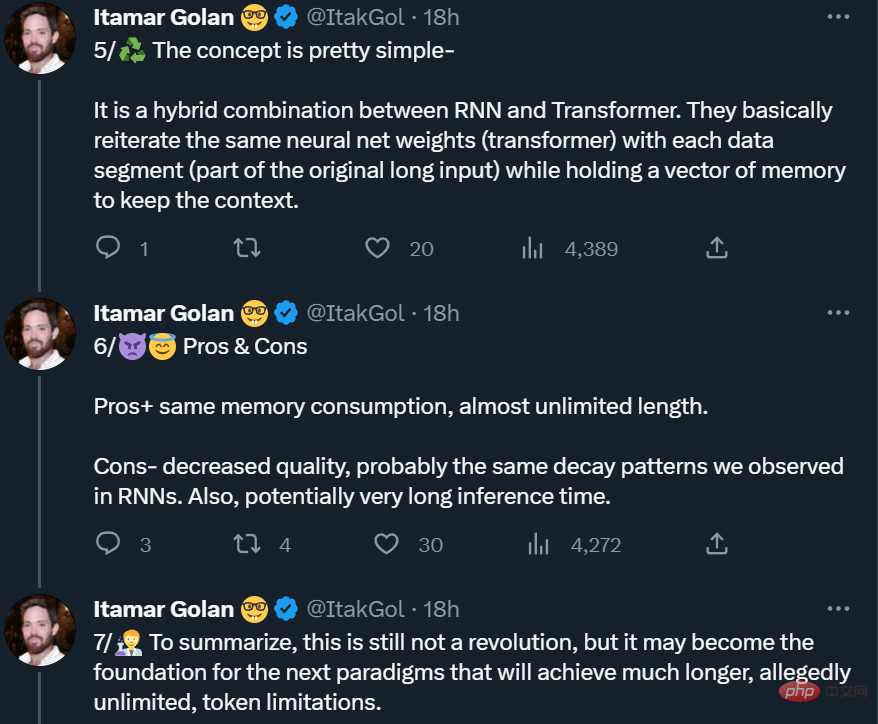

ただし、これは本当の「フリーランチ」ではなく、上記の論文の改善は「推論時間の延長と品質の大幅な低下」によって得られることを思い出させる人もいます。 。したがって、それはまだ革命ではありませんが、次のパラダイムの基礎となる可能性があります(トークンは無限に長くなる可能性があります)。

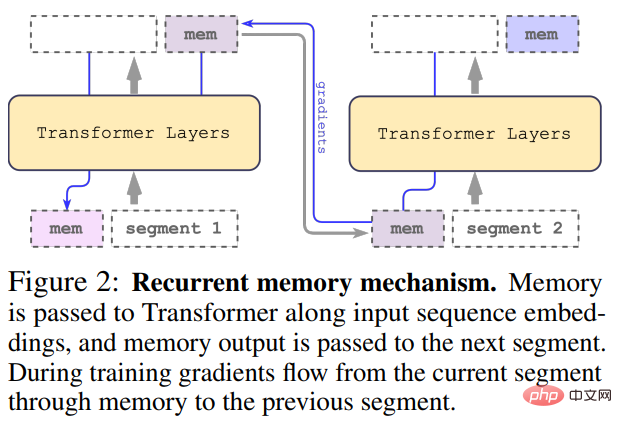

本研究では、Bulatov らによって提案された手法 Recurrent Memory Transformer を採用しています。 2022年にRMT(プラグアンドプレイ方式)に変更 主な仕組みは下図の通りです。 ##長い入力は複数のセグメントに分割され、最初のセグメントが埋め込まれる前にメモリ ベクトルが追加され、セグメント トークンとともに処理されます。 BERT のような純粋なエンコーダー モデルの場合、純粋なデコーダー モデルがメモリを読み取り部分と書き込み部分に分割する (Bulatov et al., 2022) とは異なり、メモリはセグメントの先頭に 1 回だけ追加されます。タイム ステップ τ とセグメント

の場合、ループは次のように実行されます。

#ここで、N は Transformer の層数です。順伝播後、

# にはセグメント τ の更新されたメモリ トークンが含まれます。

#入力シーケンスのセグメントは順番に処理されます。循環接続を有効にするために、調査では現在のセグメントからのメモリ トークンの出力を次のセグメントの入力に渡します:

計算効率

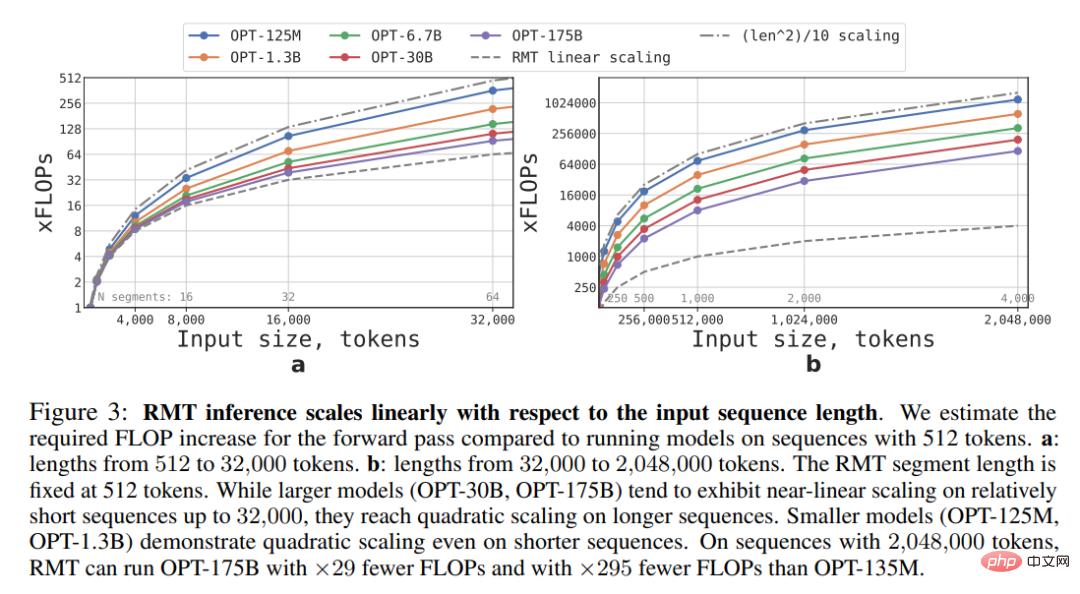

この調査では、さまざまなサイズとシーケンス長の RMT および Transformer モデルに必要な FLOP を推定します。以下の図 3 に示すように、セグメントの長さが固定されている場合、RMT は任意のモデル サイズに対して線形にスケールできます。この研究では、入力シーケンスをセグメントに分割し、セグメント境界内でのみ完全なアテンション行列を計算することにより、線形スケーリングを実現します。

FFN 層の計算の複雑さにより、大規模な Transformer モデルでは、シーケンスの長さに応じて 2 次スケーリングが遅くなる傾向があります。ただし、32000 を超える非常に長いシーケンスの場合は、二次展開に戻ります。複数のセグメント (この研究では > 512) を持つシーケンスの場合、RMT は非巡回モデルよりも必要な FLOP が少なく、FLOP の数を最大 295 分の 1 まで削減できます。 RMT は、小型モデルでは FLOP の相対的な削減が大きくなりますが、OPT-175B モデルの FLOP の 29 倍の削減は絶対的な意味で大幅です。

記憶タスク

記憶タスク

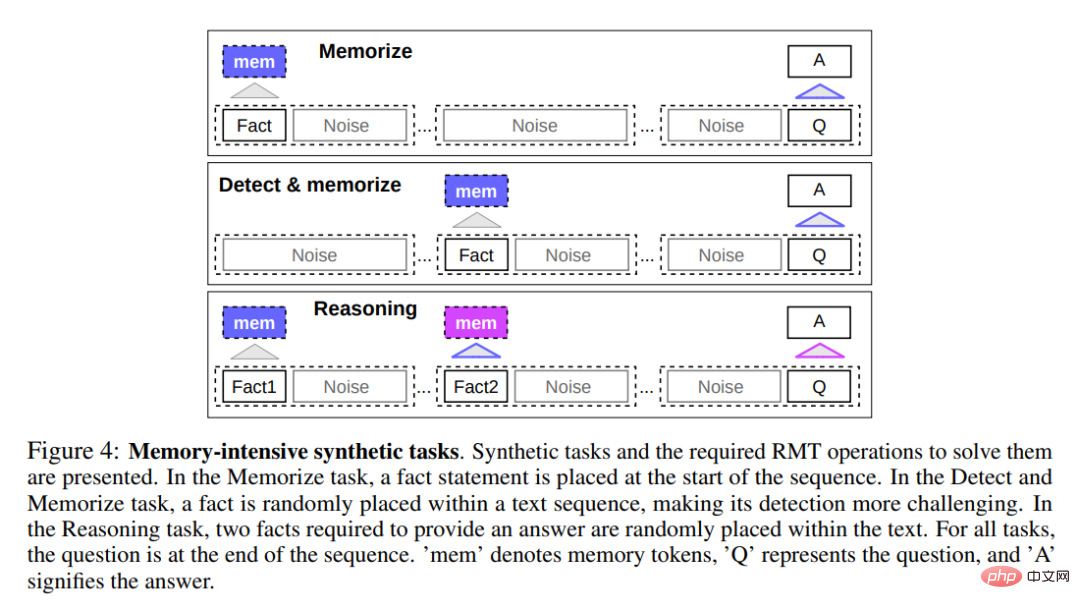

最初の項目課題は、以下の図 4 の上部に示すように、メモリに情報を長期間書き込んで保存する RMT の機能をテストすることです。最も単純なケースでは、事実は入力の先頭にあり、質問は常に最後にある傾向があります。質問と回答の間にある無関係なテキストの量が徐々に増加し、入力全体が 1 つのモデル入力に収まらなくなるまで増加します。

ファクト検出は、上の図 4 の中央に示すように、ファクトを入力内のランダムな位置に移動することにより、タスクの難易度を高めます。これには、モデルが最初に事実と無関係なテキストを区別し、その事実をメモリに書き込み、最後にそれを使用して質問に答える必要があります。 記憶された事実を使用して推論する 記憶のもう 1 つの操作は、記憶された事実と現在のコンテキストを使用して推論することです。この機能を評価するために、研究者らは、上の図 4 の下部に示すように、2 つのファクトを生成して入力シーケンス内に配置する、より複雑なタスクを使用しました。シーケンスの最後に行われる質問は、質問に正しく答えるために任意の事実を使用する必要があるように記述されています。

実験結果

研究者らは、モデルのトレーニングと評価に 4 ~ 8 個の NVIDIA 1080ti GPU を使用しました。 。より長いシーケンスの場合は、評価を高速化するために 40GB の NVIDIA A100 を 1 台使用しました。

コース学習

研究者らは、トレーニング プランを使用すると、ソリューションの精度と精度が大幅に向上することを観察しました。 。 安定性。最初に、RMT はタスクの短いバージョンでトレーニングされ、トレーニングが収束するにつれて別のセグメントを追加することでタスクの長さを増やします。コース学習プロセスは、必要な入力長に達するまで続行されます。

実験では、研究者たちはまず、単一のセグメントに適したシーケンスから開始しました。実際のセグメント サイズは 499 ですが、BERT の 3 つの特別なトークンとモデル入力から保持される 10 個のメモリ プレースホルダーにより、サイズは 512 になります。彼らは、RMT では、完璧な解決策に収束するために使用するトレーニング ステップが少なくて済むため、短いタスクでトレーニングした後、より長いバージョンのタスクを解決するのが容易であることに注目しています。

外挿能力

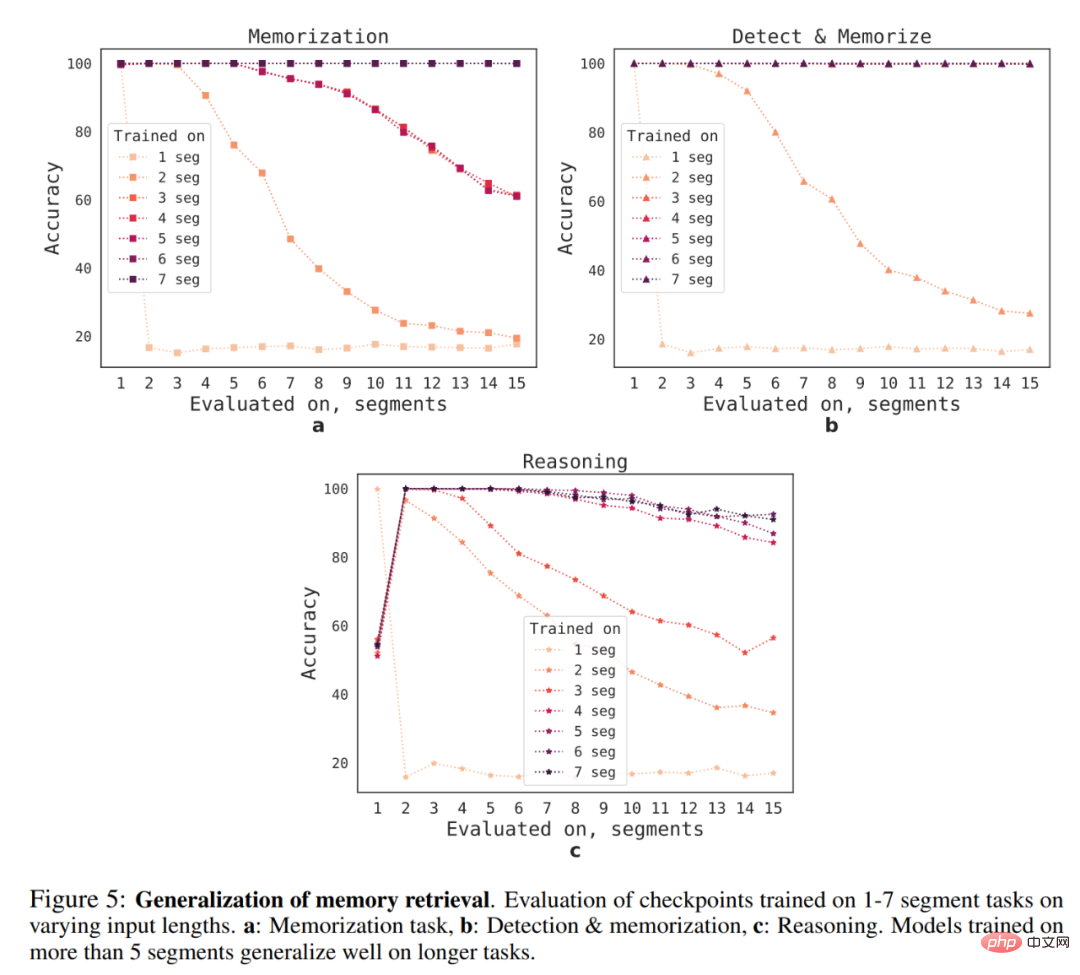

さまざまなシーケンス長に対する RMT の一般化能力は何ですか?この質問に答えるために、研究者らは、以下の図 5 に示すように、より長いタスクを解決するためにさまざまな数のセグメントでトレーニングされたモデルを評価しました。

研究者らは、単一セグメントの推論タスクを除いて、モデルは短いタスクの方がパフォーマンスが向上する傾向があることを観察しました。単一セグメントの推論タスクは解決が非常に困難になります。考えられる説明の 1 つは、タスク サイズが 1 セグメントを超えるため、モデルが最初のセグメントの問題を「予期」しなくなり、その結果品質が低下するということです。

#興味深いことに、トレーニング セグメントの数が増加するにつれて、より長いシーケンスに一般化する RMT の機能も現れます。 5 つ以上のセグメントでトレーニングした後、RMT は 2 倍の時間のタスクをほぼ完全に一般化できます。

一般化の限界をテストするために、研究者らは検証タスクのサイズを 4096 セグメントまたは 2,043,904 トークンに増加しました (上の図 1 を参照)。驚くほど良いパフォーマンスを見せました。検出と記憶のタスクが最も単純であり、推論タスクが最も複雑です。

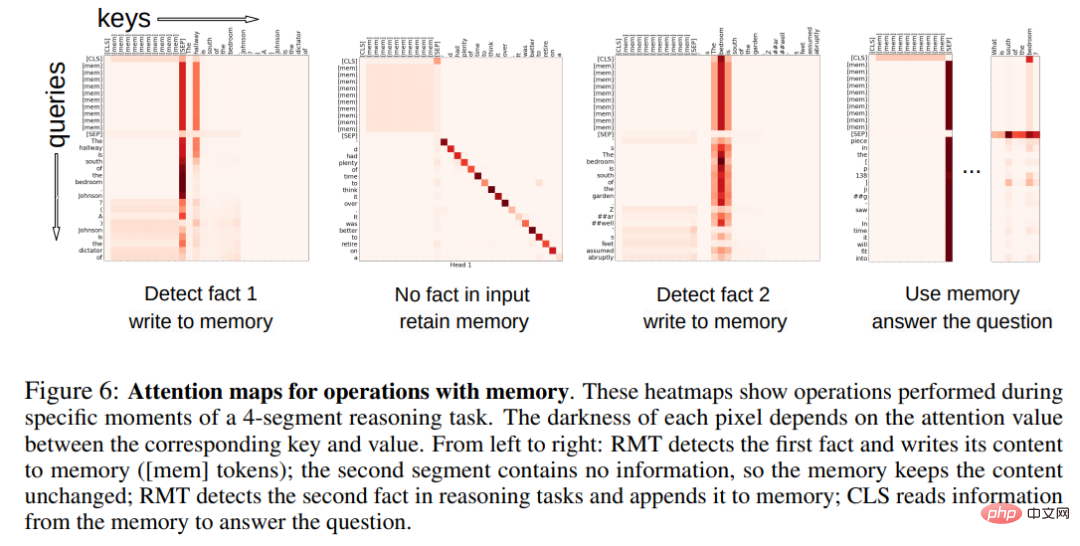

メモリ操作のアテンション パターン以下の図 6 では、特定のセグメントに対する RMT アテンションを調べることで、研究者はメモリ操作が特定のアテンションに対応していることを観察しました。モデル。さらに、セクション 5.2 の非常に長いシーケンスに対する高い外挿パフォーマンスは、何千回使用された場合でも、学習されたメモリ操作の有効性を示しています。

技術的および実験的な詳細については、元の論文を参照してください。

以上が真の量子速読:一度に50ページのテキストしか理解できないGPT-4の限界を突破、新しい研究は数百万のトークンにまで拡張の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。