ホームページ >テクノロジー周辺機器 >AI >GPU は数秒で 3D モデルを生成できます。 OpenAI の新作: Point-E はテキストを使用して 3D 点群モデルを生成できます

GPU は数秒で 3D モデルを生成できます。 OpenAI の新作: Point-E はテキストを使用して 3D 点群モデルを生成できます

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-15 08:58:02972ブラウズ

AI の世界を席巻する次のブレークスルーはどこにあるでしょうか?

多くの人は、これが 3D モデル ジェネレーターであると予測します。

今年の初めに発売された DALL-E 2 がその天才的なブラシで誰もを驚かせた後、OpenAI は火曜日に最新の画像生成モデル「POINT-E」をリリースしました。テキストモデルから直接3D。

紙のリンク: https://arxiv.org/pdf/2212.08751.pdf

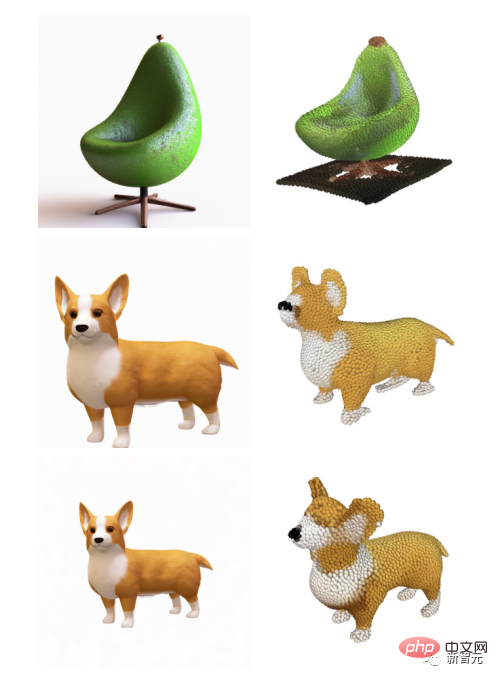

#数時間動作するために複数の GPU を必要とする競合他社 (Google の DreamFusion など) と比較して、POINT-E は 1 つの GPU だけで数分で 3D 画像を生成できます。編集者による実際のテストの後、POINT-E は基本的にプロンプト入力後数秒で 3D 画像を出力することができ、さらに、出力画像はカスタム編集、保存などの機能もサポートしています。

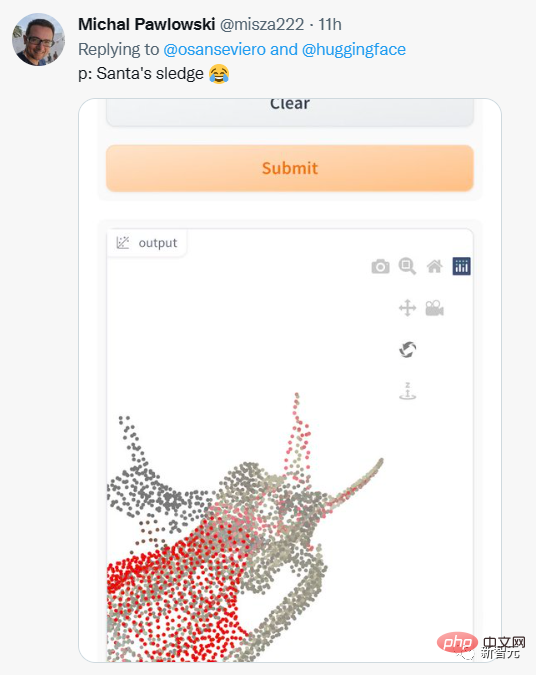

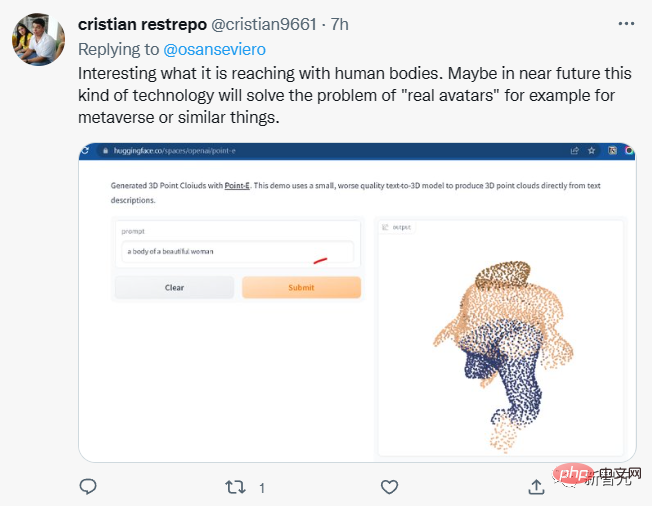

ネチズンもさまざまなプロンプト入力を試し始めました。

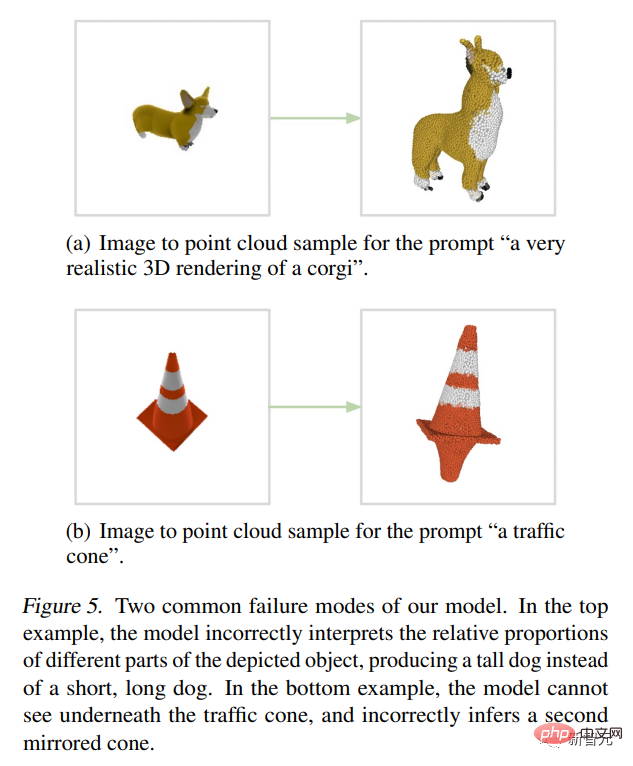

#しかし、出力結果は必ずしも満足できるものではありません。

一部のネチズンは、POINT-E は Meta のメタバース ビジョンを実現できるかもしれないと言っています。

POINT-E は、空間内の点のデータ セットである点群を通じて 3D 画像を生成することに注意してください。

# 簡単に言うと、3 次元モデルを通じてデータを収集し、空間内の 3 次元形状を表す点群データを取得することです。

計算の観点から見ると、点群は合成が容易ですが、現時点では点群では物体の繊細な形状やテクスチャを捉えることができません。ポイント-Eの欠点。

この制限に対処するために、Point-E チームは追加の人工知能システムをトレーニングして、Point-E の点群をメッシュに変換しました。

#点 E 点群をメッシュに変換

さらに独立したメッシュ生成モデルに対して、Point-E は 2 つのモデルで構成されます:

テキストから画像へのモデルと画像 3D モデル (-to-3D モデル)。テキストから画像への変換モデルは、OpenAI の DALL-E 2 および Stable Diffusion に似ており、単語と視覚的概念の関連性を理解するためにラベル付き画像でトレーニングされます。

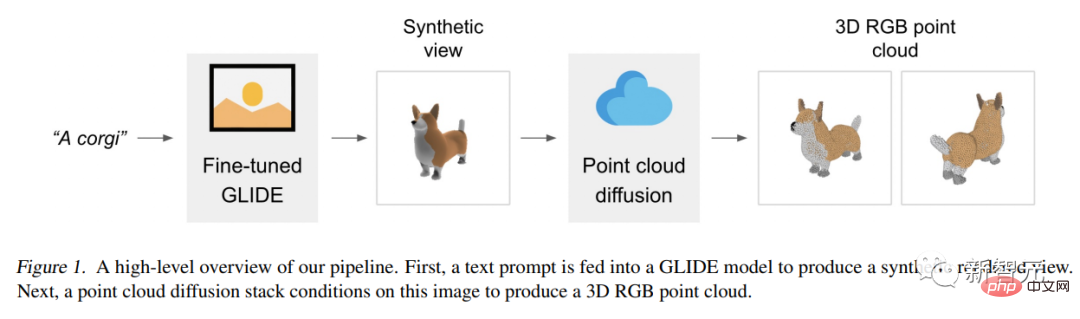

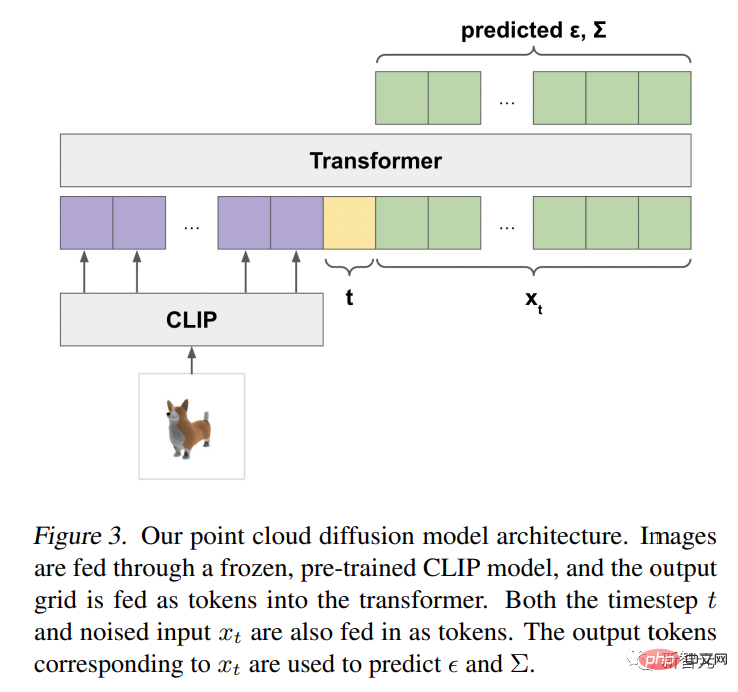

次に、3D オブジェクトとペアになった一連の画像が 3D 変換モデルに入力され、モデルが 2 つの間で効率的に変換する方法を学習します。 プロンプトが入力されると、テキストから画像への変換モデルは合成レンダー オブジェクトを生成し、それが画像から画像への変換 3D モデルに供給され、その後、点群。 OpenAI 研究者らは、Point-E は数百万の 3D オブジェクトと関連するメタデータのデータセットでトレーニングされたと述べています。 しかし、これは完璧ではありません。Point-E の画像から 3D モデルは、テキストから画像へのモデル内の画像を理解できないことがあり、その結果、テキストと一致しない形状が生成されます。ヒント。それでも、これまでの最先端テクノロジーよりも桁違いに高速です。 彼らは論文で次のように書いています: 私たちの方法は評価においては最先端のものよりも性能が劣りますが、それはサンプルのみですほんのわずかな時間で生成されます。これにより、特定のアプリケーションにとってより実用的になり、より高品質の 3D オブジェクトを検出できるようになります。 Point-E アーキテクチャと操作メカニズム Point-E モデルは、最初にテキストから画像への拡散モデルを使用して単一の合成ビューを生成し、次に2 番目の拡散 モデルは、生成された画像に基づいて条件付けされた 3D 点群を生成します。 この方法はサンプリング品質の点ではまだ最先端ではありませんが、1 ~ 2 桁高速であるため、用途によっては実用的なトレードオフが得られます。ケース。 次の図は、モデルの高レベルのパイプライン図です。 私たちはそうではありません。トレーニング 単一の生成モデルはテキストに条件付けされた点群を直接生成しますが、代わりに生成プロセスを 3 つのステップに分割します。 まず、テキスト タイトルを条件とした包括的なビューを生成します。 次に、合成ビューに基づいて大まかな点群 (1,024 点) を生成します。 最終的に、低解像度の点群と合成ビューで条件付けされた細かい点群 (4,096 点) が生成されました。 数百万の 3D モデルでモデルをトレーニングした後、データセットのデータ形式と品質が大きく異なることがわかり、より高いパフォーマンスを保証するためのさまざまな後処理ステップを開発することになりました。データの品質。 すべてのデータを共通の形式に変換するために、Blender を使用して、各 3D モデルを 20 のランダムなカメラ アングルからの RGBAD 画像にレンダリングしました (Blender は複数の 3D 形式をサポートしており、最適化されたレンダリング エンジン)。 各モデルについて、Blender スクリプトはモデルを境界立方体に正規化し、標準の照明設定を構成し、最後に Blender の組み込みリアルタイム レンダリング エンジンを使用して RGBAD 画像をエクスポートします。 次に、レンダリングを使用して各オブジェクトを色付きの点群に変換します。まず、各 RGBAD 画像の各ピクセルの点をカウントすることにより、オブジェクトごとに密な点群が構築されます。これらの点群には通常、不均一に分散された数十万の点が含まれているため、最も遠い点のサンプリングも使用して均一な 4K 点群を作成します。 レンダリングから直接点群を構築することで、3D メッシュからの直接サンプリング、モデルに含まれる点のサンプリング、またはそれらの点群の処理から発生する可能性のあるさまざまな問題を回避できます。 3D モデルを保存するための一般的なファイル形式。 最後に、さまざまなヒューリスティックを採用して、データセット内の低品質モデルの頻度を減らします。 まず、各点群の SVD を計算して平面オブジェクトを削除し、最小特異値が特定のしきい値より高いオブジェクトのみを保持します。 次に、CLIP 特徴によってデータセットをクラスタリングします (オブジェクトごとに、すべてのレンダリングにわたる特徴を平均します)。 一部のクラスターには低品質のモデル カテゴリが多数含まれている一方、他のクラスターはより多様で解釈可能であることがわかりました。 これらのクラスターをさまざまな品質のいくつかのバケットに分割し、結果のバケットを重み付けして混合したものを最終的なデータセットとして使用します。 OpenAI 研究者は、Point-E の点群は現実世界のオブジェクトの作成にも使用できると指摘しました。 3Dプリントなど。 追加のメッシュ変換モデルを使用すると、システムはゲームやアニメーションの開発ワークフローに参加することもできます。 現在、2D アート ジェネレーターに注目が集まっていますが、モデル合成人工知能が次の大きな業界の破壊者となる可能性があります。 3D モデルは、映画やテレビ、インテリア デザイン、建築、さまざまな科学分野で広く使用されています。 現在、3D モデルの製造には通常数時間かかりますが、Point-E の登場はこの欠点を補うものです。 研究者らは、Point-Eには現段階でもまだ多くの欠陥があり、訓練データから受け継いだバイアスや、危険な物体の作成に使用される可能性のあるモデルの保護手段の欠如などがあると述べている。 Point-E は単なる出発点であり、これがテキストから 3D への合成の分野における「さらなる研究」のきっかけとなることを彼らは望んでいます。

アプリケーションの見通し

以上がGPU は数秒で 3D モデルを生成できます。 OpenAI の新作: Point-E はテキストを使用して 3D 点群モデルを生成できますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。