ホームページ >テクノロジー周辺機器 >AI >なぜセルフモニタリングが効果的なのでしょうか? 243ページに及ぶプリンストン大学の博士論文「自己教師あり表現学習の理解」では、対比学習、言語モデリング、自己予測という3種類の手法について包括的に説明されている。

なぜセルフモニタリングが効果的なのでしょうか? 243ページに及ぶプリンストン大学の博士論文「自己教師あり表現学習の理解」では、対比学習、言語モデリング、自己予測という3種類の手法について包括的に説明されている。

- PHPz転載

- 2023-04-15 08:13:021070ブラウズ

事前トレーニングは、これらの欠点を克服するための代替的で効果的なパラダイムとして登場しました。事前トレーニングでは、すぐに利用できるデータを使用してモデルが最初にトレーニングされ、次に、教師あり学習よりもラベル付けの少ないデータを使用して、関心のある下流のタスクを解決するために使用されます。 。

ラベルなしデータを使用した事前トレーニング、つまり自己教師あり学習は特に革新的であり、テキスト、ビジョン、音声などのさまざまな分野で成功を収めています。

これは興味深い、そして挑戦的な質問を引き起こします: ラベルのないデータでの事前トレーニングが、一見無関係に見える下流のタスクに役立つのはなぜですか?

#論文アドレス: https://dataspace.princeton.edu/handle/88435/dsp01t435gh21h

##この論文では、なぜ自己教師あり学習が下流のタスクに有益であるかを調査するための理論的枠組みを提案および確立するいくつかの研究を紹介します。

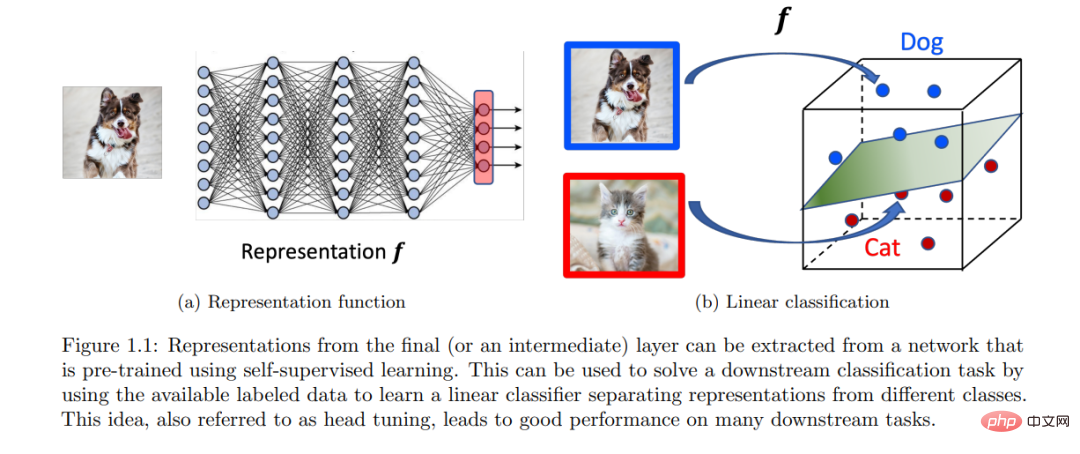

#このフレームワークは、対比学習、自己回帰言語モデリング、自己予測ベースの手法に適しています。このフレームワークの中心的な考え方は、事前トレーニングがデータの低次元表現を学習するのに役立ち、その後、必要なラベル付きデータが少なくなり、線形分類器を使用して対象の下流タスクを解決するのに役立つということです。 #共通のトピックは、自己教師あり学習タスクを構築するためのラベルなしデータ分布の理想的な特性を形式化することです。適切に形式化すると、正しい事前トレーニング目標をほぼ最小化することで、ラベルのないデータ分布で暗黙的にエンコードされたダウンストリーム信号を抽出できることが示されます。

最後に、線形分類器を使用して学習した表現から信号をデコードできることが示され、タスク間での「スキルと知識」の伝達を形式化できます。

はじめに

インテリジェントなエージェントとデータ駆動型ソリューションの設計を目指して、問題 その過程で、機械学習と人工知能の分野は過去 10 年間で目覚ましい進歩を遂げました。

ImageNet [Deng et al., 2009] などの困難な教師あり学習ベンチマークでの初期の成功により、その後、深層学習の革新により、さまざまなドメインの多くのそのようなベンチマークで超人的なパフォーマンスを発揮するモデルが誕生しました。このようなタスク固有のモデルのトレーニングは確かに印象的であり、非常に大きな実用的価値があります。ただし、大規模なラベル付きまたは注釈付きのデータセットが必要になるという重要な制限があり、コストがかかることがよくあります。さらに、知能の観点からは、人間と同じように[Ahn and Brewer, 1993]、以前の経験から学び、それらをスキルや概念に要約し、これらのスキルや概念を利用して新しいタスクを解決できる、より一般的なモデルが期待されています。デモンストレーションはほとんど、あるいはまったくありません。結局のところ、赤ちゃんは明示的な監督なしでも観察や交流を通じて多くのことを学びます。これらの制限は、事前トレーニングの代替パラダイムを発想させました。#この記事の焦点は、大量の利用可能なラベルなしデータを使用した事前トレーニングにあります。ラベルのないデータを使用するというアイデアは、特に教師なし学習および半教師あり学習を通じた機械学習において長い間関心を集めてきました。

深層学習を使用したこれの現代的な適応は、自己教師あり学習 (SSL) と呼ばれることが多く、対照学習や言語モデリングなどのアイデアを通じて、機械学習と人工知能の状況を変え始めています。自己教師あり学習の考え方は、ラベルなしのデータのみを使用して特定のタスクを構築し、構築されたタスクで適切に実行できるようにモデルをトレーニングすることです。このようなタスクでは、通常、入力の観察されていない部分または隠れた部分 (またはプロパティ) を、観察された部分または保持された部分から予測することによって、データの構造プロパティをエンコードするモデルが必要です [LeCun and Misra, 2021]。自己教師あり学習は、多くの下流の関心のあるタスクに対して汎用性と有用性を示しており、多くの場合、タスクを最初から解決するよりもサンプル効率が高く、汎用エージェントの目標に一歩近づくことができます。実際、最近、GPT-3 [Brown et al., 2020] のような大規模な言語モデルが、大規模に発生する魅力的な「緊急動作」を実証し、自己教師あり事前トレーニングのアイデアへの関心が高まっています。自己教師あり学習は経験的に成功しており、今後も大きな期待が寄せられていますが、大まかな直感を超えて自己教師あり学習がどのように機能するかについての理論的な理解はまだ十分ではありません。これらの目覚ましい成功は、興味深い疑問を引き起こします。なぜなら、あるタスクでトレーニングされたモデルが、一見無関係に見える別のタスクで役立つ必要がある理由がアプリオリに不明瞭だからです。つまり、タスク a でのトレーニングがなぜタスク b で役立つ必要があるのかということです。 SSL (およびディープ ラーニング一般) を理論的に完全に理解することは困難でとらえどころがありませんが、この現象を抽象化レベルを問わず理解することは、より原理に基づいたアルゴリズムの開発に役立つ可能性があります。この記事の研究動機は次のとおりです: なぜ自己教師あり学習タスクのトレーニング (大量のラベルなしデータを使用) がデータ不足の下流タスクの解決に役立つのか? 「知識とスキル」を伝達する方法形式化された? 教師あり学習に関する文献は大量にありますが、教師あり学習における SSL タスク→下流タスクへの一般化は、トレーニング セット→テスト セットへの一般化とは根本的に異なります。たとえば、分類の下流タスクの教師あり学習の場合、未知の分布からサンプリングされた入力ラベルのペアのトレーニング セットでトレーニングされたモデルを、同じ分布からサンプリングされた未確認のテスト セットの評価に直接使用できます。この基本的な配布により、トレーニング セットからテスト セットへの接続が確立されます。ただし、SSL タスクで使用されるラベルなしデータにはダウンストリーム ラベルに関する明確な信号がないため、SSL タスク→ダウンストリーム タスクの概念的な接続はそれほど明確ではありません。これは、SSL タスクで事前トレーニングされたモデル (入力の残りから入力の一部を予測するなど) を下流のタスク (入力からクラス ラベルを予測するなど) で直接使用することはできないことを意味します。したがって、「知識とスキル」の伝達には、ラベル付きデータを使用した追加のトレーニング ステップが必要ですが、理想的には、ゼロからの教師あり学習に必要なステップよりも少なくなります。 SSL タスク→下流タスクの一般化を理論的に理解するには、次の質問に対処する必要があります:「ラベルのないデータの本質的な役割は何ですか?」および「下流タスクに事前トレーニングされたモデルをどのように使用するか?」この文書は、分類の下流タスクを対象としています。ラベルのないデータに対して分布の仮定を立て、表現学習のアイデアを使用してこれらの問題を研究します。 (a) (分布の仮定) ラベルのないデータの分布には、暗黙的に関連するデータが含まれています。対象となる下流の分類タスクに関する情報。 (b) (表現学習) 適切な SSL タスクで事前トレーニングされたモデルは、学習された表現を通じてその信号をエンコードでき、その後、下流の分類タスクを次の方法で解決できます。線形分類器。 ポイント (a) は、ラベルのない特定の構造特性が後続の下流タスクに関するヒントを暗黙的に提供し、自己教師あり学習がデータから学習してこのシグナルを明らかにするのに役立つことを示しています。 。ポイント (b) は、モデルの学習された表現を活用して、事前トレーニングされたモデルを使用するシンプルで経験的に効果的な方法を提案します。この論文では、ラベルなしデータの分布特性を特定して数学的に定量化し、対照学習、言語モデリング、自己予測などのさまざまな SSL 手法で適切な表現を学習できることを実証しています。次のセクションでは、表現学習のアイデアを詳しく掘り下げ、なぜ自己教師あり学習が下流のタスクに役立つのかを正式に説明します。

以上がなぜセルフモニタリングが効果的なのでしょうか? 243ページに及ぶプリンストン大学の博士論文「自己教師あり表現学習の理解」では、対比学習、言語モデリング、自己予測という3種類の手法について包括的に説明されている。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。