ホームページ >テクノロジー周辺機器 >AI >初めて「ティーチング ディレクター」がモデル蒸留に導入され、大規模な圧縮が 24 の SOTA メソッドよりも優れています。

初めて「ティーチング ディレクター」がモデル蒸留に導入され、大規模な圧縮が 24 の SOTA メソッドよりも優れています。

- PHPz転載

- 2023-04-14 15:46:031107ブラウズ

ますます高度化する深層学習モデルと大量のビデオビッグデータに直面して、人工知能アルゴリズムはコンピューティングリソースへの依存度を高めています。モデルの蒸留性とスパース性を調査することにより、深層モデルのパフォーマンスと効率を効果的に向上させるために、この論文では、「 学部長-教師-生徒」モデルに基づく統合モデル圧縮テクノロジを提案します。

この成果は、人民科学技術院と中国科学院オートメーション研究所の共同研究チームによって完成されました。この論文は、人工知能に関するトップ国際ジャーナルであるパターン分析と機械知能に関する IEEE トランザクション (TPAMI) に掲載されました。この成果は、モデル蒸留技術に「ティーチング ディレクター」の役割が初めて導入され、ディープ モデルの蒸留と仕立てが統合されたものです。

論文アドレス: https://ieeexplore.ieee.org/abstract/document/9804342

現在、この成果は人民科技が独自に開発したクロスモーダルインテリジェント検索エンジン「Baize」に応用されている。 「Baize」は、グラフィックス、テキスト、オーディオ、ビデオなどの異なるモダリティ間の情報表現の壁を打ち破り、ビデオを核として、テキスト、画像、音声、ビデオなどの異なるモダリティ情報を統一された特徴表現空間にマッピングします。複数のモダリティ 統合された距離測定を使用して、テキスト、音声、ビデオなどのマルチモーダル コンテンツの意味上のギャップを埋め、統合された検索機能を実現できます。しかし、膨大なインターネット データ、特にビデオ ビッグ データに直面して、クロスモーダル ディープ モデルによるコンピューティング リソースの消費は徐々に増加しています。この研究結果に基づいて、「Baize」はアルゴリズムのパフォーマンスを確保しながらモデルサイズを大規模に圧縮することができ、高スループットかつ低消費電力のクロスモーダルインテリジェントな理解と検索機能を実現します。予備的な実用化によると、この技術は大規模モデルのパラメータ スケールを平均で 4 倍以上圧縮できます。一方で、モデルによる GPU サーバーなどの高性能コンピューティング リソースの消費を大幅に削減でき、他方では、エッジにデプロイできない大規模なモデルを抽出および圧縮して、エッジ上での低電力デプロイメントを実現できます。角。

モデル圧縮のためのフェデレーテッド ラーニング フレームワーク

深いアルゴリズム モデルの圧縮と高速化は、蒸留学習または構造化されたスパース クリッピングを通じて実現できますが、これはどちらの領域にもいくつかの制限があります。蒸留学習方法の場合、軽量モデル (つまり、生徒ネットワーク) をトレーニングして、複雑で大規模なモデル (つまり、教師ネットワーク) をシミュレートすることを目的としています。教師ネットワークの指導の下で、生徒ネットワークは単独でトレーニングするよりも優れたパフォーマンスを達成できます。

ただし、蒸留学習アルゴリズムは、学生ネットワークのパフォーマンスの向上のみに焦点を当てており、多くの場合、ネットワーク構造の重要性を無視しています。学生ネットワークの構造は通常、トレーニング プロセス中に事前に定義され、固定されます。

構造化されたスパース クリッピングまたはフィルター クリッピングの場合、これらの方法は、冗長で複雑なネットワークをスパースでコンパクトなネットワークにクリップすることを目的としています。ただし、モデルのトリミングは、コンパクトな構造を取得するためにのみ使用されます。既存の方法はどれも、元の複雑なモデルに含まれる「知識」を最大限に活用していません。最近の研究では、モデルのパフォーマンスとサイズのバランスをとるために、蒸留学習と構造化されたスパース枝刈りを組み合わせています。ただし、これらの方法は損失関数の単純な組み合わせに限定されます。

上記の問題を詳しく分析するために、この研究ではまず圧縮センシングに基づいてモデルをトレーニングしました。モデルのパフォーマンスと構造を分析することで、2 つの重要な属性があることがわかりました。深いアルゴリズム モデルの場合: 蒸留性 蒸留性とスパース性。

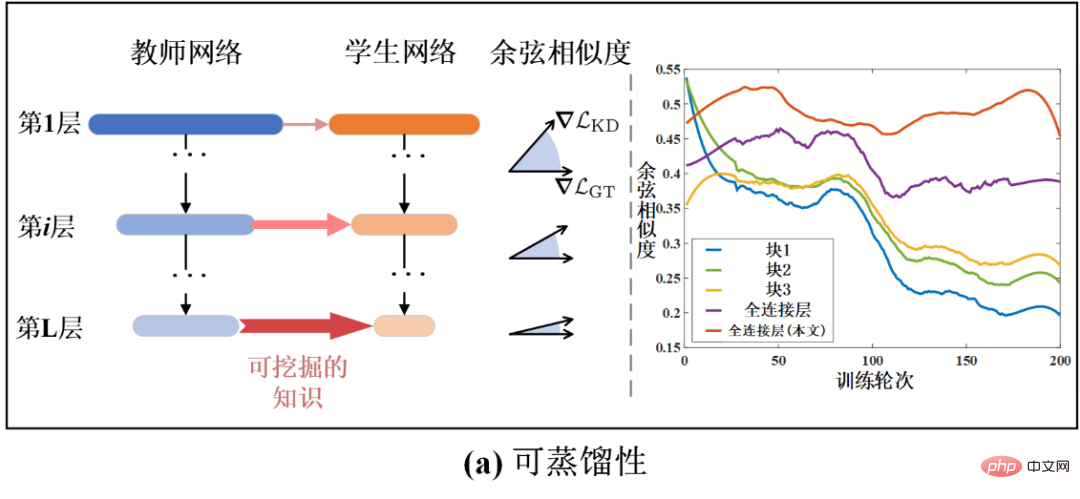

具体的には、抽出可能性は、教師ネットワークから抽出できる有効な知識の密度を指します。これは、教師ネットワークの指導の下で生徒ネットワークによって達成されるパフォーマンスの向上によって測定できます。たとえば、蒸留能力が高い学生ネットワークは、より高いパフォーマンスを達成できます。蒸留性はネットワーク層レベルで定量的に分析することもできます。

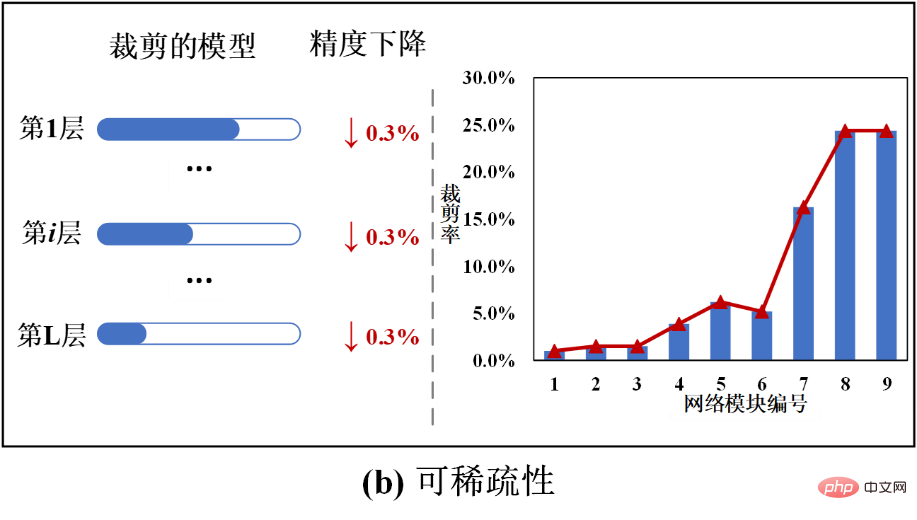

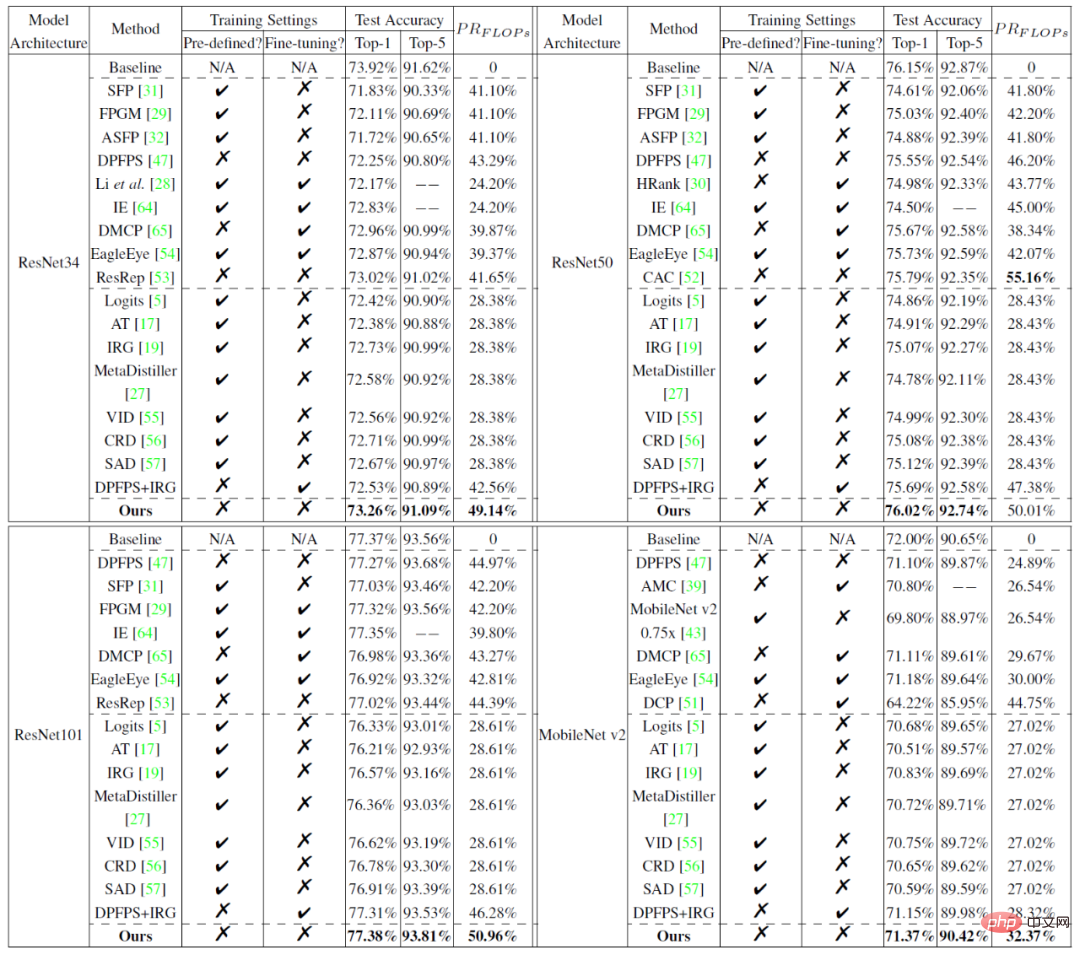

如圖 1-(a)所示,長條圖表示蒸餾學習損失梯度和真值分類損失梯度之間的餘弦相似度(Cosine Similarity)。更大的餘弦相似度說明目前蒸餾的知識對於模型性能更有幫助。這樣,餘弦相似度也可以成為可蒸餾性的一種度量。由圖 1-(a)可得,可蒸餾性隨著模型層數變深逐漸增加。這也解釋了為什麼常規使用蒸餾學習的監督均施加在模型最後幾層中。並且,在不同的訓練輪次,學生模型也有不同的可蒸餾性,因為隨著訓練時間變化餘弦相似度也在改變。因此,在訓練過程中對不同層進行可蒸餾性的動態分析十分必要。 另一方面,可稀疏性指的是模型在有限精度損失下能夠獲得的裁剪率(或稱為壓縮率)。更高的可稀疏性對應更高裁剪率的潛力。如圖 1-(b)所示,網路的不同層或模組展現了不同的可稀疏性。類似於可蒸餾性,可稀疏性也可以在網路層層級和時間維度進行分析。然而,目前沒有方法去探索和分析可蒸餾性和可稀疏性。現有方法常常使用一種固定的訓練機制,很難達到一個最優結果。 #圖1 深度神經網路的可蒸餾性和可稀疏性示意圖 為了解決上述問題,該研究分析了模型壓縮的訓練過程,從而獲得有關可蒸餾性和可稀疏性的相關發現。受這些發現啟發,該研究提出了一種基於動態可蒸餾性與可稀疏性聯合學習的模型壓縮方法。它能動態結合蒸餾學習和結構化稀疏裁剪,透過學習可蒸餾性和可稀疏性,自適應地調節聯合訓練機制。 與常規的「教師- 學生(Teacher-Student)」 框架不同,本文提出的方法能夠被描述成「在學校學習(Learning-in-School)」 框架,因為它包含三大模組:教師網絡,學生網絡和教導主任網絡。 具體而言,與之前相同,教師網路教導學生網路。而教導主任網絡負責控制學生網路學習的強度以及學習的方式。透過取得目前教師網路和學生網路的狀態,教導主任網路可以評估目前學生網路的可蒸餾性和可稀疏性,然後動態地平衡和控制蒸餾學習監督和結構化稀疏裁剪監督的強度。 為了優化本文方法,研究也提出一種基於交替方向乘子法的蒸餾學習 & 裁剪的聯合最佳化演算法,來更新學生網路。為了優化和更新教導主任網絡,本文提出一種基於元學習的教導主任優化演算法。借助動態調節監督訊號,反過來可蒸餾性也能被影響。如圖 1-(a)所示,本文方法證明能夠延緩可蒸餾性的下降趨勢,並且透過合理利用蒸餾的知識,提升了整體的可蒸餾性。 本文方法的整體演算法架構和流程圖如下圖所示。此架構包含三大模組,教師網絡,學生網絡和教導主任網絡。其中,初始的待壓縮裁剪的複雜冗餘網絡被看作教師網絡,而在後面的訓練過程中,逐漸被稀疏的原始網絡被看作是學生網絡。教導主任網絡是一個元網絡,它輸入教師網絡和學生網絡的資訊來衡量當前可蒸餾性和可稀疏性,從而控制蒸餾學習和稀疏的監督強度。 這樣,在每一時刻,學生網路都能被動態地蒸餾知識所引導和被稀疏。例如,當學生網路有更高的可蒸餾性,教導主任會讓更強的蒸餾監督訊號指導學生網路(見圖2 中粉紅色箭頭訊號);與此相反,當學生網路有更高的可稀疏性,教導主任會讓更強的稀疏監督訊號施加於學生網路中(見圖2 中橘色箭頭訊號)。 圖2 基於可蒸餾性與可稀疏性共同學習的模型壓縮演算法示意圖 實驗將本文提出的方法與24 種主流模型壓縮方法(包括稀疏裁切方法和蒸餾學習方法)在小規模資料集CIFAR 和大規模資料集ImageNet 上進行比較。實驗結果如下圖所示,結果證明本文所提方法的優越性。 表1 在CIFAR10 上的模型裁切結果效能比較:

以上が初めて「ティーチング ディレクター」がモデル蒸留に導入され、大規模な圧縮が 24 の SOTA メソッドよりも優れています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。