ホームページ >テクノロジー周辺機器 >AI >人間の作成者になりすますChatGPTやその他の悪用が懸念を引き起こす、AIが生成したテキスト検出方法をまとめた記事

人間の作成者になりすますChatGPTやその他の悪用が懸念を引き起こす、AIが生成したテキスト検出方法をまとめた記事

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-14 14:10:031277ブラウズ

自然言語生成 (NLG) テクノロジーの最近の進歩により、大規模な言語モデルによって生成されるテキストの多様性、制御、品質が大幅に向上しました。注目すべき例の 1 つは OpenAI の ChatGPT で、質問への回答、電子メール、論文、コードの作成などのタスクで優れたパフォーマンスを実証しています。ただし、テキストを効率的に生成するこの新たな機能は、フィッシング、偽情報、学術的不正などのタスクにおける大規模な言語モデルの誤用の検出と防止についての懸念も引き起こします。たとえば、生徒が ChatGPT を使用して宿題を書くことへの懸念から、ニューヨークの公立学校は ChatGPT の使用を禁止し、メディアも大規模な言語モデルによって生成されるフェイク ニュースについて警告を発しました。大規模な言語モデルの誤用に関するこうした懸念により、メディアや教育などの重要な分野での自然言語生成の適用が著しく妨げられています。

最近、大規模な言語モデルによって生成されたテキストを正しく検出するかどうか、またその方法について議論が増えています。この記事では、既存の検出方法についての包括的な技術的紹介を提供します。

- #論文アドレス: https://github.com/datamllab/The-Science- of-LLM-generated-Text-Detection

- 関連研究アドレス: https://github.com/datamllab/awsome-LLM-generated-text-detection /tree/main

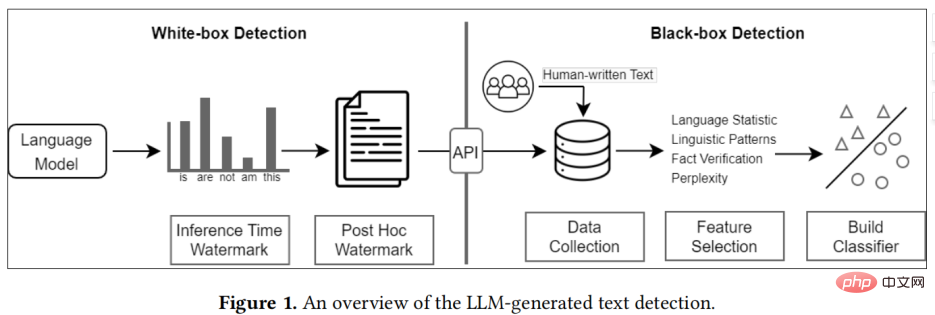

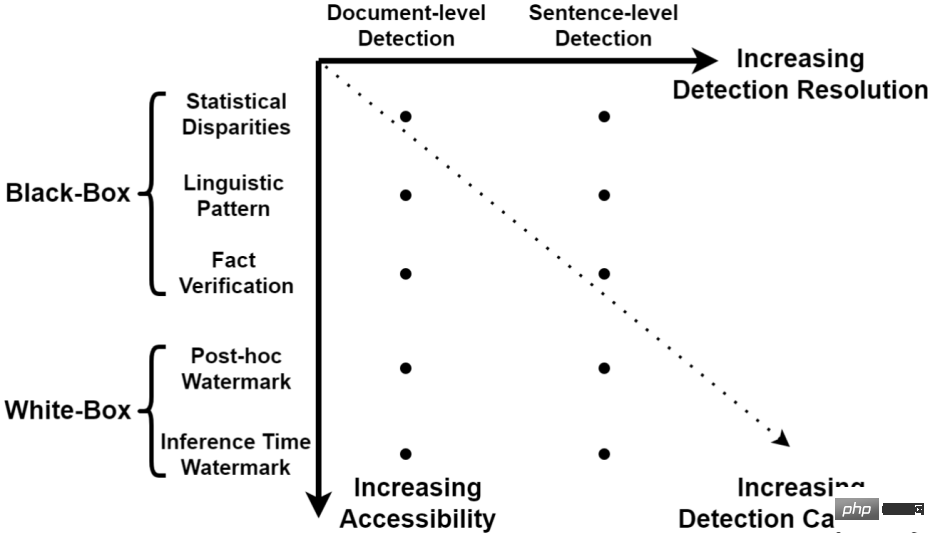

既存の手法は大きく 2 つのカテゴリに分類できます: ブラック ボックス検出とホワイト ボックス検出# # #。

##ブラック ボックス検出メソッドでは、通常、大規模な言語モデルへの API レベルのアクセスのみが可能です。したがって、このタイプのアプローチは、人間と機械からテキスト サンプルを収集して分類モデルをトレーニングすることに依存しています。

- #ホワイトボックス検出では、このタイプのアプローチは大規模な言語モデルにすべてアクセスでき、モデルの生成動作を制御したり、生成されたテキストに透かしを追加したりすることで、生成されたテキストを追跡および検出できます。

- 実際には、ブラックボックス検出器は通常、GPTZero などのサードパーティによって構築されますが、ホワイトボックス検出器は通常、大規模な言語モデル開発者によって構築されます。

生成されたテキスト検出分類法BlackBoxDetection

ブラック ボックス検出には通常、データ収集、特徴選択、モデル確立という 3 つのステップがあります。。 ヒューマンテキストの収集には、データ収集のために専門家を雇う方法がありますが、この方法は時間と労力がかかるため、大規模なデータの収集には適していませんより効率的な方法は、ウィキペディアからさまざまな専門家によって編集されたエントリを収集したり、Reddit などのメディアからデータを収集したりするなど、既存の人文テキスト データを使用することです。

特徴の選択は、一般に統計的特徴、言語的特徴、事実的特徴に分けられます。統計的特徴は通常、大規模な言語モデルによって生成されたテキストが、一般的に使用されるテキスト統計指標における人間のテキストと異なるかどうかを確認するために使用されます。一般的に使用されるものには、TFIDF、Zipf's Law

などが含まれます。言語特徴は通常、品詞、依存関係分析、感情分析などの言語特徴を探します。最後に、大規模な言語モデルは事実に反するステートメントを生成することが多いため、事実検証は、大規模な言語モデルによって生成されたテキストを区別する情報を提供することもできます。 既存の分類モデルは、通常、SVM などの従来の機械学習モデルに分類されます。最新の研究ではBERTやRoBERTaなどの言語モデルをバックボーンとして利用する傾向があり、より高い検出性能を実現しています。

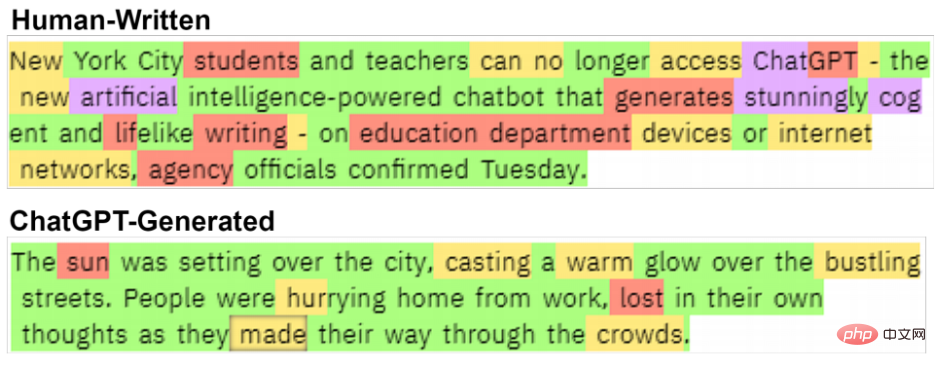

#2 つのテキストには明らかな違いがあります。 Chalkbeat New York からの人が書いたテキスト。

ホワイト ボックス検出ホワイト ボックス検出は、通常、大規模な言語モデル開発者によって提供される検出がデフォルトで使用されます。ブラックボックス検出とは異なり、ホワイトボックス検出はモデルに完全にアクセスできるため、検出の目的を達成するためにモデルの出力を変更することで透かしを埋め込むことができます。

現在の検出方法は、 事後ウォーターマークと推論時間ウォーターマークに分類できます:

- 事後ウォーターマークは、大規模言語モデルがテキストを生成した後、その後の検出のためにテキストに隠された情報を追加します;

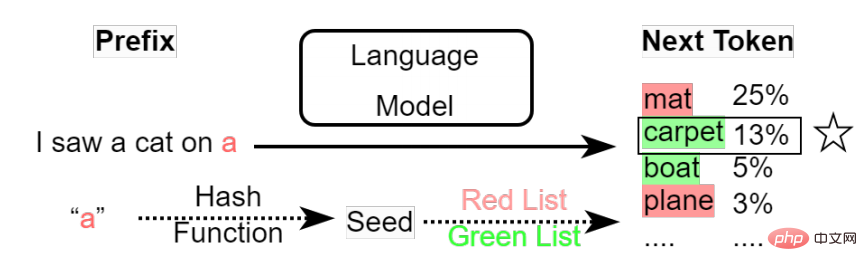

- 推論時間ウォーターマーク大規模言語モデルのトークン サンプリング メカニズムを変更してウォーターマークを追加することです。大規模言語モデルによる各トークンの生成プロセスでは、すべてのトークンの確率と事前に設定されたサンプリング戦略に基づいて、次に生成される単語が選択されます。選択の過程で透かしを追加できます。

#推論時間のウォーターマーク作者

(1)ブラック ボックス モデルの場合、データ収集は非常に重要なステップですが、このプロセスは偏見を持ち込むのは非常に簡単です。たとえば、既存のデータセットは主に、質疑応答やストーリー生成などのいくつかのタスクに焦点を当てており、これにより主題のバイアスが生じます。さらに、大規模なモデルによって生成されたテキストは、固定のスタイルまたは形式を持つことがよくあります。これらのバイアスは、ブラック ボックス分類器によって分類の主な特徴として使用されることが多く、検出の堅牢性が低下します。

大規模言語モデルの機能が向上するにつれて、大規模言語モデルによって生成されたテキストと人間との間のギャップはますます小さくなり、その結果、黒の検出精度が低下します。 -ボックスモデルはますます低くなり、したがって、ホワイトボックス検出は、将来的により有望な検出方法になります。

(2)既存の検出方法はデフォルトで会社が所有する大規模な言語モデルを使用するため、すべてのユーザーが同社の大規模言語モデル サービスは API を介して提供されており、この多対 1 の関係は、検出システムの展開に非常に役立ちます。しかし、もし同社が大規模な言語モデルをオープンソース化した場合、既存の検出方法のほとんどすべてが無効になってしまうでしょう。

ブラック ボックス検出の場合、ユーザーはモデルを微調整したり、モデル出力のスタイルや形式を変更したりできるため、ブラック ボックス検出では一般的な検出機能を見つけることができません。

ホワイト ボックス検出が解決策になる可能性があるため、企業はオープンソースにする前にモデルにウォーターマークを追加できます。ただし、ユーザーはモデルを微調整したり、モデル トークンのサンプリング メカニズムを変更してウォーターマークを削除したりすることもできます。現在、これらの潜在的な脅威からユーザーを保護できる透かし技術はありません。

以上が人間の作成者になりすますChatGPTやその他の悪用が懸念を引き起こす、AIが生成したテキスト検出方法をまとめた記事の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。