ヒントンの最新の講演を 1 万人近くが視聴しました: 順方向ニューラル ネットワーク トレーニング アルゴリズム、論文が公開されました

NeurIPS 2022 カンファレンスが本格化しています。あらゆる分野の専門家や学者が、深層学習、コンピューター ビジョン、大規模機械学習、学習理論、最適化、希薄な理論。

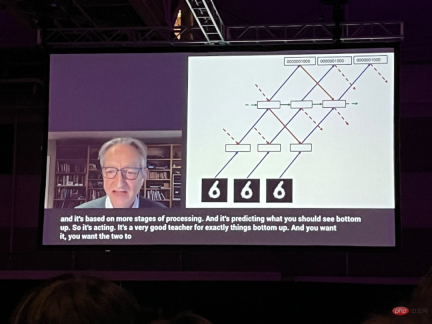

この会議では、チューリング賞受賞者でディープラーニングのパイオニアであるジェフリー・ヒントン氏が、10年前に卒業生と共著した論文「ImageNet分類」を表彰するスピーチをするよう招待されました。学生の Alex Krizhevsky と Ilya Sutskever. with Deep Convolutional Neural Networks」は、この分野への「多大な影響」によりタイムテスト賞を受賞しました。 2012 年に発表されたこの成果は、畳み込みニューラル ネットワークが ImageNet 画像認識コンテストで初めて人間レベルのパフォーマンスを達成したものであり、人工知能の第 3 波を開始する重要な出来事でした。

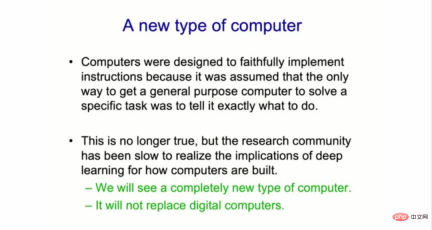

ヒントン氏の講演のテーマは「ディープ ニューラル ネットワークをトレーニングするための順方向アルゴリズム」です。ジェフリー・ヒントン氏は講演の中で、「機械学習の研究コミュニティは、コンピューターの構築方法に対するディープラーニングの影響をなかなか認識していない。」と述べ、機械学習の形式は 人工的なものであると信じています。インテリジェンスはコンピュータ システムの革命を引き起こすでしょう。、これは AI を「トースターに」組み込む、ソフトウェアとハードウェアの新しい組み合わせです。

彼は続けて、「まったく異なる種類のコンピューターが登場すると思いますが、それは数年以内には実現できないでしょう。しかし、取り組むべき十分な理由があります。」このまったく異なる種類のコンピューター上で。" コンピューター。"

まったく異なる新しいタイプのコンピューターの構築

すべてのデジタル コンピューターこれまでのソフトウェアは「不滅」(不滅)になるように構築されており、どこでも同じソフトウェアを実行できるように、ハードウェアが非常に信頼性が高くなるように設計されています。 「異なる物理ハードウェア上で同じプログラムを実行でき、その知識は不滅です。」

ヒントン氏は、この設計要件は、デジタル コンピュータが「ハードウェアのさまざまな側面を見逃していることを意味します」と述べました。 「可変、ランダム、不安定、シミュレートされた、信頼性の低いプロパティ」は、私たちにとって非常に役立つ可能性があります。

ヒントン氏の見解では、将来のコンピュータ システムは異なるアプローチをとるでしょう。それらは「ニューロモーフィック」であり、通常の (死すべき) ものになるでしょう 。これは、デジタル コンポーネントではなくアナログ コンポーネントを備えているという意味で、すべてのコンピューターがニューラル ネットワーク ソフトウェアとばらばらのハードウェアを緊密に組み合わせたものになることを意味しており、不確実性の要素が含まれ、時間の経過とともに進化する可能性があります。

ヒントン氏は次のように説明しました。「今の代替案は、ハードウェアとソフトウェアの分離を放棄することですが、コンピュータ科学者はそれを本当に好みません。 . ."

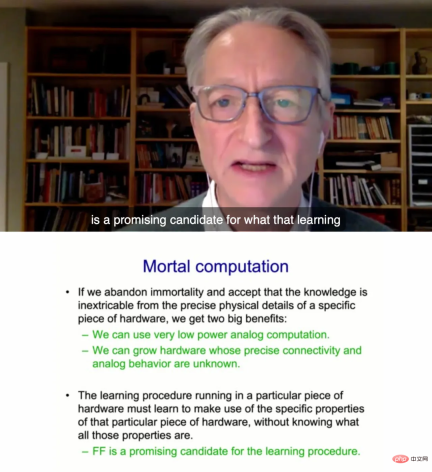

いわゆる致命的な計算は、システムによって学習された知識がハードウェアから切り離せないことを意味します。これらの通常のコンピュータは、高価なチップ製造工場から「成長」する可能性があります。

ヒントン氏は、これを実行すると、非常に低電力のアナログ計算を使用し、メモリスタの重みを使用してテラスケールの並列処理を実行できると指摘しています。これは、非線形回路コンポーネントに基づいた数十年前の実験チップを指します。さらに、ハードウェアのさまざまなビットの正確な動作の正確な品質を理解せずにハードウェアを進化させることもできます。

しかし、ヒントン氏はまた、新しい普通のコンピューターは従来のデジタルコンピューターに取って代わるものではないとも述べ、「銀行口座を管理するコンピューターではないし、あなたの銀行口座がいくらあるか正確に把握することもできない」と述べた。持っています。" お金。"

この種のコンピューターは、他のものを入れる (つまり、処理する) ために使用されます。1 ドルを使用して GPT-3 のようなものをトースターに入れることができます。中" , したがって、わずか数ワットの電力を使用してトースターと通信できます。

通常のコンピューティング ハードウェアに適した FF ネットワーク

この講演で、ヒントンは、彼がそれと呼んだ新しいニューラル ネットワーク手法について話すことにほとんどの時間を費やしました。は、ほぼすべてのニューラル ネットワークで使用されるバックプロパゲーション手法に代わる、順方向 (FF) ネットワークです。ヒントンは、バックプロパゲーションを取り除くことで、順方向ネットワークは現実の脳内で起こっていることをより合理的に近似できる可能性があると提案しました。

この論文の草稿は、トロント大学のヒントンのホームページに掲載されています:

論文リンク: https://www.cs.toronto.edu/~hinton/FFA13.pdf

ヒントン氏は、FF 手法がより適している可能性があると述べています。通常のコンピューティング ハードウェア。 「現時点でこのようなことを行うには、独自のハードウェアで実行される学習プログラムが必要です。また、その独自のハードウェアの特定の特性をすべて把握することなく、その特性を活用する方法を学習する必要があります。しかし、私は、新しいアナログ コンピュータを構築する際の障害の 1 つは、何百万ものデバイス上でソフトウェアを実行する際の信頼性が重要視されていることである、と同氏は述べました。 「これらの電話はそれぞれ、赤ちゃん用の電話として出発し、電話になる方法を学ばなければなりません」とヒントン氏は語った。 「そして、それは非常に苦痛です。」

最も熟練したエンジニアであっても、不確実性を恐れて、完璧で同一の不滅のコンピューターを諦めることには消極的です。

ヒントン氏は次のように述べています。「アナログ コンピューティングに興味を持っていても、不滅を喜んで放棄する人はまだほとんどいません。これは、一貫性や予測可能性への執着によるものです。しかし、もしあなたがアナログ ハードウェアに毎回同じことをしてもらいたいと思うと、遅かれ早かれ、この混乱による本当の問題に遭遇することになります。」

論文の内容

論文の中で, ヒントンは、新しいニューラル ネットワーク学習手順を導入し、いくつかの小さな問題に対しては十分に機能することを実験的に実証しました。具体的な内容は次のとおりです。バックプロパゲーションの問題点は何ですか?

過去 10 年間にわたる深層学習の成功により、多数のパラメーターと大量のデータを使用して確率的勾配降下法を実行する有効性が確立されました。通常、勾配はバックプロパゲーションによって計算されます。そのため、脳がバックプロパゲーションを実装しているかどうか、あるいは接続の重みを調整するために必要な勾配を取得する他の方法があるかどうかについて関心が集まっています。大脳皮質がどのように学習するかのモデルとして、バックプロパゲーションを実際のニューロンのように実装するためにかなりの努力が払われているにもかかわらず、バックプロパゲーションは依然として信じがたいことです。現在、大脳皮質が誤差導関数を明示的に伝播したり、後続の逆伝播で使用するために神経活動を保存したりするという説得力のある証拠はありません。ある皮質領域から視覚経路の以前の領域へのトップダウン接続は予想どおりではありませんでした。つまり、視覚系でバックプロパゲーションが使用された場合、ボトムアップ接続が発生します。代わりに、神経活動が 2 つの領域にある約 6 層の皮質層を通過し、その後開始場所に戻るループを形成します。

時間によるバックプロパゲーションは、シーケンスを学習する方法としては特に信頼できません。頻繁なタイムアウトを発生させずに一連の感覚入力を処理するには、脳が感覚処理のさまざまな段階を通じて感覚データをパイプライン処理する必要があり、「その場で」学習できる学習プログラムが必要です。パイプラインの後の段階での表現は、後続のタイム ステップでパイプラインの初期の段階での表現に影響を与えるトップダウンの情報を提供する可能性がありますが、知覚システムはバックプロパゲーションの実行を停止することなく、リアルタイムで推論して学習する必要があります。

バックプロパゲーションのもう 1 つの重大な制限は、正しい導関数を計算するためにフォワード パスで実行される計算に関する完全な知識が必要であることです。順方向パスにブラック ボックスを挿入すると、ブラック ボックスの微分可能モデルを学習しない限り、バックプロパゲーションは不可能になります。これから説明するように、ブラック ボックスを介して逆伝播する必要がないため、ブラック ボックスは FF アルゴリズムの学習手順をまったく変更しません。

完璧なフォワード パス モデルがない場合は、多くの形式の強化学習のうちの 1 つに頼る可能性があります。このアイデアは、重みまたは神経活動に対してランダムな摂動を実行し、これらの摂動をペイオフ関数の変化に関連付けることです。しかし、強化学習プログラムには高い変動性があります。他の多くの変数が同時に摂動されると、1 つの変数を摂動させる効果を確認するのは困難です。他のすべての摂動によって引き起こされるノイズを平均化するには、学習率が摂動される変数の数に反比例する必要があります。これは、強化学習の拡張性が低く、数百万または数十億の変数を含む大規模ネットワークの逆と比較できないことを意味します。パラメータ、コミュニケーション競争。

この論文の要点は、未知の非線形性を含むニューラル ネットワークは強化学習に頼る必要がないということです。 FF アルゴリズムは、速度の点ではバックプロパゲーションに匹敵しますが、順方向計算の正確な詳細が不明な場合に使用できるという利点があります。また、ニューラル アクティビティを保存したり、エラー導関数の伝播を停止したりすることなく、ニューラル ネットワークを介して順次データをパイプライン処理しながら学習できるという利点もあります。

一般に、FF アルゴリズムはバックプロパゲーションよりも遅く、その一般化はこの記事で検討したいくつかのおもちゃの問題にとって理想的ではないため、電力が低い場合にはバックプロパゲーションを置き換える可能性は低いです。制限が多すぎるアプリケーションでは。非常に大規模なデータセットでトレーニングされた非常に大規模なモデルの場合、このタイプの探索では引き続きバックプロパゲーションが使用されます。 FF アルゴリズムは、大脳皮質の学習モデルとして、および強化学習に頼らずに非常に低電力のシミュレーション ハードウェアを使用するモデルとして、という 2 つの点でバックプロパゲーションよりも優れている可能性があります。

FF アルゴリズム

Forward-Forward アルゴリズムは、ボルツマン マシンとノイズ対比推定にヒントを得た貪欲な多層学習手順です。 アイデアは、バックプロパゲーションの前方パスと後方パスを 2 つの前方パスを使用して置き換えることです。 これら 2 つの前方パスはまったく同じ方法です。それぞれで操作します。他にも、異なるデータを使用し、反対の目標を持ったものもあります。このうち、ポジティブ パスは実際のデータを操作し、各隠れ層の良さを高めるように重みを調整します。ネガティブ パスは負のデータを操作し、各隠れ層の良さを減らすように重みを調整します。

論文の中で、ヒントンは CIFAR-10 での実験を通じて FF アルゴリズムのパフォーマンスを実証しました。

CIFAR-10 には、サイズが 32 x 32 ピクセルで、ピクセルごとに 3 つのカラー チャネルがある 50,000 個のトレーニング画像が含まれています。したがって、各画像の次元は 3072 になります。これらの画像の背景は複雑で非常に変化しやすいため、このような限られたトレーニング データでは適切にモデル化できません。一般に、2 ~ 3 つの隠れ層を持つ完全に接続されたネットワークがバックプロパゲーション法を使用して学習される場合、隠れ層が非常に小さい場合を除き、過剰適合効果は非常に低いため、報告されるほぼすべての結果は畳み込みネットワークに関するものです。

FF は重み共有が実現できないネットワークでの使用を目的としているため、局所的な受容野を使用して重みの数を制限するバックプロパゲーション ネットワークと比較されましたが、過度に制限することはありませんでした。隠しユニットの数。目的は単に、多数の隠れユニットを使用して、非常に変化しやすい背景を含む画像に対して FF がバックプロパゲーションと同等のパフォーマンスを発揮することを示すことです。

表 1 は、バックプロパゲーションと FF でトレーニングされたネットワークのテスト パフォーマンスを示しています。どちらも過学習を減らすために重み減衰を使用しています。

研究の詳細については、元の論文を参照してください。

以上がヒントンの最新の講演を 1 万人近くが視聴しました: 順方向ニューラル ネットワーク トレーニング アルゴリズム、論文が公開されましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

AIゲーム開発は、激動の夢想家ポータルでエージェントの時代に入りますMay 02, 2025 am 11:17 AM

AIゲーム開発は、激動の夢想家ポータルでエージェントの時代に入りますMay 02, 2025 am 11:17 AM激動ゲーム:AIエージェントとのゲーム開発に革命をもたらします BlizzardやObsidianなどの業界の巨人の退役軍人で構成されるゲーム開発スタジオであるUpheavalは、革新的なAIを搭載したPlatforでゲームの作成に革命をもたらす態勢を整えています。

UberはあなたのRobotaxiショップになりたいと思っています、プロバイダーはそれらを許可しますか?May 02, 2025 am 11:16 AM

UberはあなたのRobotaxiショップになりたいと思っています、プロバイダーはそれらを許可しますか?May 02, 2025 am 11:16 AMUberのRobotaxi戦略:自動運転車用の乗車エコシステム 最近のCurbivore Conferenceで、UberのRichard Willderは、Robotaxiプロバイダーの乗車プラットフォームになるための戦略を発表しました。 で支配的な位置を活用します

ビデオゲームをプレイするAIエージェントは、将来のロボットを変革しますMay 02, 2025 am 11:15 AM

ビデオゲームをプレイするAIエージェントは、将来のロボットを変革しますMay 02, 2025 am 11:15 AMビデオゲームは、特に自律的なエージェントと現実世界のロボットの開発において、最先端のAI研究のための非常に貴重なテストの根拠であることが証明されています。 a

スタートアップインダストリアルコンプレックス、VC 3.0、およびジェームズクーリエのマニフェストMay 02, 2025 am 11:14 AM

スタートアップインダストリアルコンプレックス、VC 3.0、およびジェームズクーリエのマニフェストMay 02, 2025 am 11:14 AM進化するベンチャーキャピタルの景観の影響は、メディア、財務報告、日常の会話で明らかです。 ただし、投資家、スタートアップ、資金に対する特定の結果はしばしば見落とされています。 ベンチャーキャピタル3.0:パラダイム

AdobeはAdobe Max London 2025でクリエイティブクラウドとホタルを更新しますMay 02, 2025 am 11:13 AM

AdobeはAdobe Max London 2025でクリエイティブクラウドとホタルを更新しますMay 02, 2025 am 11:13 AMAdobe Max London 2025は、アクセシビリティと生成AIへの戦略的シフトを反映して、Creative Cloud and Fireflyに大幅な更新を提供しました。 この分析には、イベント以前のブリーフィングからの洞察がAdobeのリーダーシップを取り入れています。 (注:ADOB

すべてのメタがラマコンで発表しましたMay 02, 2025 am 11:12 AM

すべてのメタがラマコンで発表しましたMay 02, 2025 am 11:12 AMMetaのLlamaconアナウンスは、Openaiのような閉じたAIシステムと直接競合するように設計された包括的なAI戦略を紹介し、同時にオープンソースモデルの新しい収益ストリームを作成します。 この多面的なアプローチはBOをターゲットにします

AIは単なる通常のテクノロジーに過ぎないという提案に関する醸造論争May 02, 2025 am 11:10 AM

AIは単なる通常のテクノロジーに過ぎないという提案に関する醸造論争May 02, 2025 am 11:10 AMこの結論に関して、人工知能の分野には深刻な違いがあります。 「皇帝の新しい服」を暴露する時が来たと主張する人もいれば、人工知能は普通の技術であるという考えに強く反対する人もいます。 それについて議論しましょう。 この革新的なAIブレークスルーの分析は、AIの分野での最新の進歩をカバーする私の進行中のForbesコラムの一部です。 一般的な技術としての人工知能 第一に、この重要な議論の基礎を築くためには、いくつかの基本的な知識が必要です。 現在、人工知能をさらに発展させることに専念する大量の研究があります。全体的な目標は、人工的な一般情報(AGI)を達成し、さらには可能な人工スーパーインテリジェンス(AS)を達成することです

モデル市民、なぜAI価値が次のビジネスヤードスティックであるのかMay 02, 2025 am 11:09 AM

モデル市民、なぜAI価値が次のビジネスヤードスティックであるのかMay 02, 2025 am 11:09 AM企業のAIモデルの有効性は、現在、重要なパフォーマンス指標になっています。 AIブーム以来、生成AIは、誕生日の招待状の作成からソフトウェアコードの作成まで、すべてに使用されてきました。 これにより、言語modが急増しました

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

WebStorm Mac版

便利なJavaScript開発ツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

ホットトピック

7906

7906 15

15 1652

1652 14

14 1411

1411 52

52 1303

1303 25

25 1248

1248 29

29