2020 年 5 月のリリース以来、約 2 年半の間、GPT-3 は、その魔法のようなテキスト生成機能の恩恵により、人間が非常に上手に文章を書くのを支援することができました。

しかし、最終的には、GPT-3 はテキスト生成モデルであり、人間の執筆プロセスとはまったく異なるものであると言えます。

たとえば、論文や作文を書きたい場合、まず頭の中でフレームワークを構築し、関連する情報を確認して下書きを作成し、その後、テキストを常に修正して磨き上げてくれる家庭教師を見つける必要があります。この期間中にアイデアを修正することもあり、最終的にはそれが良い記事になる可能性があります。

生成モデルによって取得されるテキストは、文法要件を満たすことしかできませんが、内容の配置にロジックがなく、自己修正機能もないため、AI が自律的に記述できるようになるのはまだ遠いです。

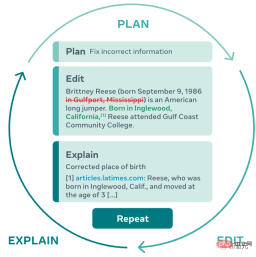

最近、メタ AI リサーチとカーネギー メロン大学の研究者は、人間の執筆プロセスを完全にシミュレートする新しいテキスト生成モデル PEER (Plan、Edit Edit、Explain、Repeat) を提案しました。テキストを編集して繰り返します。

論文アドレス: https://arxiv.org/abs/2208.11663

PEER は、従来の言語モデルが解決できる問題を解決します生成のみ 最終的には生成されたテキストを制御できなくなりますが、自然言語コマンドを入力することで、PEER は生成されたテキストを変更できます。

最も重要なことは、研究者が PEER の複数のインスタンスをトレーニングしたことです。PEER は、書き込みプロセスで複数のリンクを埋めることができるため、自己トレーニングを使用できるようになります) テクノロジートレーニング データの質、量、多様性が向上します。

トレーニング データを生成できるということは、PEER の可能性がエッセイの執筆をはるかに超えていることを意味します。PEER は履歴を編集せずに他の分野でも使用でき、指示に従い、有益なコメントを書き、そしてその行動能力について説明します。

NLP はバイオニクスにも適用されます

自然言語による事前トレーニングの後、大規模ニューラル ネットワークのテキスト生成効果はすでに非常に強力ですが、これらのモデルの生成方法は基本的に結果として得られるテキストを一度に出力することは、人間が反復的に書くプロセスとは大きく異なります。

ワンタイム生成には、テキスト内の文章を遡って修正・改良することができない、また、なぜその文章が生成されたのかを説明できないなどのデメリットも多くあります。また、生成されたテキストの正確性をテストすることも難しく、結果にエラーが発生することが多く、幻覚的なコンテンツ、つまり事実と一致しないテキストが生成されます。これらの欠陥は、一貫性のある事実に基づいたテキストを必要とする人間と協力して書くモデルの能力も制限します。

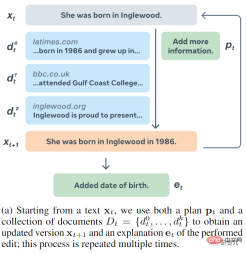

PEER モデルはテキストの「編集履歴」に基づいてトレーニングされ、モデルが人間の執筆プロセスをシミュレートできるようになります。

1. PEER モデルの実行中、ユーザーまたはモデルは計画 (Plan) を指定し、実行したいアクション (アクション) を自然言語で記述する必要があります。情報の追加や文法エラーの修正など;

2. 次に、テキストを編集してこのアクションを実行します;

3. モデルは自然言語で説明し、関連リソースを示すことができます ( Explain) テキストの最後に参照を追加するなど、この編集の結果;

4. 生成されたテキストをさらに更新する必要がなくなるまで、このプロセスを繰り返します。

この反復的なアプローチにより、モデルは、一貫性があり、一貫性があり、事実に基づいたテキストを記述するという複雑なタスクを複数のより簡単なサブタスクに分割できるだけでなく、人間が生成プロセスにより深く関与できるようになります。モデルを正しい方向に導き、ユーザーに計画やコメントを提供したり、自分でモデルの編集を開始したりする時間ができます。

メソッドの説明から、関数を実現する上で最も難しいことは、Transformer を使用してモデルを構築することではなく、トレーニング データを見つけて必要なデータを見つけることであることがわかります。大規模な言語をトレーニングする方法を見つけること ほとんどの Web サイトでは編集履歴が提供されていないため、このプロセスに必要なデータをモデルに必要な規模で学習することは明らかに困難であり、クローラーを通じて取得した Web ページをトレーニング データとして使用することはできません。

クローラーを介して同じ Web ページを異なる時点で編集履歴として取得することさえ、編集を計画または説明する関連テキストがないため、現実的ではありません。

PEER は、これまでの反復編集手法と似ており、一次編集および関連コメントのデータ ソースとして Wikipedia を使用します。これは、Wikipedia がさまざまなトピックに関するコメントを含む編集の完全な履歴を提供し、記事の規模が大きいためです。多くの場合、引用文が含まれており、関連文書を見つけるのに役立ちます。

しかし、トレーニング データの唯一のソースとして Wikipedia のみに依存することには、さまざまな欠点もあります:

1. Wikipedia のみを使用してトレーニングされたモデルは、予想されるテキスト コンテンツと予測計画に悪影響を及ぼします。編集は Wikipedia と同様にする必要があります;

2. Wikipedia のコメントはノイズが多いため、多くの場合、コメントは計画や説明に適切な入力ではありません;

3. Wikipedia の多くの文章この背景情報の欠如は検索システムを使用することで補うことができますが、そのようなシステムでさえ、多くの編集者にとってサポートとなる背景情報を見つけることができない場合があります。

研究者らは、Wikipedia がコメント編集履歴の唯一のソースであることによって引き起こされるすべての問題を解決する簡単な方法を提案しました。それは、複数の PEER インスタンスをトレーニングし、これらのインスタンスを使用して編集プロセスのさまざまな側面を設定する方法を学習するというものです。これらのモデルを使用して、トレーニング コーパスの欠落部分の代替として合成データを生成できます。

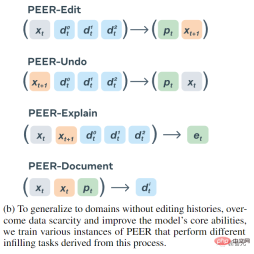

最終的にトレーニングされた 4 つのエンコーダー/デコーダー モデル:

1. PEER-Edit の入力はテキスト x と一連のドキュメント、およびモデル出力です。は計画と編集されたテキストです。p は計画されたテキストです。

2. PEER-Undo の入力は編集されたテキストとドキュメントのセットであり、モデルの出力は編集を元に戻すかどうかです。

3. PEER-Explain は編集の説明を生成するために使用され、入力はソース テキスト、編集されたテキスト、および一連の関連ドキュメントです。

4. PEER-Document はソース テキスト、編集されたテキスト、および計画を入力し、モデル出力はこの編集で最も役立つ背景情報です。

PEER のすべてのバリアント モデルは、欠落部分を補うトレーニング データの生成と、既存データの「低品質」部分の置き換えの両方で、合成データを生成するために使用されます。

テキストに編集履歴がない場合でも、任意のテキスト データをトレーニングできるようにするために、PEER-Undo を使用して合成「逆方向」編集を生成します。つまり、PEER-Undo が繰り返し適用されます。テキストが空になるまでソース テキストを編集し、その後 PEER-Edit を呼び出して逆方向にトレーニングします。

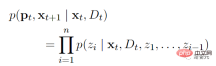

計画を生成するときは、PEER-Explain を使用して、コーパス内の多くの低品質のコメントを修正するか、コメントのないテキストを処理します。 PEER-Explainの出力から複数の結果を「潜在的なプラン」としてランダムにサンプリングし、実際に編集される可能性を計算し、最も確率の高いものを新しいプランとして選択します。

特定の編集操作に関連するドキュメントが見つからない場合は、PEER-Document を使用して、編集操作を実行するための情報を含む一連の合成ドキュメントを生成します。最も重要なことは、PEER-Edit はこれをトレーニング中にのみ実行し、推論段階では合成ドキュメントを提供しないことです。

生成された計画、編集、ドキュメントの品質と多様性を向上させるために、研究者らは、トレーニング中のモデルによって生成された出力シーケンスに特定の制御マーカーをプリセットしてから推論する制御メカニズムも実装しました。これらの制御タグは、モデルの生成をガイドするプロセスで使用されます。タグには次のものが含まれます:

1. type は、PEER-Explain によって生成されるテキスト タイプを制御するために使用されます。オプションの値は命令 (出力) to 不定詞で始まる必要があります。.. ..) およびその他;

2, length, PEER-Explain の出力長を制御します。オプションの値には、s (2 ワード未満)、m (2- 3 単語)、l (4 ~ 5 単語)、および

4. 単語、ソース テキストと PEER-Undo の編集済みテキストの間の異なる単語の数を制御するために使用されます。オプションの値はすべて整数です。##5. を含む、PEER-Undo Document によるテキスト出力に特定の部分文字列が含まれていることを確認するために使用されます

PEER は、PEER 編集に制御文字を導入しません。ユーザーがモデルを使用して解決できる編集タスクの種類を決定し、モデルの汎用性を高めます。

実験的比較フェーズでは、PEER はトレーニング前の初期化に LM-Adapted T5 の 3B パラメーター バージョンを使用します。

一連の計画に従い、提供されたドキュメントを利用し、さまざまなドメイン、特に編集履歴のないドメインで編集を行う PEER の能力を評価するために、新しいデータセットが導入されます。さまざまなテキスト タイプとドメインに合わせて編集します。

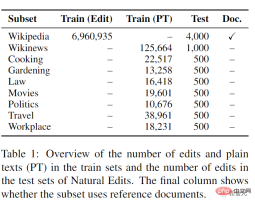

データは、Wikipedia の百科事典ページ、Wikinews のニュース記事、料理、園芸、法律、映画、政治、旅行、職場に関する StackExchange サブフォーラムの 3 つの英語 Web ソースから収集されました。問題の収集、これらすべてのサイト編集者の意図を詳述するコメントを含む編集履歴を提供し、それを計画としてモデルにフィードします。

Wikinews と StackExchange サブセットのトレーニングでは、実際の編集ではなくプレーン テキスト データのみが提供されるため、編集履歴のない領域での編集能力がテストされます。

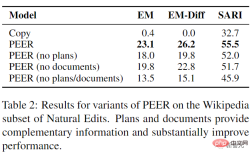

実験結果は、PEER のパフォーマンスがすべてのベースラインをある程度上回っていることを示しており、計画とドキュメントはモデルで使用できる補足情報を提供します

# Natural Edits のすべてのサブセットで PEER を評価すると、計画がドメイン間で大きく役立つことが明らかになり、Wikipedia 編集における計画を理解する能力は他のドメインに直接応用できることが示唆されます。重要なのは、PEER のドメイン適応バリアントは、Natural Edits のすべてのサブセットで通常の PEER よりも大幅に優れており、特にガーデニング、政治、映画のサブセットで大幅な改善が見られます (それぞれ 84%、71%)。 Diff) は、異なるドメインで PEER を適用する場合に合成編集を生成することの有効性も示しています。

以上が論文を 100 回改訂しても慌てる必要はありません。 Meta が新しい記述言語モデル PEER をリリース: 参照が追加されますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ChatGPTが使えない!原因とすぐ試せる対処法を解説【2025年最新】May 14, 2025 am 05:04 AM

ChatGPTが使えない!原因とすぐ試せる対処法を解説【2025年最新】May 14, 2025 am 05:04 AMChatGptはアクセスできませんか?この記事では、さまざまな実用的なソリューションを提供しています!多くのユーザーは、ChatGPTを毎日使用する場合、アクセス不能や応答が遅いなどの問題に遭遇する可能性があります。この記事では、さまざまな状況に基づいてこれらの問題を段階的に解決するように導きます。 ChatGPTのアクセス不能性と予備的なトラブルシューティングの原因 まず、問題がOpenaiサーバー側にあるのか、ユーザー自身のネットワークまたはデバイスの問題にあるのかを判断する必要があります。 以下の手順に従って、トラブルシューティングしてください。 ステップ1:OpenAIの公式ステータスを確認してください OpenAIステータスページ(status.openai.com)にアクセスして、ChatGPTサービスが正常に実行されているかどうかを確認してください。赤または黄色のアラームが表示されている場合、それは開くことを意味します

ASIのリスクを計算することは、人間の心から始まりますMay 14, 2025 am 05:02 AM

ASIのリスクを計算することは、人間の心から始まりますMay 14, 2025 am 05:02 AM2025年5月10日、MIT物理学者のMax Tegmarkは、AI Labsが人工的なスーパーインテリジェンスを解放する前にOppenheimerの三位一体計算をエミュレートすべきだとGuardianに語った。 「私の評価では、「コンプトン定数」、競争が

ChatGPTで作詞・作曲する方法とおすすめツールをわかりやすく解説May 14, 2025 am 05:01 AM

ChatGPTで作詞・作曲する方法とおすすめツールをわかりやすく解説May 14, 2025 am 05:01 AMAI Music Creation Technologyは、1日ごとに変化しています。この記事では、ChatGPTなどのAIモデルを例として使用して、AIを使用して音楽の作成を支援し、実際のケースで説明する方法を詳細に説明します。 Sunoai、Hugging Face、PythonのMusic21 Libraryを通じて音楽を作成する方法を紹介します。 これらのテクノロジーを使用すると、誰もがオリジナルの音楽を簡単に作成できます。ただし、AIに生成されたコンテンツの著作権問題は無視できないことに注意する必要があります。使用する際には注意する必要があります。 音楽分野でのAIの無限の可能性を一緒に探りましょう! Openaiの最新のAIエージェント「Openai Deep Research」が紹介します。 [chatgpt] ope

ChatGPT-4とは?できることや料金、GPT-3.5との違いを徹底解説!May 14, 2025 am 05:00 AM

ChatGPT-4とは?できることや料金、GPT-3.5との違いを徹底解説!May 14, 2025 am 05:00 AMChATGPT-4の出現により、AIアプリケーションの可能性が大幅に拡大しました。 GPT-3.5と比較して、CHATGPT-4は大幅に改善されました。強力なコンテキスト理解能力を備えており、画像を認識して生成することもできます。普遍的なAIアシスタントです。それは、ビジネス効率の改善や創造の支援など、多くの分野で大きな可能性を示しています。ただし、同時に、その使用における予防策にも注意を払わなければなりません。 この記事では、ChATGPT-4の特性を詳細に説明し、さまざまなシナリオの効果的な使用方法を紹介します。この記事には、最新のAIテクノロジーを最大限に活用するためのスキルが含まれています。参照してください。 Openaiの最新のAIエージェント、「Openai Deep Research」の詳細については、以下のリンクをクリックしてください

ChatGPTのアプリの使い方を解説!日本語対応で音声会話機能もMay 14, 2025 am 04:59 AM

ChatGPTのアプリの使い方を解説!日本語対応で音声会話機能もMay 14, 2025 am 04:59 AMChatGPTアプリ:AIアシスタントで創造性を解き放つ!初心者向けガイド ChatGPTアプリは、文章作成、翻訳、質問応答など、多様なタスクに対応する革新的なAIアシスタントです。創作活動や情報収集にも役立つ、無限の可能性を秘めたツールです。 この記事では、ChatGPTスマホアプリのインストール方法から、音声入力機能やプラグインといったアプリならではの機能、そしてアプリ利用上の注意点まで、初心者にも分かりやすく解説します。プラグインの制限やデバイス間の設定同期についてもしっかりと触れていきま

ChatGPTの中文版の利用方法は?登録手順や料金について解説May 14, 2025 am 04:56 AM

ChatGPTの中文版の利用方法は?登録手順や料金について解説May 14, 2025 am 04:56 AMChatgpt中国語版:中国語のAIの対話の新しい体験のロックを解除する ChatGptは世界中で人気がありますが、中国語版も提供していることをご存知ですか?この強力なAIツールは、毎日の会話をサポートするだけでなく、プロのコンテンツを処理し、簡素化された伝統的な中国語と互換性があります。中国のユーザーであろうと、中国語を学んでいる友人であろうと、あなたはそれから利益を得ることができます。 この記事では、アカウント設定、中国語の迅速な単語入力、フィルターの使用、さまざまなパッケージの選択を含むChatGpt中国語のバージョンの使用方法を詳細に紹介し、潜在的なリスクと対応戦略を分析します。さらに、ChatGpt中国語版を他の中国のAIツールと比較して、その利点とアプリケーションシナリオをよりよく理解するのに役立ちます。 Openaiの最新のAIインテリジェンス

5 AIエージェントの神話あなたは今信じるのをやめる必要がありますMay 14, 2025 am 04:54 AM

5 AIエージェントの神話あなたは今信じるのをやめる必要がありますMay 14, 2025 am 04:54 AMこれらは、生成AIの分野で次の飛躍と考えることができ、ChatGptやその他の大規模なモデルのチャットボットを提供しました。単に質問に答えたり情報を生成したりするのではなく、彼らは私たちに代わって行動を起こすことができます。

ChatGPTで複数アカウントを作成・管理する不法をわかりやすく解説May 14, 2025 am 04:50 AM

ChatGPTで複数アカウントを作成・管理する不法をわかりやすく解説May 14, 2025 am 04:50 AMChatGPTを活用した効率的な複数アカウント管理術|ビジネスとプライベートの使い分けも徹底解説! 様々な場面で活用されているChatGPTですが、複数アカウントの管理に頭を悩ませている方もいるのではないでしょうか。この記事では、ChatGPTの複数アカウント作成方法、利用上の注意点、そして安全かつ効率的な運用方法を詳しく解説します。ビジネス利用とプライベート利用の使い分け、OpenAIの利用規約遵守といった重要な点にも触れ、複数アカウントを安全に活用するためのガイドを提供します。 OpenAI

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

SublimeText3 中国語版

中国語版、とても使いやすい

ドリームウィーバー CS6

ビジュアル Web 開発ツール

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)