ホームページ >テクノロジー周辺機器 >AI >コンピューティング能力が限られている中で、言語モデルのパフォーマンスを向上させるにはどうすればよいでしょうか? Googleは新しいアイデアを持っています

コンピューティング能力が限られている中で、言語モデルのパフォーマンスを向上させるにはどうすればよいでしょうか? Googleは新しいアイデアを持っています

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-13 14:01:091518ブラウズ

近年、言語モデル (LM) は自然言語処理 (NLP) 研究においてより注目を集めており、実際の現場でもますます影響力を増しています。一般に、モデルのサイズを大きくすると、さまざまな NLP タスクのパフォーマンスが向上することが示されています。

ただし、モデルをスケールアップするという課題も明らかです。新しい大規模なモデルをトレーニングするには、大量のコンピューティング リソースが必要です。さらに、新しいモデルは最初からトレーニングされることが多く、以前のモデルのトレーニング重みを利用できません。

この問題に関して、Google の研究者は、追加のコンピューティング リソースを大量に消費することなく、既存の言語モデルのパフォーマンスを大幅に向上させる 2 つの補完的な方法を検討しました。

まず、記事「0.1% の追加コンピューティングによるスケーリングの法則の超越」で、研究者らは、混合エノイザー ターゲットを使用する軽量の第 2 段階事前トレーニング モデルである UL2R を紹介しました。 。 UL2R は、さまざまなタスクのパフォーマンスを向上させ、以前はほぼランダムなパフォーマンスだったタスクでもパフォーマンスのバーストを解放します。

論文リンク: https://arxiv.org/pdf/2210.11399.pdf

さらに, 「命令の微調整された言語モデルのスケーリング」では、命令が記述されたデータセット上で言語モデルを微調整する問題、つまり「Flan」と呼ばれるプロセスについて調査します。このアプローチにより、パフォーマンスが向上するだけでなく、ユーザー入力に対する言語モデルの使いやすさも向上します。

論文リンク: https://arxiv.org/abs/2210.11416 ##最後に、Flan と UL2R は、Flan-U-PaLM 540B と呼ばれるモデルで補完的なテクノロジーとして組み合わせることができ、これは、さまざまな困難な評価ベンチマークにおいて、調整されていない PaLM 540B モデルよりも優れたパフォーマンスを 10% 上回っています。

UL2R のトレーニング

伝統的に、ほとんどの言語モデルは、モデルが次の単語を予測できるように、因果関係のある言語モデリングの目標に基づいて事前にトレーニングされています。シーケンス (GPT-3 や PaLM など) またはノイズ除去目標で、モデルは破損した単語シーケンス (T5 など) から元の文を復元することを学習します。

言語モデリングの目的にはいくつかのトレードオフがありますが、つまり、因果関係のある言語モデルは長い文の生成でより優れたパフォーマンスを発揮しますが、ノイズ除去の目的でトレーニングされた言語モデルは細かい文の生成でより優れたパフォーマンスを発揮します。チューニング面のパフォーマンスは向上しましたが、研究者らは以前の研究で、両方の対物レンズを含むハイブリッド イノイザー対物レンズがどちらの場合でも優れたパフォーマンスを達成したことを示しました。

ただし、さまざまなターゲットで大規模な言語モデルを最初から事前トレーニングすることは計算的に困難です。したがって、UL2 ターゲットでの事前トレーニングを継続し、比較的少量の計算のみを必要とする追加ステージである UL2 修復 (UL2R) を提案します。

UL2R を PaLM に適用し、結果として得られる新しい言語モデルを U-PaLM と呼びます。

私たちの経験的評価では、ほんの少量の UL2 トレーニングでモデルが大幅に改善されたことがわかりました。

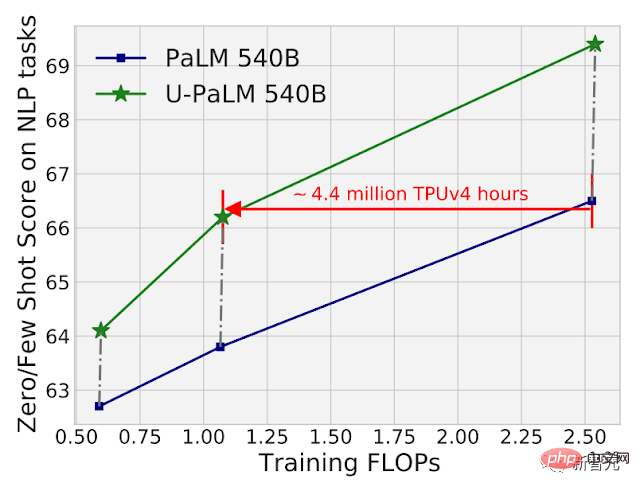

たとえば、PaLM 540B の中間チェックポイントで UL2R を使用すると、2 倍の計算量を使用しながら、最終チェックポイントで PaLM 540B のパフォーマンスを達成できます。もちろん、PaLM 540B の最終チェックポイントに UL2R を適用すると、大きな改善がもたらされます。

26 個の NLP ベンチマークにおける PaLM 540B と U-PaLM 540B の計算とモデルのパフォーマンスの比較。 U-PaLM 540B は引き続き PaLM のトレーニングを行い、計算量は非常に少ないものの、パフォーマンスは大幅に向上しました。

26 個の NLP ベンチマークにおける PaLM 540B と U-PaLM 540B の計算とモデルのパフォーマンスの比較。 U-PaLM 540B は引き続き PaLM のトレーニングを行い、計算量は非常に少ないものの、パフォーマンスは大幅に向上しました。

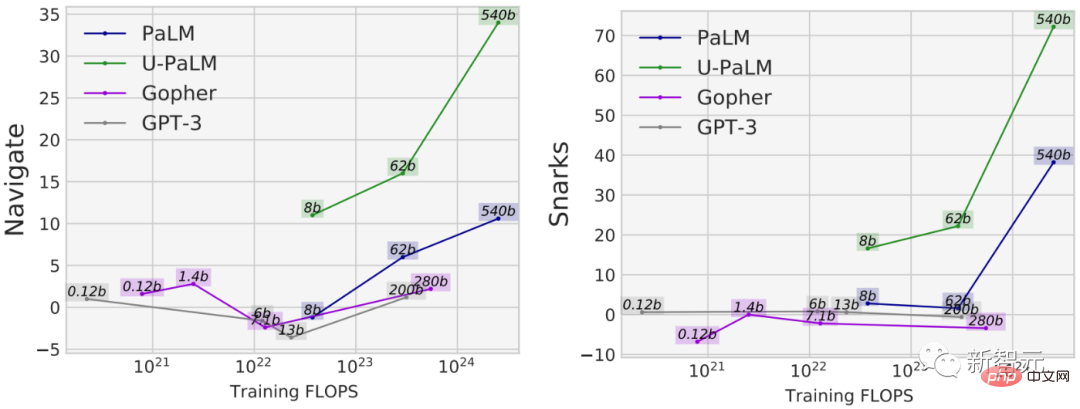

UL2R を使用するもう 1 つの利点は、因果言語モデリングの目標のみに基づいてトレーニングされたモデルよりも一部のタスクでパフォーマンスがはるかに優れていることです。たとえば、いわゆる「緊急機能」を備えた BIG-Bench タスクが多数あります。これらの機能は、十分に大きな言語モデルでのみ利用可能です。

新しい機能を発見する最も一般的な方法はモデルをスケールアップすることですが、UL2R は実際にはモデルをスケールアップせずに新しい機能を呼び起こすことができます。

たとえば、状態追跡を実行するモデルの能力を測定する BIG-Bench のナビゲーション タスクでは、U-PaLM を除くすべてのモデルはトレーニング FLOP が少なくなり、10^23 になります。もう 1 つの例は、皮肉な言葉を検出するモデルの能力を測定する BIG-Bench の Snarks タスクです。

BIG-Bench の両方の機能で新たなタスクのパフォーマンスが実証され、U-PaLM は UL2R ターゲットの使用により、より小さなモデル サイズで新たなパフォーマンスを達成します。

命令の微調整

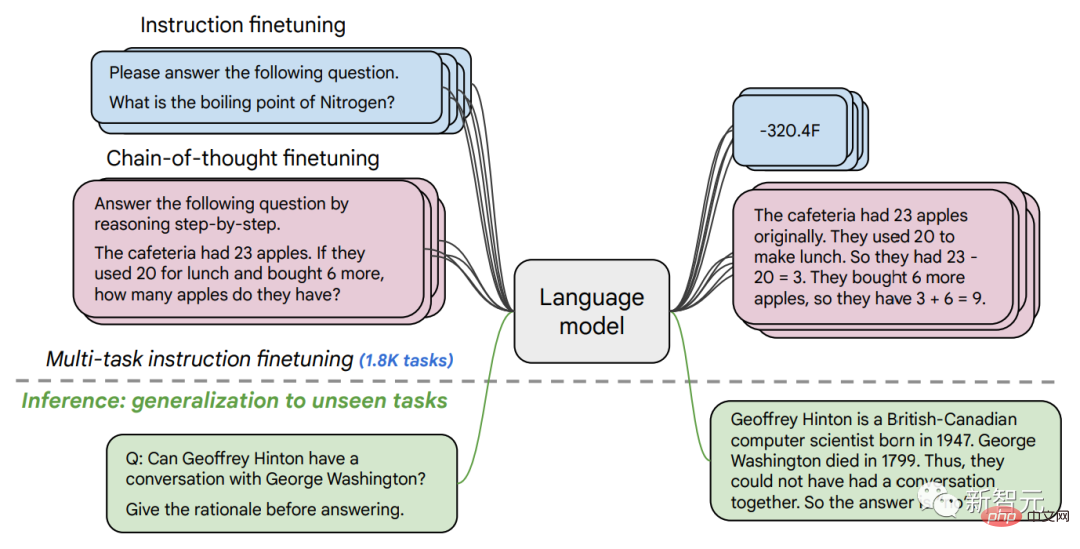

2 番目の論文では、命令の微調整について説明します。これには、一連の命令の微調整が含まれます。 NLP データセットの LM を微調整します。

前回の研究では、短い質問に答える、映画で表現される感情を分類する、映画の中で表現される感情を分類するなど、62 の NLP タスクの 137B パラメーター モデルに命令の微調整を適用しました。文 スペイン語などに翻訳。

この作業では、1.8K を超えるタスクで 540B パラメーターの言語モデルを微調整します。さらに、これまでの研究では、少数の例を含む言語モデル (例: MetaICL) または例のないゼロインスタンス言語モデル (例: FLAN、T0) のみを微調整していましたが、我々は両方の組み合わせを微調整しました。

モデルが複数ステップの推論を実行できるようにする思考連鎖の微調整データも含まれています。言語モデルを微調整するための改良された方法を「Flan」と呼びます。

1.8K タスクで微調整した場合でも、Flan は事前トレーニングと比較して計算の一部のみを使用することは注目に値します (PaLM 540B の場合、Flan は Requires 0.2 のみを使用します)トレーニング前の計算の %)。

命令として定式化された 1.8K タスクの言語モデルを微調整し、新しいタスクでモデルを評価します。トリミングには含まれません。微調整は、例 (つまり、0 ショットと少数ショット) の有無、および思考チェーンの有無に応じて実行され、モデルをさまざまな評価シナリオにわたって一般化できるようになります。

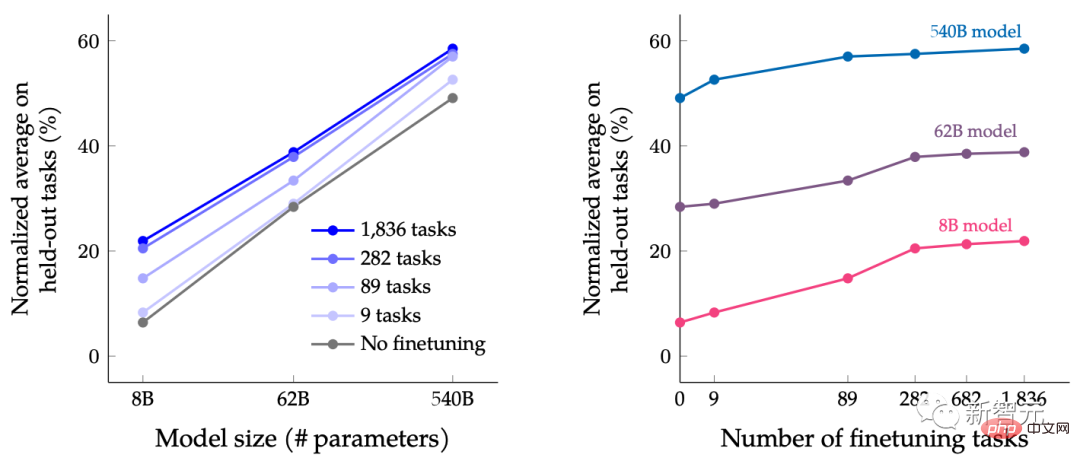

この論文では、言語モデルのサイズの拡大と言語モデルの数の増加を同時に行うことの共同効果を研究することを目的として、さまざまなサイズの LM に微調整を指示します。タスクの微調整。

たとえば、PaLM クラス言語モデルの場合、8B、62B、および 540B のパラメーター仕様が含まれています。私たちのモデルは 4 つの難しいベンチマーク評価基準 (MMLU、BBH、TyDiQA、および MGSM) に基づいて評価され、パラメーターの数を拡張することとタスクの数を微調整することの両方により、新しいタスクやこれまでに見たことのないタスクのパフォーマンスを向上させることができることがわかりました。

パラメーター モデルを 540B に拡張し、1.8K の微調整タスクを使用すると、パフォーマンスを向上させることができます。上図の Y 軸は、4 つの評価スイート (MMLU、BBH、TyDiQA、および MGSM) の正規化された平均です。

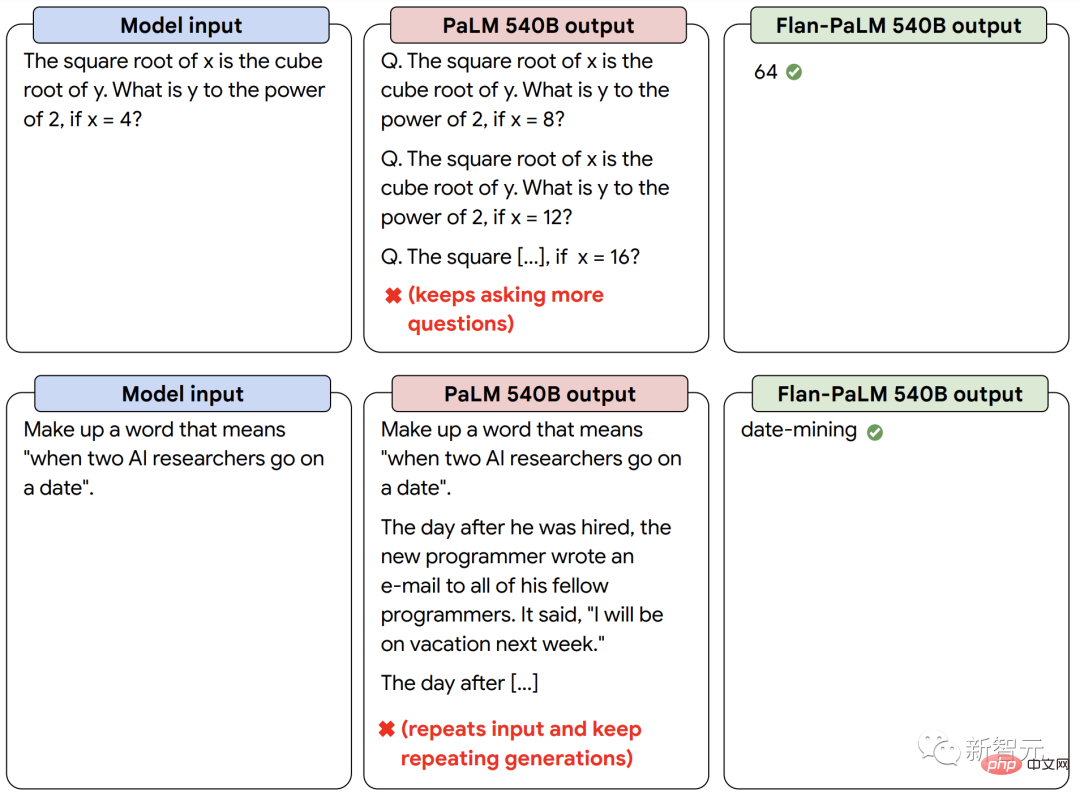

命令微調整 LM は、パフォーマンスの向上に加えて、少数の例やヒント エンジニアリングを必要とせずに、推論時にユーザーの命令に反応できます。これにより、LM はさまざまな入力にわたってよりユーザーフレンドリーになります。たとえば、命令の微調整を行わない LM は、入力を繰り返したり、命令に従わなかったりすることがありますが、命令の微調整を使用すると、そのようなエラーを軽減できます。

命令を微調整した言語モデル Flan-PaLM は、命令を微調整していない PaLM モデルよりも命令に対する応答が優れています。

強力な力を組み合わせて「1 1>2」を達成する

最後に、UL2R と Flan を組み合わせて Flan-U-PaLM モデルをトレーニングできることを示します。

Flan は NLP タスクからの新しいデータを使用し、ゼロポイント命令追跡を実現できるため、UL2R に続く 2 番目の選択肢として Flan を使用します。

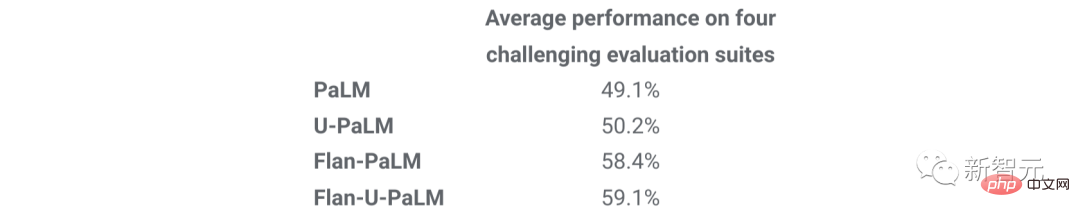

4 つのベンチマーク スイートを再度評価したところ、Flan-U-PaLM モデルが、UL2R のみ (U-PaLM) または Flan のみ (Flan-PaLM) を使用した PaLM モデルよりも優れていることがわかりました。さらに、思考連鎖と自己一貫性を組み合わせると、Flan-U-PaLM は MMLU ベンチマークで 75.4% のスコアで新しい SOTA に到達します。

UL2R のみ(U-PaLM)または Flan のみ(Flan-U-PaLM)を使用した場合と、UL2R と Flan を組み合わせた場合(Flan - U-PaLM) を組み合わせると、最高のパフォーマンスが得られます。つまり、4 つの評価スイート (MMLU、BBH、TyDiQA、および MGSM) の正規化された平均です。

一般に、UL2R と Flan は、事前トレーニングされた言語モデルを改善するための 2 つの補完的な方法です。 UL2R は同じデータを使用して LM をデノイザーの混合目標に適応させますが、Flan は 1.8,000 を超える NLP タスクからのトレーニング データを活用してモデルに指示に従うように教えます。

言語モデルが大きくなるにつれて、大量の計算を必要とせずに一般的なパフォーマンスを向上させる UL2R や Flan などの手法がますます魅力的になる可能性があります。

以上がコンピューティング能力が限られている中で、言語モデルのパフォーマンスを向上させるにはどうすればよいでしょうか? Googleは新しいアイデアを持っていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。