ホームページ >テクノロジー周辺機器 >AI >コンパクトな音声表現を備えた高性能音声合成システムを構築する方法

コンパクトな音声表現を備えた高性能音声合成システムを構築する方法

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-13 11:10:021723ブラウズ

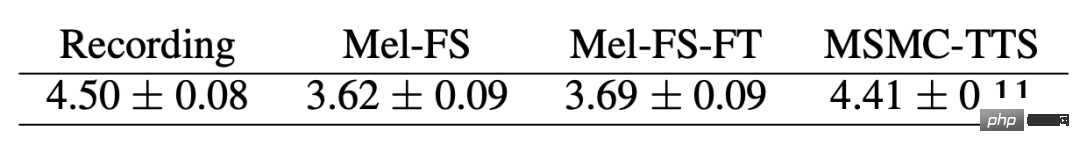

Xiaohongshu マルチメディア インテリジェント アルゴリズム チームと香港中文大学は共同で、マルチステージ マルチ コードブックのコンパクトな音声表現に基づく高性能音声合成スキーム MSMC-TTS を初めて提案しました。ベクトル量子化変分オートエンコーダ (VQ-VAE) に基づく特徴アナライザーは、複数のコードブックを使用して音響特徴を段階的にエンコードし、異なる時間分解能を持つ潜在シーケンスのセットを形成します。これらの潜在的なシーケンスは、多段階予測器によってテキストから予測され、ニューラルボコーダーによってターゲットオーディオに変換されます。 Mel-Spectrogram ベースの Fastspeech ベースライン システムと比較して、このソリューションは音質と自然さが大幅に向上しています。この成果は現在、論文「高性能ニューラル TTS へのマルチステージ マルチコードブック VQ-VAE アプローチ」にまとめられ、音声ドメイン会議 INTERSPEECH 2022 に採択されました。

1. 背景の紹介

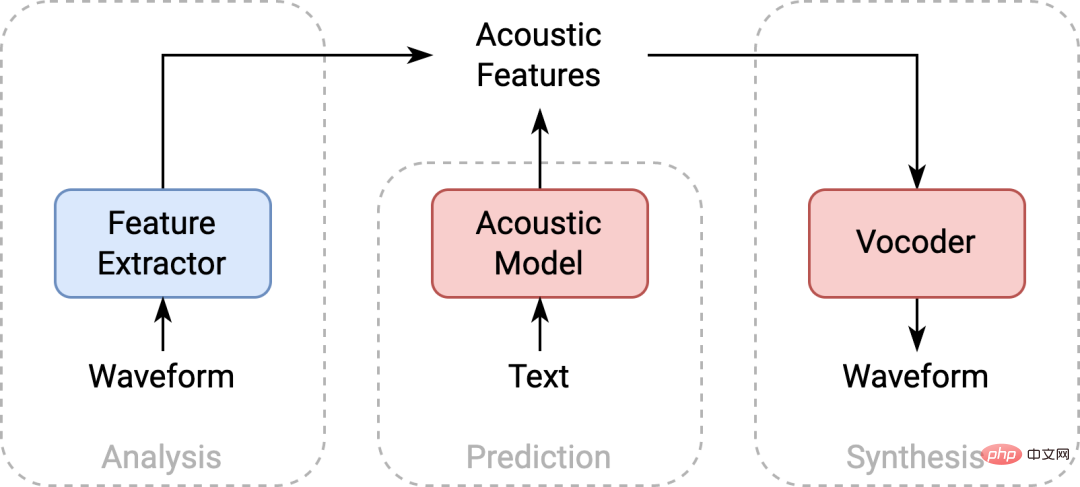

Text-to-Speech (TTS) は、テキストを音声に変換する技術で、ビデオの吹き替えやオーディオおよびビデオ コンテンツの作成に広く使用されています。 -コンピュータインタラクションおよびその他の製品。主流の音声合成システムのバックエンド音響モデリング技術には、通常、特徴抽出器、音響モデル、ボコーダの 3 つの部分が含まれています。 TTSは通常、信号処理(メル・スペクトログラムなど)に基づいて得られた音響特徴量を音響モデリングしますが、モデルのフィッティング能力の制限により、予測された音響特徴量と実際のデータの間には分布に一定の差異が生じます。これにより、実際のデータでトレーニングされたボコーダーが予測された特徴から高品質のオーディオを生成することが困難になります。

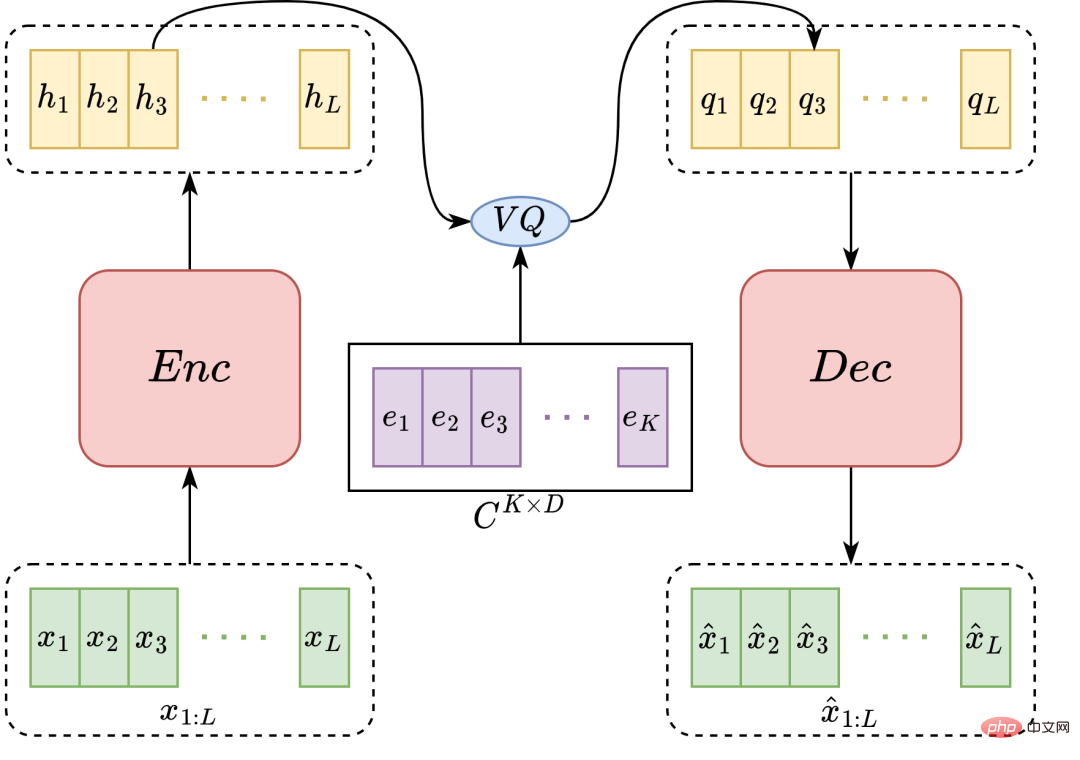

##VQ-VAE モデル構造図

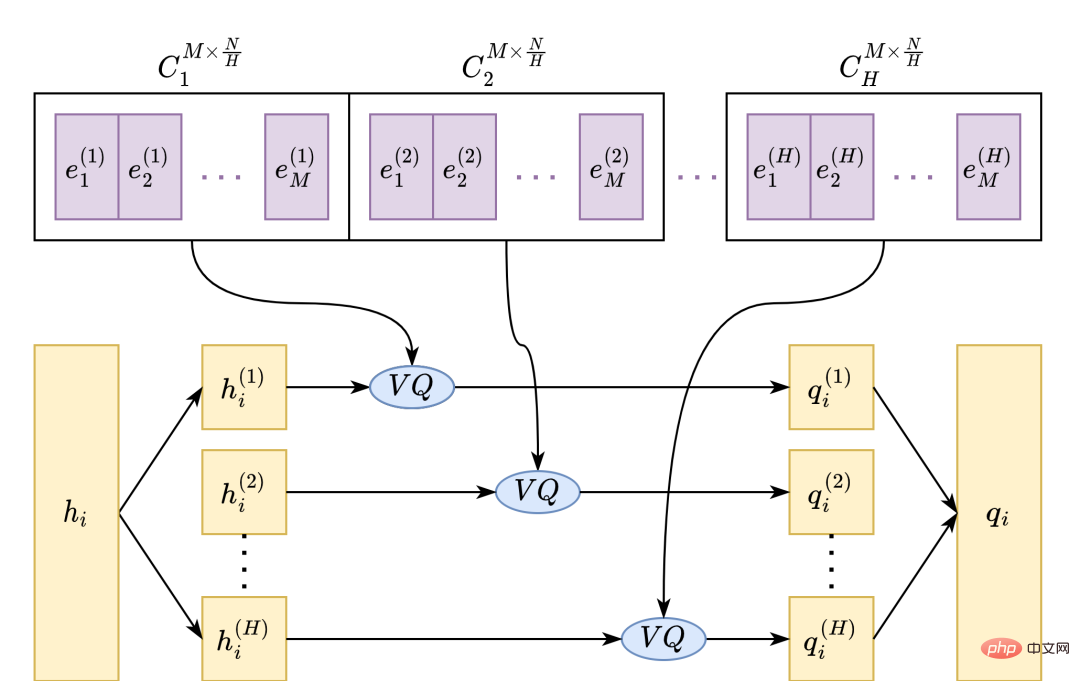

MHVQ は 1 つのコードブックになります特徴次元の方向に従っていくつかのサブコードブックに分割されます。量子化中、各入力ベクトルは均等に複数のサブベクトルに分割され、それぞれ対応するサブコードブックで量子化され、最後に出力ベクトルに結合されます。このようにして、コードブック パラメータの量を増やすことなく、コードブックの使用率と表現能力をより効果的に向上させることができます。たとえば、圧縮率を 1 分の 1 に下げるには、コードワードを元のコードブック番号の 2 乗に増やす必要があります。 MHVQ を使用した後は、コードブックを 2 つの部分に分割するだけで同じ圧縮率を達成できます。したがって、この方法は定量的表現の完全性をより効果的に調整できます。

マルチステージモデリング例図

3. 音響モデリング MSMC-TTS

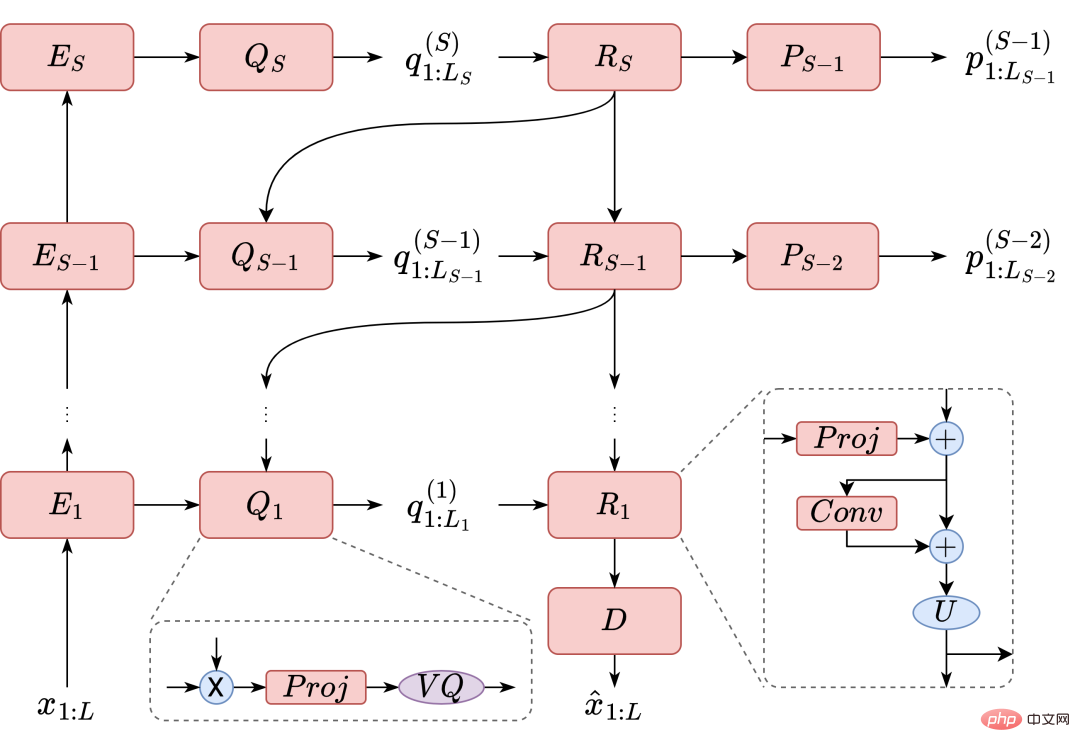

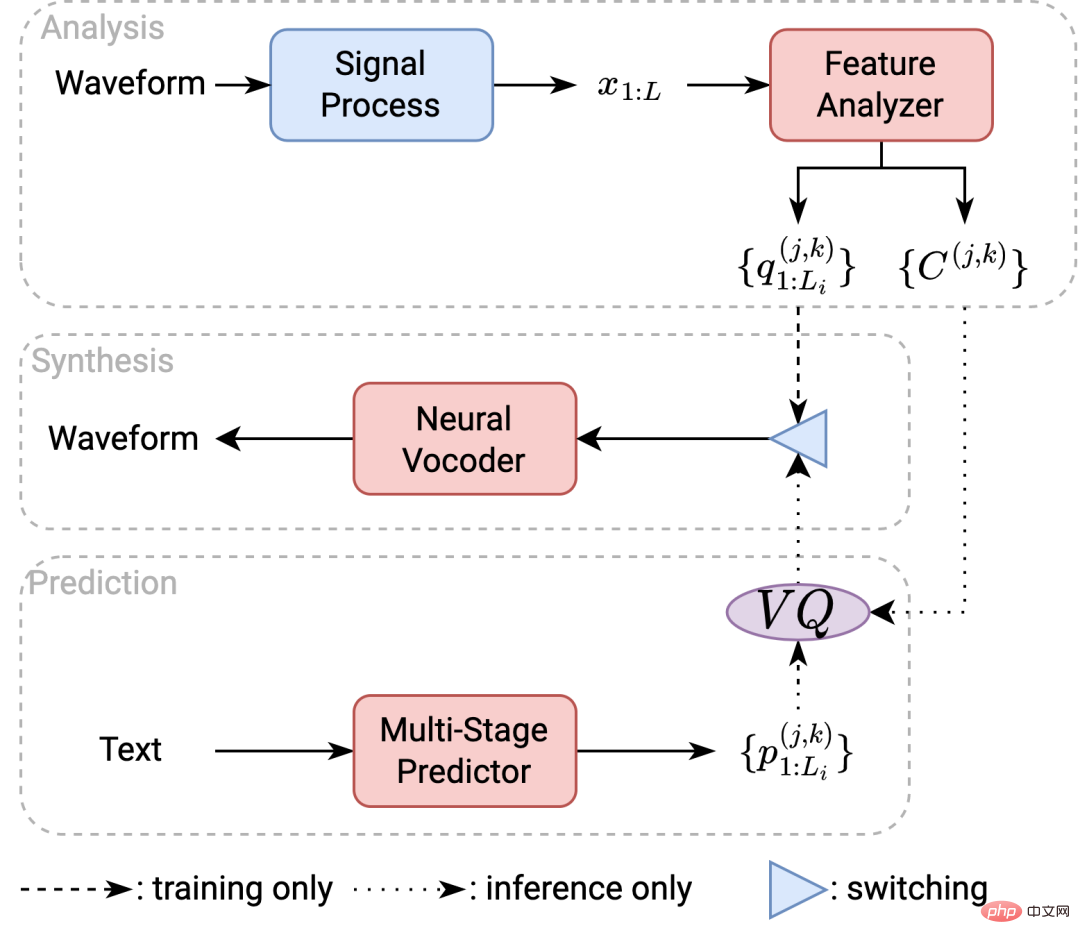

マルチステージの場合マルチコードブックはMSMCRを表しており、本論文ではこれに対応するTTSシステム、すなわちMSMC-TTSシステムを提案する。このシステムには、分析、合成、予測の 3 つの部分が含まれています。システムトレーニングでは、システムは最初に分析モジュールをトレーニングします。トレーニング セット内の音声は、信号処理後に完全性の高い音響特徴 (この作品で使用されているメル スペクトログラム特徴など) に変換されます。これらの音響特徴は、MSMC-VQ-VAE に基づく特徴アナライザーのトレーニングに使用され、トレーニングの最後に対応する MSMCR に変換され、音響モデルとニューラル ボコーダーがトレーニングされます。デコード中、システムは音響モデルを使用してテキストから MSMCR を予測し、ニューラル ボコーダーを使用してターゲット オーディオを生成します。

##MSMC-TTS システム フレームワーク図

##MSMC-TTS システム フレームワーク図

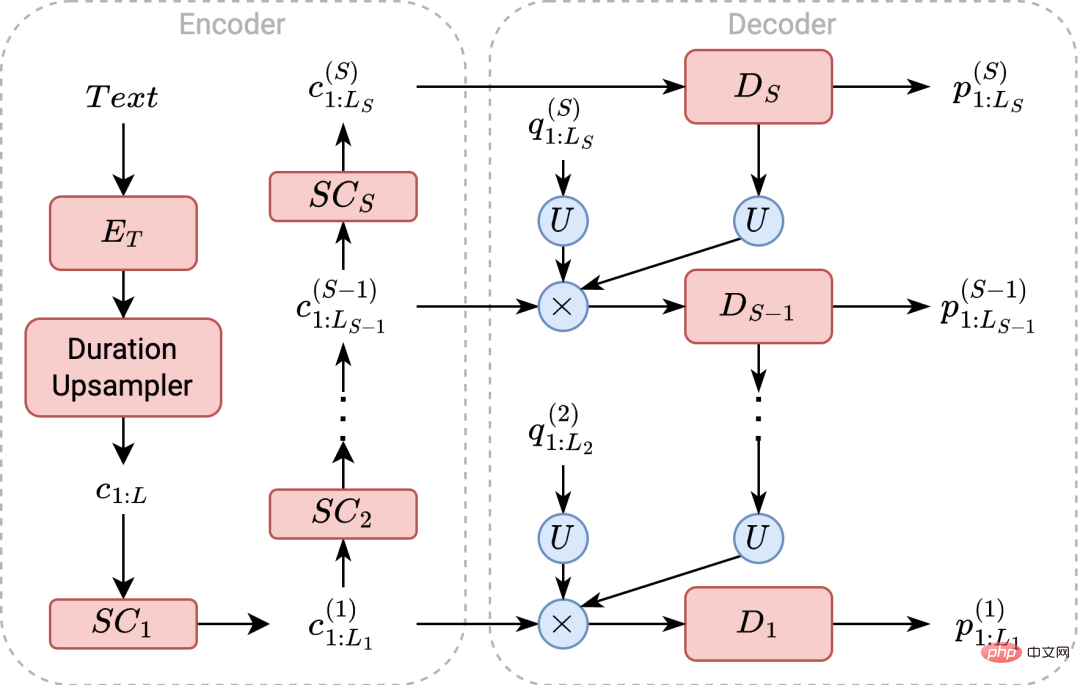

この研究では、A も提案しています。 MSMCR モデリングに適合する多段階予測子。このモデルは FastSpeech に基づいて実装されていますが、デコーダ側が異なります。モデルはまずテキストをエンコードし、予測された継続時間情報に基づいてテキストをアップサンプリングします。次に、シーケンスは MSMCR に対応する各時間解像度にダウンサンプリングされます。これらのシーケンスは、さまざまなデコーダーによって低解像度から高解像度まで段階的にデコードおよび量子化されます。同時に、低解像度の量子化シーケンスが次の段階のデコーダに送信され、予測が支援されます。最後に、予測された MSMCR がニューラル ボコーダーに供給されて、ターゲット オーディオが生成されます。

#多段階予測器の構造図

多段階予測器についてトレーニングと推論を実行するとき、この作業では、連続空間内のターゲット表現を直接予測することを選択します。この方法は、線形連続空間におけるベクトルとコードワード間の距離関係をより適切に考慮することができます。 TTS モデリングに一般的に使用される MSE 損失関数に加えて、トレーニング基準では「トリプレット損失」も使用して、予測ベクトルを非ターゲット コードワードから強制的に遠ざけ、ターゲット コードワードに近づけます。 2 つの損失関数項を組み合わせることで、モデルはターゲット コードワードをより適切に予測できます。

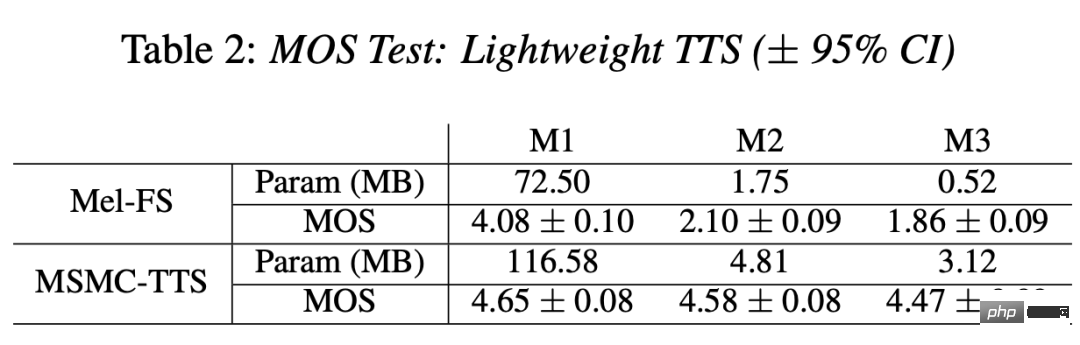

さらに、モデリングの複雑さが TTS のパフォーマンスに及ぼす影響についてさらに説明しました。モデル パラメーターの数は M1 から M3 まで指数関数的に減少し、Mel-FS 合成効果は 1.86 ポイントに低下します。対照的に、MSMC-TTS の場合、パラメータ数の削減は合成品質に大きな影響を与えませんでした。音響モデルのパラメータ サイズが 3.12 MB の場合でも、MOS は 4.47 ポイントを維持できます。これは、コンパクトな機能に基づく MSMC-TTS モデリングの複雑さの要件が低いことを示すだけでなく、この方法が軽量の TTS システムに適用できる可能性があることも示しています。

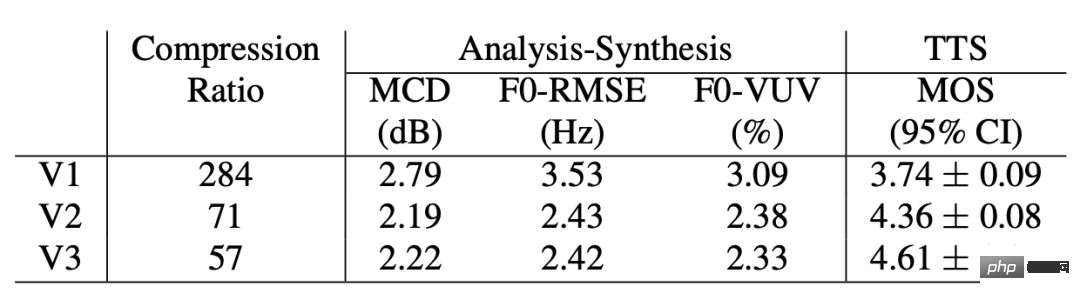

最後に、MHVQ とマルチステージ モデリングが TTS に及ぼす影響を調査するために、さまざまな MSMCR に基づいて MSMC と TTS の比較を実施しました。 . .このうち、V1 システムは 1 段階の単一コードブック表現を使用し、V2 システムは V1 に基づいた 4 ヘッド ベクトル量子化を使用し、V3 システムは V2 に基づいた 2 段階モデリングを使用します。まず、V1 システムで使用される表現は、特徴圧縮率が最も高くなりますが、解析合成実験では完全性が最も低く、TTS 実験では合成品質が最悪です。 MHVQで完成度が高まったのに続き、V2システムでもTTS効果が大幅に向上しました。 V3 で使用されたマルチステージ表現では、完成度のさらなる向上は見られませんでしたが、TTS では最高の結果が得られ、リズミカルな自然さとオーディオ品質の両方が大幅に向上しました。これは、MSMC-TTS ではマルチステージ モデリングとマルチスケールの情報保持が非常に重要であることを示しています。

5. 概要

この研究では、コンパクトな音声表現を研究する観点から、一連の新しい高性能 TTS (MSMC-TTS) モデリング手法を提案します。このシステムは、従来の音響特徴の代わりに、オーディオからマルチステージ マルチコードブック表現を抽出します。入力テキストは、多段階予測器によって異なる時間解像度を持つ複数のシーケンスからなる音声表現に変換され、ニューラルボコーダーによってターゲット音声信号に変換されます。実験結果は、Mel-Spectrogram に基づく主流の FastSpeech システムと比較して、このシステムは合成品質が高く、モデリングの複雑さの要件が低いことを示しています。

6. 著者情報

Guo Haohan: 小紅樹マルチメディア インテリジェント アルゴリズム チームのインターン。彼はノースウェスタン工科大学を学士号を取得して卒業し、ASLP 研究室で Xie Lei 教授の下で学びました。現在、彼は香港中文大学のHCCL研究室で孟美玲教授の下で博士号取得を目指して勉強しています。これまでに、ICASSP、INTERSPEECH、SLT の国際スピーチ会議で第一著者として 6 件の論文が発表されています。

Xie Fenglong: Xiaohongshu マルチメディア インテリジェント アルゴリズム チームの音声テクノロジー責任者。 ICASSP、INTERSPEECH、SPEECHCOM などの音声会議やジャーナルに 10 本以上の論文を発表しています。ICASSP や INTERSPEECH などの主要な音声会議の査読者を長年務めています。主な研究方向は音声信号処理とモデリングです。

以上がコンパクトな音声表現を備えた高性能音声合成システムを構築する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。