ホームページ >テクノロジー周辺機器 >AI >Lao Huang は、ChatGPT がシーンを爆発させるための特別な「核爆弾」を持っています。NVIDIA H100 Extreme Edition は 10 倍高速です。

Lao Huang は、ChatGPT がシーンを爆発させるための特別な「核爆弾」を持っています。NVIDIA H100 Extreme Edition は 10 倍高速です。

- 王林転載

- 2023-04-13 10:10:021363ブラウズ

NVIDIA、勝利!

終了したばかりの GTC カンファレンスで、Lao Huang 氏は、「生成 AI」の全画面を利用し、ChatGPT のコンピューティング能力をサポートし、10 倍高速化する H100 NVLINK チップを手にしています。欠けているこれらの言葉を顔に書いてください - 「私は勝者です」。

ChatGPT、Microsoft 365、Azure、安定した拡散、DALL-E、Midjourney...これらはすべて最も優れています現在人気のある Nvidia は、爆発的な AI 製品のシェアを獲得できる可能性があります。

今年初めの ChatGPT の世界的な人気により、NVIDIA の株価は急騰し、その市場価値は直接 700 億ドル以上増加しました。現在、NVIDIA の時価総額は 6,400 億米ドルです。

今、iPhone の AI の瞬間が到来し、第 4 の技術革命が始まろうとしています。A100 と H100 を保有する Nvidia 、最大の勝者になる可能性があります。

GTC カンファレンスで、Lao Huang 氏は、GPU、アクセラレーション ライブラリ、計算リソグラフィー、クラウド プラットフォームにおける NVIDIA の目覚ましい進歩を発表し、NVIDIA が次の TSMC になるという大胆な主張さえしました。 AI業界!

今日のスピーチはすべて H100 の AIGC モデルを使用して生成されたのではないかとすでに推測している人もいます。

ChatGPT 専用 GPU が登場このカンファレンスでの最大のリリースは、ChatGPT 用に構築された NVIDIA H100 NVLINK です。

コンピューティング能力に対する大きな需要のため、NVIDIA は、ChatGPT などの LLM 推論用の新しい Hopper GPU、デュアル GPU NVLINK および 94B メモリを搭載した PCIE H100 を発売しました。

実際、ディープ ラーニングの歴史は 2012 年以来、NVIDIA と密接に関係しています。

Lao Huang 氏は、2012 年にディープ ラーニングのベテランであるヒントン氏と学生のアレックス ケルチェフスキー氏とイリヤ サスケヴァー氏が AlexNet のトレーニングに GeForce GTX 580 を使用したと述べました。

その後、AlexNet は ImageNet 画像分類コンテストで一気に優勝し、ディープラーニング爆発の特異点となりました。

10 年後、OpenAI の Ilya Suskever も NVIDIA の DGX を使用して、ChatGPT の背後で GPT3 と GPT3.5 をトレーニングしました。

Lao Huang 氏は、ChatGPT を実際に処理できるクラウド上の唯一の GPU は HGX A100 であると誇らしげに述べました。

しかし、A100 と比較すると、4 ペアの H100 とデュアル GPU NVLINK を搭載したサーバーは 10 倍高速です。 H100 を使用すると、LLM の処理コストを一桁削減できるためです。

生成型 AI がチャンスの波を生み出し、推論ワークロードがステップ関数的に増加するため、AI は変曲点にあります。

以前は、生成 AI を処理するクラウド データセンターを設計することは大きな課題でした。

データセンターの柔軟性を高めるにはアクセラレータを使用するのが理想的ですが、一方で、アルゴリズムやモデルの問題を処理できるアクセラレータはありません。最適な方法、データ型とサイズの多様性。 NVIDIA の One Architecture プラットフォームは、高速化機能と柔軟性の両方を備えています。

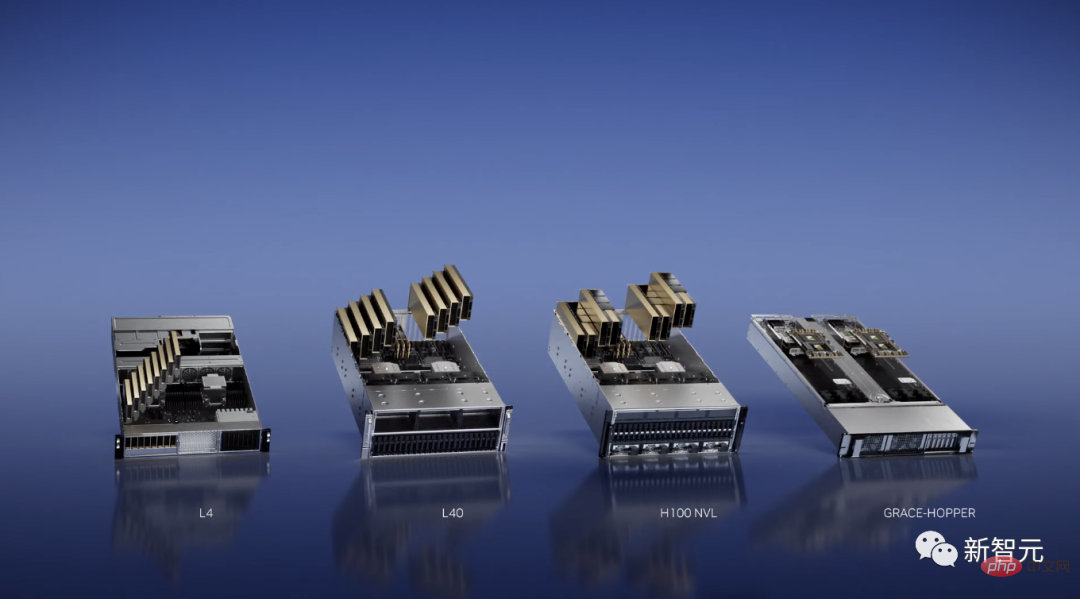

本日、NVIDIA は新しい推論プラットフォームの発売を発表しました。各構成は、特定の種類のワークロードに合わせて最適化されています。

たとえば、NVIDIA は、AI ビデオ ワークロード向けに、ビデオのデコードとトランスコーディング、ビデオ コンテンツのレビュー、ビデオ通話機能を最適化した L4 を発表しました。

そして、8 GPU L4 サーバーは、AI ビデオの処理に使用される 100 台以上のデュアルソケット CPU サーバーを置き換えます。

同時に、NVIDIA は、Omniverse、グラフィックス レンダリング、テキストから画像/ビデオへの変換などの生成 AI 向けの L40 も発表しました。そのパフォーマンスは、Nvidia で最も人気のあるクラウド推論 GPU T4 の 10 倍です。

現在、Runway が発表した第 1 世代および第 2 世代の生成 AI モデルの強力な機能は、NVIDIA GPU に依存しています。

さらに、NVIDIA は、レコメンデーション システムやベクトル データベースに適した新しいスーパー チップ Grace-Hopper も発売しました。

チップの限界に挑戦し、計算リソグラフィーを 40 倍高速化

チップ分野では、NVIDIA が TSMC、ASML、シノプシスと提携して、ついに計算リソグラフィーを完成させました。 4 年後 テクノロジーにおける大きな進歩 - NVIDIA cuLitho コンピュテーショナル リソグラフィー ライブラリ。

2nmプロセスの限界に達した後、ブレークスルーポイントとなるのがフォトリソグラフィーです。

計算リソグラフィーは、光が光学素子を通過した後にフォトレジストと相互作用する際の光の挙動をシミュレートします。逆物理アルゴリズムを適用することで、マスク上のパターンを予測して、最終的なパターンがウェーハ上に生成されます。

コンピューテーショナル リソグラフィーは、チップ設計および製造における最大のコンピューティング ワークロードであり、毎年数百億の CPU 時間を消費します。対照的に、NVIDIA が作成した新しいアルゴリズムを使用すると、ますます複雑になる計算リソグラフィ ワークフローを GPU 上で並行して実行できます。

要約すると、cuLitho は計算速度を 40 倍向上させるだけでなく、消費電力を最大 9 倍も削減できます。

たとえば、Nvidia の H100 には 89 個のマスクが必要です。

CPU によって処理される場合、各マスクには 2 週間かかります。 GPU 上で cuLitho を実行する場合、マスクの処理にかかる時間はわずか 8 時間です。

TSMC は、500 台の DGX H100 システムで 4,000 個の Hopper GPU を使用して、以前は最大 40,000 台の CPU ベースのサーバーを必要としていた作業を完了することもでき、電力も増加します (35MW から 5MW に削減されます)。

cuLitho アクセラレーション ライブラリは Ampere および Volta アーキテクチャの GPU とも互換性がありますが、Hopper が最も高速なソリューションであることは注目に値します。

Lao Huang氏は、フォトリソグラフィー技術はすでに物理の限界に達しているため、ウェーハ工場は生産を増やして2nm以降の開発に備えることができると述べた。

AI の iPhone モーメント

過去数か月間、ChatGPT は第 4 の技術革命を起こそうとしています。 「私たちは iPhone の AI の瞬間にいます」という言葉も広く流布されています。

GTC カンファレンスで、Lao Huang 氏は興奮しながらこの言葉を 3 回繰り返しました。

iPhone の瞬間が到来しており、OpenAI などの新興企業が破壊的な製品やビジネス モデルの構築に競い合っている一方で、Google や Microsoft などの既存企業はそれに対処する方法を模索しています。

彼らのさまざまな行動は、すべて世界中の生成AIをきっかけとしたAI戦略策定への危機感から生まれています。

NVIDIA アクセラレーテッド コンピューティングは、DGX AI スーパーコンピューターから始まりました。これは、大規模な言語モデルにおける現在の画期的な進歩の原動力でもあります。

GTC で、Lao Huang は、私が個人的に世界初の DGX を OpenAI に引き渡した、と誇らしげに言いました。

それ以来、フォーチュン 100 企業の半数が DGXAI スーパーコンピューターを導入しました。

DGX には 8 つの H100 GPU モジュールが搭載されており、H100 には ChatGPT のような素晴らしいモデルを処理できる Transformer エンジンが搭載されています。

8 つの H100 モジュールは NVLINK スイッチを介して相互に接続され、包括的なノンブロッキング通信を実現します。 8 台の H100 が巨大な GPU のように連携して動作します。

Lao Huang をさらに興奮させているのは、Microsoft が Azure の H100 AI スーパーコンピューターのプライベート プレビュー バージョンを公開すると発表したことです。

はまた、「DGX スーパーコンピューターは現代の AI 工場です。私たちは iPhone の AI の瞬間にいます。」

ChatGPT を片手で持ち出す

過去 10 年にわたり、アクセラレーションと垂直スケーリングの組み合わせにより、アプリケーションは 100 万倍のパフォーマンス向上を達成できました。

最も印象的な例は、2012 年の AlexNet 深層学習フレームワークの導入です。

当時、Alex Krizhevsky、Ilya Suskever、Hinton は、262 ペタフロップスの浮動小数点演算を処理できる GeForce GTX 580 で 1,400 万枚の画像を使用したトレーニングを完了しました。

10 年後、『トランスフォーマー』がリリースされました。

Ilya Suskever は、次の単語を予測するように GPT-3 をトレーニングしました。これには、AlexNet モデルのトレーニングよりも 100 万倍多くの浮動小数点演算が必要でした。

こうして、世界に衝撃を与えた AI、ChatGPT が誕生しました。

Lao Huang の言葉で要約すると:

これは、新しいコンピューティング プラットフォームが誕生し、AI の「iPhone の瞬間」が到来したことを意味します。到着しました。 。高速化されたコンピューティングと AI テクノロジーが現実のものとなりました。

アクセラレーション ライブラリは、アクセラレーション コンピューティングの中核です。これらのアクセラレーション ライブラリは、さまざまなアプリケーションを接続し、さらにさまざまな業界に接続し、ネットワーク内にネットワークを形成します。

30 年間の開発を経て、数千のアプリケーションが NVIDIA のライブラリによって高速化され、科学と産業のほぼすべての分野をカバーしています。

現在、すべての NVIDIA GPU は CUDA と互換性があります。

既存の 300 の加速ライブラリと 400 の AI モデルは、量子コンピューティング、データ処理、機械学習などの幅広い分野をカバーしています。

今回の GTC カンファレンスで、Nvidia はそのうち 100 個をアップデートしたと発表しました。

NVIDIA Quantum プラットフォームは、研究者が量子プログラミング モデル、システム アーキテクチャ、アルゴリズムを進歩させることを可能にするライブラリとシステムで構成されています。

cuantum は、量子回路シミュレーション用の加速ライブラリであり、IBM や Baidu などの企業は、この加速ライブラリを自社のシミュレーション フレームワークに統合しています。

Open Quantum CUDA は、NVIDIA のハイブリッド GPU-Quantum プログラミング モデルです。

NVIDIA は、Quantum Machines と提携して開発された量子制御リンクの発売も発表しました。 Nvidia GPU を量子コンピューターに接続して、非常に高速にエラー訂正を実行できます。

インデックス作成、データ読み込み、最近傍検索を高速化するために、新しい RAFT ライブラリもリリースされました。

さらに、NVIDIA は、DGX で構築され、最新のオープンソース CUDA Quantum を活用した DGX Quantum も発表しました。この新しいプラットフォームは、量子コンピューティングに携わる研究者に革新的なハイエンド プラットフォームを提供します。パフォーマンスと低遅延アーキテクチャ。

NVIDIA は、データセンター全体で Triton 推論インスタンスを自動的に拡張および調整する NVIDIA Triton Management Service ソフトウェアも開始しました。 GPT-3 などの大規模言語モデルのマルチ GPU およびマルチノード推論に適しています。

コンピューター ビジョン用の CV-CUDA とビデオ処理用の VPF は、Nvidia の新しいクラウド スケール アクセラレーション ライブラリです。

Lao Huang は、CV-CUDA ベータ版が前処理と後処理を最適化し、より高いクラウド スループットを実現し、コストとエネルギー消費を 4 分の 1 削減すると発表しました。

現在、Microsoft がビジュアル検索を処理し、Runway は生成 AI ビデオ処理に CV-CUDA および VRF ライブラリを使用しています。

さらに、NVIDIA アクセラレーテッド コンピューティングは、ゲノミクスのマイルストーン開発の達成にも貢献しました。 NVIDIA を搭載した機器を使用することで、ゲノムシーケンス全体のコストを 100 ドルに削減することが、新たなマイルストーンとなりました。

NVIDIA Parabrics アクセラレーション ライブラリは、クラウドまたは機器内でのエンドツーエンドのゲノム解析に使用でき、さまざまなパブリック クラウドおよびゲノミクス プラットフォームに適しています。

ChatGPT が実行され、NVIDIA が収益を上げています

ChatGPT、Stable Diffusion、DALL-E、Midjourney は、生成 AI に対する世界の認識を呼び起こしました。

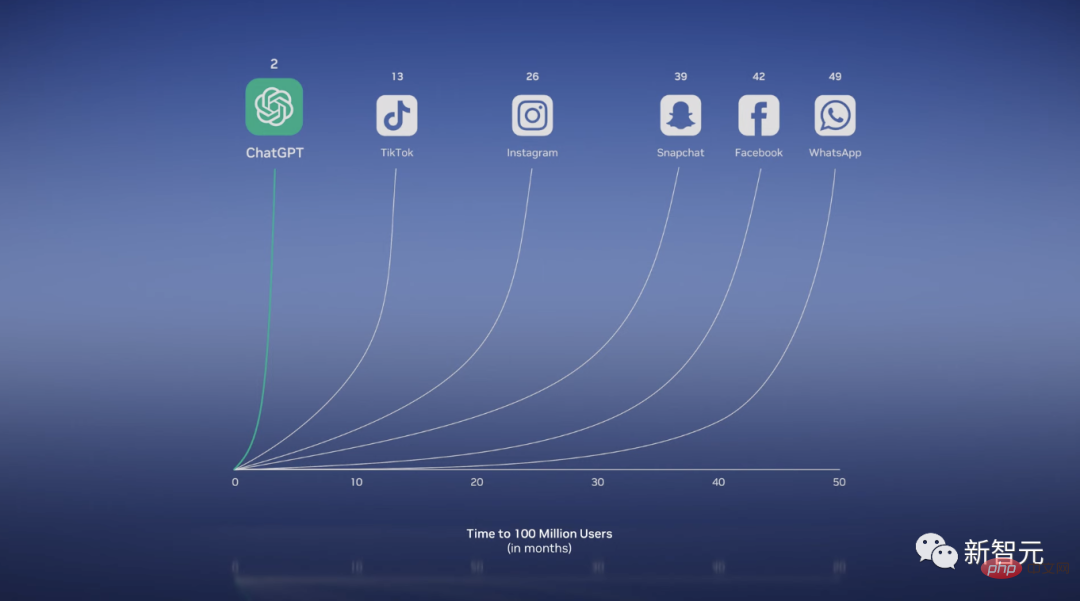

人気の ChatGPT は、リリースからわずか 2 か月で月間ユーザー数が 1 億人を超え、史上最も急速にユーザーが増加したアプリケーションになりました。

コンピュータであると言えます。テキストを生成したり、詩を書いたり、研究論文を書き直したり、数学の問題を解決したり、さらにはプログラムを作成することもできます。

多くの画期的な成果により、今日の生成 AI が生み出されました。

Transformer は、データの関係と依存関係からコンテキストと意味を大規模な並列方法で学習できます。これにより、LLM は大量のデータから学習し、明示的なトレーニングなしで下流のタスクを実行できるようになります。

さらに、物理学にヒントを得た拡散モデルは、教師なし学習を通じて画像を生成できます。

Lao Huang氏は、わずか十数年の間に、人類は猫の識別から、宇宙服を着て月面を歩く猫を生成するプロセスに移行したと結論付けました。

現在、生成 AI は新しい種類のコンピューター、つまり人間の言語でプログラムできるコンピューターであると言えます。

# 以前は、コンピューターに問題解決を命令するのはプログラマーの特権でしたが、今では誰もがプログラマーになれるようになりました。

ビル・ゲイツと同様に、フアン氏も同様の定義を示しました。ジェネレーティブ AI は、PC、インターネット、モバイル デバイス、クラウドに似た新しいコンピューティング プラットフォームです。

Debuild を使用すると、必要なものを明確に指定する限り、Web アプリケーションを直接設計してデプロイできます。

生成 AI がほぼすべての業界を再構築することは明らかです。

AI 業界で「TSMC」になるためには

#この状況において、専門企業は独自のカスタマイズされたモデルを構築するための独自のデータ。

そして、Huang 氏は、業界はカスタマイズされた大規模言語モデルを構築するために TSMC と同様のファウンドリを必要としており、NVIDIA がこの「TSMC」であると誇らしげに発表しました。

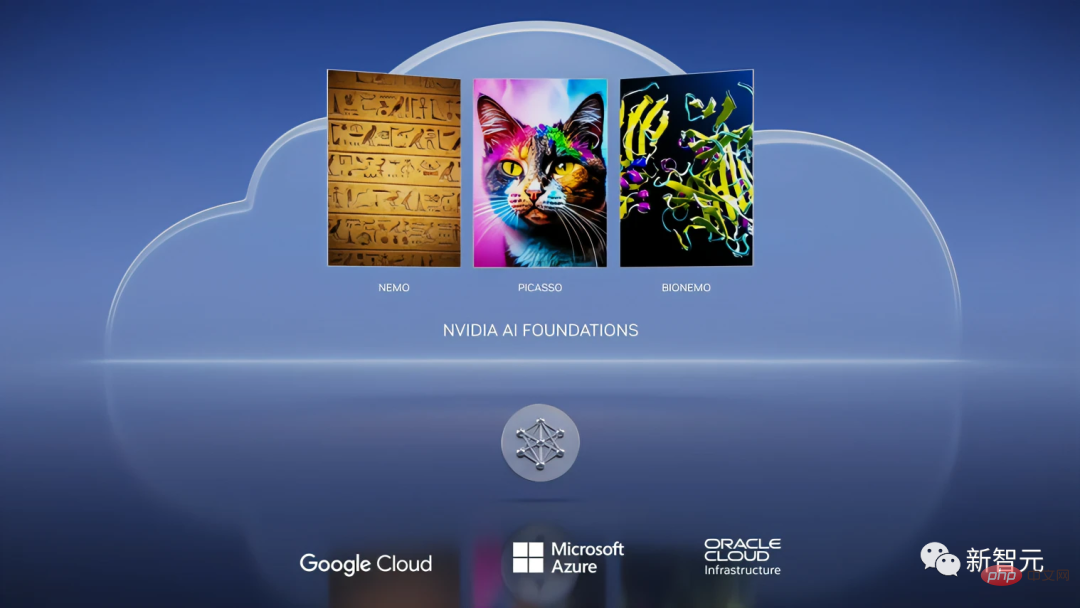

カンファレンスで、NVIDIA は、顧客が LLM と生成 AI をカスタマイズできるようにする NVIDIA AI Foundations クラウド サービスの開始を発表しました。

#このクラウド サービスには、言語、視覚、生物学モデルの作成サービスが含まれます。

その中で、Nemo は、カスタマイズされた言語のテキスト間生成モデルを構築するために使用されます。

Picasso は、画像、ビデオ、3D アプリケーションなどのカスタム モデルのトレーニングに使用できるビジュアル言語モデル メーカーです。

テキスト プロンプトとメタデータを含む API 呼び出しを Picasso に送信するだけで、Picasso は DGX Cloud 上のモデルを使用して生成されたマテリアルをアプリケーションに送り返します。

さらに驚くべきことは、これらのマテリアルを NVIDIA Omniverse にインポートすることで、現実的なメタバース アプリケーションとデジタル ツイン シミュレーションを構築できることです。

さらに、NVIDIA は Shutterstock と協力して Edify-3D 生成モデルを開発しています。

同時に、NVIDIA と Adobe の協力関係は拡大し続けており、生成 AI をマーケターやクリエイティブ担当者の日常のワークフローに統合し、アーティストの保護に特別な注意を払っています。著作権。

#3 番目の分野は生物学です。

今日、医薬品研究開発産業の価値は2兆元近くに達し、研究開発投資は最大2,500億米ドルに達しています。

NVIDIA Clara は、イメージング、計測、ゲノム分析、創薬のための医療および健康アプリケーション フレームワークです。

最近、生物圏で人気の方向性は、生成 AI を使用して疾患標的を発見し、新しい分子やタンパク質医薬品を設計することです。

同様に、BIONEMO を使用すると、ユーザーは独自のデータを使用して、AlphaFold、ESMFold、OpenFold などのタンパク質予測モデルを含むカスタマイズされたモデルを作成、微調整、提供できます。

最後に、Huang 氏は、NVIDIA AI Foundations はカスタム言語モデルと生成 AI を構築するためのクラウド サービスおよびファウンドリであると結論付けました。

老黄云サービス、月額レンタルは36,999ドルですNvidiaも今回クラウドサービスを開始しました。

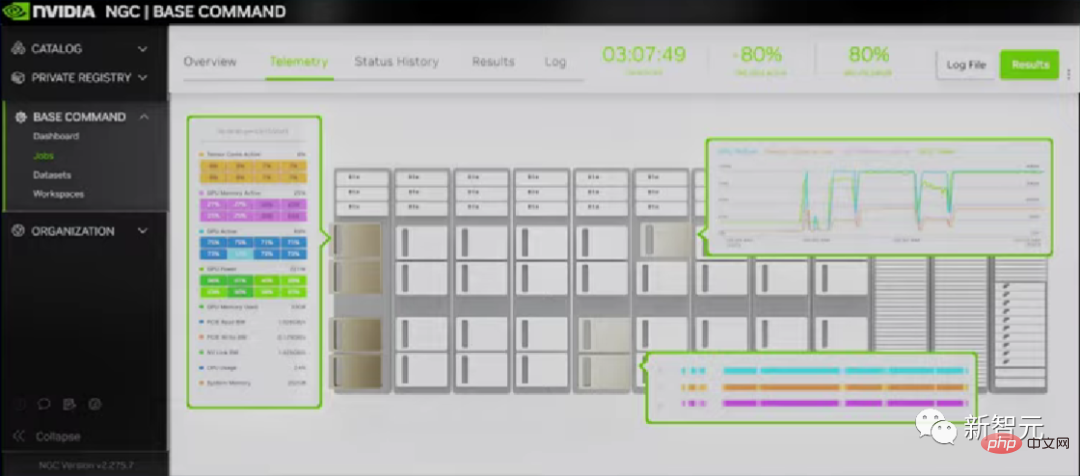

同社は、顧客が NVIDIA AI にもっと簡単かつ迅速にアクセスする必要性を痛感し、NVIDIA DGX Cloud を立ち上げました。

DGX Cloud は、Microsoft Azure、Google GCP、Oracle OCI と連携します。ブラウザと NVIDIA DGX AI スーパーコンピューターだけで、あらゆる企業に瞬時にアクセスできます。

このクラウドでは、NVIDIA AI Enterprise アクセラレーション ライブラリ スイートを実行して、AI のエンドツーエンドの開発と展開を直接解決できます。

さらに、クラウドは NVIDIA AI だけでなく、世界のいくつかの主要なクラウド サービス プロバイダーも提供しています。

そして、NVIDIA の最初の NVIDIA DGX クラウドは Oracle Cloud Infrastructure (OCI) です。

OCI では、NVIDIA CX-7 と BlueField-3 の 2 つの王様が結合して、強力なスーパーコンピューターを形成しました。

レポートによると、企業は DGX Cloud を月額 36,999 ドルからレンタルできるようになりました。

最後に、もちろん、年次 GTC カンファレンスの予約プログラムであるオムニバースがまだ残っています。 Lao Huang氏はメタバースプラットフォームOmniverseのアップデートを発表した。

現在、Microsoft と NVIDIA は、数億人の Microsoft 365 および Azure ユーザーに Omniverse を提供する準備を進めています。

また、H100を法規制を遵守して中国に輸出できるようにするため、老黄が従来のA800の経験をもとに「H800」を特別に調整したというニュースもある。 H100とH100の間のデータ転送速度は約50%に低下します。

要約すると、Lao Huang 氏はこのカンファレンスで、NVIDIA が AI 分野の TSMC になり、ウェーハ工場のような OEM を提供したいと考えており、これに基づいて業界の他の企業ができることを明確にしました。アルゴリズムを訓練します。

このビジネスモデルは成功するでしょうか?

以上がLao Huang は、ChatGPT がシーンを爆発させるための特別な「核爆弾」を持っています。NVIDIA H100 Extreme Edition は 10 倍高速です。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。