ホームページ >テクノロジー周辺機器 >AI >写真を送って 30 秒のビデオを生成してください。

写真を送って 30 秒のビデオを生成してください。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-13 08:43:121834ブラウズ

AIはまた進歩したのか?

#そして、1枚の写真から連続30秒の動画を生成するタイプです。

えっと…ちょっと画質がぼやけすぎませんか

これは 1 つの画像 (最初のフレーム) からのみ生成され、ジオメトリ情報は表示されないことに注意してください。

これは、DeepMind - Transframer によって最近提案された、確率的フレーム予測に基づく画像モデリングとビジョン タスクのための一般的なフレームワークです。

#簡単に言えば、Transframer は任意のフレームの確率を予測するために使用されます。

これらのフレームは、前のビデオ フレーム、タイムスタンプ、またはカメラタグ付きビュー シーンなど、1 つ以上の注釈付きコンテキスト フレームに基づいて条件付けできます。

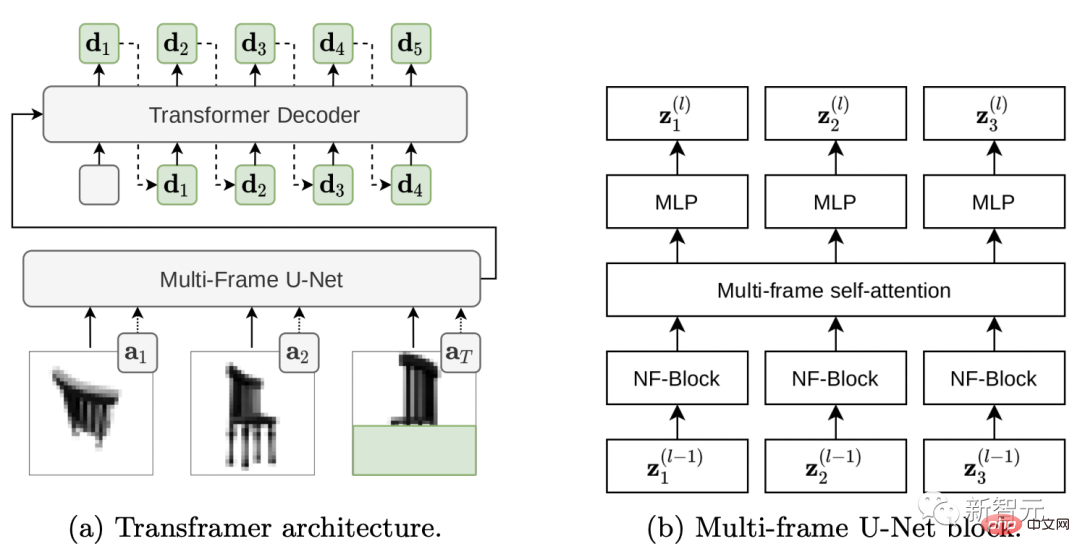

Transframer アーキテクチャ

まず、この魔法のような Transframer アーキテクチャがどのように機能するかを見てみましょう。

論文のアドレスは以下に掲載されています。興味のあるお子様はご覧ください ~ https://arxiv.org /abs /2203.09494

ターゲット画像上の予測分布を推定するには、多様で高品質の出力を生成できる式生成モデルが必要です。

単一画像ドメイン上の DC Transformer の結果はニーズを満たすことができますが、複数画像のテキスト セット {(In,an) には含まれていません。 }n が条件として必要です。

# したがって、画像と注釈の条件付き予測を可能にするために DC Transformer を拡張しました。

DC Transformer を、マルチフレーム U-Net アーキテクチャを使用して単一の DCT 画像を操作する Vision-Transformer スタイルのエンコーダに置き換えます。注釈付きフレームと部分的に隠されたターゲット DCT イメージのセット。

#Transframer アーキテクチャがどのように機能するかを見てみましょう。

(a) Transframer は、DCT 画像 (a1 および a2) だけでなく、部分的に隠されたターゲット DCT 画像 (aT) および追加の注釈も入力として受け取ります。フレーム U-Net エンコーダ。次に、U-Net 出力はクロス アテンションを通じて DC-Transformer デコーダに渡され、自動的に後退して、ターゲット イメージの隠れた部分に対応する DCT トークン シーケンス (緑色の文字) が生成されます。 (b) マルチフレーム U-Net ブロックは、NF-Net 畳み込みブロックとマルチフレーム セルフ アテンション ブロックで構成され、入力フレームとトランスフォーマー スタイルの残差 MLP の間で情報を交換します。

画像入力を処理するマルチフレーム U-Net を見てみましょう。

U-Net への入力は、N 個の DCT フレームと部分的に隠されたターゲット DCT フレームで構成されるシーケンスです。注釈付きの情報は各入力フレームに関連付けられています。ベクトルで提供されます。形状。

U-Net のコア コンポーネントは、最初に共有 NF-ResNet 畳み込みブロックを各入力フレームに適用し、次に Transformer スタイルを適用する計算ブロックです。フレーム全体の情報を集約するためのセルフ アテンション ブロック。 (図 2 b)

NF-ResNet ブロックは、TPU のパフォーマンス向上を目的として、グループ化された畳み込み層、スクイーズ層、励起層で構成されています。

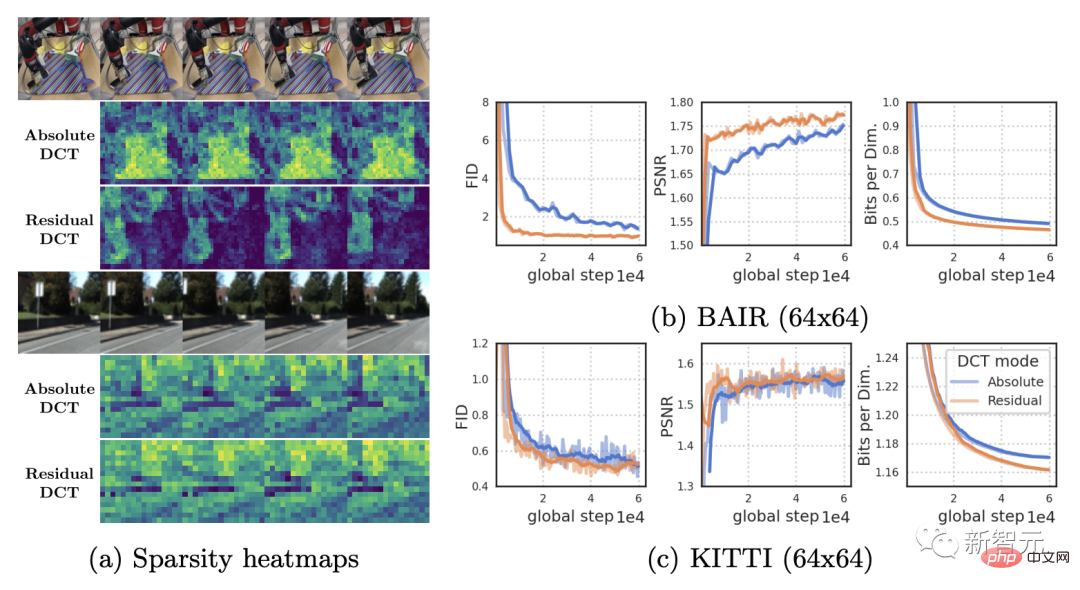

以下の図 (a) は、RoboNet (128x128) ビデオと KITTI ビデオの絶対および残差 DCT 表現のスパース性を比較しています。

RoboNet は少数の動く要素のみを含む静的ビデオで構成されているため、残留フレーム表現のスパース性が大幅に増加します。

そして、KITTI ビデオには多くの場合カメラが移動するため、連続するフレームのほぼすべての場所で違いが生じます。

#しかし、この場合、小規模なスパース性の利点も弱まります。

マルチビジョン タスクの強力な拠点

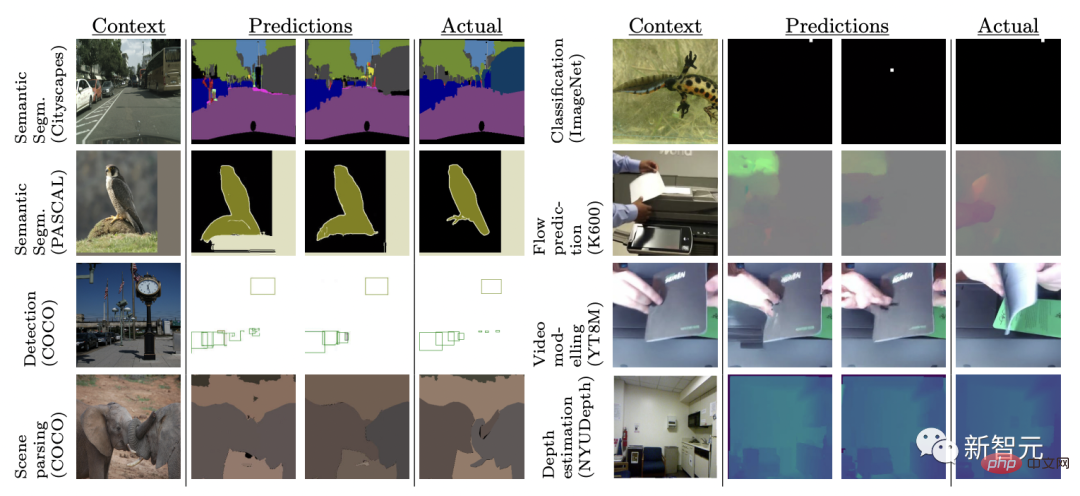

データ セットとタスクに関する一連のテストを通じて、結果は、Transframer が幅広いタスクに適用できることを示しています。

これには、ビデオ モデリング、新しいビュー合成、セマンティック セグメンテーション、オブジェクト認識、深度推定、オプティカル フロー予測などが含まれます。

ビデオ モデリング

Transframer による予測入力ビデオ フレームのシーケンスが指定された場合の次のフレーム。

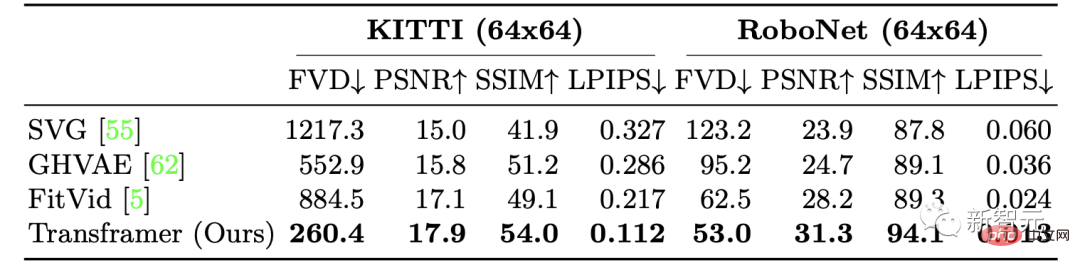

研究者らは、KITTI データセットと RoboNet データセットでそれぞれビデオ生成における Transframer のパフォーマンスをトレーニングしました。

KITTI の場合、5 つのコンテキスト フレームと 25 のサンプル フレームが与えられた場合、結果は、Transframer モデルがすべてのフレームでより優れたパフォーマンスを示すことを示しています。メトリクス LPIPS と FVD のパフォーマンスが向上しましたが、その中でも LPIPS と FVD の向上が最も顕著です。

RoboNet では、研究者には 2 つのコンテキスト フレームと 10 のサンプリング フレーム (それぞれ 64x64 と 128x128) が与えられました。一定の解像度で実行され、最終的に非常に良い結果が得られました。

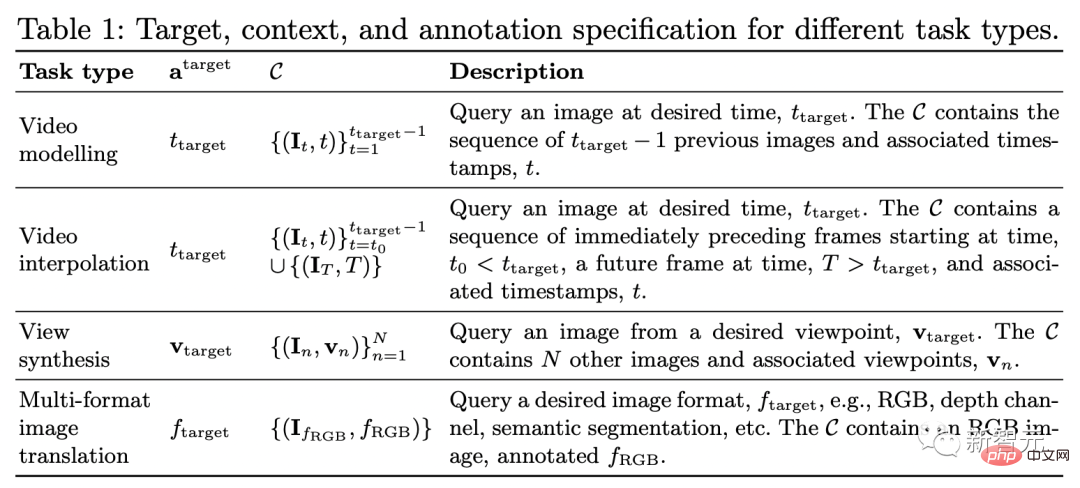

#構成を見る

ビューの合成に関しては、表 1 (3 行目) で説明されているように、カメラ ビューをコンテキストおよびターゲットの注釈として提供し、指定された最大値まで複数のコンテキスト ビューを均一にサンプリングすることで作業します。

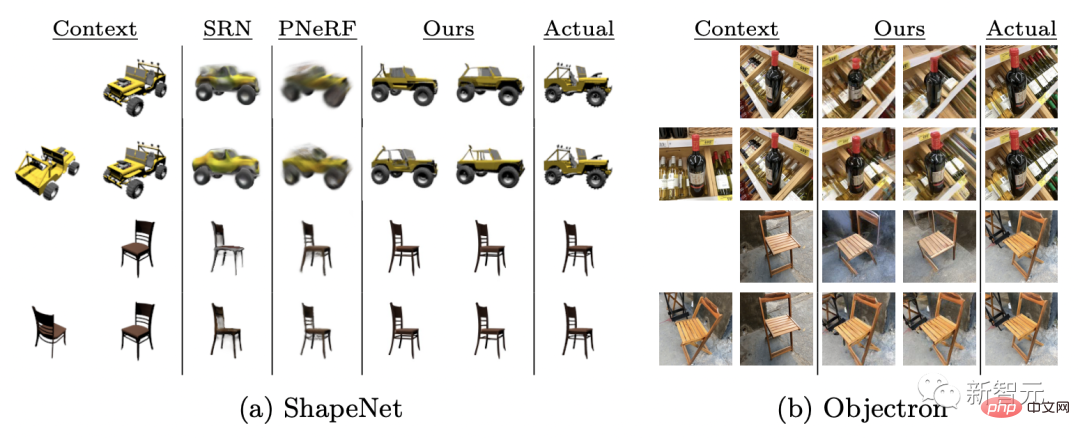

1 ~ 2 つのコンテキスト ビューを提供することにより、モデル Transframer は ShapeNet ベンチマークで評価され、PixelNeRF および SRN を大幅に上回りました。

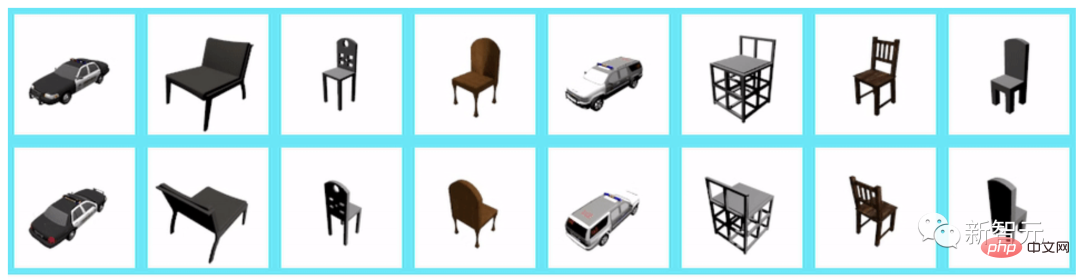

さらに、データセット Objectron の評価後、単一の入力ビューが与えられると、モデルが次の結果を生成することがわかります。一貫した出力ですが、椅子の脚を交差させるなどのいくつかの機能がありません。

#1 つのコンテキスト ビューが指定された場合、128×128 の解像度で合成されたビューは次のようになります。

さらに 2 つのコンテキスト ビューが指定された場合、128×128 の解像度で合成されたビューは次のようになります: #複数のビジョン タスク さまざまなコンピューター ビジョン タスクでは、複雑なアーキテクチャが使用されることがよくあります。および処理する損失関数。 ここでは、研究者らは共同で、同じ損失関数を使用して 8 つの異なるタスクとデータセットで Transframer モデルをトレーニングしました。 8 つのタスクは次のとおりです: 単一画像のオプティカル フロー予測、オブジェクト分類、検出とセグメンテーション、セマンティック セグメンテーション (2 つのデータ セット上)、将来のフレーム予測そして深さの推定。 #結果は、Transframer がまったく異なるタスクで異なるサンプルを生成することを学習していることを示しています。モデルは高品質の出力を生成します。 ただし、将来のフレーム予測や境界ボックス検出などのタスクにおけるモデル出力の品質は変動しており、この設定でのモデリングはより困難であることが示唆されています。 。

以上が写真を送って 30 秒のビデオを生成してください。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。