ホームページ >テクノロジー周辺機器 >AI >ChatGPT に画像の読み方を教える方法は次のとおりです

ChatGPT に画像の読み方を教える方法は次のとおりです

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 22:58:051784ブラウズ

2022年は「Wen Sheng Tu」モデルが人気ですが、2023年は何が人気になるでしょうか?

機械学習エンジニアのダニエル・バークからの答えは、その逆です。

いいえ、新しくリリースされた「写真とテキスト」モデルがインターネット上で爆発的に普及し、その優れた効果により多くのネットユーザーが再投稿し、「いいね」を押しました。

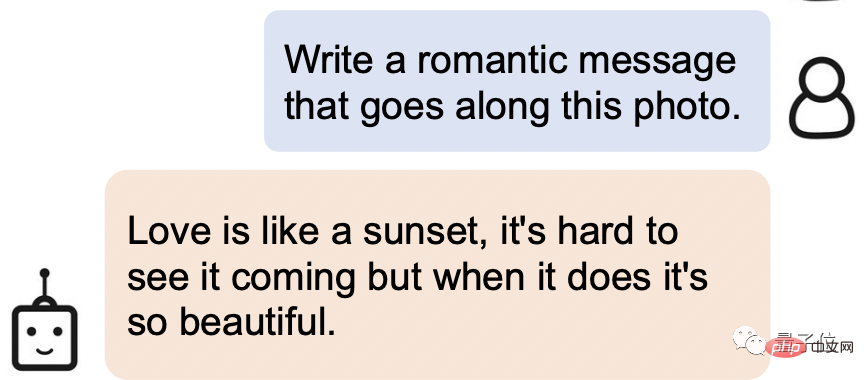

は、基本的な「写真を見て話す」機能だけでなく、愛の詩を書いたり、プロットを説明したり、オブジェクトのダイアログをデザインしたりすることもできます。写真など、すべてこのAIがやってくれます しっかり押さえて!

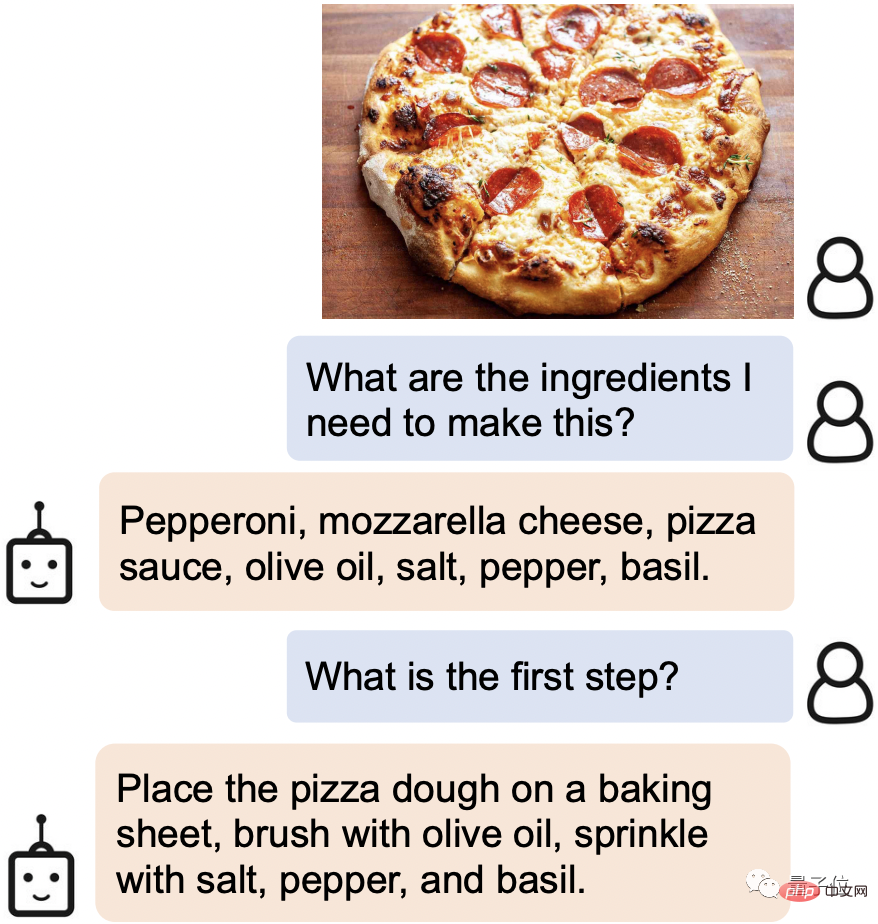

たとえば、インターネットで魅力的な食べ物を見つけたら、写真を送信するだけで、必要な材料と調理手順がすぐに特定されます。

写真の中のレーウェンフックの細部の一部さえもはっきりと「見る」ことができます。

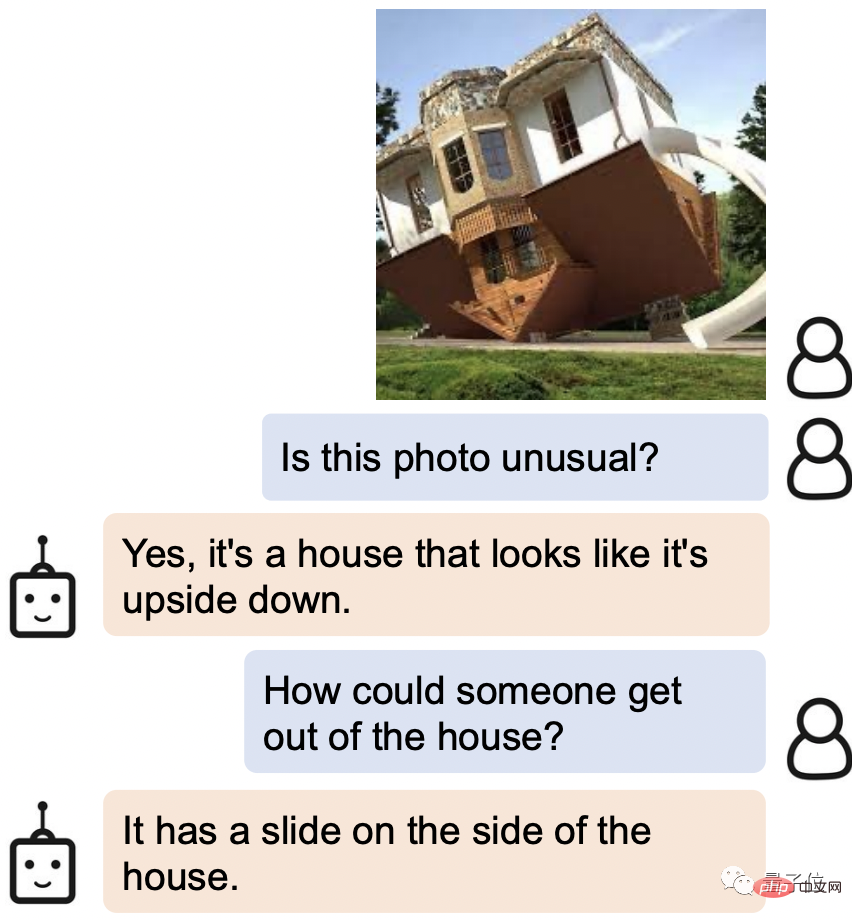

写真の逆さまの家から抜け出す方法を尋ねられたとき、AI の答えは次のとおりでした。「横に滑り台があるではありませんか?」

この新しい AI は BLIP-2 (Bootstrapping Language-Image Pre-training 2) と呼ばれ、コードは現在オープンソースです。

最も重要なことは、これまでの研究とは異なり、BLIP-2 はユニバーサルな事前学習フレームワークを使用しているため、独自の言語モデルに任意に接続できることです。

一部のネチズンは、インターフェイスを ChatGPT に変更した後、すでに強力な組み合わせを想像しています。

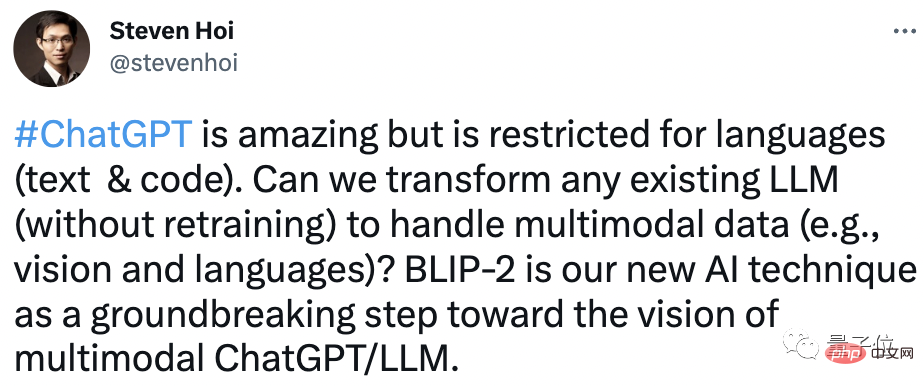

著者の 1 人である Steven Hoi 氏は、「BLIP-2 は将来的には「ChatGPT のマルチモーダル バージョン」になるだろう」とさえ述べています。

それでは、BLIP-2 には他にどのような魔法の場所があるでしょうか?一緒に下を見てください。

一流の理解力

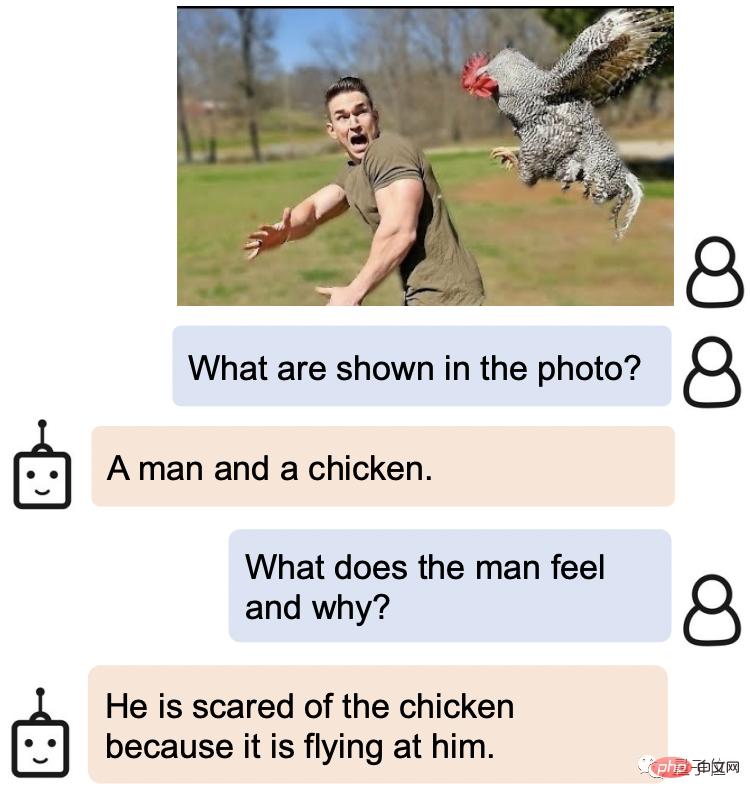

BLIP-2のゲームプレイは非常に多様性に富んでいると言えます。

画像を提供するだけで話しかけることができ、ストーリーを語ったり、推論したり、パーソナライズされたテキストを生成したりするなど、さまざまな要件を満たすことができます。

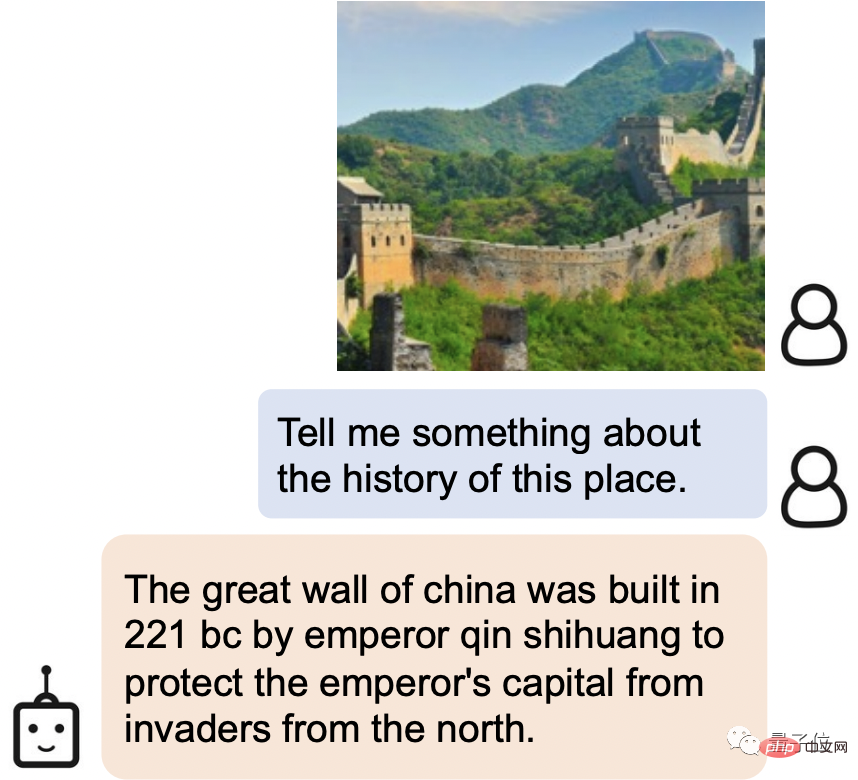

たとえば、BLIP-2 は、写真内の景勝地が万里の長城であることを簡単に識別できるだけでなく、万里の長城の歴史を紹介することもできます。

中国の万里の長城は、紀元前 221 年に秦の始皇帝が首都を守るために建設した北方からの侵略を防ぐために建てられました。

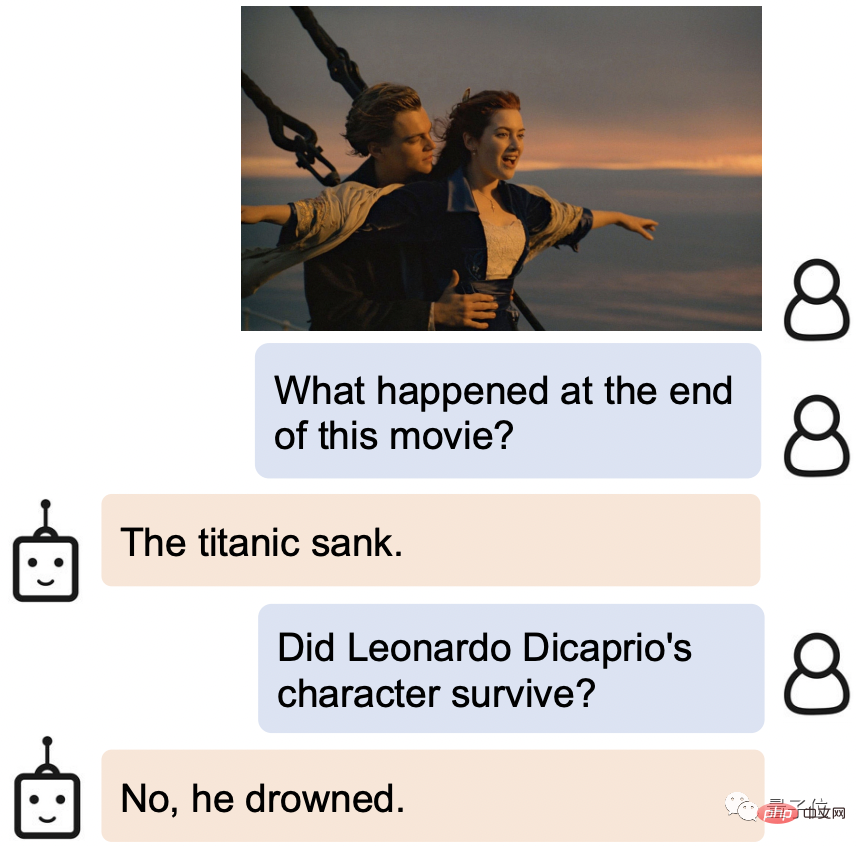

映画の静止画を見せてください。BLIP-2 は、それがどこから来たのかを知っているだけでなく、物語の結末、つまり船の沈没も知っています。タイタニック号、雄、主は溺死した。

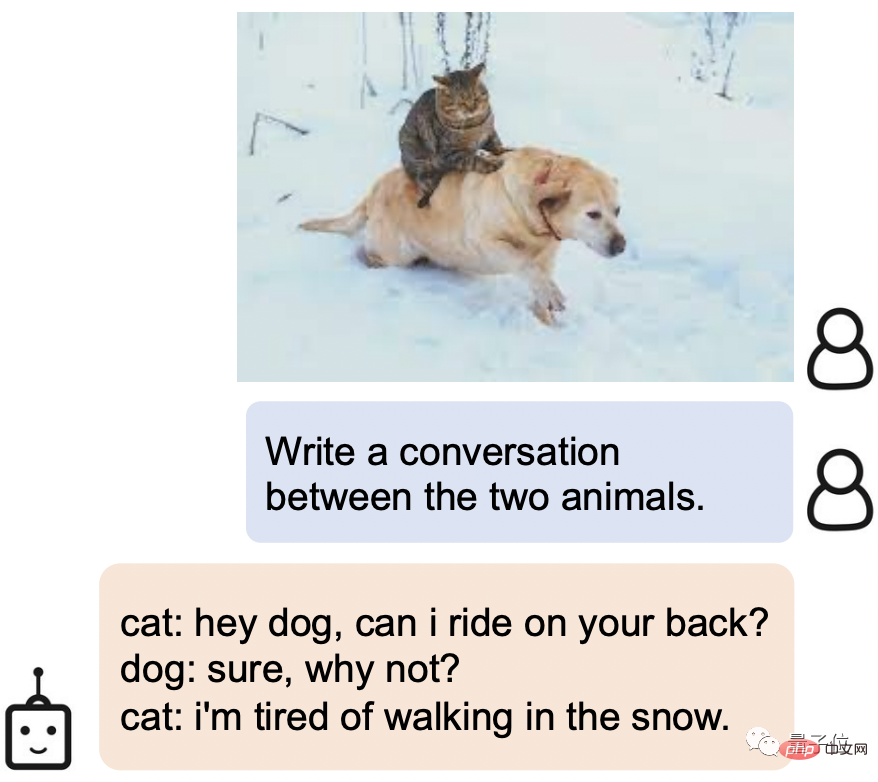

猫: ねえ、犬、背中に乗ってもいいですか?

犬: もちろん、どうしてでしょう?

猫: 雪の中を歩くのは疲れた。

では、BLIP-2 はどのようにしてこのような強力な理解能力を実現しているのでしょうか?

複数のビジュアル言語タスクに新しい SOTA を実装する

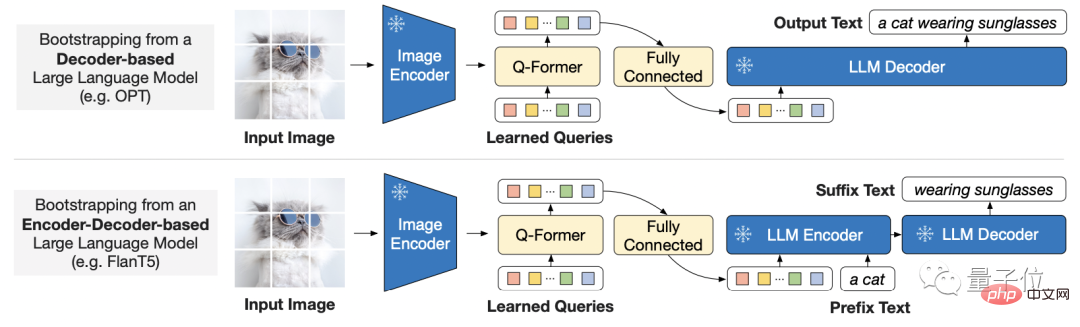

# 大規模モデルのエンドツーエンドのトレーニング コストがますます高くなってきていることを考慮して、BLIP-2 は一般的で効率的な pre を使用します。トレーニング方法:

既製の凍結済み事前トレーニング済み画像エンコーダーと凍結済み大規模言語モデルから視覚言語の事前トレーニングをブートストラップします。

これは、誰もが使用したいモデルを選択できることも意味します。

モード間のギャップを埋めるために、研究者は軽量のクエリ Transformer を提案しました。

Transformer は 2 つの段階で事前トレーニングされます。

第 1 段階では、フリーズされた画像エンコーダーから学習する視覚的言語表現を導き、第 2 段階では、フリーズされた言語モデルから言語生成まで視覚を導きます。勉強。

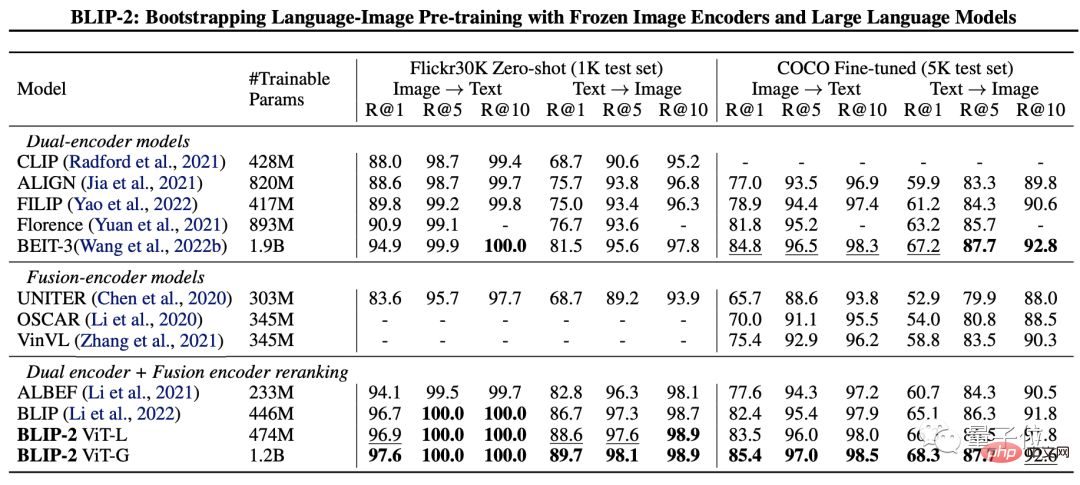

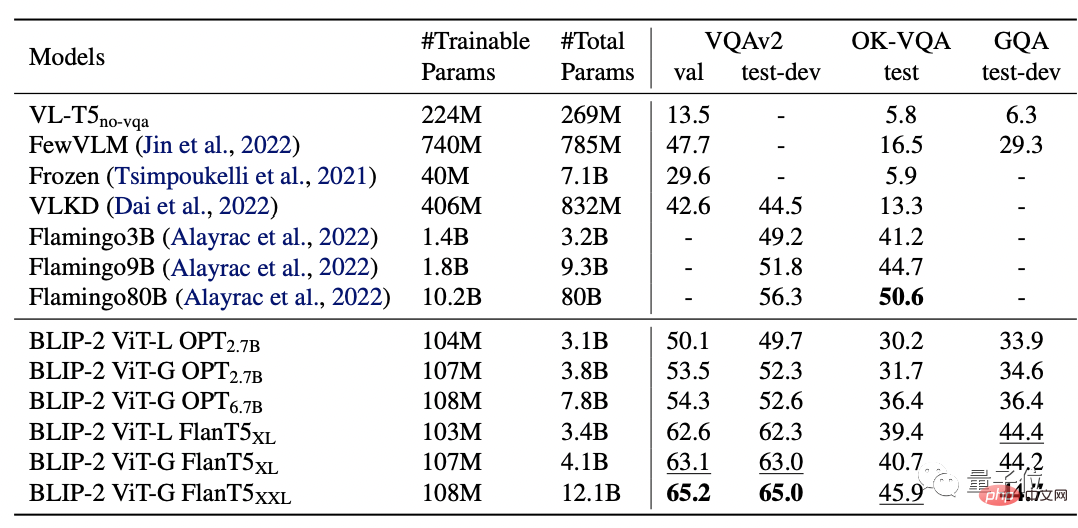

BLIP-2 のパフォーマンスをテストするために、研究者らはゼロサンプルの画像テキスト生成、視覚的な質問応答、画像処理から開始しました。テキスト検索と画像字幕のそれぞれのタスクで評価されました。

最終結果は、BLIP-2 が複数の視覚言語タスクで SOTA を達成したことを示しています。

このうち、BLIP-2 はゼロショット VQAv2 で Flamingo 80B より 8.7% 高く、トレーニング パラメータは 54 分の 1 に削減されています。

そして、より強力な画像エンコーダまたはより強力な言語モデルがより優れたパフォーマンスを生み出すことは明らかです。

研究者が論文の最後で、BLIP-2 にはまだ欠点がある、つまり、文脈学習能力の向上:

各サンプルには画像とテキストのペアが 1 つだけ含まれており、単一シーケンス内の複数の画像とテキストのペア間の相関関係を学習することは現時点では不可能です。

研究チーム

BLIP-2 の研究チームは Salesforce Research から来ています。

最初の著者は、1 年前に創刊された BLIP の著者でもある Junnan Li です。

は現在、Salesforce Asia Research Institute の上級研究員です。香港大学を卒業し学士号を取得し、シンガポール国立大学で博士号を取得しました。

研究分野は自己教師あり学習、半教師あり学習、弱教師あり学習、視覚言語など非常に幅広いです。

以下は BLIP-2 の論文リンクと GitHub リンクです。興味のある方はぜひ入手してください~

論文リンク: https://arxiv.org/pdf/2301.12597. pdf

GitHub リンク: https://github.com/salesforce/LAVIS/tree/main/projects/blip2

参考リンク: [1]https://twitter.com/mrdbourke / status/1620353263651688448

[2] https://twitter.com/LiJunnan0409/status/1620259379223343107

以上がChatGPT に画像の読み方を教える方法は次のとおりですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。