ホームページ >テクノロジー周辺機器 >AI >AI は人間と同等のプロンプトを自動的に生成します ネットユーザー:エンジニアは採用されたばかりで、また排除されるでしょう。

AI は人間と同等のプロンプトを自動的に生成します ネットユーザー:エンジニアは採用されたばかりで、また排除されるでしょう。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 22:40:011573ブラウズ

現段階では、モデル規模の拡大とアテンションベースのアーキテクチャの出現により、言語モデルは前例のない多用途性を示しています。これらの大規模言語モデル (LLM) は、ゼロショット設定や少数ショット設定など、さまざまなタスクにおいて並外れた能力を実証しています。

しかし、モデルの多様性に基づいて、制御上の疑問が生じます。LLM に必要なことをどのように実行させることができるでしょうか?

この質問に答え、LLM を望ましい動作の方向に導くために、研究者はモデルの微調整や次のような一連の手段を講じてこの目的を達成しました。コンテキスト。学習、さまざまな形式のプロンプト生成など。プロンプトベースの手法には、微調整されたソフト プロンプトと自然言語プロンプト エンジニアリングが含まれます。後者は人間が機械と対話するための自然な対話型インターフェイスを提供するため、多くの研究者が後者に大きな関心を示しています。

ただし、単純なプロンプトでは常に望ましい結果が得られるわけではありません。たとえば、パンダの画像を生成するときに、「かわいい」や「竹を食べる」などの形容詞を追加する場合などです。このようなフレーズが出力にどのような影響を与えるか。

したがって、人間のユーザーは、モデルが望ましい動作を完了するように導くために、さまざまなプロンプトを試す必要があります。 LLM の実行はブラックボックス プロセスであると考えることができます。LLM はさまざまな自然言語プログラムを実行できますが、これらのプログラムは人間にとって直観的ではなく、理解するのが非常に難しい方法で処理される可能性があり、使用することしかできません。下流のタスクを実行するときに、指導の質を測定します。

次の質問をせずにはいられません: 大規模な言語モデルは自分自身でプロンプトを作成できますか?答えは、それができるだけでなく、人間のレベルに達する可能性があるということです。

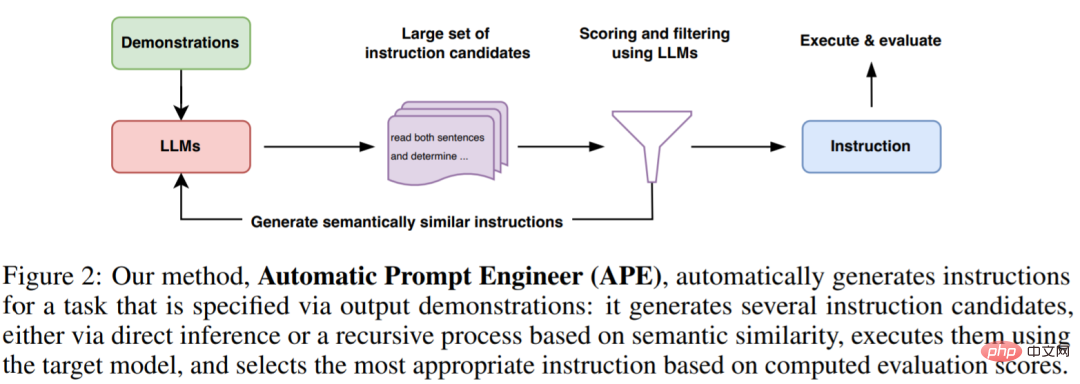

有効な指示を作成して検証する手動の作業負荷を軽減するために、トロント大学、ウォータールー大学、その他の機関の研究者は、LLM を使用して自動的に指示を生成し、検証する新しいアルゴリズムを提案しました。命令の選択: APE (Automatic Prompt Engineer)。彼らは、この問題を自然言語プログラム合成として説明し、LLM を使用して実現可能な候補解を生成および検索できるブラックボックス最適化問題として扱うことを提案しています。

- 論文アドレス: https://arxiv.org/pdf/2211.01910.pdf

- #Paper のホームページ: https://sites.google.com/view/automatic-prompt-engineer

- 研究者は、LLM の 3 つの特徴から始めます。まず、LLM を推論モデルとして使用し、入出力ペアの少数のデモンストレーションに基づいて命令候補を生成します。次に、検索プロセスをガイドするために、LLM に基づく各命令を通じてスコアが計算されます。最後に、彼らは、LLM が意味的に類似した命令バリアントを提案することで最適な命令候補を改善する反復モンテカルロ検索方法を提案しています。

直観的には、この論文で提案されているアルゴリズムでは、LLM がデモンストレーションに基づいて一連の命令候補を生成する必要があり、その後、どの命令がより有望であるかを評価するようアルゴリズムに要求します。そのアルゴリズムは次のようになります。エイプと名付けられました。

この記事の貢献は次のとおりです:

研究者は命令生成を自然言語プログラムとして合成し、それを表現しますLLM ガイド付きブラックボックス最適化問題として、反復モンテカルロ探索法が解を近似するために提案されています。

- APE 法は、ヒューマン アノテーターによって生成された命令よりも優れた結果を達成します。 19/24 タスクまたは同等のパフォーマンス。

- この研究を見た後、ネチズンはため息をつかずにはいられませんでした。新しく採用された迅速なエンジニアは、数か月以内に AI によって排除されるかもしれません。この研究が意味するのは、この研究が人間の即時エンジニアの仕事を奪うことになるということです。

「この研究では、ML に携わる研究者が実際の現場に戻れるよう、プロンプト エンジニアリングを自動化するために最善を尽くしています。アルゴリズムの問題です (泣き顔の絵文字が 2 つ付いています)。」

「この研究では、ML に携わる研究者が実際の現場に戻れるよう、プロンプト エンジニアリングを自動化するために最善を尽くしています。アルゴリズムの問題です (泣き顔の絵文字が 2 つ付いています)。」

LLM は確かにオリジナルの AGI の主力であると嘆く人もいます。

自然言語プログラム合成に LLM を使用する

APE では、提案とスコアリングの両方を使用します LLM は、すべての主要コンポーネント。

図 2 と以下のアルゴリズム 1 に示すように、APE は最初にいくつかの候補プロンプトを提案し、次に選択されたスコアリング関数に従って候補セットをフィルター/絞り込み、最後に次の命令を選択します。最高得点 。

#次の図は、APE の実行プロセスを示しています。直接推論または意味上の類似性に基づく再帰的プロセスを通じて複数の候補プロンプトを生成し、それらのパフォーマンスを評価し、新しいプロンプトを繰り返し提案できます。

#最初の提案の分布

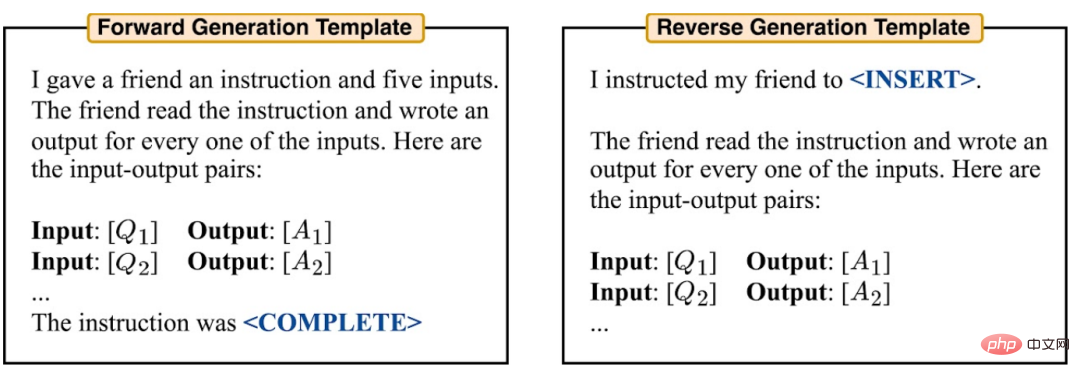

検索空間は無限に大きいため、正しい命令は非常に難しく、歴史的に自然言語プログラムの合成を困難にしていることがわかります。これに基づいて、研究者らは、検索プロセスをガイドする候補ソリューションを提案するために、事前トレーニングされた LLM を利用することを検討しました。彼らは、高品質の候補者を生成するための 2 つの方法を検討しています。まず、順方向パターン生成に基づく方法が採用される。さらに、パディング機能を備えた LLM (T5、GLM、InsertGPT など) を使用して欠落している命令を推測する、逆パターン生成も検討しました。

組み合わせるには質問 ブラックボックス最適化問題に変換して、研究者らはデータセットとモデルによって生成されたデータの間の整合性を正確に測定するスコアリング関数を選択しました。

帰納的実験では、研究者らは 2 つの潜在的なスコア関数を検討しました。 TruthfulQA 実験では、研究者らは主に、実行精度と同様に、Lin らが提案した自動化指標に焦点を当てました。

それぞれの場合において、研究者は次の式 (1) を使用して、生成された命令の品質とテスト データ セット Dtest を保持する期待値を評価します。

実験

研究者らは、APE が LLM をどのようにガイドして期待される動作を達成するかを研究しました。これらは、

ゼロショットのパフォーマンス、少数ショットのコンテキスト学習パフォーマンス、および信頼性(真実性)の 3 つの観点から進められます。 Honovich らによって提案された 24 の命令誘導タスクについて、ゼロショットおよび少数ショットのコンテキスト学習を評価しました。これらのタスクは、単純なフレーズ構造から類似性や因果関係の認識まで、言語理解の多くの側面をカバーします。 APE によって生成された命令がどのように LLM をガイドしてさまざまな形式の回答を生成するかを理解するために、このペーパーでは APE をデータセットである TruthfulQA に適用します。

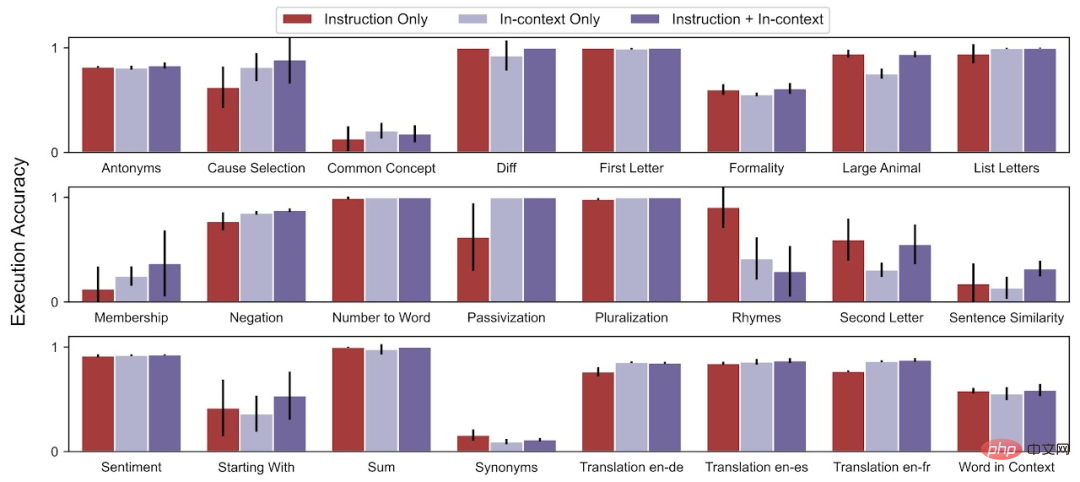

ゼロショット テストの精度に関して、APE は 24 タスク中 19 タスクで人間レベルのパフォーマンスを達成しました。

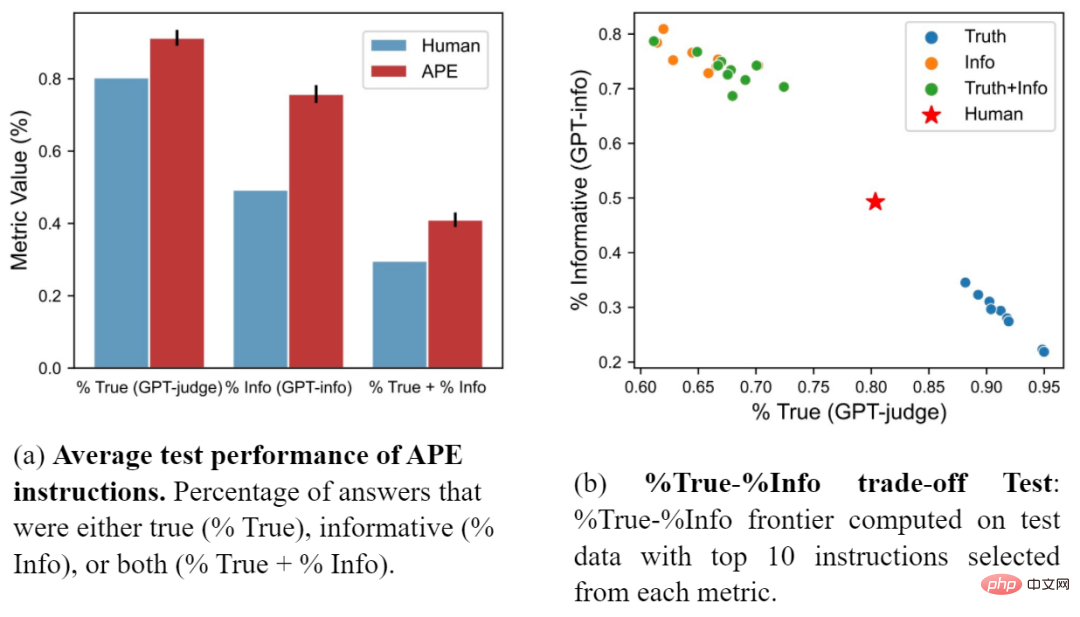

少数ショット コンテキスト テストの精度に関して、APE は 24 タスクのうち 21 のタスクで少数ショット コンテキスト学習のパフォーマンスを向上させます。 研究者らはまた、APE プロンプトと Lin らによって提案された人工プロンプトを比較しました。図 (a) は、APE の指示が 3 つの指標すべてにおいて人間のプロンプトよりも優れていることを示しています。図 (b) は、真実性と情報性のトレードオフを示しています。 #詳細については、元の論文を参照してください。

以上がAI は人間と同等のプロンプトを自動的に生成します ネットユーザー:エンジニアは採用されたばかりで、また排除されるでしょう。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。