ホームページ >テクノロジー周辺機器 >AI >ディープフェイクに代わるものとして期待されていますか?今年最も人気のある NeRF テクノロジーの素晴らしさを明らかにする

ディープフェイクに代わるものとして期待されていますか?今年最も人気のある NeRF テクノロジーの素晴らしさを明らかにする

- PHPz転載

- 2023-04-12 21:37:011666ブラウズ

えっ、まだ NeRF を知らないのですか?

NeRF は、コンピューター ビジョンの分野で今年最も注目されている AI テクノロジーとして広く使用されており、明るい将来があると言えます。

ステーション B の友人たちは、このテクノロジーを新しい方法で使用しています。

良いニュースを引き寄せるために

それでは、NeRFとは一体何なのでしょうか?

NeRF (Neural Radiance Fields) は、2020 ECCV カンファレンスの最優秀論文で最初に提案された概念であり、2D ポーズ画像のみを監督として使用し、暗黙的な表現を新しいレベルに押し上げます。次元のシーン。

一石は千の波を巻き起こす その後、NeRF は急速に発展し、「新しい視点の合成、三次元再構成」など、多くの技術的方向に応用されています。

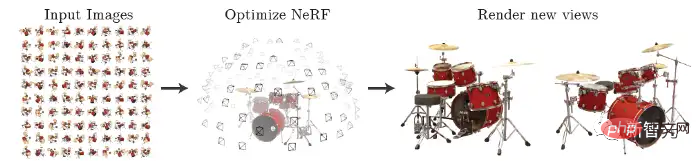

NeRF は、トレーニング用のポーズ付きのまばらなマルチアングル画像を入力して神経放射線野モデルを取得し、このモデルに従って、下図に示すように、どの角度から見ても鮮明な写真をレンダリングできます。これは、MLP を使用して 3 次元シーンを暗黙的に学習すると簡単に要約することもできます。

#ネチズンは当然、NeRF と同様に人気のあるディープフェイクを比較します。

MetaPhysics によって公開された最近の記事では、NeRF の進化の歴史、課題、利点を評価し、NeRF が最終的にディープフェイクに取って代わることを予測しました。

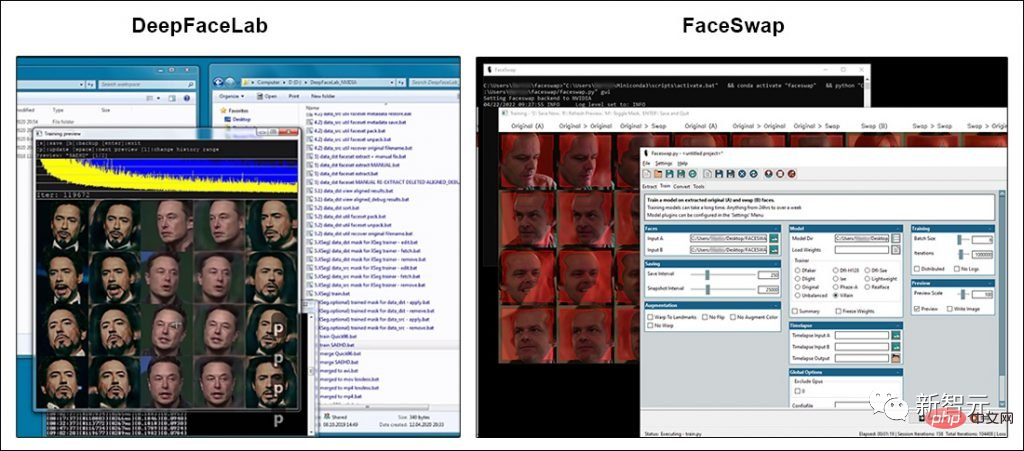

ディープフェイク技術に関する目を引くトピックのほとんどは、ディープフェイクが 2017 年に世間の注目を集めるようになった 2 つのオープンソース ソフトウェア パッケージ、DeepFaceLab (DFL) と FaceSwap に言及しています。

どちらのパッケージにも広範なユーザー ベースと活発な開発者コミュニティがありますが、どちらのプロジェクトも GitHub コードから大きく逸脱していません。

もちろん、DFL と FaceSwap の開発者は怠けているわけではありません。より高価な GPU が必要になりますが、より大きな入力画像を使用してディープフェイク モデルをトレーニングできるようになりました。

#しかし実際には、過去 3 年間でメディアが宣伝したディープフェイクの画質向上は主にエンドユーザーによるものです。

彼らは、データ収集における「時間を節約し、まれな」経験と、モデルをトレーニングするための最良の方法 (1 回の実験に数週間かかる場合もあります) を蓄積し、オリジナルの 2017 年のデータを活用して拡張する方法を学びました。コード。最も外側の制限。

VFX および ML 研究コミュニティの一部は、機械学習モデルを最大 1024×1024 の画像でトレーニングできるようにアーキテクチャを拡張することで、人気のディープフェイク パッケージの「ハード リミット」を突破しようとしています。

ピクセルは、DeepFaceLab または FaceSwap の現在の実際の範囲の 2 倍であり、映画やテレビの制作に役立つ解像度に近くなります。

NeRFについて一緒に学びましょう~

お披露目

2020年に登場したNeRF(Neural Radiance Fields)は、ニューラルネットワークの一種で、物体や環境を再構成する手法です。ネットワーク内の複数の視点からの写真をつなぎ合わせることによって。

入力ビューの疎なセットを使用して基礎となる連続体積シーン関数を最適化することで、複雑なシーン ビューを合成するための最良の結果が得られます。

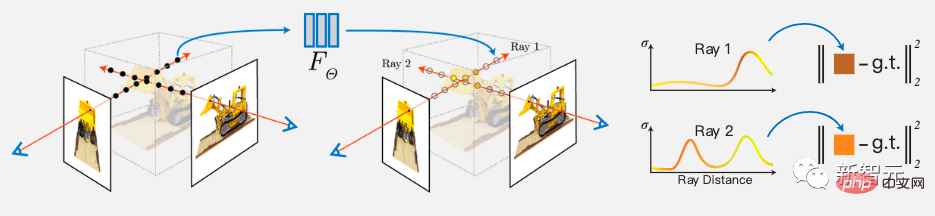

このアルゴリズムでは、完全に接続されたディープ ネットワークも使用してシーンを表現します。その入力は単一の連続 5D 座標 (空間位置 (x、y、z) および視線方向 (θ、φ)) であり、その出力は、空間位置での体積密度と、それに関連する発光振幅の明るさです。

ビューは、カメラ レイに沿って 5D 座標をクエリし、古典的なボリューム レンダリング技術を使用して出力の色と密度を画像に投影することによって合成されます。

実装プロセス:

まず、連続シーンを 5D ベクトル値関数として表します。その入力は、の出力は発光色 c と体積密度 σ です。

実際には、3D デカルト単位ベクトル d が方向を表すために使用されます。この連続 5D シーン表現は MLP ネットワークで近似され、その重みが最適化されます。

さらに、位置 x の関数として体積密度 σ を予測するようにネットワークを制限することで、表現が複数のビューにわたって一貫性を持つように奨励されます。また、位置と視線方向の関数として RGB カラー c を予測できるようになります。 。

これを実現するために、MLP はまず、入力 3D 座標 x を 8 つの完全に接続された層 (ReLU アクティベーションと層ごとに 256 チャネルを使用) で処理し、σ および 256 次元の特徴ベクトルを出力します。

この特徴ベクトルは、カメラ レイの視線方向と連結され、ビューに関連付けられた RGB カラーを出力する完全に接続された追加の層に渡されます。

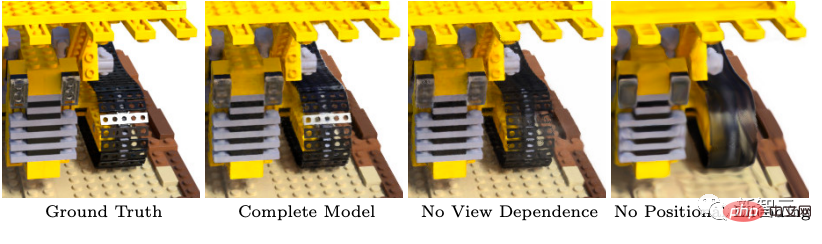

さらに、NeRF では、高解像度の複雑なシーンの表現を実現するために 2 つの改善も導入されています。 1 つ目は、MLP による高周波関数の表現を支援する位置エンコーディングであり、2 つ目は、高周波表現を効率的にサンプリングできるようにする層別サンプリング プロセスです。

ご存知のとおり、Transformer アーキテクチャの位置エンコーディングは、シーケンス内のマークの離散位置をアーキテクチャ全体の入力として提供できます。 NeRF は位置コーディングを使用して連続入力座標を高次元空間にマッピングし、MLP が高周波関数を近似しやすくします。

以上がディープフェイクに代わるものとして期待されていますか?今年最も人気のある NeRF テクノロジーの素晴らしさを明らかにするの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。