ホームページ >テクノロジー周辺機器 >AI >Google がビデオ生成 AIGC を初めてリリース、ネチズン: 映画をカスタマイズできる

Google がビデオ生成 AIGC を初めてリリース、ネチズン: 映画をカスタマイズできる

- PHPz転載

- 2023-04-12 20:10:121658ブラウズ

生成モデルとマルチモーダル視覚言語モデルの進歩により、前例のない生成リアリズムと多様性を備えた大規模なテキストから画像へのモデルへの道が開かれたことを私たちは知っています。これらのモデルは新しい創造的なプロセスを提供しますが、既存の画像を編集するのではなく、新しい画像を合成することに限定されます。このギャップを埋めるために、直感的なテキストベースの編集方法により、生成された画像と実際の画像のテキストベースの編集が可能になり、これらの画像の元のプロパティの一部が保持されます。画像と同様に、最近多くのテキストからビデオへのモデルが提案されていますが、これらのモデルをビデオ編集に使用する方法はほとんどありません。

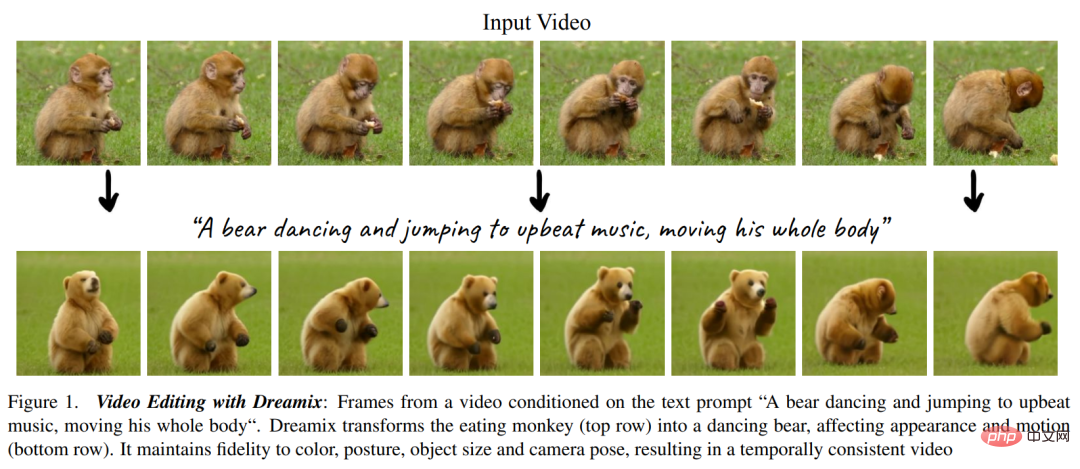

テキストガイド付きビデオ編集では、ユーザーは、以下の図 1 に示すように、生成されたビデオの予期されるプロパティを説明するテキスト プロンプトとともに入力ビデオを提供します。目標には次の 3 つの側面があります、1) 整列、編集されたビデオは入力テキスト プロンプトに準拠する必要があります、2) 忠実度、編集されたビデオは元のビデオの内容を保持する必要があります、3) 品質、編集されたビデオは高品質である必要があります。 。

#ご覧のとおり、 ビデオ編集は画像編集よりも難しく、単に見た目を変更するだけではなく、新しいアクションを合成する必要があります# 。時間的な一貫性を維持する必要もあります。したがって、SDEdit や Prompt-to-Prompt などの画像レベルの編集方法をビデオ フレームに適用するだけでは、良好な結果を得るには十分ではありません。

研究者らは、UniTune からインスピレーションを受け、テキスト条件付きビデオ拡散モデル (VDM) をビデオ編集に適用した新しい手法、Dreamix を提案しました。

- プロジェクトのホームページ: https://dreamix-video-editing.github.io/

- #この記事の方法の核心は次のとおりです。 テキスト条件付き VDM は、次の 2 つの方法によって入力ビデオに対する高い忠実度を維持します。主なアイデア

。 1 つはモデルの初期化として純粋なノイズを使用せず、元のビデオのダウングレード バージョンを使用して、サイズを削減しノイズを追加することで低い時空間情報のみを保持します。もう 1 つは、モデルの初期化を微調整することで元のビデオの忠実度をさらに向上させます。元のビデオに生成モデルを費やします。 微調整により、モデルが元のビデオの高解像度特性を確実に理解できるようになります。入力ビデオを簡単に微調整することで、モデルがテキスト プロンプトに従うよりも生のモーションを優先するように学習するため、モーションの編集可能性が比較的低くなります。研究者らは、VDM も入力ビデオの個々のフレームのセットに対して微調整され、そのタイミングを破棄する、新しいハイブリッド微調整方法を提案しています。ブレンドの微調整により、モーション編集の品質が大幅に向上します。

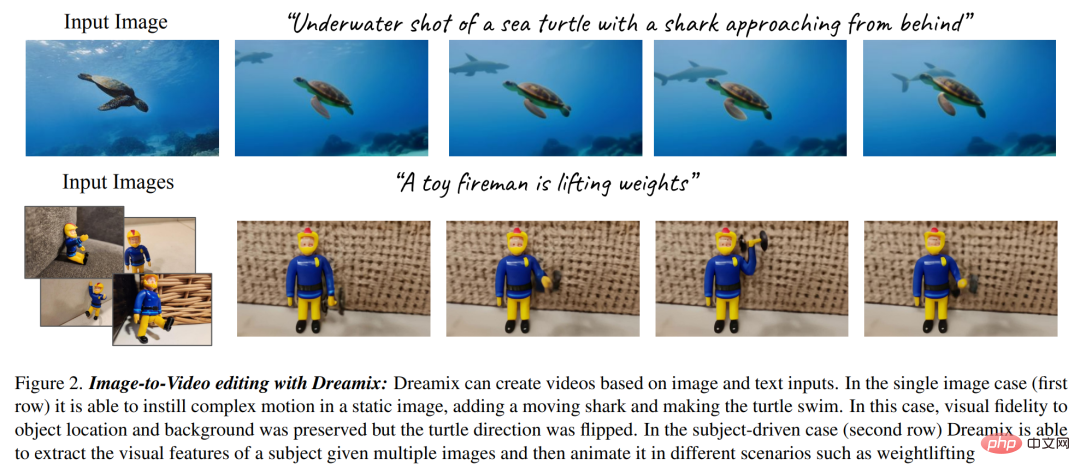

研究者らは、ビデオ編集モデルをさらに使用して、新しい画像アニメーション フレームワーク

を提案しました (以下の図 2 を参照)。このフレームワークは、画像内のオブジェクトや背景のアニメーション化、動的なカメラの動きの作成など、いくつかのステップで構成されています。これは、フレームのコピーや幾何学的画像変換などの単純な画像処理操作を通じて行われ、粗雑なビデオが作成されます。次に、Dreamix ビデオ エディターを使用してビデオを編集します。さらに、研究者らは、Dreambooth のビデオ版である目標主導型ビデオ生成の微調整手法も使用しました。

#実験表示部分では、研究者は広範な定性調査と手動評価を実施しました。彼らのメソッドの強力な機能については、次のアニメーションを参照してください。

この Google の調査では、3D モーションと編集ツールは次のように述べられています。次の論文の人気のトピックになるかもしれません。

# 他の人はこう言いました: 予算内ですぐに自分の映画を作ることができます。必要なのはグリーン スクリーンとこのテクノロジーだけです:

## を提案します。

#破壊されたビデオのリバース エンジニアリングによるテキストガイド付きビデオ編集彼らはカスケード VDM (ビデオ拡散モデル) を使用し、まず入力ビデオを特定のレベルまで破壊します。ダウンサンプリングを通じて拡張し、ノイズを追加します。次に、カスケード拡散モデルがサンプリング プロセスと条件付き時間 t に使用され、ビデオを最終的な時間空間解像度にアップスケールします。

入力ビデオを破棄するプロセスでは、まずダウンサンプリング操作を実行して基本モデル (16 フレーム 24 × 40) を取得し、次に分散は

ガウス ノイズであり、入力ビデオがさらに破損します。

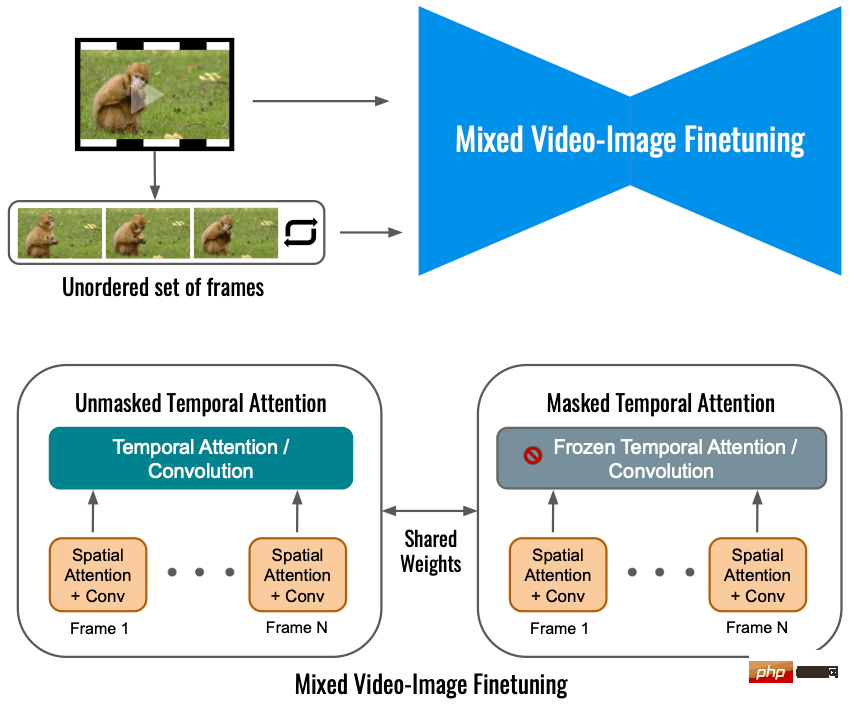

ハイブリッド ビデオ画像の微調整

入力ビデオのみを使用してビデオ拡散モデルを微調整すると、オブジェクトの動きの変化を制限します。代わりに、この研究ではハイブリッド ターゲットを使用します。つまり、元のターゲット (左下隅) に加えて、この論文では、順序付けされていないフレームのセットに対しても微調整を実行します。これは、「」を通じて行われます。一時的な注意を防ぐために「マスクされた一時的な注意」。力と畳み込みが微調整されます (右下)。この操作により、静止ビデオに動きを追加できます。

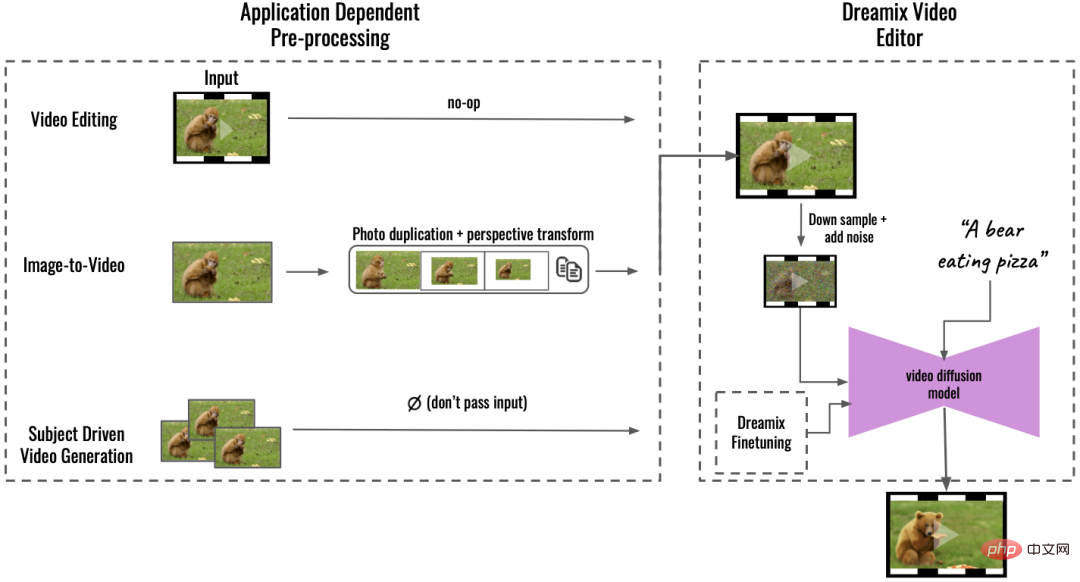

アプリケーション内この研究は、前処理 (アプリケーション依存の前処理、下図の左側) に基づいて、複数のアプリケーションをサポートし、入力コンテンツを統一されたビデオ形式に変換できます。画像からビデオへの変換の場合、入力画像がコピーおよび変換され、カメラの動きを含む大まかなビデオが合成されます。オブジェクト駆動型のビデオ生成の場合、忠実度を維持するために入力が省略され、個別に微調整されます。この大まかなビデオは、Dreamix Video Editor (右) を使用して編集されました。前述したように、ビデオは最初にダウンサンプリングによって破壊され、ノイズが追加されました。次に、微調整されたテキストガイド付きビデオ拡散モデルが適用され、ビデオが最終的な時間的および空間的解像度にアップスケールされます。

実験結果

ビデオ編集: 下の図では、Dreamix がアクションをダンスに変更し、見た目がダンスから変わります。サルとクマ、しかしビデオの被写体の基本的な属性は変わっていません:

ビデオ編集: 下の図では、Dreamix がアクションをダンスに変更し、見た目がダンスから変わります。サルとクマ、しかしビデオの被写体の基本的な属性は変わっていません:

画像からビデオへ: 入力が画像の場合、Dreamix はビデオを使用して新しい移動オブジェクトを追加できます。 、以下の通り 霧の森の中にユニコーンが現れ、ズームインされています。

ペンギンが小屋の隣に現れました:

目標主導型ビデオ生成: Dreamix は、同じ被写体を示す画像のコレクションを取得し、その被写体を移動オブジェクトとして含む新しいビデオを生成することもできます。下の写真は、葉の上でうごめく毛虫を示しています。

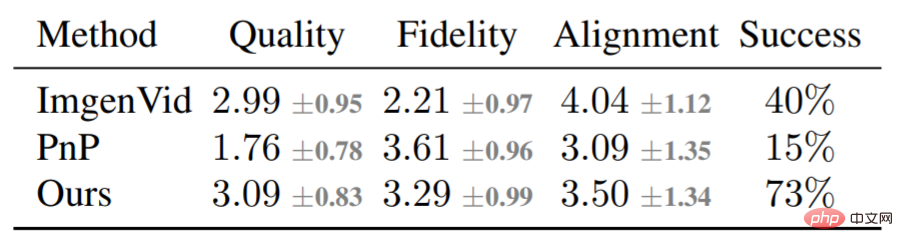

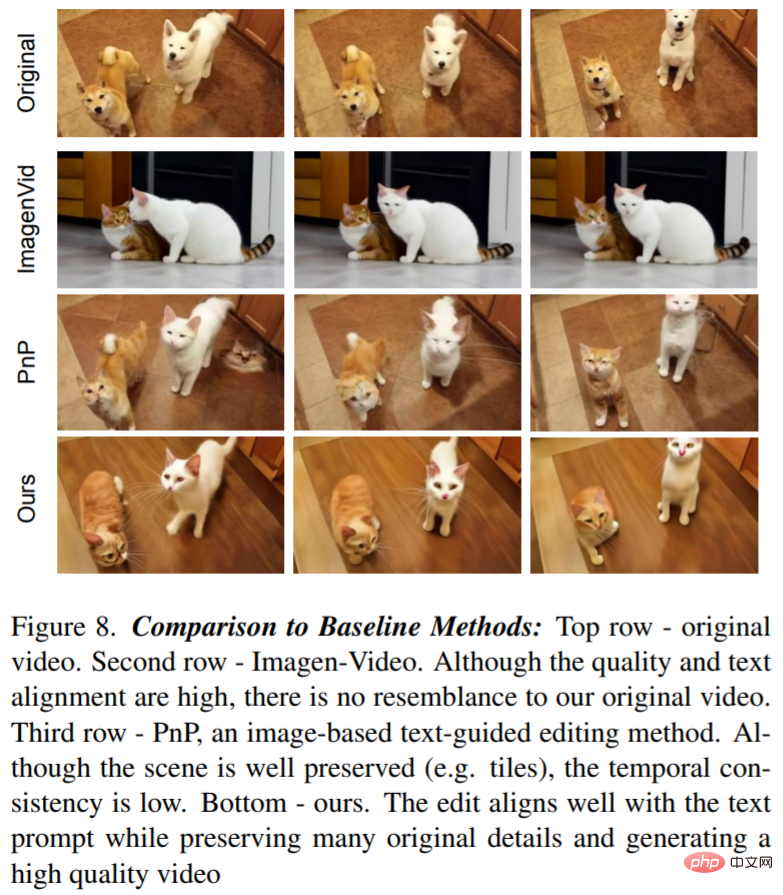

定性分析に加えて、この研究では主に Dreamix Compare with を使用してベースライン比較も実施しました。 2 つの基本的な方法: Imagen-Video とプラグ アンド プレイ (PnP)。次の表はスコアリング結果を示しています。

# 図 8 は、Dreamix によって編集されたビデオと 2 つのベースライン例を示しています。ビデオ モデルは、元のビデオに依存しないため、低忠実度の編集が可能になります。 PnP はシーンを保持しますが、フレームごとの一貫性に欠けます。Dreamix は 3 つの目標すべてで優れたパフォーマンスを発揮します。

#技術的な詳細については、元の論文を参照してください。

以上がGoogle がビデオ生成 AIGC を初めてリリース、ネチズン: 映画をカスタマイズできるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。