ホームページ >テクノロジー周辺機器 >AI >強化学習のもう一つの革命! DeepMind が提案する「アルゴリズム蒸留」: 探索可能な事前トレーニング済み強化学習 Transformer

強化学習のもう一つの革命! DeepMind が提案する「アルゴリズム蒸留」: 探索可能な事前トレーニング済み強化学習 Transformer

- 王林転載

- 2023-04-12 18:58:152021ブラウズ

現在のシーケンス モデリング タスクでは、Transformer は最も強力なニューラル ネットワーク アーキテクチャであると言え、事前トレーニングされた Transformer モデルは、プロンプトを条件として使用したり、コンテキスト内学習を使用してさまざまな状況に適応したりできます。 。

大規模な事前トレーニング済み Transformer モデルの汎化能力は、テキスト補完、言語理解、画像生成などの複数の分野で検証されています。

昨年以来、オフライン強化学習 (オフライン RL) をシーケンス予測問題として扱うことにより、モデルがオフライン データから ポリシーを学習できます。

しかし、現在のメソッドは、学習を含まないデータ (蒸留によって修正されたエキスパート ポリシーなど) からポリシーを学習するか、学習を含むデータ (たとえば、エージェントの重いバッファ)、しかしそのコンテキストが小さすぎるため、ポリシーの改善を捉えることができません。

DeepMind の研究者は、原則として、強化学習アルゴリズム トレーニングにおける学習の逐次的性質により、強化を学習に変換できることを観察を通じて発見しました。プロセス自体は「因果系列予測問題」 としてモデル化されます。

具体的には、Transformer のコンテキストが学習の更新によるポリシーの改善を含めるのに十分な長さである場合、固定ポリシーを表すだけでなく、次のこともできる必要があります。以前のエピソードの状態、アクション、報酬は、ポリシー改善演算子として表されます。

これは、あらゆる RL アルゴリズムを模倣学習を通じて十分に強力なシーケンス モデルに蒸留し、インコンテキスト RL アルゴリズムに変換できるという技術的な実現可能性も提供します。

これに基づいて、DeepMind は、因果系列モデルを確立することで強化学習アルゴリズムをニューラル ネットワークに抽出するアルゴリズム蒸留 (AD) を提案しました。

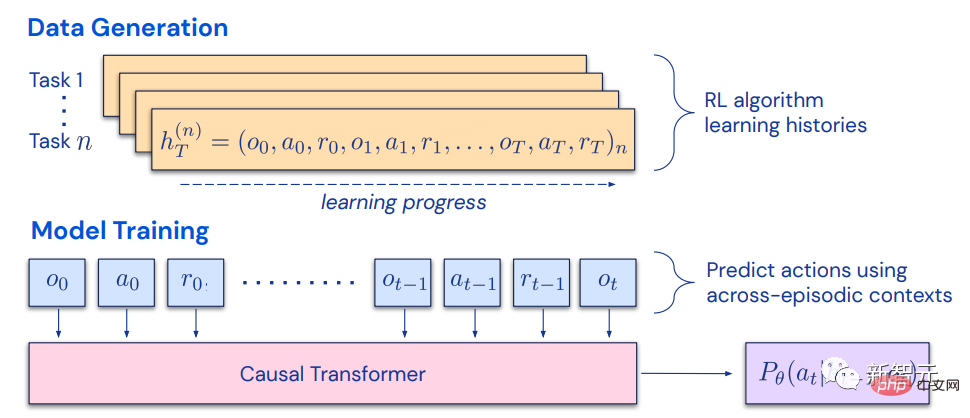

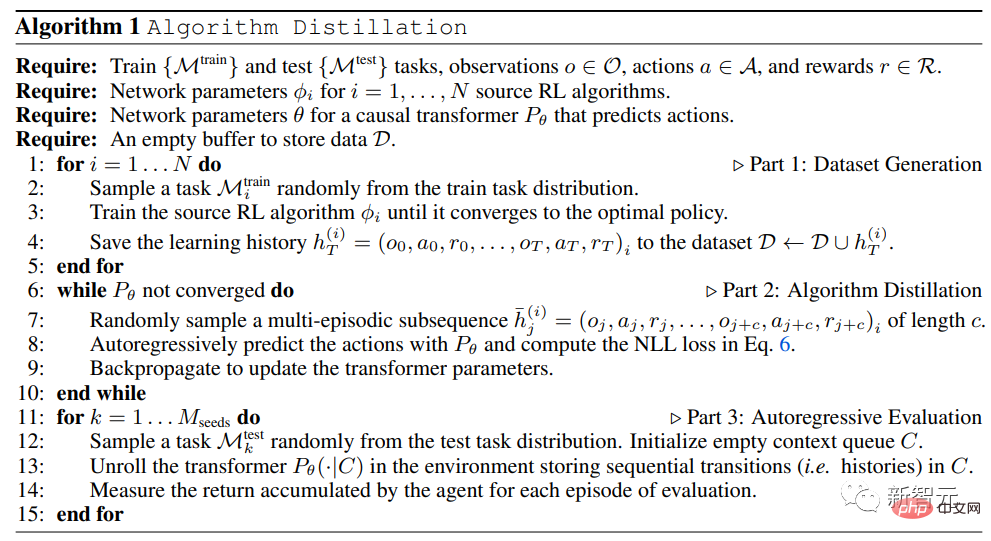

紙のリンク: https://arxiv.org/pdf/2210.14215.pdf #アルゴリズム蒸留は、学習強化学習をクロスエピソードシーケンス予測問題として扱い、ソース RL アルゴリズムを通じて学習履歴データセットを生成し、その学習履歴をコンテキストとして使用して、自己回帰予測を通じて因果トランスフォーマーをトレーニングします。行動 。

エキスパート シーケンスの事後学習やシーケンス ポリシー予測構造とは異なり、AD はネットワーク パラメーターを更新せずに、コンテキストに応じてポリシーを完全に改善できます。

Transformer は独自のデータを収集し、新しいタスクの報酬を最大化します;

- プロンプトや微調整は必要ありません;

- 重みを凍結すると、Transformer はコンテキストのリターンを探索、活用し、最大化することができます。 Gato などの専門的な蒸留方法では探究することができず、収益を最大化することはできません。

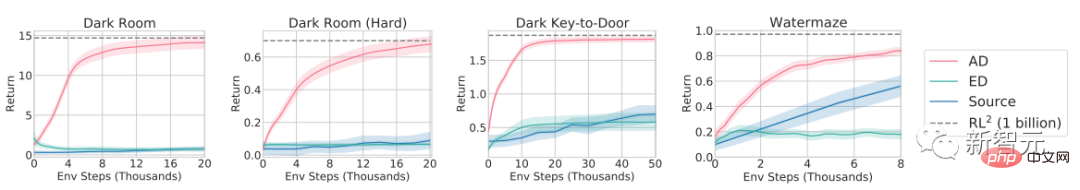

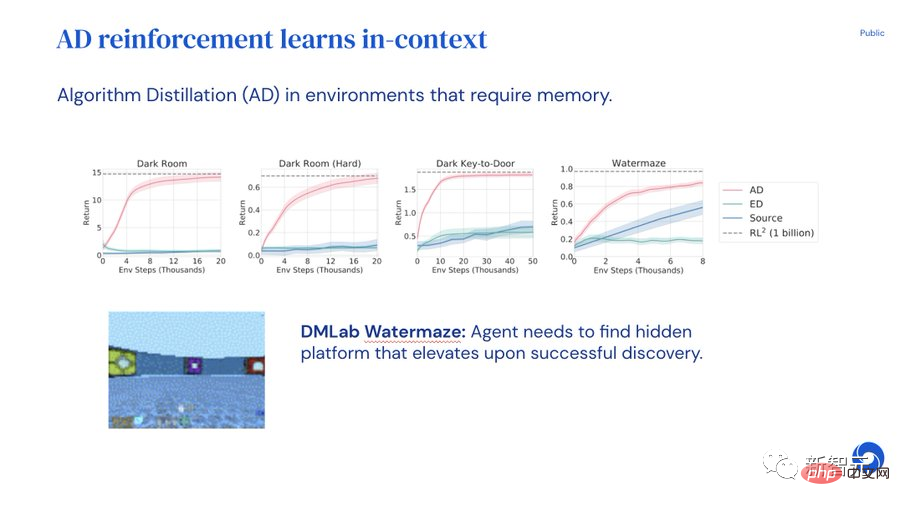

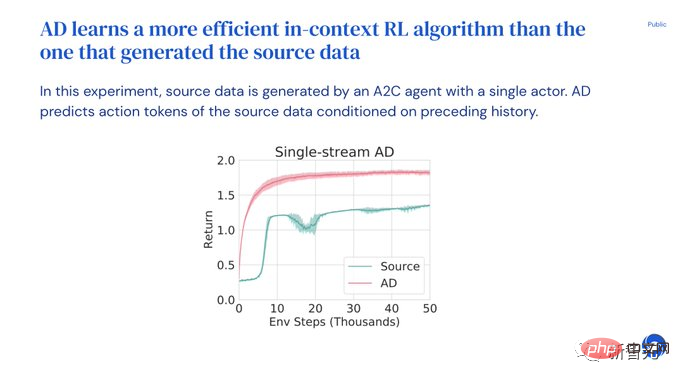

- 実験結果は、AD が報酬がまばらで、タスク構造が結合され、ピクセルベースの観察が行われたさまざまな環境で強化学習を実行できること、および AD 学習のデータ効率を証明しています (データ効率) は、ソース データを生成した RL アルゴリズムよりも優れています。

AD は、模倣損失を伴うオフライン データのシーケンス モデリングを通じて、コンテキスト内強化学習手法を実証した最初の

です。アルゴリズム蒸留

2021 年、一部の研究者は、Transformer が模倣学習を通じてオフライン RL データからシングルタスク ポリシーを学習できることを初めて発見し、その後、次のように拡張されました。同一ドメインおよびクロスドメイン設定でマルチタスク戦略を抽出できます。これらの研究は、一般的なマルチタスク ポリシーを抽出するための有望なパラダイムを提案しています。まず、多数の異なる環境相互作用データ セットを収集し、次にシーケンス モデリング戦略を通じてデータから 1 つを抽出します。

模倣学習を通じてオフライン RL データからポリシーを学習する方法は、オフライン ポリシー蒸留、または単に ポリシー蒸留 (ポリシー蒸留、PD) とも呼ばれます。

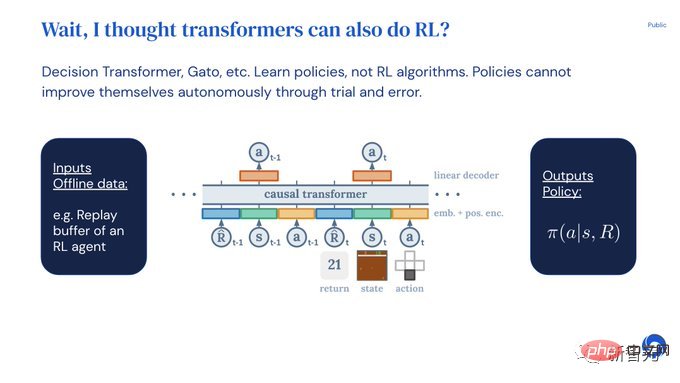

PD のアイデアは非常にシンプルで拡張が簡単ですが、PD には大きな欠陥があります。生成された戦略は、環境との追加の相互作用によって改善されません。

たとえば、MultiGame Decision Transformer (MGDT) は、多数の Atari ゲームをプレイできるリターン条件付きポリシーを学習し、Gato は Strategies で条件付きポリシーを学習しました。さまざまな環境でタスクを解決するためのアプローチですが、どちらのアプローチも試行錯誤を通じて戦略を改善することはできません。

MGDT はモデルの重みを微調整することでトランスフォーマーを新しいタスクに適応させますが、Gato は新しいタスクに適応するために専門家のデモンストレーションのヒントを必要とします。

つまり、ポリシー蒸留メソッドは、強化学習アルゴリズムではなくポリシーを学習します。

研究者らは、Policy Distillation が試行錯誤によって改善できない理由は、学習の進捗が示されていないデータに基づいてトレーニングされているためであると仮説を立てました。

アルゴリズム蒸留 (AD) は、RL アルゴリズムの学習履歴における因果系列予測損失を最適化することによって、固有のポリシー改善演算子を学習する方法です。

AD には 2 つのコンポーネントが含まれています:

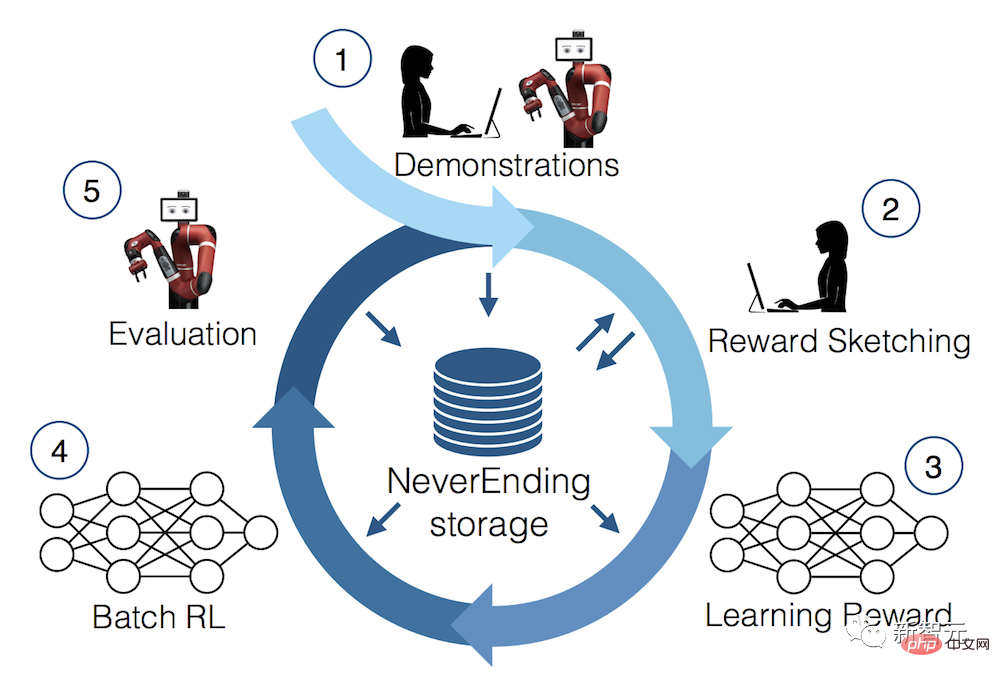

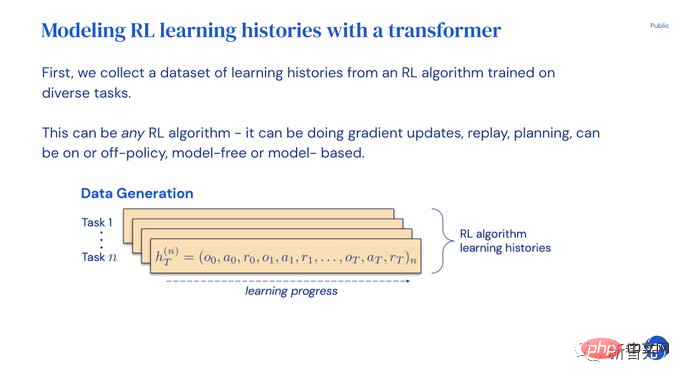

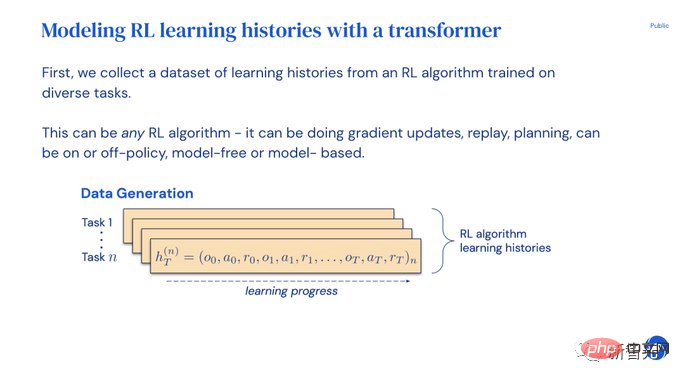

1. トレーニング履歴を保存する多くの個別のタスクに対する RL アルゴリズムの解析により、大規模なマルチタスク データ セットが生成されます;

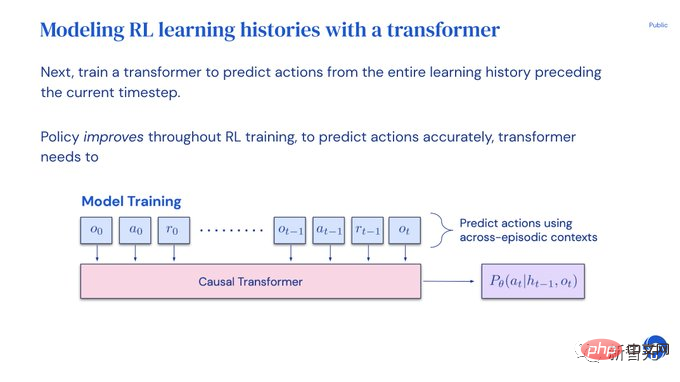

#2. Transformer は、以前の学習履歴を背景として使用して、アクションの因果関係を構築します。

ポリシーはソース RL アルゴリズムのトレーニング プロセス全体を通じて改善され続けるため、AD はトレーニングの任意の時点でアクションを正確にシミュレートするためにオペレーターを改善する方法を学習する必要があります。歴史。

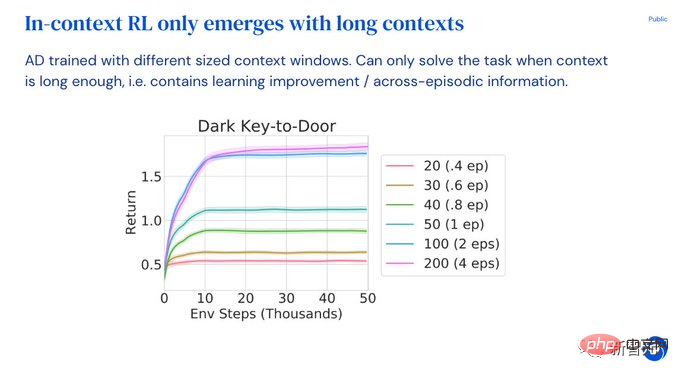

最も重要なのは、Transformer のコンテキスト サイズが、トレーニング データの改善を捉えるのに十分な大きさ (つまり、エポック全体) である必要があることです。

実験部分では、インコンテキスト RL 機能における AD の利点を調査するために、研究者はゼロを渡すことができないことに焦点を当てました。事前トレーニング後、ショットは、各環境が複数のタスクをサポートする必要があり、モデルが観察からタスクの解決策を簡単に推測できない環境を解決するために一般化します。同時に、エピソード間で因果関係のあるトランスフォーマーをトレーニングできるように、エピソードは十分に短くする必要があります。

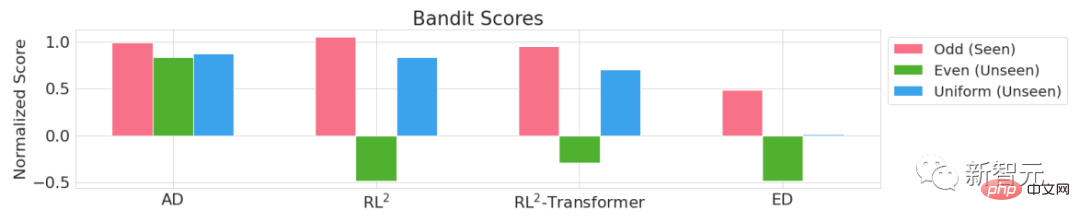

Adversarial Bandit、Dark Room、Dark Key-to-Door、DMLab Watermaze の 4 つの環境の実験結果からわかるように、十分な大きさのコンテキストを備えた因果的トランスフォーマーを使用した模倣勾配ベースの RL アルゴリズムを通じて、AD はコンテキスト内での新しいタスクの学習を完全に強化できます。

AD は、コンテキスト内の探索、一時的なクレジットの割り当て、一般化を実行できます。AD 学習のアルゴリズムは、Transformer トレーニングのソースよりも優れています。データアルゴリズムによりデータ効率が向上します。

PPT 説明論文の理解を容易にするために、論文著者の 1 人である Michael Laskin が Twitter で PPT 説明を公開しました。

# アルゴリズム蒸留の実験では、Transformer が重みの更新、プロンプト、微調整を行わずに、試行錯誤を通じてモデルを独自に改善できることがわかりました。単一の Transformer は独自のデータを収集し、新しいタスクの報酬を最大化できます。

Transformer がコンテキスト内でどのように学習するかを示す成功したモデルは数多くありますが、Transformer がコンテキスト内での学習を強化することはまだ証明されていません。

新しいタスクに適応するには、開発者はプロンプトを手動で指定するか、モデルを調整する必要があります。

Transformer が強化学習に適応し、そのまま使用できるようになれば素晴らしいと思いませんか?

しかし、Decision Transformers や Gato はオフライン データからしか戦略を学習できず、実験を繰り返すことで自動的に改善することはできません。

アルゴリズム蒸留 (AD) の事前トレーニング方法を使用して生成されたトランスフォーマーは、コンテキスト内で強化学習を実行できます。

まず、強化学習アルゴリズムの複数のコピーをトレーニングして、さまざまなタスクを解決し、学習履歴を保存します。

#学習履歴データセットが収集されると、以前の学習履歴アクションを予測するように Transformer をトレーニングできます。

ポリシーは歴史的に改善されてきたため、アクションを正確に予測することで、Transformer はポリシーの改善をモデル化する必要があります。

プロセス全体はとてもシンプルです。Transformer はアクションを模倣することによってのみトレーニングされます。一般的な強化学習モデルのような Q 値はありません。操作-アクション-報酬シーケンスには、DT のような戻り条件もありません。

コンテキストでは、強化学習には追加のオーバーヘッドはなく、AD が新しいタスクの報酬を最大化できるかどうかを観察することによってモデルが評価されます。

Transformer がコンテキスト内で利益を探索、活用し、最大化している間、その重みは凍結されます。

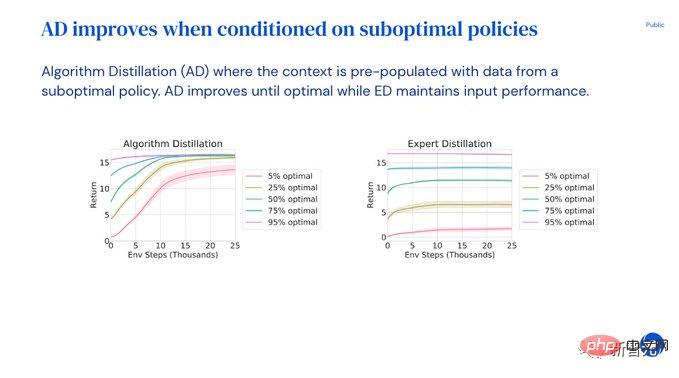

一方、Expert Distillation (Gato に最も似ています) では、収益を探索したり最大化したりすることはできません。

AD は任意の RL アルゴリズムを抽出できます。研究者は UCB と DQNA2C を試しました。興味深い発見は、コンテキストに応じた RL アルゴリズム学習では、AD の方がデータ効率が高いということです。 。

ユーザーはプロンプトや次善のデモを入力することもでき、モデルは最適な解決策が得られるまで自動的に戦略を改善します。

ただし、エキスパート蒸留 ED は次善のデモ パフォーマンスしか維持できません。

コンテキスト RL は、トランスフォーマーのコンテキストが十分に長く、複数のエピソードにまたがる場合にのみ表示されます。

AD には、効果的なモデルの改善と識別タスクを実行するのに十分な長い履歴が必要です。

実験を通じて、研究者たちは次の結論に達しました:

- 変圧器は次のとおりです。コンテキストで使用

- AD を使用したコンテキスト RL アルゴリズムは、勾配ベースのソース RL アルゴリズムより効率的です

- AD で RL を実行すると、準最適なポリシー

- インコンテキスト強化学習はロングコンテキスト模倣学習から生じる

以上が強化学習のもう一つの革命! DeepMind が提案する「アルゴリズム蒸留」: 探索可能な事前トレーニング済み強化学習 Transformerの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。