ホームページ >テクノロジー周辺機器 >AI >Yann LeCun が Google Research について語る: ターゲットを絞ったコミュニケーションは長い間存在してきましたが、あなたのイノベーションはどこにありますか?

Yann LeCun が Google Research について語る: ターゲットを絞ったコミュニケーションは長い間存在してきましたが、あなたのイノベーションはどこにありますか?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 18:52:131467ブラウズ

最近、学術チューリング賞受賞者のヤン・ルカン氏がGoogleの調査に疑問を呈した。

少し前に、Google AI は、新しい研究「LocoProp: ローカル損失最適化による BackProp の強化」フレームワーク LocoProp で、多層ニューラル ネットワークの一般的な階層損失構造を提案しました。これにより、1 次オプティマイザーのみを使用しながら、2 次メソッドに近いパフォーマンスが実現されます。

より具体的には、このフレームワークはニューラル ネットワークを複数のレイヤーのモジュール構成として再考し、各レイヤーが独自の重み正則化機能、ターゲット出力、損失関数を使用し、最終的にパフォーマンスと効率を同時に達成します。

Google は、ベンチマーク モデルとデータセットに対するアプローチの有効性を実験的に検証し、1 次オプティマイザーと 2 次オプティマイザーの間のギャップを狭めました。さらに、Googleの研究者らは、ローカル損失構築法がローカル損失として二乗損失を使用するのは初めてであると述べています。

出典: @Google AI

Google によるこの研究について、素晴らしい、興味深いというコメントをしている人もいます。しかし、チューリング賞受賞者のヤン・ルカン氏を含め、異なる見解を表明する人もいた。

彼は、現在ターゲット プロップと呼ばれるものには多くのバージョンがあり、その一部は 1986 年に遡ると考えています。では、Google の LocoProp とそれらの違いは何でしょうか?

写真出典: @Yann LeCun

UIUC の助教授に就任予定の Haohan Wang 氏も、LeCun 氏の質問に同意します。彼は、一部の著者がなぜこのような単純なアイデアがこの種の最初のものであると考えたのか、時々驚くべきだと述べた。おそらく彼らは何か違うことをしたのでしょうが、宣伝チームは出てきてすべてを主張するのを待ちきれませんでした...

写真出典: @HaohanWang

ただし、一部の人々は、ルカンが競争上の考慮から疑問を提起したり、さらには「戦争を始めたりする」と考えて、ルカンに対して「冷たくありません」。 LeCun氏は、彼の質問は競争とは何の関係もないと主張し、マルク・アウレリオ・ランザート氏、カロル・グレゴール氏、コライ・カヴククオグル氏など、ターゲット伝播のいくつかのバージョンを使用した研究室の元メンバーの例を挙げて答えた。そして今では全員が Google DeepMind で働いています。

写真出典: @Gabriel Jimenez@Yann LeCun

ヤン・ルカンをからかう人もいて、「ユルゲン・シュミットフーバーに勝てないなら、彼になれ。 》

ヤン・ルカンは正しいですか?まず、この Google の調査の内容を見てみましょう。目立ったイノベーションはありますか?

Google LocoProp: 局所損失最適化によるバックプロパゲーションの強化

この研究は、Google の 3 人の研究者、Ehsan Amid、Rohan Anil、Manfred K. Warmuth によって完了しました。

論文アドレス: https://proceedings.mlr.press/v151/amid22a/amid22a.pdf

この記事では、ディープ ニューラル ネットワーク (DNN) ) 成功には、モデル設計とトレーニング データという 2 つの重要な要素がありますが、モデル パラメーターを更新するための最適化方法について議論している研究者はほとんどいません。 DNN のトレーニングには、真の値とモデルの予測値の差を予測するために使用される損失関数の最小化と、バックプロパゲーションを使用したパラメーターの更新が含まれます。

最も単純な重み更新方法は確率的勾配降下法です。つまり、各ステップで重みが勾配に対して負の方向に移動します。さらに、モーメンタム オプティマイザー、AdaGrad などの高度な最適化手法もあります。これらのオプティマイザーは、通常、更新方向を変更するために一次導関数からの情報のみを使用するため、一次メソッドと呼ばれることがよくあります。

また、シャンプー、K-FAC などのより高度な最適化手法もあり、収束を向上させ、反復回数を削減することが証明されており、これらの手法は勾配の変化を捉えることができます。この追加情報を使用すると、高次のオプティマイザーは、異なるパラメーター グループ間の相関関係を考慮して、トレーニングされたモデルのより効率的な更新方向を発見できます。欠点は、高次の更新方向の計算が一次更新よりも計算コストがかかることです。

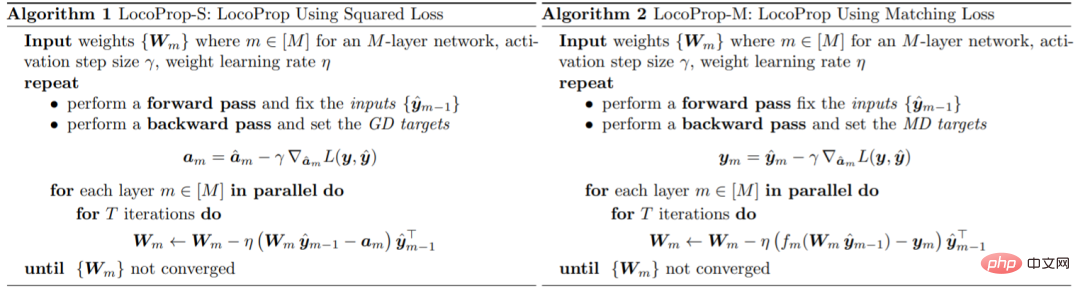

Google は論文の中で、DNN モデルをトレーニングするためのフレームワークである LocoProp を紹介しました。LocoProp は、ニューラル ネットワークをレイヤーのモジュール式の組み合わせとして考えています。一般に、ニューラル ネットワークの各層は入力に対して線形変換を実行し、その後に非線形活性化関数を実行します。この研究では、ネットワークの各層に独自の重み正則化装置、出力ターゲット、および損失関数が割り当てられました。各層の損失関数は、その層の活性化関数と一致するように設計されています。この形式を使用すると、レイヤー間で並行して反復して、ローカル損失の特定の小さなバッチのトレーニングを最小限に抑えることができます。

Google は、パラメータの更新にこの 1 次オプティマイザーを使用することで、高次オプティマイザーに必要な計算コストを回避します。

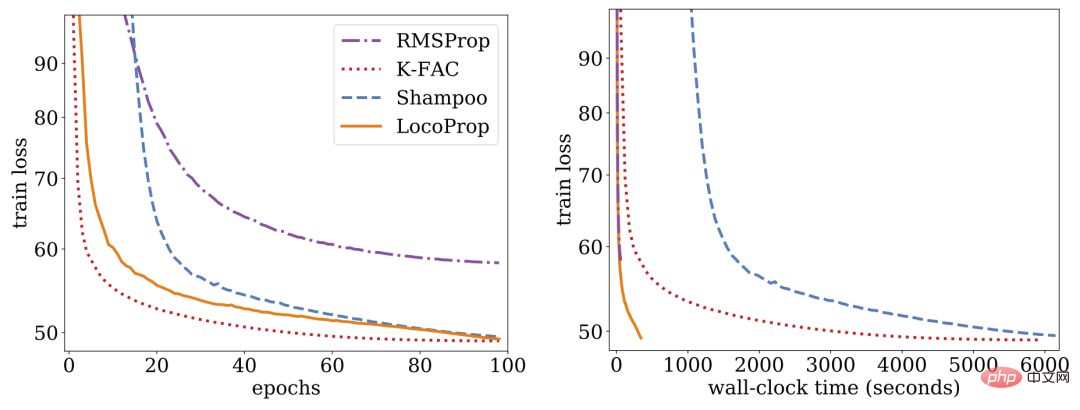

調査によると、LocoProp はディープ オートエンコーダー ベンチマークで一次メソッドを上回り、高いメモリや計算要件を必要とせずに、シャンプーや K-FAC などの高次オプティマイザーと同等のパフォーマンスを発揮します。

LocoProp: 局所損失最適化によるバックプロパゲーションの強化

通常、ニューラル ネットワークは、各層の入力を出力表現に変換する複合関数として見なされます。 LocoProp は、ネットワークをレイヤーに分解するときにこの観点を採用しています。特に、LocoProp は、出力の損失関数を最小化するためにレイヤーの重みを更新する代わりに、各レイヤーに固有の事前定義されたローカル損失関数を適用します。特定の層に対して、活性化関数と一致するように損失関数が選択されます。たとえば、tanh 活性化のある層には Tanh 損失が選択されます。さらに、正則化項により、更新された重みが現在の値から大きく逸脱しないことが保証されます。

バックプロパゲーションと同様に、LocoProp はアクティベーションを計算するためにフォワード パスを適用します。バックワード パスでは、LocoProp は各層のニューロンのターゲットを設定します。最後に、LocoProp はモデル トレーニングをレイヤー全体の独立した問題に分解し、複数のローカル更新を各レイヤーの重みに並行して適用できます。

Google は、最適化アルゴリズムのパフォーマンスを評価するための一般的なベンチマークであるディープ オートエンコーダー モデルの実験を実施しました。彼らは、SGD、モーメンタム付き SGD、AdaGrad、RMSProp、Adam、および Shampoo、K-FAC などの高次オプティマイザーを含む複数の一般的に使用される 1 次オプティマイザーで広範な最適化を実行し、その結果を LocoProp と比較しました。結果は、LocoProp メソッドのパフォーマンスが 1 次オプティマイザーよりも大幅に優れており、高次オプティマイザーと同等であると同時に、単一 GPU で実行すると大幅に高速であることを示しています。

以上がYann LeCun が Google Research について語る: ターゲットを絞ったコミュニケーションは長い間存在してきましたが、あなたのイノベーションはどこにありますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。