ホームページ >テクノロジー周辺機器 >AI >大規模モデルのトレーニングと推論をこれまで以上に高速化します。 Google の 2022 年末総括、第 4 回

大規模モデルのトレーニングと推論をこれまで以上に高速化します。 Google の 2022 年末総括、第 4 回

- 王林転載

- 2023-04-12 18:04:031525ブラウズ

Google の Bard は覆されましたが、Google の AI の強さは依然として過小評価できません。

今年の初めから、Jeff Dean が率いる Google Research 年末総括シリーズ 「Google Research, 2022 & before」 が継続的に更新されています。最近も更新されました。問題 4。

今回のテーマは 「モデルの効率化」 Google のエンジニアがどんなアイデアを出してきたのかを見ていきましょう!

運用効率が鍵

過去 10 年間、主に新しいアルゴリズムとアーキテクチャの統合により、ディープ ラーニングは爆発的な発展を遂げ、データ量が大幅に増加しましたそしてコンピューティング能力の向上。

10 年前と比較して、人工知能と機械学習のモデルはより大規模かつ複雑になり、より深く複雑なネットワーク構造、より多くのパラメータ、およびトレーニングで使用されるパラメータが増加しました。データを組み合わせることで、機械学習の歴史の中で最も革新的な結果が生まれました。

これらのモデルが運用アプリケーションやビジネス アプリケーションに導入されることが増えるにつれ、モデルの推論効率とランニング コストは小さな要因から大きな制限要因になりました。

#この点に関する Google の対応は、主に次の 4 つの問題を解決するために、機械学習の効率化に多額の投資を継続することです。

1. 効率的なアーキテクチャ

2. データ効率

3. トレーニング効率

4. 推論の効率

モデルは、効率に加えて、信頼性、セキュリティに関する多くの問題にも直面しています。 、プライバシーと新鮮さ。

この記事では、上記の課題に対処するために Google Research によって開発された一連の新しいアルゴリズムに焦点を当てます。

効率的なモデル アーキテクチャ

最も基本的な質問の 1 つは、「効率を向上させるためにモデルをパラメータ化するより良い方法はあるのか?」というものです。

2022 年、Google Research は、コンテキストを取得し、専門家を融合してトランスフォーマー (ほとんどの大規模な機械学習モデルの中核) をより効率的にし、外部の知識を注入することでモデルを強化する新しいテクノロジーに焦点を当てます。 。

コンテキスト拡張モデル

より高い品質と効率を追求するために、ニューラル モデルを外部から強化することができます大規模なデータベースやトレーニング可能なメモリ内のコンテキスト。

取得したコンテキストを活用することで、ニューラル ネットワークは内部パラメーターに大量の世界の知識を記憶する必要がなくなり、より優れたパラメーターの効率、解釈可能性、現実性を実現できます。

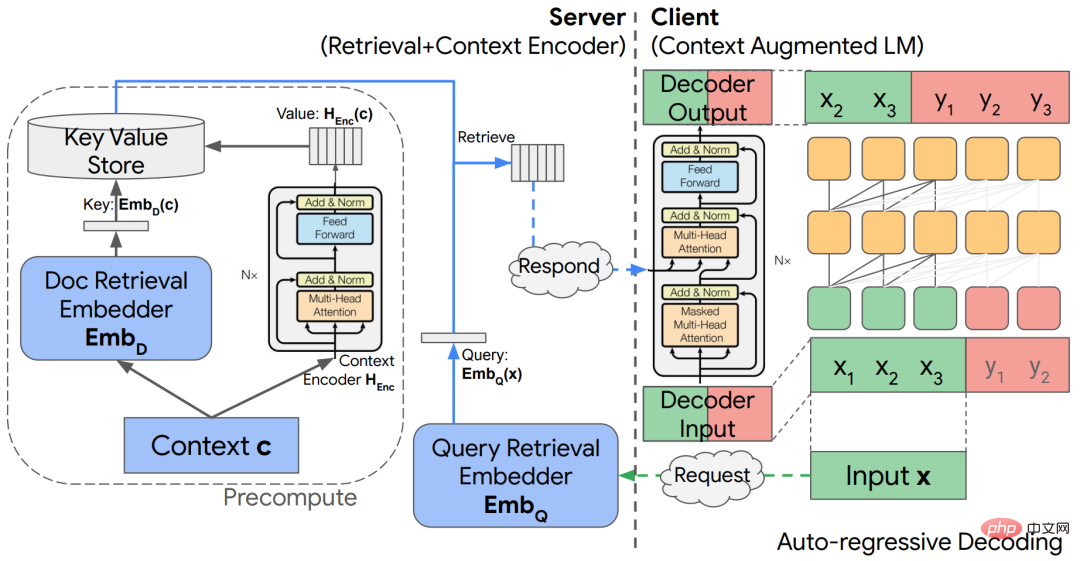

記事「コンテキスト強化言語モデリングのための分離されたコンテキスト処理」では、研究者は、外部コンテキストを言語モデルに組み込む分離されたコーデック アーキテクチャを調査しています。

論文リンク: https://arxiv.org/abs/2210.05758

#このモデルは、自己回帰言語モデリングやオープンドメインの質問応答タスクで優れた結果をもたらしながら、計算量を大幅に節約できます。事前トレーニングされた大規模言語モデル (LLM) は、大規模なトレーニング セットの自己監視を通じて多くの情報を消費しますが、これらのモデルの「世界の知識」がどのように関連しているかは不明です入力コンテキストが相互作用します。

モジュール式ディープ ネットワークを探索する際の問題の 1 つは、対応するコンピューティング モジュールを備えた概念データベースをどのように設計するかです。研究者らは、「イベントを記憶する」をスケッチの形式で配置する理論的アーキテクチャを提案しました。外部 LSH に保存されます。このテーブルには、スケッチを処理するためのポインター モジュールが含まれています。

コンテキスト拡張モデルのパズルのもう 1 つのピースは、大規模なデータベースから情報を迅速に取得するためのアクセラレータです。

研究者らは、TPU のパフォーマンス モデルと一致し、予想される再現率を分析的に保証し、最適なパフォーマンスをもたらす TPU ベースの最近傍検索アルゴリズムを開発しました。

検索アルゴリズムには通常、多数のハイパーパラメータと設計の選択肢が含まれるため、新しいタスクでの最適化が困難になります。そこで研究者らはさらに、ハイパーパラメータを自動的に調整するための新しい制約付き最適化アルゴリズムを提案しました。必要なコストまたはリコールを入力として受け取るこのアルゴリズムは、経験的に速度とリコールのパレートフロンティアに非常に近いチューニングを生成し、標準ベンチマークで優れたパフォーマンスを提供します。

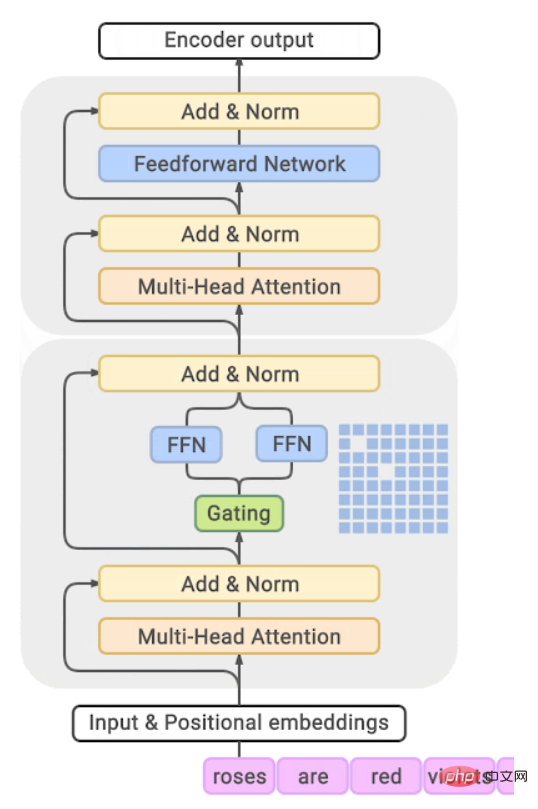

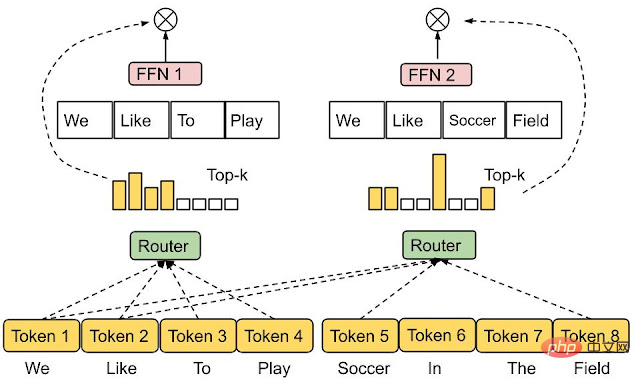

専門家混合モデル

専門家混合 (MoE、専門家混合)計算コストを過度に増加させることなく、ニューラル ネットワーク モデルの容量を増やす効率的な手段です。 MoE の基本的な考え方は、複数のエキスパート サブネットワークからネットワークを構築し、各入力が適切なエキスパート サブネットワークによって処理されることです。

結果として、MoE は標準のニューラル ネットワークと比較してモデル全体のごく一部のみを呼び出すため、GLaM などの言語モデル アプリケーションの効率が向上します。

どの専門家が特定の入力に参加するためにアクティブになるべきかの決定は、ルーティング関数の設計に依存します)。開発者の期待は、各エキスパート モデルが適切であり、過小利用されたり過剰に利用されたりしないことであるため、ルーティングは非常に困難です。

研究者らは最近の研究で、各入力を割り当てない新しいルーティング メカニズムである Expert Choice Routing を提案しました。トークンを上位 k のエキスパートに割り当てますが、各エキスパートを上位 k のトークンに割り当てることで、複数のエキスパートが自然に処理できるようにしながら、エキスパートの負荷分散を自動的に調整できます。トークンを入力してください

#論文リンク: https://openreview.net/pdf?id=jdJo1HIVinI

##効率的なトランスフォーマー

##トランスフォーマーは、視覚から自然言語理解に至るまで、現在最も人気のあるシーケンス間モデルであり、さまざまな困難な課題において非常に強力なパフォーマンスを実証しています。タスク。このタイプのモデルのコア コンポーネントはアテンション レイヤーで、「クエリ」と「キー」の類似性を計算し、値に重み付けされた適切な組み合わせを構築します。パフォーマンスは強力ですが、アテンション メカニズムの計算効率は高くなく、複雑さは通常、入力シーケンスの長さの 2 乗になります。

Transformer の規模が拡大し続けるにつれて、重要な問題の 1 つに関する研究は非常に価値があります。それは、問題を解決できる自然発生的な構造や学習モデルのパターンがあるかどうかです。効果的な注意の原則。

これに関して、Google Research は中間 MLP 層の学習エンベディングを調査し、それらが非常にまばらであることを発見しました。たとえば、T5 ラージ モデルには、非項目はゼロで、その疎性はさらに高くなります。モデルのパフォーマンスに影響を与えることなく FLOP を削減できることを示しています

#紙のリンク: https://arxiv.org/pdf/2210.06313.pdf 研究者らは最近、デシジョン ツリーに依存する標準的なアテンション計算の代替となる Treeformer モデルを提案しました。これは、クエリに関連するキーの小さなサブセットを直感的に迅速に識別でき、このモデルでのみセットに対してアテンション演算を実行します。 。経験に基づいて、Treeformer はアテンション層の FLOP を 30 分の 1 に削減できます。 同時に、研究者らは、attention アルゴリズムと貪欲アルゴリズムを組み合わせた微分可能な特徴選択手法である sequence Attendance も導入し、このテクノロジーは直接的かつコスト効率が高いことが証明されています。大規模モデルへの移行。 Transformer の効率を向上させるもう 1 つの方法は、注目層のソフトマックスの計算を高速化することです。 ソフトマックス カーネルの低ランク近似の研究に基づいて、研究者らは新しいタイプのランダム特徴を提案し、ソフトマックス カーネルの最初の「正で有界な」ランダム特徴を提供しました。シーケンスの長さ全体にわたって、計算上はほぼ線形です。

論文リンク: https://arxiv.org/abs/2205.15317

また、因果符号化や相対位置符号化など、複数のアテンション マスクをカバーする最初のメカニズムも提案しました。トレーニング効率

効果的な最適化手法は最新の機械学習アプリケーションの基礎であり、大規模環境では特に重要です。この場合、Adam のような一次適応手法でも多くの場合、大量の計算が必要となり、学習の安定性が非常に難しくなります。

さらに、これらの方法はニューラル ネットワークのアーキテクチャと無関係であることが多く、モデル アーキテクチャ内の構造情報が考慮されていないため、トレーニング効率が低くなります。これは新しいテクノロジーの促進にもつながります。最新のニューラル ネットワーク モデルをより効果的に最適化します。

Google Research は、モデル アーキテクチャに基づいて、たとえば、新しいスケール不変の Transofmre ネットワークと新しいクリッピング手法を含む、Transofmre ネットワークのトレーニング用の新しいトレーニング手法をいくつか開発しました。バニラの確率的勾配降下法 (SGD) を使用すると、トレーニングを高速化できます。

紙のリンク: https://arxiv.org/pdf/2202.00980.pdf

このアプローチを使用して、研究者らは、適応性を必要とせずに、単純な SGD のみを使用して BERT を効果的にトレーニングできる機能を初めて達成しました。さらに、研究者らは、1 次オプティマイザーと同じコンピューティングおよびメモリ リソースを使用しながら、2 次オプティマイザーと同様の結果を得る新しい手法 LocoProp を提案しました。 。

LocoProp は、ニューラル ネットワークをレイヤーの組み合わせに分解することで、ニューラル ネットワークのモジュール ビューを取得します。各層は、出力ターゲットと重み調整器だけでなく、独自の損失関数を持つことができます。この設定では、適切な順方向および逆方向の勾配パスの後、LocoProp は各層の「ローカル損失」に対する並列更新を実行し続けます。

紙のリンク: https://proceedings.mlr.press/v151/amid22a.html

実際、これらの更新は理論的にも経験的にも高次のオプティマイザーと同様であり、LocoProp はディープ オートエンコーダー ベンチマークで高次のオプティマイザーと同じ結果を達成しました。大幅に高速化されています。SGD のようなオプティマイザの重要な前提は、各データ ポイントが分布から独立して同一にサンプリングされるということですが、強化学習などの現実世界のアプリケーション環境では、この前提を実現することが困難です。モデル (またはエージェント) は、自身の予測に基づいて生成されたデータから学習する必要があるため、満足します。

研究者らは、線形力学システムおよび非線形力学システムで使用できる、リバース エクスペリエンス リプレイを備えた SGD と呼ばれる新しいアルゴリズム手法を提案しました。Q- などのいくつかの状況で最適なソリューションを見つけます。学習と強化学習。

論文リンク: https://arxiv.org/abs/2103.05896 ## さらに、この手法の改良版である IER は、さまざまな一般的な RL ベンチマークにおいて、最先端で最も安定したエクスペリエンス リプレイ手法であることが実験的に証明されています。

データ効率

ディープ ニューラル ネットワークは大規模なデータ セットに大きく依存しており、ストレージ コストとこれらのデータの潜在的なセキュリティ/プライバシーの問題が伴います。このセットには高い計算コストも伴います。

この問題を解決する有望な方法は、データ サブセットの選択です。学習者の目標は、多数のトレーニング サンプルから、最も有益なサブセットに近いものを見つけることです (改善)トレーニングセット全体のトレーニング。

研究者らは、学習者がコンテキストと実際のラベルにアクセスしながら、一度に 1 つのサンプルをサンプリングできる実用的なバッチ設定で任意のモデル ファミリを操作するように設計されたサブセット選択フレームワークを分析しました。オーバーヘッドを制限するために、十分な大きさのサンプルのバッチが選択されると、その状態は更新されるだけになります。つまり、モデルの重みがさらにトレーニングされます。

そして、これに基づいて、重要度サンプリングを通じてサンプルを選択する IWeS と呼ばれるアルゴリズムが開発されました。各サンプルに割り当てられるサンプリング確率は、以前に選択されたバッチのエントロピーに基づきます。 -訓練されたモデル。この論文では、一般化とサンプリング レートの限界を示す理論的分析を提供します。

大規模ネットワークのトレーニングに関するもう 1 つの問題は、特に限られた数のネットワークを扱う場合、展開時に表示されるトレーニング データやデータ間の分布の変化に非常に敏感になる可能性があることです。トレーニング データの場合、これらのデータには展開時のすべてのシナリオが含まれていない可能性があります。

最近の研究では、ニューラル ネットワークの脆弱性の背後にある重要な問題は「極端な単純性バイアス」であるという仮説が立てられ、その最新の研究によりこの仮説が実現可能となり、2 つの新しい補完的な手法 DAFT とFRR を組み合わせると、大幅に強力なニューラル ネットワークが提供されます。特に、これら 2 つの方法では、敵対的な微調整と逆特徴予測を使用して、学習ネットワークの堅牢性を向上させます。

推論効率

ニューラル ネットワークのサイズを大きくすると、予測精度の向上に驚くべき効果があることが示されていますが、これらを活用するのは困難です。大規模なモデルの推論コストは法外に高額になる可能性があるため、現実の世界では利点を実現するのは困難ですが、この問題は精度を犠牲にすることなくサービスの効率を向上させる戦略も推進します。

研究者たちは、この目標を達成するためにさまざまな戦略、特に知識の蒸留と適応コンピューティングに基づく戦略を提案してきました。

蒸留

蒸留は、大規模なニューラル モデルを大幅にスケールする、シンプルで効果的なモデル圧縮方法です。潜在的な応用性があります。広告の推奨などの一連の実用的なアプリケーションで非常に効果的であることが証明されています。

蒸留のほとんどの使用例では、特定のドメインに基本モデルを直接適用することが含まれますが、これをいつ行うべきか、なぜ行うべきかについては限られた理解しかありません。 Google の研究では、特定の状況に合わせて蒸留を調整することに焦点を当て、蒸留の成功を決定する要因を系統的に調査しています。

アルゴリズム的には、教師モデルによって提供されるラベル内のノイズを慎重にモデル化することにより、研究者らはトレーニング サンプルの重み付けを変更するための原則に基づいたアプローチと、堅牢なアプローチを開発しました。サンプルには教師ラベルが付いています。

「教師指導トレーニング」のプロセスで、研究者は新しい抽出フレームワークを提案しました。教師を受動的に使用して固定データセットに注釈を付けるのではなく、教師を積極的に使用して情報サンプルをガイドします。選択した内容は注釈に使用されます。これにより、限られたデータまたはロングテール設定で蒸留プロセスがより効率的になります。

#紙のリンク: https://arxiv.org/abs/2208.06825

また、クロスエンコーダ (BERT などのデュアルエンコーダ) から、(クエリ、ドキュメントのペアでもある) 階乗デュアルエンコーダ (デュアルエンコーダ) までの新しい手法も研究しました。 ) 関連性はスコアリングの重要な設定です。

論文リンク: https://proceedings.mlr.press/v162/menon22a/menon22a.pdf

この論文では、クロス エンコーダとデュアル エンコーダの間のパフォーマンスのギャップの理由を研究し、これがエンコーダの容量制限ではなく一般化の結果である可能性があることを指摘しています。デュアルエンコーダー。

#慎重に構築された蒸留損失関数により、この状況が軽減され、クロスエンコーダーとデュアルエンコーダー間のパフォーマンスのギャップを埋めることができます。その後、教師モデルからの埋め込みをマッチングすることによるデュアルエンコーダー蒸留のさらなる改善が、EmbedDistil でさらに研究されました。この戦略は、大規模から小規模のデュアル エンコーダ モデルから情報を抽出するためにも使用できます。この場合、教師ドキュメントの埋め込みの継承と凍結が非常に効果的であることが証明されています。

は、教師あり複雑性の蒸留を通じて、生徒が教師のラベルをどのように予測できるかを測定する理論的側面に関する新しい視点を提供します。

#ニューラル タンジェント カーネル (NTK) 理論を使用すると、いくつかの概念的な結論が導き出されます。たとえば、そのような教師のラベルは純粋なランダム性に似ている可能性があるため、能力のギャップが蒸留に影響を与える可能性があります。学生。

#紙のリンク: https://arxiv.org/abs/2301.12923

同時に、蒸留によって生徒の適合が不十分になる点も、教師モデルにとっては難しい問題であることがさらに証明されています。合理的にモデル化できるサンプルについて。

適応計算

蒸留は推論のコストを削減する効果的な方法ですが、その効果は次のとおりです。均一で直感的には、一部の「簡単な」サンプルは、比較的「難しい」サンプルよりも本質的に必要な計算量が少ない場合があります。

アダプティブ コンピューティングの目標は、このようなサンプル依存の計算を実行できるメカニズムを設計することです。Confident Adaptive Language Modeling (CALM) では、T5 などの Transformer ベースのテキスト ジェネレーターに制御された早期終了機能が導入されています。

#紙のリンク: https://arxiv.org/abs/2207.07061

この形式の適応計算では、モデルは各デコード ステップで使用される Transformer レイヤーの数を動的に変更し、早期終了ゲートは決定しきい値を持つ信頼性メトリックを使用します。統計的パフォーマンス保証を満たすように調整されています。 このように、モデルは最も困難な予測の場合は完全なデコーダー層スタックのみを計算する必要があり、より単純な予測の場合は少数のデコーダー層のみを計算する必要があります。実際には、モデルは予測に平均して約 3 分の 1 のレイヤーを使用するため、同じレベルの生成品質を維持しながら 2 ~ 3 倍の高速化が実現します。 一般的に使用される適応計算メカニズムは、2 つ以上の基本モデルのカスケードで構成されます。ここで重要な問題は、現在のモデルの予測を単純に使用するか、予測を下流モデルに延期して、いつ延期が必要かを学習するかを決定することです。決定を延期するための監視として適切な信号を利用できる適切な損失関数を設計します。 Google Research は、既存の損失関数を体系的に研究し、ラベル スムージングの暗黙的な適用によりサンプルのトレーニングに適していない可能性があることを実証しました。論文では、遅延ルールのポストホック トレーニングによってこれを軽減できることも示しましたこの場合、このトレーニングではモデルの内部を変更する必要はまったくありません。

# 論文リンク: https://openreview.net/pdf?id=_jg6Sf6tuF7 ##検索アプリケーションの場合、標準的なセマンティック検索手法では、大規模なモデルによって生成された各埋め込みに対して固定表現が使用されます。つまり、下流のタスクとそれに関連するコンピューティング環境または制約に関係なく、表現のサイズとアビリティは次のようになります。ほとんど修正されました。

マトリョーシカ表現の学習では、デプロイメント環境に応じて表現を調整する柔軟性が導入され、表現の座標に自然な順序が強制されるため、リソースに制約のある環境では、表現の最上位の少数の座標のみが使用されます。が使用されますが、より豊富で精度が重要な設定の場合は、より多くの座標を使用できます。

スキャニング ニューラル ネットワークなどの標準的な近似最近傍検索手法と組み合わせると、MRL は同じ再現率と精度のメトリクスに対して最大 16 倍低い計算量を提供できます。 概要

大規模な機械学習モデルは、複数の領域で革新的な結果を実証していますが、これらのモデルを現実世界で実行可能にするためには、トレーニングと推論の効率が重要な要件になりつつあります。

Google Research は、新しい基本テクノロジーの開発により、大規模な機械学習モデルの効率化に多大な投資を行ってきましたが、これには継続的な努力も必要です。今後も、機械学習モデルを作成するための中核的な課題の探索を続けていきます。より堅牢で効率的です。

以上が大規模モデルのトレーニングと推論をこれまで以上に高速化します。 Google の 2022 年末総括、第 4 回の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。