ホームページ >テクノロジー周辺機器 >AI >拡散モデルの爆発、これが Github 論文の最初のレビューと要約です

拡散モデルの爆発、これが Github 論文の最初のレビューと要約です

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 17:01:091300ブラウズ

このレビュー (普及モデル: 方法と応用の包括的調査) は、カリフォルニア大学および Google Research、北京大学 Cui Bin 研究室、CMU、UCLA、モントリオール ミラ研究所の Ming-Hsuan Yang によるものです。チームは、拡散モデルのアルゴリズムの詳細な分類、他の 5 つの主要な世代モデルとの関連性、および 7 つの主要分野への適用から始めて、既存の拡散モデルの包括的な概要と分析を初めて実施しました。最終的に提案された普及モデルの既存の限界と将来の開発の方向性について説明します。

# 記事リンク: https://arxiv.org/abs/2209.00796 論文分類の概要 github リンク: https://github.com/YangLing0818/Diffusion-Models-Papers-Survey-Taxonomy

はじめに拡散モデルはディープジェネレーションモデルの新しいSOTAです。拡散モデルは、画像生成タスクにおいてオリジナルの SOTA: GAN を上回り、コンピューター ビジョン、NLP、波形信号処理、マルチモーダル モデリング、分子グラフ モデリング、時系列モデリングなど、多くの応用分野で優れたパフォーマンスを発揮します。浄化など。さらに、拡散モデルは、ロバスト学習、表現学習、強化学習などの他の研究分野と密接に関連しています。ただし、元の拡散モデルにも欠点があります。サンプリング速度が遅く、通常、サンプルを抽出するのに数千の評価ステップが必要です。最尤推定は尤度ベースのモデルに匹敵しません。さまざまなデータ タイプに一般化されます。能力が低いです。現在、多くの研究が実用化の観点から上記の制限を解決するため、または理論的な観点からモデルの機能を分析するために多くの努力が払われています。

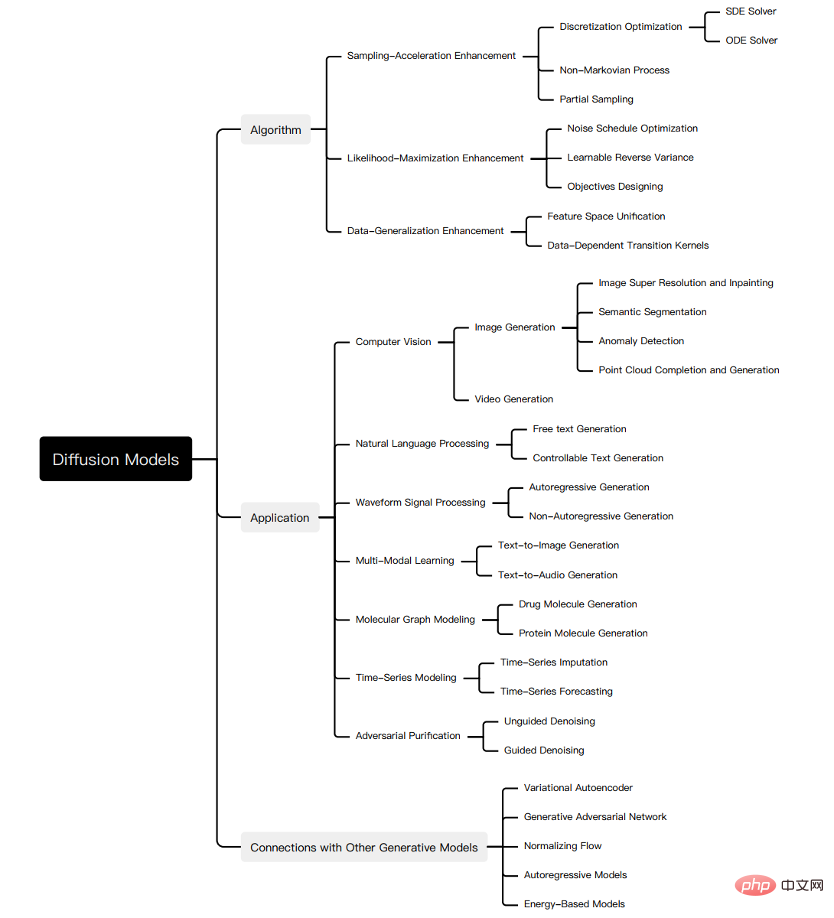

しかし、アルゴリズムからアプリケーションに至る普及モデルの最近の進歩についての体系的なレビューは現在不足しています。この急速に成長する分野の進歩を反映するために、普及モデルの最初の包括的なレビューを紹介します。私たちは、私たちの研究が拡散モデルの設計上の考慮事項と高度な手法に光を当て、さまざまな分野での応用を実証し、将来の研究の方向性を示すことを構想しています。このレビューの概要を以下の図に示します。

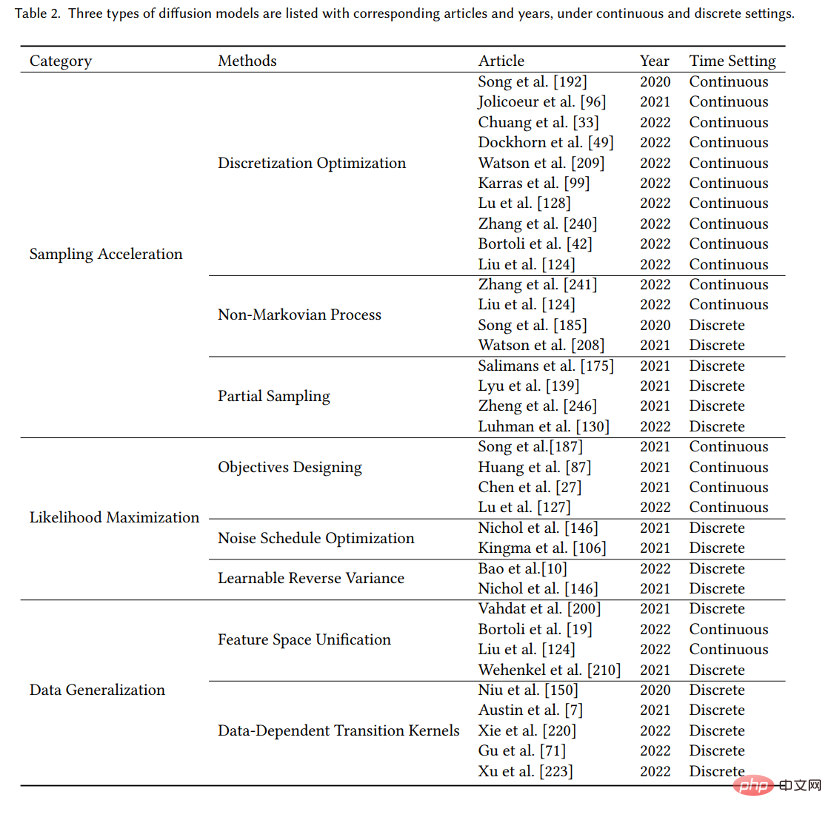

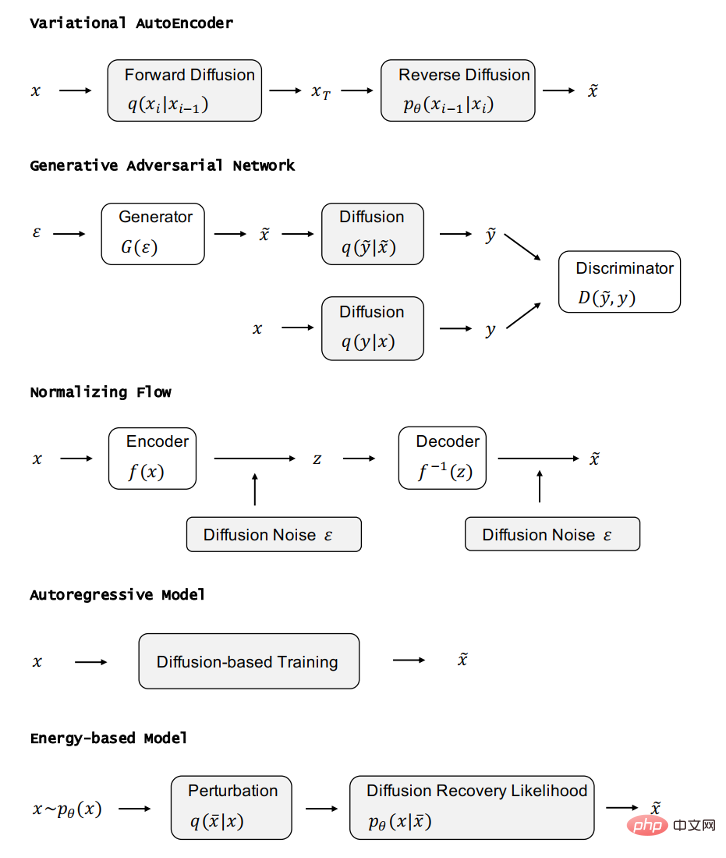

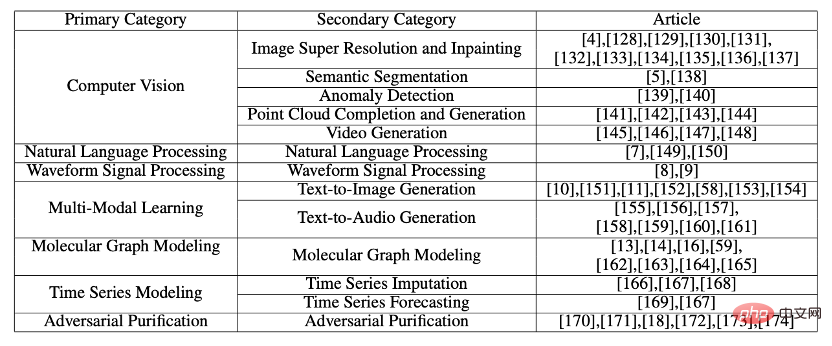

拡散モデルには優れた特徴がありますが、さまざまなタスクでのパフォーマンス どちらのモデルでも優れたパフォーマンスを発揮しますが、それでも独自の欠点があり、多くの研究で普及モデルが改善されています。普及モデルの研究進捗を体系的に明らかにするために、元の普及モデルの 3 つの主な欠点、遅いサンプリング速度、貧弱な最尤性、弱いデータ汎化能力を要約し、普及モデルの改善研究を対応する分野に分割することを提案しました。 3 つのカテゴリ: サンプリング速度の向上、最尤化の強化、およびデータ汎化の強化。まず改善動機を説明し、さらに手法の特徴に応じて改善方向ごとに研究を分類し、手法間のつながりや違いを明確に示します。ここでは、例としていくつかの重要なメソッドのみを選択します。図に示すように、各タイプのメソッドは私たちの研究で詳しく紹介されています。 3 種類の拡散モデルを分析し、他の 5 つの生成モデル、GAN、VAE、自己回帰モデル、正規化フロー、エネルギーベース モデルを紹介します。拡散モデルの優れた特性を考慮して、研究者はその特性に応じて拡散モデルを他の生成モデルと組み合わせてきました。モデルおよびその他の生成モデルは、元の生成モデルの機能と改善点を示します。拡散モデルは多くの分野で優れた性能を発揮しており、拡散モデルはさまざまな分野のアプリケーションで異なる変形を示すことを考慮して、コンピュータビジョン、NLP、波形信号処理、マルチモーダルモデリング、分子グラフモデリング、時系列モデリング、敵対的精製。

各タスクについて、タスクを定義し、拡散モデルを使用してタスクを処理する作業を紹介します。

:

- 新しい分類方法: 拡散モデルとその応用の新しい体系的な分類を提案します。具体的には、モデルをサンプリング速度の強化、最尤推定の強化、データ一般化の強化の 3 つのカテゴリに分類します。さらに、拡散モデルのアプリケーションを、コンピューター ビジョン、NLP、波形信号処理、マルチモーダル モデリング、分子グラフ モデリング、時系列モデリング、および敵対的浄化の 7 つのカテゴリに分類します。

- 包括的なレビュー: 最新の普及モデルとその応用についての最初の包括的な概要を提供します。各普及モデルの主な改良点を示し、元のモデルと必要な比較を行い、対応する論文を要約します。普及モデルの適用の種類ごとに、普及モデルが対処する主な問題を提示し、それらの問題をどのように解決するかを説明します。

- 今後の研究の方向性: 将来の研究に向けて未解決の疑問を提起し、アルゴリズムにおける拡散モデルの適用を評価します。アプリケーションの将来の開発のためにいくつかの提案が提供されます。

拡散モデルの基礎

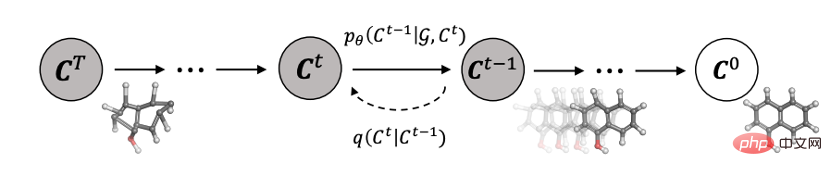

生成モデリングにおける中心的な問題は、モデルの柔軟性と計算可能性の間のトレードオフです。拡散モデルの基本的な考え方は、順拡散プロセスを通じてデータの分布を体系的に撹乱し、その後、逆拡散プロセスを学習することでデータの分布を復元することで、非常に柔軟で計算が容易なモデルを生成することです。生成モデル。

A. ノイズ除去拡散確率モデル (DDPM)

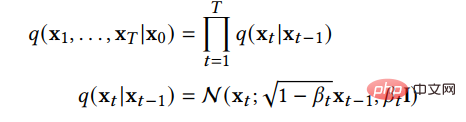

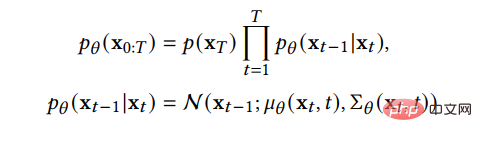

DDPM は、2 つのパラメーター化されたマルコフ連鎖構成で構成されます。変分推論を使用して、有限時間後の元のデータ分布と一致するサンプルを生成します。フォワード チェーンの機能はデータに摂動を与えることであり、データの分布が事前分布、つまり標準ガウス分布になるまで、事前に設計されたノイズ スケジュールに従ってデータにガウス ノイズを徐々に追加します。逆方向チェーンは、指定された事前確率から開始され、パラメーター化されたガウス変換カーネルを使用して、元のデータ分布を徐々に復元することを学習します。元のデータとその分布を表す  を使用すると、フォワード チェーンの分布は次の式で表すことができます。

を使用すると、フォワード チェーンの分布は次の式で表すことができます。

## これは、フォワード チェーンがマルコフ プロセスであること、x_t が t ステップのノイズを追加した後のサンプル、β_t が事前に与えられたノイズの進行を制御するパラメーターであることを示しています。  が 1 になる傾向がある場合、x_T は標準ガウス分布にほぼ従うと考えることができます。 β_t が小さい場合、逆プロセスの転送カーネルは近似的にガウスであると考えることができます。

が 1 になる傾向がある場合、x_T は標準ガウス分布にほぼ従うと考えることができます。 β_t が小さい場合、逆プロセスの転送カーネルは近似的にガウスであると考えることができます。

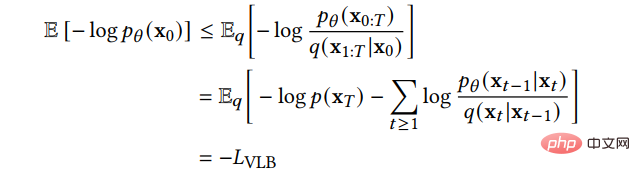

変分の下限を次のように学習できます。損失関数:

##B. スコアベースの生成モデル (SGM)

上記 DDPM は SGM の離散形式とみなすことができます。 SGM は、確率微分方程式(SDE)を構築してデータ分布を滑らかに乱し、元のデータ分布を既知の事前分布に変換します。対応する逆 SDE を使用して、以前の分布を元のデータ分布に変換します:

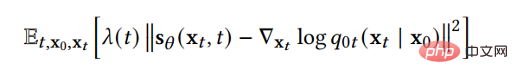

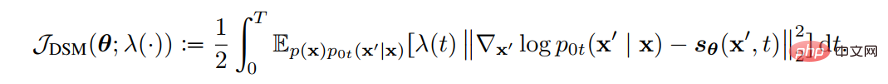

したがって、拡散プロセスを逆にしてデータを生成するために必要な情報は、各時点における分数関数だけです。スコア マッチング手法を使用すると、次の損失関数を通じてスコア関数を学習できます。

2 つの方法とそれらの関係の詳細な紹介紹介については記事をご覧ください。

元の拡散モデルの 3 つの主な欠点は、サンプリング速度が遅い、最尤度が低い、データ一般化能力が弱いことです。最近の研究の多くはこれらの欠点に対処しているため、改良された拡散モデルをサンプリング速度の強化、最尤化の強化、およびデータ一般化の強化の 3 つのカテゴリに分類します。次の 3、4、5 セクションで、これら 3 種類のモデルを詳しく紹介します。

サンプリング加速法

適用すると、新しいサンプルの最高品質を達成するために、拡散モデルは多くの場合、新しいサンプルを取得するために数千の計算ステップを必要とします。サンプル。これにより、拡散モデルの実際の応用価値が制限されます。実際の応用では、多くの場合、処理の次のステップに材料を提供するために多数の新しいサンプルを生成する必要があるからです。研究者は、拡散モデルのサンプリング速度を向上させるために多くの研究を行ってきました。これらの研究について詳しく説明します。これを、離散化最適化、非マルコフ プロセス、部分サンプリングの 3 つの方法に洗練します。

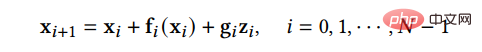

#A.離散化最適化手法拡散 SDE を解く手法を最適化します。実際には複雑な SDE を解くには実解を近似するために離散解しか使用できないため、このタイプの方法では、サンプルの品質を確保しながら離散ステップの数を削減するために SDE の離散化方法を最適化しようとします。 SGM は、逆方向プロセスを解くための一般的な方法、つまり、順方向プロセスと逆方向プロセスに同じ離散化方法を採用する方法を提案します。順方向 SDE に離散化が与えられている場合:

# 次に、同じ方法で逆 SDE を離散化できます:

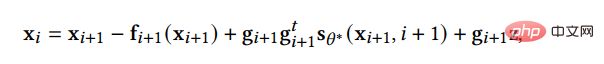

B. 非マルコフ過程 この方法は、元のマルコフ過程の限界を突破します。逆プロセス 各ステップは、より多くの過去のサンプルに基づいて新しいサンプルを予測できるため、ステップ サイズが大きい場合でもより適切な予測を行うことができ、それによってサンプリング プロセスが高速化されます。その中で、主な作業である DDIM は、フォワード プロセスがマルコフ プロセスであることを前提とせず、次の分布に従います:

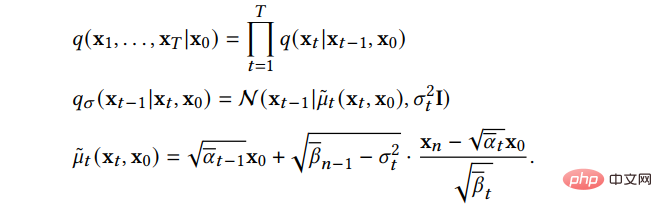

#C.Partial Sampling メソッドは、生成プロセスで時間ノードの一部を無視し、残りのノードのみを使用します。次回ノードはサンプルの生成に使用され、これによりサンプリング時間が直接短縮されます。たとえば、漸進的蒸留は、トレーニングされた拡散モデルからより効率的な拡散モデルを蒸留します。トレーニングされた拡散モデルの場合、漸進的蒸留は新しい拡散モデルの 1 ステップがトレーニングされた拡散モデルの 2 ステップに対応するように拡散モデルを再トレーニングします。これにより、新しいモデルは古いモデルのサンプリング プロセスの半分を節約できます。具体的なアルゴリズムは次のとおりです:

#この蒸留プロセスを継続的に繰り返すと、サンプリングのステップを大幅に減らすことができます。

最尤推定の強化

最尤推定における拡散モデルのパフォーマンスは、尤度関数に基づく生成モデルのパフォーマンスより劣りますが、最尤推定は推定には多くの利点があり、画像圧縮、半教師あり学習、敵対的浄化などのアプリケーション シナリオが非常に重要です。対数尤度を直接計算するのは難しいため、研究は主に変分下限 (VLB) の最適化と分析に焦点を当てています。拡散モデルの最尤推定を改善するモデルについて詳しく説明します。私たちはこれを、目標設計、ノイズ スケジュール最適化、学習可能な逆分散という 3 つのカテゴリの手法に細分化します。

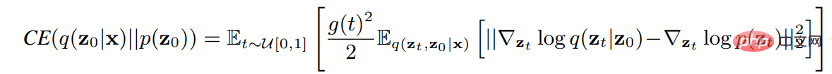

A. 目的の設計 この方法では、拡散 SDE を使用して、生成されたデータのマッチング損失関数。このように、損失関数を適切に設計することで、VLB と対数尤度を最大化できます。 Song らは、プラグイン逆 SDE によって生成されたサンプルの尤度関数値が損失関数値以下になるように、損失関数の重み関数を設計できることを証明しました。尤度関数の上限。分数関数フィッティングの損失関数は次のとおりです。

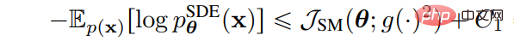

重み関数 λ(t) を拡散係数 g( t) 損失関数を尤度関数の VLB とします。つまり、

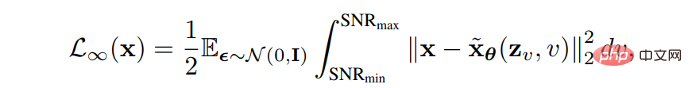

# #B. ノイズ スケジュールの最適化 フォワード プロセスのノイズの多い進行状況を設計または学習することで、VLB を増加します。 VDM は、離散ステップが無限大に近づくと、損失関数が信号対雑音比関数 SNR(t) の終点によって完全に決定されることを証明します。 # 次に、「離散ステップが無限大に近づくとき」では、信号対雑音比関数 SNR(t) のエンドポイントを学習することで VLB を最適化し、関数値を学習することでモデルの他の側面を改善できます。信号対雑音比関数の中央部分。

C.学習可能な逆分散

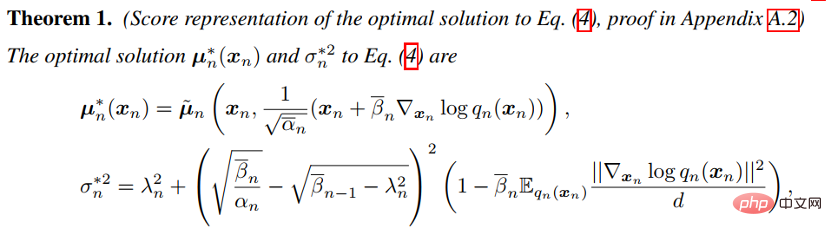

このメソッドは逆プロセスの分散を学習するため、フィッティング誤差が減少し、効果的に VLB を最大化できます。 Analytic-DPM は、DDPM と DDIM の逆プロセスに最適な期待値と分散があることを証明します。上記の式とトレーニング済みの For を使用します。分数関数を使用すると、特定のフォワード プロセスの条件下で、最適な VLB をほぼ達成できます。

データ一般化の強化

データ一般化の強化

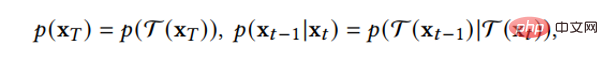

拡散モデルは、データがユークリッド空間、つまり平面幾何学を持つ多様体に存在すると仮定しており、ガウス ノイズの追加は避けられません。データを連続状態空間に変換するため、拡散モデルは最初は画像などの連続データのみを処理でき、離散データやその他のデータ型を直接適用する効果は低くなります。これにより、普及モデルの適用シナリオが制限されます。いくつかの研究成果は拡散モデルを他のデータ型に一般化しており、これらの方法を詳細に説明します。特徴空間統合とデータ依存遷移カーネルの 2 種類の手法に分類されます。

A.特徴空間の統合

メソッドは、データを潜在空間の統一形式に変換し、次に潜在空間に変換します。広がる。 LSGM は、VAE フレームワークを通じてデータを連続的な潜在空間に変換し、その上に拡散することを提案します。この方法の難しさは、VAE と拡散モデルを同時にトレーニングする方法です。 LSGM は、基礎となる事前分布が扱いにくいため、部分的なマッチング損失が適用されなくなることを示しています。 LSGM は、VAE の従来の損失関数 ELBO を損失関数として直接使用し、ELBO とスコア マッチングの関係を導き出します。 #この式は、定数が無視された場合に当てはまります。拡散プロセスにおけるサンプルの分数関数をパラメータ化することにより、LSGM は ELBO を効率的に学習して最適化できます。 B.データ依存の遷移カーネル #方法: 以下に従って拡散プロセスで遷移カーネルを設計します。データ型の特性を利用して、拡散モデルを特定のデータ型に直接適用できるようにします。 D3PM は、離散データ用の遷移カーネルを設計しました。これは、遅延ランダムウォーク、吸収状態などに設定できます。 GEODIFF は、3D 分子グラフ データ用の並進回転不変グラフ ニューラル ネットワークを設計し、不変初期分布と遷移カーネルによって不変周辺分布を導出できることを証明しました。 T が次のような平行移動 - 回転変換であるとします。 以下の各セクションでは、最初に他の 5 つの重要なタイプの生成モデルを紹介し、それらの利点と限界を分析します。次に、拡散モデルがそれらにどのように関連しているかを紹介し、拡散モデルを組み込むことでこれらの生成モデルをどのように改善できるかを説明します。 VAE、GAN、自己回帰モデル、正規化フロー、エネルギーベースのモデル、拡散モデルの関係を以下の図に示します。 #DDPM は、階層的なマルコフ VAE とみなすことができます。ただし、DDPM と一般的な VAE の間には違いもあります。 VAE として、DDPM のエンコーダとデコーダは両方ともガウス分布に従い、マルコフ行を持ちます。隠れ変数の次元はデータ次元と同じです。デコーダのすべての層はニューラル ネットワークを共有します。 DDPM は、GAN が不安定なトレーニングの問題を解決するのに役立ちます。データは高次元空間内の低次元多様体にあるため、GAN によって生成されたデータの分布は実際のデータの分布との重なりが低く、その結果、トレーニングが不安定になります。拡散モデルは体系的にノイズを追加するプロセスを提供します. 拡散モデルを通じて生成されたデータと実際のデータにノイズを追加し, ノイズが追加されたデータを識別器に送信します. これにより, GANがトレーニングできない問題を効果的に解決できます.そしてトレーニングも不安定。。 マルチモーダル タスクでは、拡散モデルを使用してテキストから画像への生成 (GLIDE) を行うことができます。 use 分子グラフ生成で薬物分子とタンパク質分子 (GeoDiff) を生成するために拡散モデルを使用します: アプリケーション分類の概要を表に示します: 今後の研究の方向性 # 仮説の再検証を適用します。アプリケーションにおいて一般的に受け入れられている仮定を検討する必要があります。たとえば、実際には、拡散モデルの前方プロセスによってデータが標準ガウス分布に変換されると一般に考えられていますが、これは当てはまりません。前方拡散ステップを増やすと、最終的なサンプル分布が標準ガウス分布に近づきます。 、サンプリング プロセスと一致します。 ; しかし、前方拡散ステップが増えると、分数関数の推定も難しくなります。理論的な条件を得るのが難しいため、実際には理論と実践の間に不一致が生じます。私たちはこの状況を認識し、適切な普及モデルを設計する必要があります。

#他の生成モデルとの関係

#他の生成モデルとの関係

正規化フローは全単射関数を使用してデータを事前分布に変換します。このアプローチでは正規化フローの表現能力が制限され、アプリケーションの結果が低下します。アナロジー拡散モデルはエンコーダにノイズを付加することで正規化フローの表現力を高めることができますが、見方を変えると拡散モデルをフォワード処理でも学習できるモデルに拡張するアプローチです。

以上が拡散モデルの爆発、これが Github 論文の最初のレビューと要約ですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。