ホームページ >テクノロジー周辺機器 >AI >わずか 3 つのサンプルと 1 つの文で、AI は写真のようにリアルな画像をカスタマイズできます。Google は非常に新しい普及モデルに取り組んでいます。

わずか 3 つのサンプルと 1 つの文で、AI は写真のようにリアルな画像をカスタマイズできます。Google は非常に新しい普及モデルに取り組んでいます。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 15:46:07909ブラウズ

最近、テキストから画像へのモデルが人気の研究方向になってきており、大規模な自然の風景であっても、新しい風景の画像であっても、単純なテキスト記述を使用して自動的に生成される場合があります。

その中でも、想像力豊かなシーンのレンダリングは、自然に見えるように新しいシーンに特定のテーマ (物体、動物など) のインスタンスを合成する必要がある難しいタスクです。シーン。

大規模なテキストから画像へのモデルの中には、自然言語で書かれたテキスト プロンプトに基づいて、高品質で多様な画像合成を実現するものもあります。これらのモデルの主な利点は、画像内でさまざまなポーズで表示される犬のさまざまなインスタンスと「犬」という単語の関連付けなど、多数の画像とテキストの説明のペアから学習された強力な意味事前確率です。

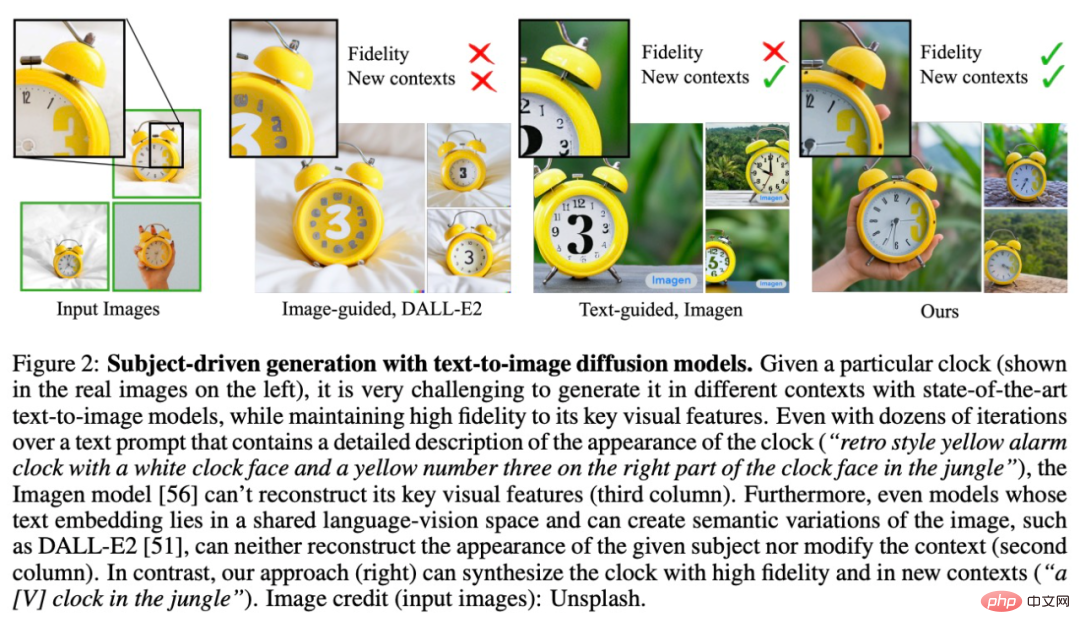

これらのモデルの合成機能は前例のないものですが、特定の参照被写体を模倣し、同じ被写体で異なるシーンの異なるインスタンスを含む新しい画像を合成する機能がありません。既存モデルの出力領域の表現能力には限界があることがわかります。

この問題を解決するために、Google とボストン大学の研究者は、「パーソナライズされた」テキストから画像への拡散モデル DreamBooth を提案しました。ユーザー固有の画像生成ニーズに適応します。

論文アドレス: https://arxiv.org/pdf/2208.12242.pdf

プロジェクトアドレス: https://github.com/XavierXiao/Dreambooth-Stable-Diffusion

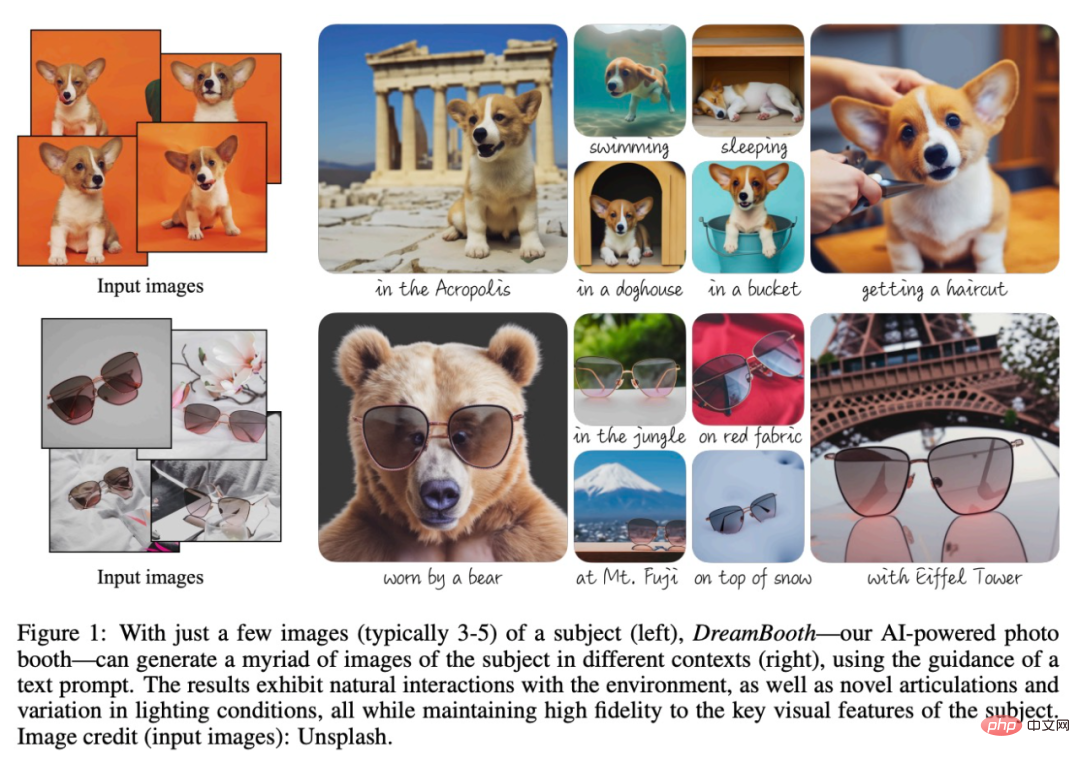

この研究の目標は、モデルの言語 - ビジュアル辞書を拡張して、新しい語彙を組み込むことができます。 ユーザーが生成したい特定のテーマにバインドします。新しい辞書がモデルに埋め込まれると、以下の図 1 に示すように、これらの単語を使用して、特定のトピックの斬新で現実的なイメージを合成しながら、さまざまなシーンでそれらを文脈化しながら、主要な識別特徴を維持できます。

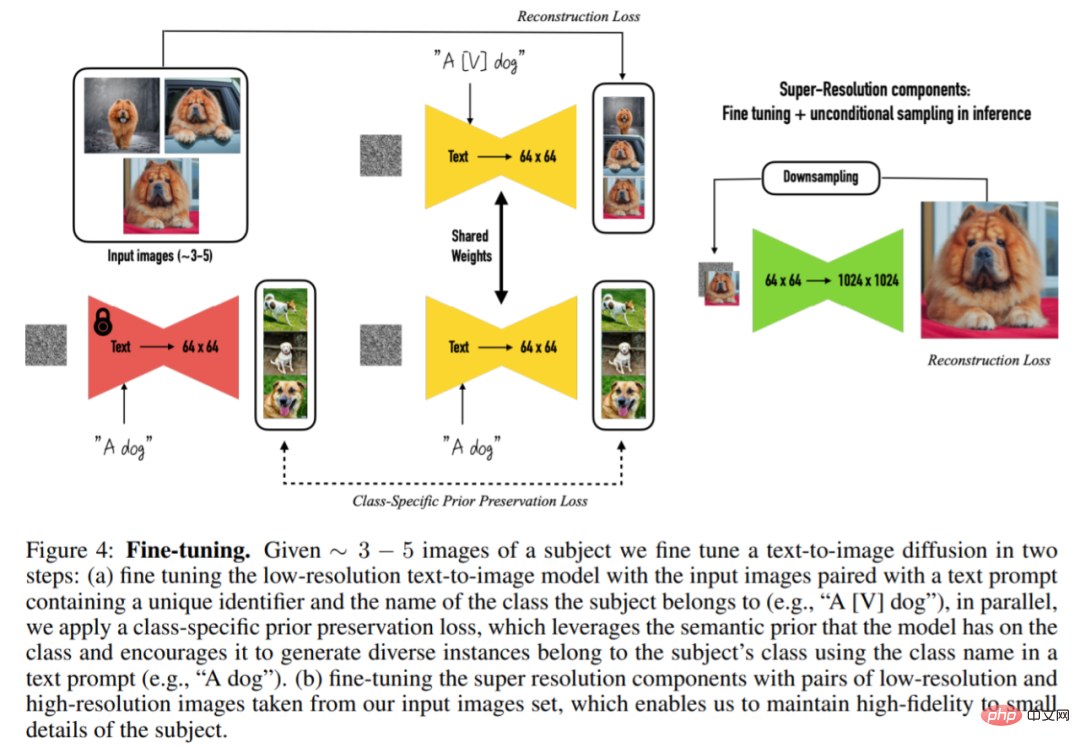

具体的には、この研究では、特定の被写体の画像をモデルの出力ドメインに埋め込み、一意の識別子を使用して画像を合成できるようにします。この目的を達成するために、この研究では、まれなトークン識別子で特定のトピックを表現する方法を提案し、テキスト画像から低解像度を生成するという 2 つのステップで動作する、事前にトレーニングされた拡散ベースのテキストから画像へのフレームワークを微調整します。 、超解像度 (SR) 拡散モデルを適用します。

この調査では、まず入力画像と一意の識別子 (「A [V] などのサブジェクト クラス名) を含むテキスト ヒントを使用して、低解像度のテキストから画像へのモデルを微調整しました」犬") 。モデルがクラス名を特定のインスタンスにオーバーフィッティングしたりセマンティック ドリフトを防ぐために、この研究では、モデルに埋め込まれたクラスの事前セマンティクスを利用して、モデルのさまざまなインスタンスを生成することを促進する、自己生成されたクラス固有の事前保存損失を提案します。特定のトピックの下で同じクラス。

2 番目のステップでは、入力画像の低解像度バージョンと高解像度バージョンを使用して超解像度コンポーネントを微調整します。これにより、モデルはシーンの主題の小さいながらも重要な詳細に対して高い忠実度を維持できます。

この研究で提案されている具体的な方法を見てみましょう。

方法の紹介

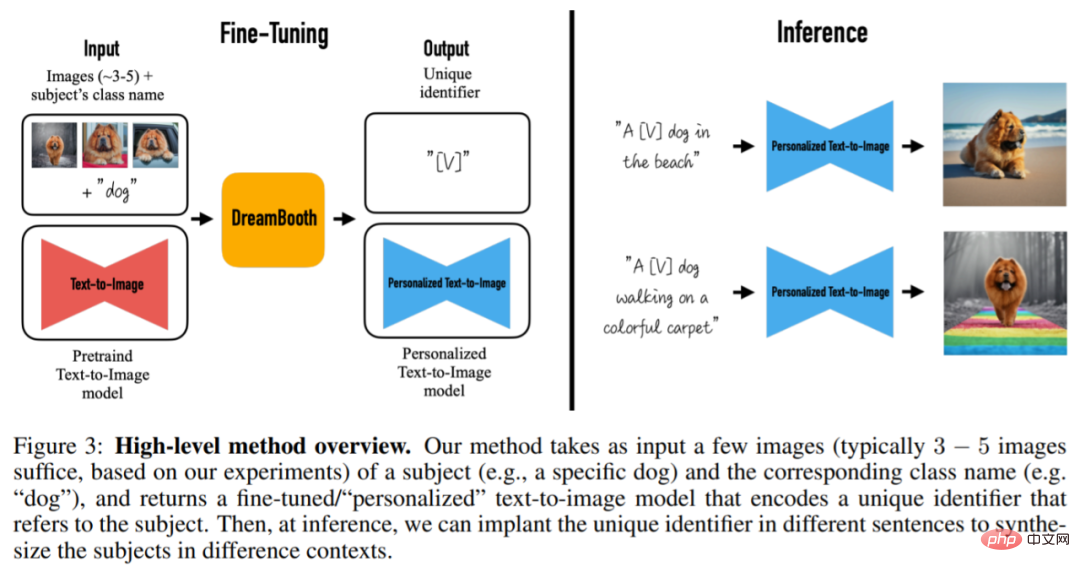

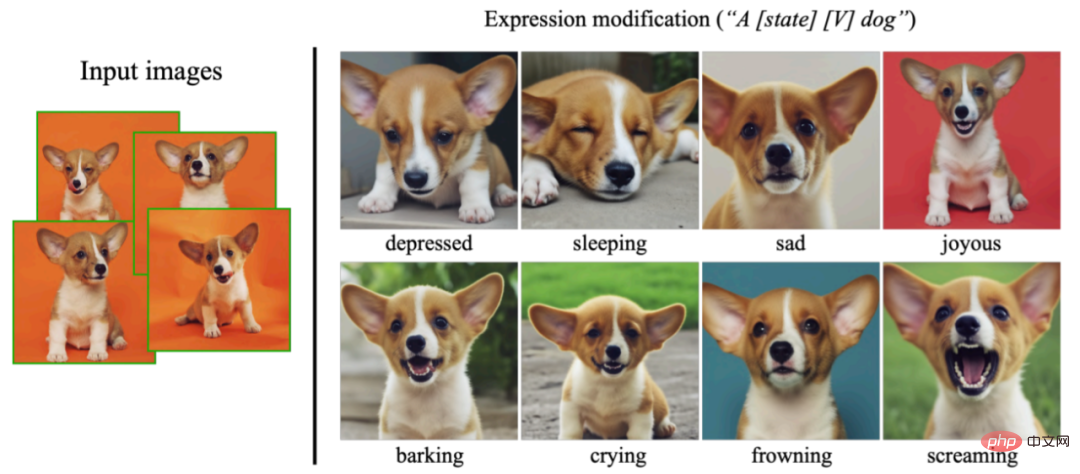

テキスト説明のない 3 ~ 5 枚のキャプチャ画像を考慮して、このペーパーでは、細部の忠実度が高く、テキストによるプロンプトを備えた画像を生成することを目的としています。変更をガイドするための新しい画像です。この研究では入力画像に制限を課しておらず、対象画像にはさまざまなコンテキストが含まれる可能性があります。その方法を図 3 に示します。出力画像は、被写体の位置などの元の画像を変更したり、色、形状などの被写体のプロパティを変更したり、被写体の姿勢、表情、素材、その他の意味上の変更を変更したりできます。

より具体的には、このメソッドは、被写体 (たとえば、特定の犬) のいくつかの画像 (通常は 3 ~ 5 枚の画像) と対応するクラス名 (たとえば、犬のカテゴリ) を入力として受け取り、次の値を返します。主題を参照する一意の識別子をエンコードする、微調整/パーソナライズされたテキストから画像へのモデル。次に、推論中に、一意の識別子をさまざまな文に埋め込んで、さまざまなコンテキストでトピックを合成できます。

調査の最初のタスクは、トピック インスタンスをモデルの出力ドメインに埋め込み、トピックを一意の識別子にバインドすることです。この研究では、モデルの微調整プロセスを監視する新しい方法の設計に加えて、識別子の設計方法を提案します。

画像の過剰適合と言語ドリフトの問題を解決するために、この研究では、拡散モデルが同じクラスを継続的に生成することを促進する損失 (Prior-Preservation Loss) も提案しています。異なるインスタンスを使用することで、モデルの過剰適合や言語のドリフトなどの問題が軽減されます。

画像の詳細を保持するには、モデルの超解像度 (SR) コンポーネントを微調整する必要があることが研究でわかりました。この記事は事前の情報に基づいて完成しています。 -トレーニングされたImagenモデル。具体的なプロセスを図 4 に示します。同じ被写体の 3 ~ 5 枚の画像を指定すると、テキストから画像への拡散モデルが次の 2 つのステップで微調整されます。

#レア トークン識別子はトピックを表します

この研究では、トピックのすべての入力画像を「[識別子] [クラス名詞]」としてマークします。ここで、[ 識別子 ] はトピックにリンクされた一意の識別子であり、[クラス名詞] はトピックの大まかなクラス記述子 (例: 猫、犬、時計など) です。この研究では、クラス事前分布をトピックに関連付けるために、文内でクラス記述子を特に使用しています。

エフェクト表示以下は、Dreambooth の安定した拡散実装です (プロジェクトのリンクを参照)。定性的結果: トレーニング画像は「Textual Inversion」ライブラリから取得されます:

トレーニングが完了すると、「写真の写真」というプロンプトが表示されます。 sks コンテナ」、モデルが生成されます。コンテナの写真は次のとおりです。

場所に「ビーチ上の sks コンテナの写真」を追加します。プロンプトが表示されると、コンテナがビーチに表示されます。

緑のコンテナは色がシンプルすぎます。赤を追加したい場合は、プロンプト「赤い sks コンテナの写真」を入力して完了します。

プロンプト「sks コンテナの上の犬」を入力してください。子犬を箱の中に座らせます:

以下は論文に示されている結果の一部です。さまざまなアーティスト スタイルで犬に関する芸術的な写真を生成します:

この研究では、入力画像に現れないさまざまな表現を合成することもでき、モデルの外挿能力を実証しています。 詳細については、原論文を参照してください。

以上がわずか 3 つのサンプルと 1 つの文で、AI は写真のようにリアルな画像をカスタマイズできます。Google は非常に新しい普及モデルに取り組んでいます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。