AI 次元削減が人間のペインターを攻撃し、ヴィンセント グラフが ControlNet に導入され、深さとエッジ情報が完全に再利用可能になります

大規模なテキスト画像モデルの出現により、魅力的な画像の生成は非常に簡単になり、ユーザーは指の動きで簡単なプロンプトを入力するだけで済みます。一連の操作を通じてイメージを取得した後、必然的にいくつかの疑問が生じます。プロンプトに基づいて生成されたイメージは要件を満たしているか?ユーザーから提起されるさまざまな要件に対処するには、どのようなアーキテクチャを構築する必要があるか?大規模なモデルでも、特定のタスクにおいて数十億の画像から得られる利点と機能を維持できるでしょうか?

これらの質問に答えるために、スタンフォードの研究者はさまざまな画像処理アプリケーションについて多数の調査を実施し、次の 3 つの発見に至りました。

まず第一に、特定のフィールドで利用可能なデータは、実際には一般的なモデルをトレーニングするためのデータよりも少ないです。これは主に、たとえば、特定の問題 (ジェスチャー理解、など) は通常 100k 未満で、大規模データセットよりも小さいです。マルチモーダル テキスト画像データセット LAION 5B は 5 × 10^4 桁小さいです。これには、ニューラル ネットワークがモデルの過剰適合を回避するために堅牢であること、および特定の問題を対象とする場合に適切な一般化ができることが必要です。

第 2 に、画像タスクのデータ駆動型処理を使用する場合、大規模なコンピューティング クラスターが常に利用できるとは限りません。ここで、高速トレーニング方法、つまり許容可能な時間とメモリ空間内で特定のタスクに合わせて大規模なモデルを最適化できる方法が重要になります。さらに、後続の処理で微調整、転移学習、その他の操作が必要になる場合があります。

最後に、画像処理プロセスで遭遇するさまざまな問題には、さまざまな定義形式があります。これらの問題を解決する際、画像拡散アルゴリズムは「手続き型」の方法で調整することができます。たとえば、ノイズ除去プロセスの制約、多頭注意の活性化の編集などですが、これらの手作りのルールは基本的に人間の指示によって指示されます。深度画像、ポーズ人物などのいくつかの特定のタスクを考慮すると、これらの問題は基本的に生の入力を解釈してオブジェクト レベルまたはシーン レベルで理解する必要があるため、手作りの手続き型アプローチは実現可能性が低くなります。したがって、複数のタスクでソリューションを提供するには、エンドツーエンドの学習が不可欠です。

上記の発見に基づいて、この論文では、追加の条件を追加することで拡散モデル (安定拡散など) を制御できるエンドツーエンドのニューラル ネットワーク アーキテクチャ ControlNet を提案します。グラフの改善や、線画からのフルカラー画像の生成、同じ奥行き構造の画像の生成、手のキーポイントによる手の生成の最適化などが可能です。

論文アドレス: https://arxiv.org/pdf/2302.05543.pdf

プロジェクトアドレス: https://github.com/lllyasviel/ControlNet

効果の表示

それでは、ControlNet の効果とは何でしょうか?

キャニーエッジ検出:元画像から線画を抽出することで、同じ構図の画像を生成できます。

#奥行き検出: 元の画像の奥行き情報を抽出することで、同じ奥行き構造を持つマップを生成できます。 。

セマンティック セグメンテーションを使用した ControlNet:

学習ベースの使用ハフ変換は Places2 から直線を検出し、BLIP を使用して字幕を生成します。

メソッドの紹介

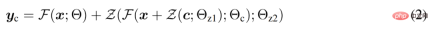

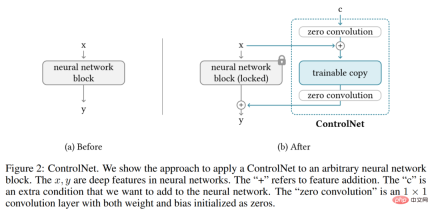

ControlNet は、タスク固有の条件で事前トレーニングされた画像拡散モデルを強化するニューラル ネットワーク アーキテクチャです。まず、ControlNet の基本構造を見てみましょう。

ControlNet は、ニューラル ネットワーク ブロックの入力条件を操作し、それによってニューラル ネットワーク全体の全体的な動作をさらに制御します。ここで「ネットワーク ブロック」とは、resnet ブロック、マルチヘッド アテンション ブロック、Transformer ブロックなど、ニューラル ネットワークを構築するための共通の単位としてまとめられるニューラル層のグループを指します。

2D 特徴を例として、特徴マップ x ϵ R^h×w×c を指定します。ここで、{h, w, c} は高さ、幅、チャネル数です。それぞれ。パラメータ Θ のセットを持つニューラル ネットワーク ブロック F (・; Θ) は、以下の式 (1) に示すように、x を別の特徴マップ y に変換します。

#このプロセスを以下の図 2-(a) に示します。

#画像拡散モデルにおける ControlNet

#研究者は、安定拡散を例として、ControlNet コントロールの使用方法を紹介しました。 - タスク固有の条件を備えたスケール拡散モデル。安定拡散は、数十億の画像でトレーニングされた大規模なテキストから画像への拡散モデルであり、本質的にはエンコーダー、中間ブロック、および残差接続デコーダーで構成される U-net です。

以下の図 3 に示すように、研究者は ControlNet を使用して U-net の各層を制御します。ここでの ControlNet の接続方法は計算効率が高いことに注意してください。元の重みがロックされているため、元のエンコーダーでの勾配計算にはトレーニングが必要ありません。また、元のモデルの勾配計算の半分が削減されるため、トレーニングが高速化され、GPU メモリが節約されます。 ControlNet を使用して安定拡散モデルをトレーニングするには、トレーニング反復ごとに約 23% 多くの GPU メモリと 34% 多くの時間を必要とするだけです (単一の Nvidia A100 PCIE 40G でテスト)。

トレーニングとトレーニングの強化

画像 z_0 が与えられると、拡散アルゴリズムは画像に徐々にノイズを追加し、ノイズ画像 z_t、t はノイズを追加する回数です。 t が十分に大きい場合、画像は純粋なノイズに近似します。以下の式 (10) に示すように、タイム ステップ t、テキスト プロンプト c_t、およびタスク固有の条件 c_f を含む一連の条件が与えられると、画像拡散アルゴリズムはネットワーク ϵ_θ を学習して、ノイズのある画像 z_t に追加されるノイズを予測します。

トレーニング プロセス中に、研究者らはテキスト プロンプト c_t の 50% を空の文字列にランダムに置き換えました。これは、入力条件マップからセマンティック コンテンツを識別する ControlNet の機能にとって有益です。

さらに、研究者らは、特にコンピューティング デバイスが非常に限られている場合 (ラップトップなど)、または非常に強力な場合 (大規模なコンピュータなど)、ControlNet のトレーニングを改善するためのいくつかの戦略についても議論しました。 GPU が利用可能)、コンピューティング クラスター)。

技術的な詳細については、元の論文を参照してください。

以上がAI 次元削減が人間のペインターを攻撃し、ヴィンセント グラフが ControlNet に導入され、深さとエッジ情報が完全に再利用可能になりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM

AIのスキルギャップは、サプライチェーンのダウンを遅くしていますApr 26, 2025 am 11:13 AM「AI-Ready労働力」という用語は頻繁に使用されますが、サプライチェーン業界ではどういう意味ですか? サプライチェーン管理協会(ASCM)のCEOであるAbe Eshkenaziによると、批評家ができる専門家を意味します

1つの会社がAIを永遠に変えるために静かに取り組んでいる方法Apr 26, 2025 am 11:12 AM

1つの会社がAIを永遠に変えるために静かに取り組んでいる方法Apr 26, 2025 am 11:12 AM分散型AI革命は静かに勢いを増しています。 今週の金曜日、テキサス州オースティンでは、ビテンサーのエンドゲームサミットは極めて重要な瞬間を示し、理論から実用的な応用に分散したAI(DEAI)を移行します。 派手なコマーシャルとは異なり

Nvidiaは、AIエージェント開発を合理化するためにNEMOマイクロサービスをリリースしますApr 26, 2025 am 11:11 AM

Nvidiaは、AIエージェント開発を合理化するためにNEMOマイクロサービスをリリースしますApr 26, 2025 am 11:11 AMエンタープライズAIはデータ統合の課題に直面しています エンタープライズAIの適用は、ビジネスデータを継続的に学習することで正確性と実用性を維持できるシステムを構築する大きな課題に直面しています。 NEMOマイクロサービスは、NVIDIAが「データフライホイール」と呼んでいるものを作成することにより、この問題を解決し、AIシステムがエンタープライズ情報とユーザーインタラクションへの継続的な露出を通じて関連性を維持できるようにします。 この新しく発売されたツールキットには、5つの重要なマイクロサービスが含まれています。 NEMOカスタマイザーは、より高いトレーニングスループットを備えた大規模な言語モデルの微調整を処理します。 NEMO評価者は、カスタムベンチマークのAIモデルの簡素化された評価を提供します。 Nemo Guardrailsは、コンプライアンスと適切性を維持するためにセキュリティ管理を実装しています

aiは芸術とデザインの未来のために新しい絵を描きますApr 26, 2025 am 11:10 AM

aiは芸術とデザインの未来のために新しい絵を描きますApr 26, 2025 am 11:10 AMAI:芸術とデザインの未来 人工知能(AI)は、前例のない方法で芸術とデザインの分野を変えており、その影響はもはやアマチュアに限定されませんが、より深く影響を与えています。 AIによって生成されたアートワークとデザインスキームは、広告、ソーシャルメディアの画像生成、Webデザインなど、多くのトランザクションデザインアクティビティで従来の素材画像とデザイナーに迅速に置き換えられています。 ただし、プロのアーティストやデザイナーもAIの実用的な価値を見つけています。 AIを補助ツールとして使用して、新しい美的可能性を探求し、さまざまなスタイルをブレンドし、新しい視覚効果を作成します。 AIは、アーティストやデザイナーが繰り返しタスクを自動化し、さまざまなデザイン要素を提案し、創造的な入力を提供するのを支援します。 AIはスタイル転送をサポートします。これは、画像のスタイルを適用することです

エージェントAIとのズームがどのように革命を起こしているか:会議からマイルストーンまでApr 26, 2025 am 11:09 AM

エージェントAIとのズームがどのように革命を起こしているか:会議からマイルストーンまでApr 26, 2025 am 11:09 AM最初はビデオ会議プラットフォームで知られていたZoomは、エージェントAIの革新的な使用で職場革命をリードしています。 ZoomのCTOであるXD Huangとの最近の会話は、同社の野心的なビジョンを明らかにしました。 エージェントAIの定義 huang d

大学に対する実存的な脅威Apr 26, 2025 am 11:08 AM

大学に対する実存的な脅威Apr 26, 2025 am 11:08 AMAIは教育に革命をもたらしますか? この質問は、教育者と利害関係者の間で深刻な反省を促しています。 AIの教育への統合は、機会と課題の両方をもたらします。 Tech Edvocate NotesのMatthew Lynch、Universitとして

プロトタイプ:アメリカの科学者は海外の仕事を探していますApr 26, 2025 am 11:07 AM

プロトタイプ:アメリカの科学者は海外の仕事を探していますApr 26, 2025 am 11:07 AM米国における科学的研究と技術の開発は、おそらく予算削減のために課題に直面する可能性があります。 Natureによると、海外の雇用を申請するアメリカの科学者の数は、2024年の同じ期間と比較して、2025年1月から3月まで32%増加しました。以前の世論調査では、調査した研究者の75%がヨーロッパとカナダでの仕事の検索を検討していることが示されました。 NIHとNSFの助成金は過去数か月で終了し、NIHの新しい助成金は今年約23億ドル減少し、3分の1近く減少しました。リークされた予算の提案は、トランプ政権が科学機関の予算を急激に削減していることを検討しており、最大50%の削減の可能性があることを示しています。 基礎研究の分野での混乱は、米国の主要な利点の1つである海外の才能を引き付けることにも影響を与えています。 35

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AM

オープンAIの最新のGPT 4.1ファミリ - 分析VidhyaApr 26, 2025 am 10:19 AMOpenaiは、強力なGPT-4.1シリーズを発表しました。実際のアプリケーション向けに設計された3つの高度な言語モデルのファミリー。 この大幅な飛躍は、より速い応答時間、理解の強化、およびTと比較した大幅に削減されたコストを提供します

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

ホットトピック

7739

7739 15

15 1643

1643 14

14 1397

1397 52

52 1290

1290 25

25 1233

1233 29

29