ホームページ >テクノロジー周辺機器 >AI >ダウンストリームトレーニングなしで、Tip-Adapter は CLIP 画像分類の精度を大幅に向上させます

ダウンストリームトレーニングなしで、Tip-Adapter は CLIP 画像分類の精度を大幅に向上させます

- 王林転載

- 2023-04-12 15:25:261385ブラウズ

- # 論文リンク: https://arxiv.org/pdf/2207.09519.pdf

- コードリンク: https://github.com/gaopengcuhk/Tip-Adapter

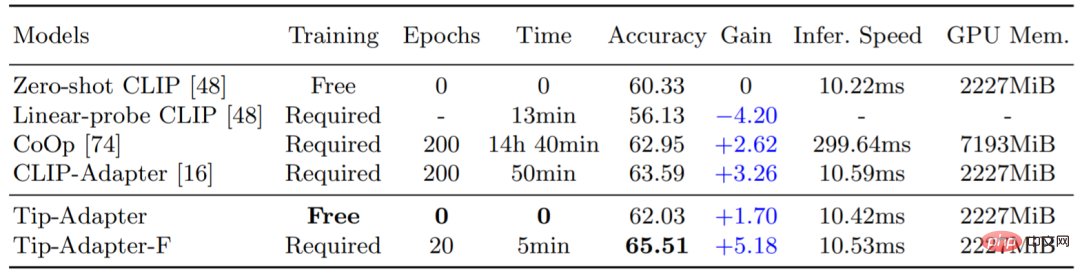

Contrastive Image Language Pre-training Model (CLIP) は最近、強力な視覚領域転送機能を実証し、新しい下流データセットに対してゼロショット画像認識を実行できることを実証しました。 CLIP の移行パフォーマンスをさらに向上させるために、既存の方法では、CoOp や CLIP-Adapter などの少数ショット設定を使用します。これにより、ダウンストリーム データ セットに少量のトレーニング データが提供され、CLIP がさまざまな視覚的シナリオに対して適切な意思決定を行えるようになります。 。 調整。ただし、この追加のトレーニング ステップはかなりの時間とスペースのリソース オーバーヘッドをもたらし、CLIP 本来の迅速な知識伝達機能にある程度の影響を与えます。したがって、追加の下流トレーニングを必要とせず、CLIP の精度を大幅に向上できる数ショット画像分類法 Tip-Adapter を提案します。これに基づいて、当社はわずかな微調整だけで最先端のパフォーマンスを達成できるソリューション、Tip-Adapter-F を提案し、効率とパフォーマンスの最適な妥協点を達成しました。以下の表 1 に示すように、Tip-Adapter はトレーニング時間を必要としません。つまり、ImageNet データ セットにおける CLIP の精度を 1.7% (精度) 向上させることができますが、Tip-Adapter-F では 10 分の 1 しか必要としません。以前のソリューションのトレーニング時間 (エポック数、時間) を考慮すると、既存の最高の分類パフォーマンスを達成できます。

#表 1: ImageNet データセット上のさまざまなスキームの 16 ショット画像分類精度とトレーニング時間の比較

#表 1: ImageNet データセット上のさまざまなスキームの 16 ショット画像分類精度とトレーニング時間の比較

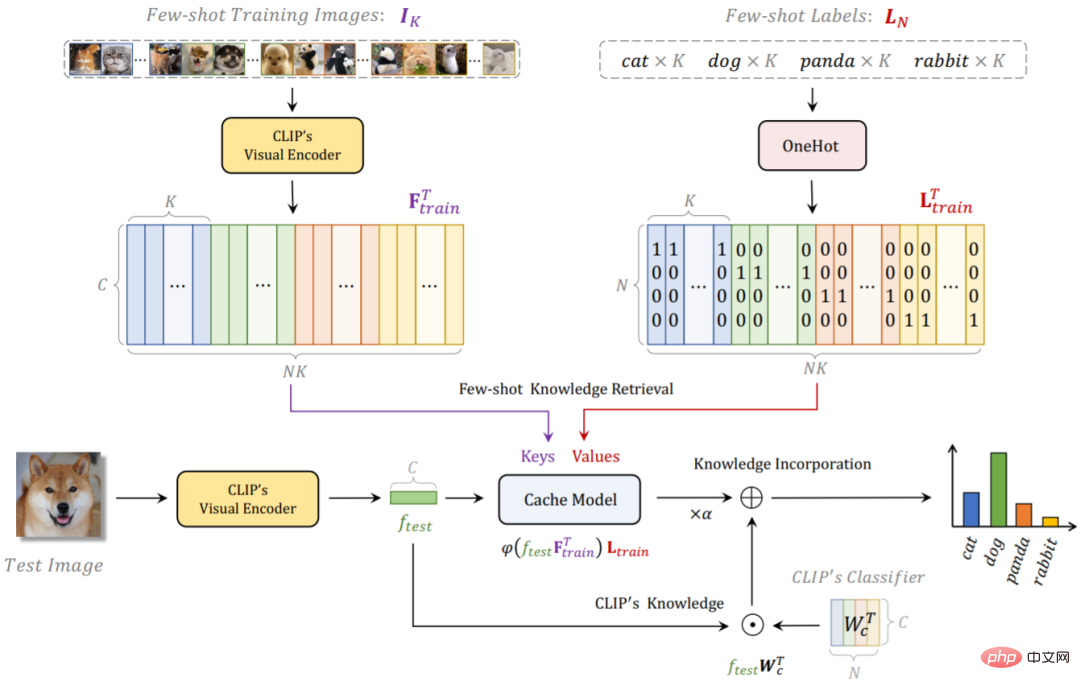

1.Tip-AdapterTip-Adapter の全体的なネットワーク構造を以下の図 1 に示します。与えられた数ショットのトレーニング データセットとラベルに対して、 use CLIP は、非トレーニング ソリューションを使用して、下流のトレーニング データからの分類知識を保存するキャッシュ モデル (キャッシュ モデル) を構築します。テスト中に、Tip-Adapter は、キャッシュ モデルの予測と元のモデルの予測の線形合計を実行します。 CLIP 、より強力な最終分類結果を取得します。

詳細には、CLIP 事前トレーニング済みビジュアル エンコーダー (Visual Encoder) を使用して、数ショット トレーニング セット内のすべての画像の特徴をキャッシュ モデルのキーとして抽出します。対応する画像タグをキャッシュモデルの値としてワンホットエンコーディング形式に変換します。この Key-Value キャッシュ モデルの構築方法では、事前トレーニング済みの Visual Encoder を使用するため、トレーニングのオーバーヘッドは必要ありません。また、数ショットのトレーニング セットには各カテゴリの少数の画像 (1 ~ 16 ショット) しか含まれていないことを考慮すると、キャッシュ モデルは、追加のグラフィック メモリ オーバーヘッドもほとんど消費しません。表 1 の GPU メモリ インジケータを参照してください。

テスト イメージの場合、最初に CLIP のビジュアル エンコーダーを使用してその特徴を取得し、次にその特徴をダウンストリームの少数ショット データのナレッジ取得のためのキャッシュ モデルへのクエリとして扱います。 Key も CLIP の Visual Encoder によって抽出されるため、テスト画像特徴量 Query と同じ起源を持ちます。それらの間のコサイン類似度を直接計算して、Key-Query 隣接行列を取得できます。この行列は、それぞれの重みに対応するとみなすことができます。貴ぶ。したがって、値の加重合計を計算して、キャッシュ モデルを取得することで得られたこのテスト画像の分類予測を取得できます。さらに、テスト画像の特徴を CLIP の Textual Encoder のテキスト特徴と照合することで、CLIP のゼロショット予測を取得することもできます。 2 つの合計を線形に重み付けすることで、最終的な分類予測が得られます。これには、CLIP によって事前トレーニングされた画像言語の対照的な知識と、新しい下流データセットの少数ショットの知識の両方が含まれているため、より正確な予測を実現できます。強力な画像分類精度。

Tip-Adapter のネットワーク構造に基づいて、キャッシュ モデルのキー部分を学習パラメータにさらに変更できます。つまり、トレーニングを通じて更新できます。このソリューションは次のとおりです。チップアダプター F.表 1 に示すように、すでに構築されているキャッシュ モデルの助けにより、Tip-Adapter-F は既存の CLIP-Adapter のトレーニング ラウンドと時間の 10 分の 1 だけで高いパフォーマンスを達成できます。

#図 1: チップ アダプターおよびチップ アダプター F

# のネットワーク フローチャート # #2.Tip-Adapter と既存のソリューションの違いと関連性

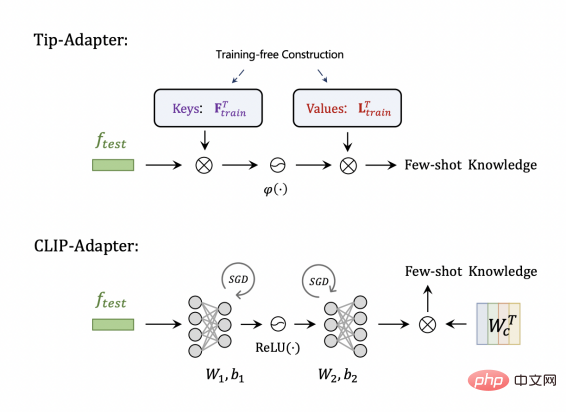

CLIP-Adapter を比較すると、図 2 に示すように、Tip-Adapter にはキーと値が格納されます。これらはそれぞれ、CLIP-Adapter のアダプター構造の 2 つの線形層に対応します。ただし、前者は構築にトレーニングを必要としませんが、後者はランダムに初期化され、最適なパラメーターを学習するためにトレーニングが必要になります。

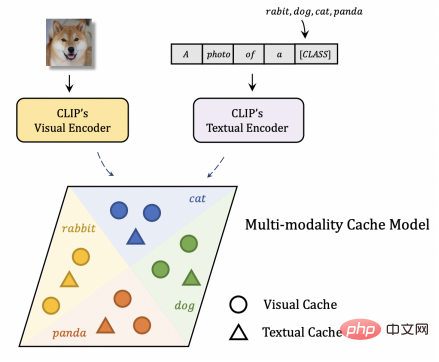

図 3 に示すように、キャッシュ モデルを構築するための他の既存のソリューションと比較すると、Tip-Adapter のキャッシュ モデルはマルチモーダルな視覚言語キャッシュとみなすことができます。 CLIP のテキスト エンコーダーによって出力された特徴はテキストの Key-Value と見なすことができるため、これは画像の特徴をクエリとしてテストし、それぞれビジュアル キャッシュとテキスト キャッシュ内の知識を取得するのと同等です。 Visual Cache、Tip-Adapter はマルチモーダルな知識を利用して、より強力な認識パフォーマンスを得ることができます。

#図 3: キャッシュ モデルを構築するための他のソリューションと比較したチップアダプター

#図 3: キャッシュ モデルを構築するための他のソリューションと比較したチップアダプター

三つ。実験結果1. ImageNet での分類精度

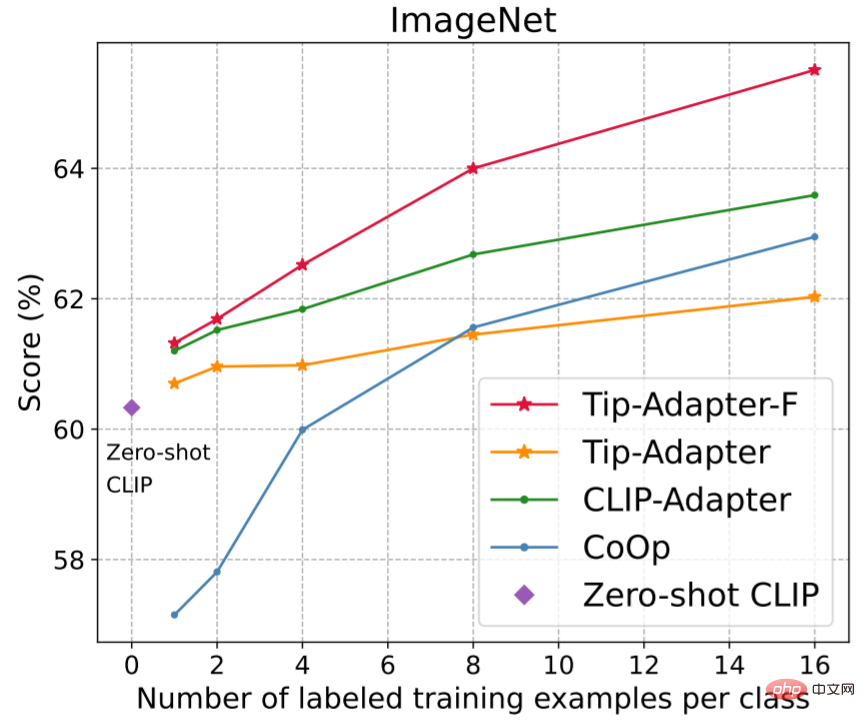

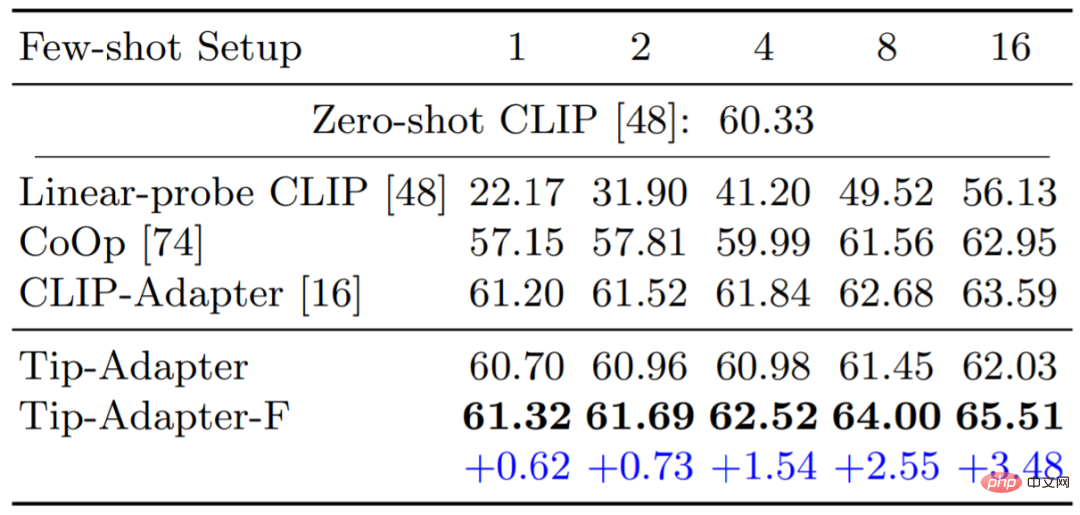

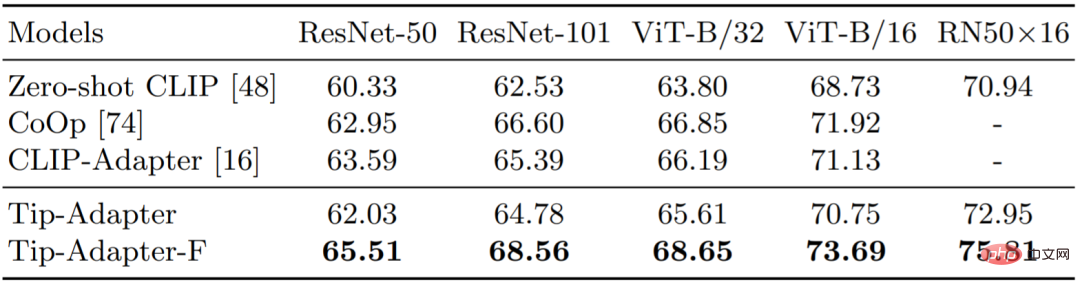

図 4 と表 2 は、Tip-Adapter、Tip-Adapter-F、および 1 と 2、4、8、の既存のソリューションを比較しています。表 3 は、16 ショットの ImageNet データセットで異なる CLIP を使用した Visual Encoder の精度を比較しています。どちらのソリューションも、リソースのオーバーヘッドがほとんどなく、優れたパフォーマンスを達成していることがわかります。

#図 4 と表 2: ImageNet データセットのさまざまなメソッドの 1 ~ 16ショット画像の分類精度の比較

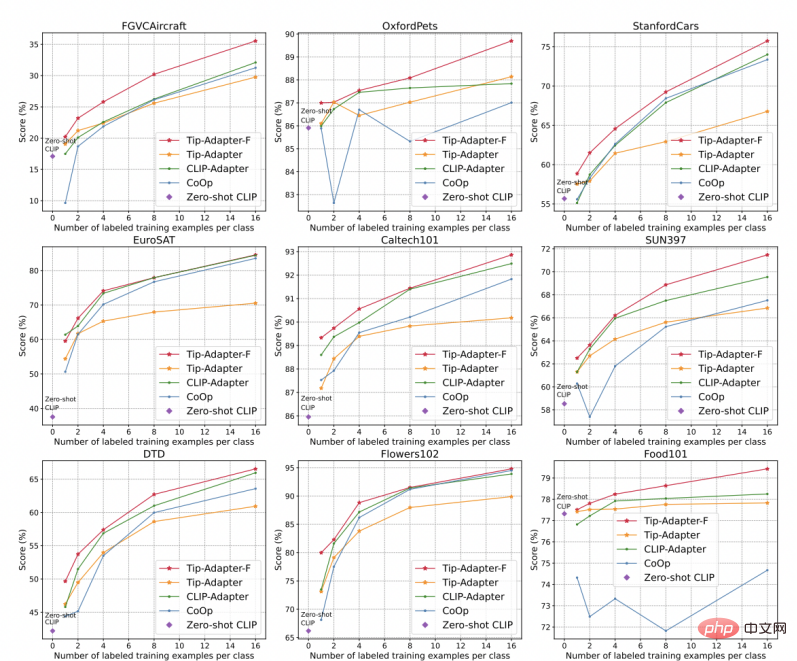

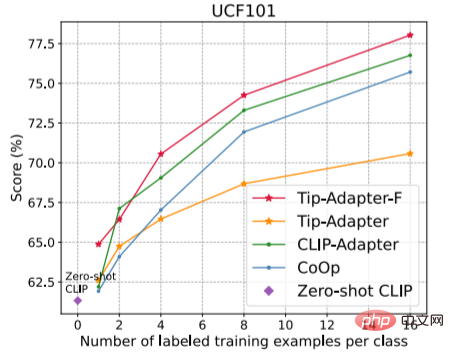

2 を使用した Visual Encoder の分類精度。別の 10 個の画像分類データ セット図 5 に示すように、精度の比較結果が得られます。さらに 10 個の画像分類データ セット、つまり StandfordCars、UCF101、Caltech101、Fflowers102、SUN397、DTD、EuroSAT、FGVCAircraft、OxfordPets、Food101 が取得されます。図に示すように、当社のチップアダプター F はすべて最高の認識精度を達成しました。

#図 5: 別の 10 個のデータセットに対するさまざまなメソッドの 1 ~ 16 ショットの画像分類精度の比較

#図 5: 別の 10 個のデータセットに対するさまざまなメソッドの 1 ~ 16 ショットの画像分類精度の比較

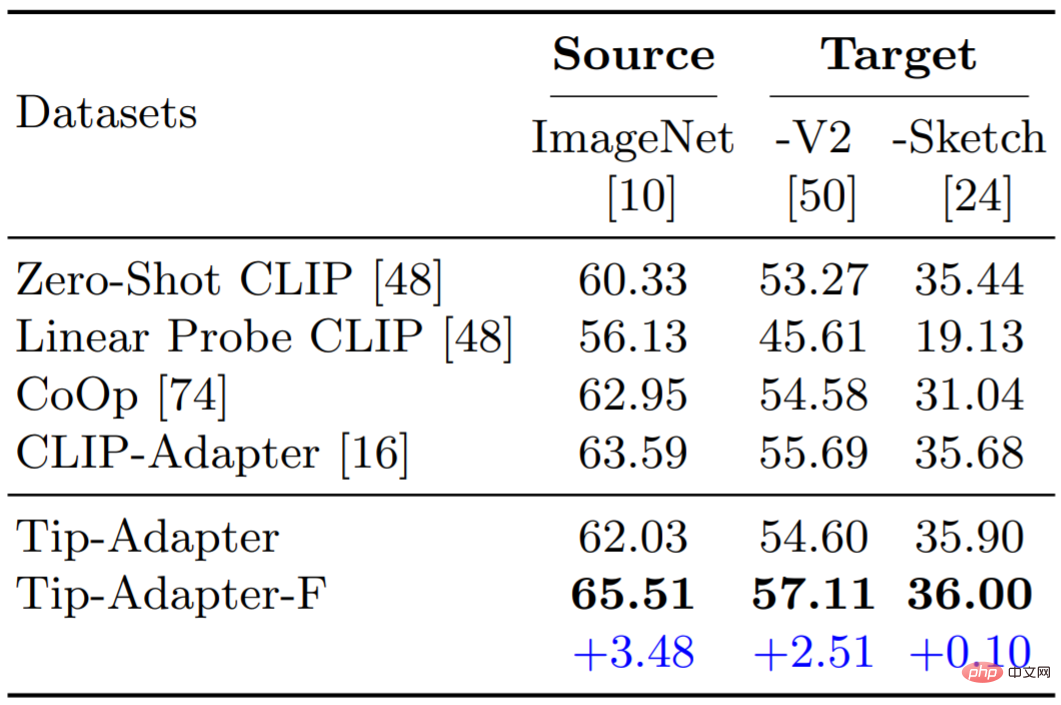

3. ドメイン汎化能力の評価

また、ドメイン汎化における Tip-Adapter と Tip-Adapter-F のパフォーマンスもテストしました。表 6 に示すように、どちらのスキームも強力な堅牢性と機能転送機能を示しています。 ##################四。結論

この論文では、下流の少数ショット画像分類に CLIP を使用するためのトレーニング不要のソリューションである Tip-Adapter を提案します。 Tip-Adapterは、テスト画像Queryの知識検索データベースとしてKey-Valueキャッシュモデルを構築し、キャッシュモデルの予測とCLIPのゼロショット予測を融合することでより強力な認識性能を獲得します。私たちは、Tip-Adapter が事前トレーニング済みモデルの効率的な移行に関するさらなるフォローアップ作業のきっかけとなることを願っています。

以上がダウンストリームトレーニングなしで、Tip-Adapter は CLIP 画像分類の精度を大幅に向上させますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。